Can LLM-Generated Misinformation Be Detected? 能否发现由 LLM 生成的错误信息?

论文主页

代码地址

ICLR 2024 & Didactic Paper Award: Can LLM-Generated Misinformation Be Detected?

Abstract

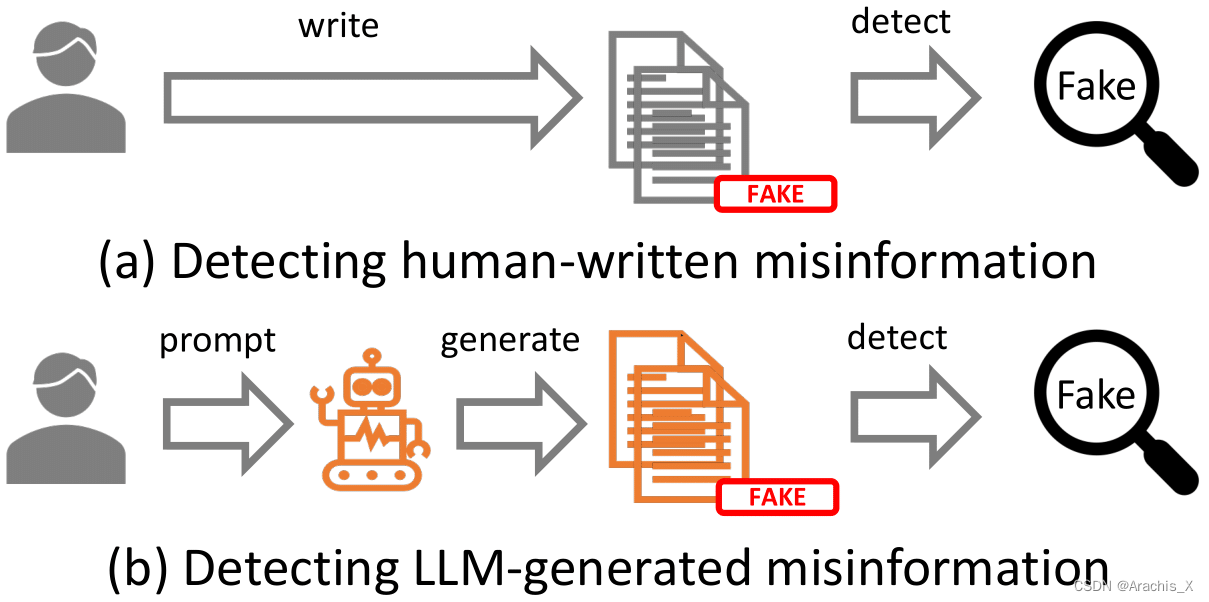

The advent of Large Language Models (LLMs) has made a transformative impact. However, the potential that LLMs such as ChatGPT can be exploited to generate misinformation has posed a serious concern to online safety and public trust. A fundamental research question is: will LLM-generated misinformation cause more harm than human-written misinformation? We propose to tackle this question from the perspective of detection difficulty. We first build a taxonomy of LLM-generated misinformation. Then we categorize and validate the potential real-world methods for generating misinformation with LLMs. Then, through extensive empirical investigation, we discover that LLM-generated misinformation can be harder to detect for humans and detectors compared to human-written misinformation with the same semantics, which suggests it can have more deceptive styles and potentially cause more harm. We also discuss the implications of our discovery on combating misinformation in the age of LLMs and the countermeasures.

大型语言模型(LLM)的出现产生了变革性的影响。然而,像 ChatGPT 这样的大型语言模型有可能被用来生成错误信息,这给网络安全和公众信任带来了严重问题。

一个基本的研究问题是:LLM 生成的错误信息会比人工编写的错误信息造成更大的伤害吗?

我们建议从检测难度的角度来解决这个问题。

- 我们首先建立了 LLM 生成的错误信息分类法。

- 然后,我们对现实世界中利用 LLM 生成错误信息的潜在方法进行了分类和验证。

- 然后,通过广泛的实证调查,我们发现 LLM 生成的错误信息与人类编写的具有相同语义的错误信息相比,更难被人类和检测器检测到,这表明它可能具有更强的欺骗性,并可能造成更大的危害。

我们还讨论了我们的发现对打击 LLM 时代的错误信息的影响以及对策。

Contributions

(1) We build a taxonomy by types, domains, sources, intents and errors to systematically characterize LLM-generated misinformation as an emerging and critical research topic.

- 我们按类型、领域、来源、意图和错误建立了一个分类法,以系统地描述 LLM 生成的错误信息,将其作为一个新兴的重要研究课题。

(2) We make the first attempt to categorize and validate the potential real-world methods for generating misinformation with LLMs including Hallucination Generation, Arbitrary Misinformation Generation and Controllable Misinformation Generation methods.

- 我们首次尝试对现实世界中利用 LLM 生成误导信息的潜在方法进行分类和验证,包括幻觉生成法、任意误导信息生成法和可控误导信息生成法。

(3) We discover that misinformation generated by LLMs can be harder for humans and detectors to detect than human-written misinformation with the same semantic information through extensive investigation, which provides sufficient empirical evidence to demonstrate that LLM-generated misinformation can have more deceptive styles and potentially cause more harm.

- 通过大量调查,我们发现,与人类编写的具有相同语义信息的错误信息相比,LLM生成的错误信息更难被人类和检测器检测到,这为证明LLM生成的错误信息可能具有更强的欺骗性和潜在的更大危害提供了充分的经验证据。

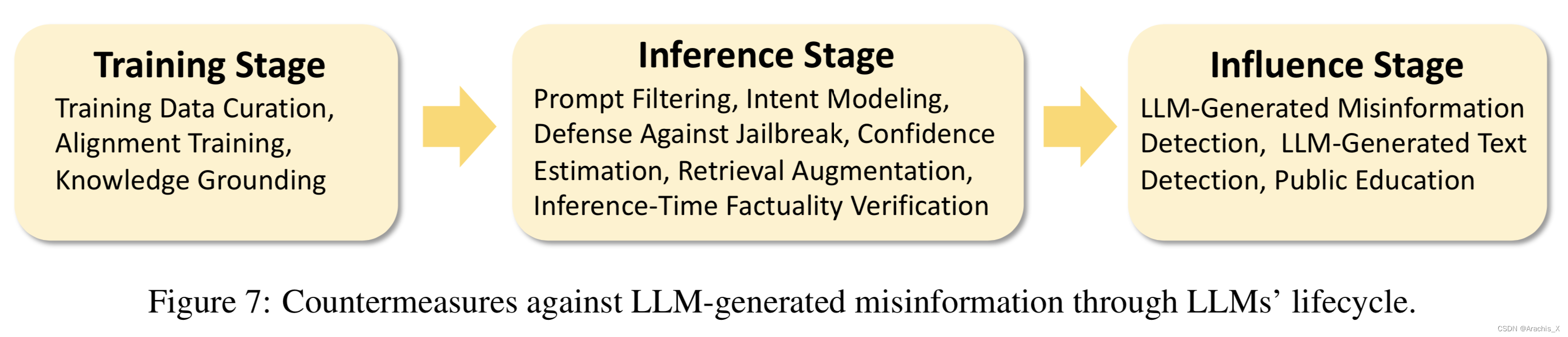

(4) We discuss the emerging challenges for misinformation detectors (Section 6), important implications of our discovery on combating misinformation in the age of LLMs (Section 7), the countermeasures against LLM-generated misinformation through LLMs’ whole lifecycle (Section 8).

- 我们讨论了误报检测器面临的新挑战(第 6 节)、我们的发现对打击 LLM 时代误报的重要意义(第 7 节)、针对 LLM 整个生命周期产生的误报的对策(第 8 节)。

其他

详情见文首【论文主页】

1063

1063

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?