点击下方卡片,关注“具身智能之心”公众号

更多干货,欢迎加入国内首个具身智能全栈学习社区:具身智能之心知识星球(戳我),这里包含所有你想要的。

深度强化学习是深度学习与强化学习相融合的产物。深度学习具备强大的感知和特征提取能力,能够处理图像、语音等复杂数据;强化学习则基于环境反馈让智能体通过试错来学习最优行为策略。二者结合,使得智能体可以在复杂环境下,从高维数据中学习到有效的决策策略。这么好的东西,为什么不用于机器人灵巧操作任务训练?

用力过猛?频繁出错?分分钟EMO

结果有人一试发现,在训练人形机器人执行如双手机器人移交任务时,近端策略优化算法中的学习率、折扣因子等超参数取值的微小改变,会使机器人在抓取、移交物体动作的准确性和流畅性上有显著差异。并且,同样以双手机器人移交任务为例,在相同的实验环境、代码和初始条件下,多次运行深度强化学习算法,每次训练得到的机器人操作策略和最终任务完成成功率都可能不同。有时机器人能较为顺利地完成移交任务,成功率较高;而有时则频繁出错,成功率很低。

此外,在模拟人形机器人抓取不同形状、材质的物体时,比如模拟抓取表面光滑的金属块和表面粗糙的木块,仿真可能无法完全还原真实的抓取难度差异,导致在仿真中训练好的抓取策略在现实中效果不佳。同时,设计奖励函数也很困难。以抓取任务为例,简单地以是否成功抓取作为奖励,机器人可能会学习到一些不规范的抓取动作,如用力过猛损坏物体或抓取姿势不稳定。

然而,它存在一些自身问题,并在机器人应用场景中面临额外挑战:深度强化学习存在对超参数敏感的问题,超参数的微小变化可能导致模型性能大幅波动,增加了调优难度;其可重复性存疑,相同实验设置下多次运行结果可能不同,不利于研究成果的验证和推广;在机器人应用场景中,还面临环境建模不精确的难题,难以准确模拟现实环境的复杂性,以及奖励函数设计困难的问题,难以制定合理有效的奖励机制引导智能体学习,同时在高维动作和感知空间中探索效率较低,学习过程缓慢 。

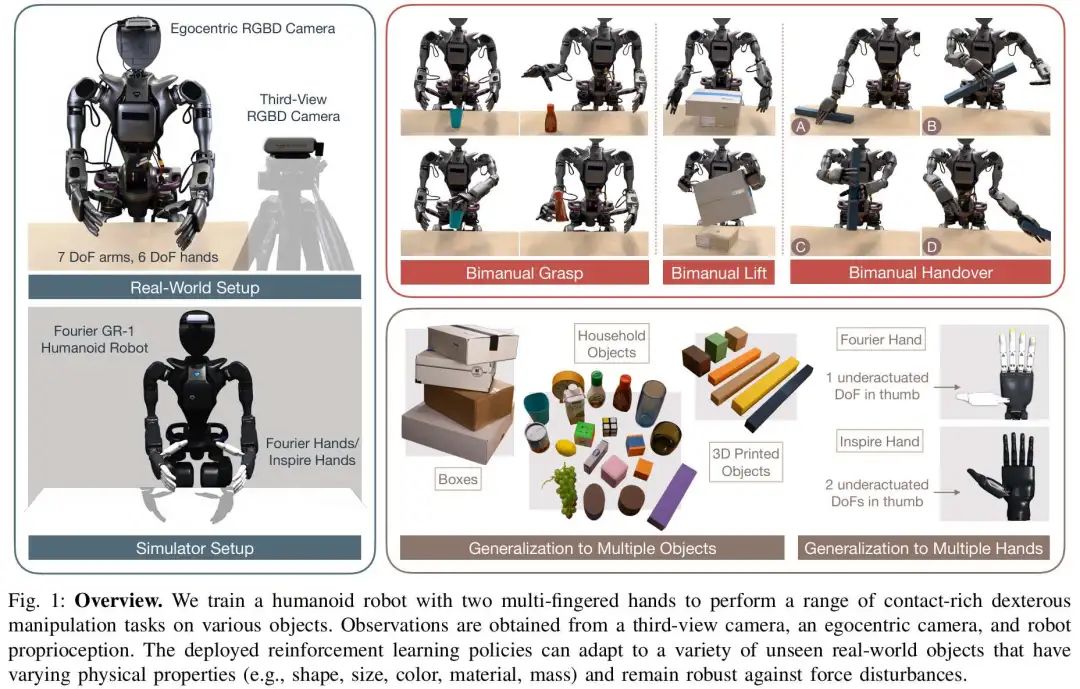

针对以上问题,“Sim-to-Real Reinforcement Learning for Vision-Based Dexterous Manipulation on Humanoids” 一文提出了将仿真到现实(sim-to-real)的强化学习应用于基于视觉的人形机器人灵巧操作的方法,通过解决环境建模、奖励设计、策略学习和仿真到现实转换等方面的挑战,使机器人能够在现实世界中完成多种灵巧操作任务。具体如下:

环境建模难题:仿真环境与现实环境难以精准匹配,使用物理硬件训练成本高且风险大,而以往灵巧操作的仿真到现实工程工作繁琐且针对性强。文章提出自动化的Real-to-Sim调优模块,自动搜索参数空间优化模拟器物理参数和机器人模型常数,快速校准参数使模拟环境更接近真实情况,同时采用近似物体建模,将物体简化为基本几何形状,平衡训练效率和策略迁移能力。

奖励设计困境:对于接触丰富或长时程的灵巧操作任务,设计通用的奖励函数非常困难,传统依赖专家知识的手工工程方法可扩展性差。文章提出将任务分解为“接触目标”和“物体目标”的通用奖励设计方案,使用基于关键点的技术,在物体表面设置“接触贴纸”来指定接触目标,简化奖励工程复杂性,使复杂任务可通过强化学习有效学习。

策略学习困境:在高维空间中,由于样本复杂性和奖励稀疏性,策略学习困难,多指手操作的复杂接触模式加剧了该问题。文章提出两种技术改进,一是利用任务感知的手部姿势初始化任务,收集人类相关数据作为初始状态,减少探索难度;二是将复杂任务分解为子任务,训练专家策略后蒸馏为通用策略,提高样本效率和策略泛化能力。

物体感知难题:物体感知在操作任务中至关重要,但物体形状、大小、质量等属性多样,高维物体表示虽信息丰富但仿真到现实差距大,低维表示则难以学习最优策略。文章提出混合使用低维的3D物体位置和高维的深度图像来表示物体,并对高维特征进行数据增强,减少感知差距,同时应用域随机化技术,确保策略在不同环境下的鲁棒性。

哪些深度强化学习的工作值得follow?

在深度强化学习应用方面,其在多领域成果显著,但自身存在对超参数敏感、可重复性存疑的问题(Henderson 等,2018; Islam 等,2017)。在机器人应用场景中,面临探索效率低、环境建模不精确、奖励函数设计困难等挑战(Bellemare 等,2013; Tassa 等,2018)。过去的研究提出了学习人类运动数据(Rajeswaran 等,2017; Yin 等,2025; Chi 等,2023; Zhu 等,2018)、实仿技术(Akkaya 等,2019; Haarnoja 等,2024; Handa 等,2023; Lin 等,2024; Torne 等,2024)和更合理的奖励设计方法(Memmel 等,2024; Zhang 等,2024)等缓解措施,为本文研究奠定了基础。

在基于视觉的人形机器人灵巧操作方面,模仿学习和经典方法依赖遥操作或人类演示数据,成本高昂(Levine 等,2018; Fanqi 等,2024; Tony 等,2024)。强化学习方法虽有应用,但存在假设单手持操作、不使用像素输入或专注单一技能等局限(Akkaya 等,2019; Yuanpei 等,2023; Handa 等,2023; Tyler 等,2024; Haozhi 等,2023; Ritvik 等,2024; Jun 等,2024) 。与本文最接近的 Chen 等人的研究(Yuanpei 等,2024),依赖人类手部运动捕捉数据学习手腕控制器,并非从头学习手 - 臂关节控制。而本文首次成功将基于视觉的灵巧操作策略从仿真转移到新型多手指人形机器人硬件上。

模型架构

文章图2展示了基于视觉的灵巧操作的仿真到现实强化学习流程,涵盖环境建模、奖励设计、策略学习和视觉仿真到现实转换等关键模块,各模块协同工作以实现人形机器人的灵巧操作。

自动现实到仿真调优模块:现实与仿真环境难以匹配,该模块旨在解决这一问题。它通过自动搜索参数空间,快速校准模拟器物理参数和机器人模型常数。具体来说,先从制造商提供的机器人模型文件出发,随机采样参数组合初始化多个模拟环境,接着在真实机器人硬件和模拟环境中并行执行关节位置目标的校准序列,通过比较跟踪误差,选择能最小化均方误差的参数集,从而优化机器人和环境的建模,减少手动调优的工作量,提高仿真与现实的契合度。

可泛化奖励设计:将操作任务分解为“接触目标”和“物体目标”,以此为基础设计奖励函数。利用基于关键点的技术,在物体表面生成“接触贴纸”来指定接触目标,根据手指与接触点的距离计算接触奖励;通过惩罚物体当前状态与目标状态的距离来设定物体目标奖励。例如在双手交接任务中,依据不同阶段的接触和物体状态变化来分配奖励,引导机器人完成任务。

样本高效策略学习

任务感知手部姿势初始化:通过连接遥操作系统收集人类的任务感知手部姿势数据,包括物体姿态和机器人关节位置,将这些数据随机采样作为仿真中的任务初始化状态,降低策略学习的探索难度,减少数据收集时间。

分治蒸馏:把复杂任务分解为简单子任务,如将多物体操作任务拆分为多个单物体操作任务,为每个子任务训练专家策略,再将这些策略蒸馏为通用策略。同时,可根据子任务策略的最优性筛选轨迹数据,提高样本质量和训练效率。

基于视觉的仿真到现实转换

混合物体表示:结合低维的3D物体位置和高维的深度图像表示物体。3D物体位置由第三方视角相机获取,确保物体在视野内且位置可追踪;深度图像提供物体几何信息,二者结合平衡了信息丰富度和仿真到现实的差距,提升策略从仿真到现实的可转移性。

域随机化:对动力学和感知进行多种域随机化处理,如随机化物体的摩擦、质量、尺度,施加随机力模拟物理效果,以及对观测和动作中的噪声进行建模,增强策略在不同环境下的鲁棒性,确保可靠的仿真到现实转换。

实验

实验设置

实验采用Fourier GR1人形机器人,其配备两个7自由度的手臂和不同类型的多手指手,如Fourier手和Inspire手,以测试跨实体的通用性。实验中的具体任务包括:

(1)抓取 - 到达任务,要求机器人用一只手抓取桌面上的物体并移动到目标位置,测试物体具有多种形状、质量等属性,每次试验会改变物体的初始位置、方向和目标位置;

(2)箱子提升任务,机器人需要提升太大而无法单手握持的箱子,箱子的颜色、大小和质量随机变化,每次试验随机设置箱子的初始位置和垂直轴方向;

(3)双手机器人移交任务,机器人要从桌子一侧用一只手抓取物体,然后交给另一只手,物体的颜色、尺寸和质量多样,每次试验的物体初始位置和方向也会变化。

实验结果

研究发现自动调优模块的均方误差(MSE)与仿真到现实的成功率相关。在抓取 - 到达任务中,对三组使用不同机器人建模参数(由自动调优模块得出不同MSE)的策略检查点进行测试,结果显示MSE越低,仿真到现实的转移成功率越高。例如,MSE最低的一组,抓取成功率为8/10,到达成功率为7/10;而MSE最高的一组,抓取和到达成功率均为0/10。

图4对比了使用不同物体集训练抓取 - 到达策略的情况。结果表明,将物体建模为简单几何原语(如圆柱体、立方体和球体)在训练效率和仿真到现实的转移性之间能达到较好平衡。从训练曲线看,使用简单几何物体训练的策略比使用复杂物体训练的策略样本效率更高。此外,用随机化简单几何物体训练的策略,能泛化到多种未见物体。

以箱子提升任务为例,展示了不同接触标记放置下出现的不同接触行为。结果显示,接触行为与指定的接触位置紧密对齐,表明使用接触标记来指定接触目标是有效的,为奖励设计中基于接触目标的设定提供了支持。

表2对比了有无任务感知手部姿势初始化时各任务成功训练策略的百分比。结果表明,有人类先验知识进行初始化能显著提高困难强化学习任务的探索效率。如抓取任务,有人类初始化时成功率为80%,无人类初始化时为60%;双手移交任务,有人类初始化时成功率为30%,无人类初始化时为0%。

表3比较了基于深度和位置的策略(Depth + Pos)与仅基于深度的策略(Depth Only)的仿真到现实转移性能。在抓取、提升和双手移交等任务中,结合低维3D物体位置和深度的策略(Depth + Pos)在仿真到现实的转移上表现更优。例如,在双手移交任务的不同阶段,“Depth + Pos”策略的拾取成功率和任务成功率均高于“Depth Only”策略。

图 6 展示了人形机器人在不同任务中,面对各种力扰动时所学习到的策略的鲁棒性实验结果。在抓取 - 到达、箱子提升和双手机器人移交等任务中,机器人在遭遇如撞击、拉扯、推挤和拖拽等外力干扰时,仍能保持较好的操作表现,体现出策略的鲁棒性。

总结与展望

文章提出了一套完整的应用于人形机器人基于视觉的灵巧操作的仿真到现实强化学习方法,解决了环境建模、奖励设计、策略学习和仿真到现实转换中的关键挑战,证明强化学习可有效学习操作技能,且策略具有良好的泛化性、鲁棒性,能完成复杂任务。但研究仍存在不足,虽然提出的技术构建了可行的仿真到现实强化学习流程,实现了一定的泛化性、鲁棒性和灵巧性,但仍与人类的通用操作能力存在差距。奖励设计可融入更多人类先验,如遥操作任务演示;在动力学仿真到现实的差距上,仅用简单域随机化,可能是双手机器人移交任务成功率低的原因;还受限于现有硬件的灵巧性,未来期望应用于更先进的机器人手。

参考文献

Sim-to-Real Reinforcement Learning for Vision-Based Dexterous Manipulation on Humanoids

https://arxiv.org/pdf/2502.20396

https://toruowo.github.io/recipe/

https://huggingface.co/papers/2502.20396

“具身智能之心”公众号持续推送具身智能领域热点:

往期 · 推荐

机械臂操作

优于现有SOTA!PointVLA:如何将3D数据融入VLA模型?

北京大学最新!HybridVLA:打通协同训练,各种任务中均SOTA~

北京大学最新 | 成功率极高!DexGraspVLA:首个用于灵巧抓取的分层VLA框架

ICLR'25 | VLAS:将语音集成到模型中,新颖的端到端VLA模型(西湖大学&浙大)

清华大学最新!UniAct:消除异质性,跨域跨具身泛化,性能超越14倍参数量的OpenVLA

港大最新!RoboTwin:结合现实与合成数据的双臂机器人基准

伯克利最新!CrossFormer:一个模型同时控制单臂/双臂/轮式/四足等多类机器人

四足或人形机器人

斯坦福大学 | ToddlerBot:到真实世界的零样本迁移,低成本、开源的人形机器人平台

TeleAI&港科大最新!离线学习+在线对齐,扩散模型驱动的四足机器人运动

Robust Robot Walker:跨越微小陷阱,行动更加稳健!

斯坦福大学最新!Helpful DoggyBot:四足机器人和VLM在开放世界中取回任意物体

机器人学习

视觉强化微调!DeepSeek R1技术成功迁移到多模态领域,全面开源

UC伯克利最新!Beyond Sight: 零样本微调异构传感器的通用机器人策略

CoRL 2024 | 通过语言优化实现策略适应:实现少样本模仿学习

NeurIPS 2024 | BAKU:一种高效的多任务Policy学习Transformer

人形机器人专场!有LLM加持能有多厉害?看HYPERmotion显身手

NeurIPS 2024 | 大规模无动作视频学习可执行的离散扩散策略

波士顿动力最新!可泛化的扩散策略:能有效操控不同几何形状、尺寸和物理特性的物体

RSS 2024 | OK-Robot:在机器人领域集成开放知识模型时,真正重要的是什么?

MIT最新!还在用URDF?URDF+:一种针对机器人的具有运动环路的增强型URDF

VisionPAD:3DGS预训练新范式!三大感知任务全部暴力涨点

NeurIPS 2024 | VLMimic:5个人类视频,无需额外学习就能提升泛化性?

纽约大学最新!SeeDo:通过视觉语言模型将人类演示视频转化为机器人行动计划

CMU最新!SplatSim: 基于3DGS的RGB操作策略零样本Sim2Real迁移

LLM最大能力密度100天翻一倍!清华刘知远团队提出Densing Law

机器人干活总有意外?Code-as-Monitor 轻松在开放世界实时精确检测错误,确保没意外

斯坦福大学最新!具身智能接口:具身决策中语言大模型的基准测试

机器人控制

简单灵活,便于部署 | Diffusion-VLA:通过统一扩散与自回归方法扩展机器人基础模型

RoboMatrix:一种以技能为中心的机器人任务规划与执行的可扩展层级框架

港大DexDiffuser揭秘!机器人能拥有像人类一样灵巧的手吗?

TPAMI 2024 | OoD-Control:泛化未见环境中的鲁棒控制(一览无人机上的效果)

其他(抓取,VLN等)

CVPR2025满分作文!TSP3D:高效3D视觉定位,性能和推理速度均SOTA(清华大学)

模拟和真实环境SOTA!MapNav:基于VLM的端到端VLN模型,赋能端到端智能体决策

场面混乱听不清指令怎么执行任务?实体灵巧抓取系统EDGS指出了一条明路

北京大学与智元机器人联合实验室发布OmniManip:显著提升机器人3D操作能力

动态 3D 场景理解要理解什么?Embodied VideoAgent来揭秘!

NeurIPS 2024 | HA-VLN:具备人类感知能力的具身导航智能体

北大最新 | RoboMamba:端到端VLA模型!推理速度提升3倍,仅需调整0.1%的参数

博世最新!Depth Any Camera:任意相机的零样本度量深度估计

真机数据白采了?银河通用具身大模型已充分泛化,基于仿真数据!

港科大最新!GaussianProperty:无需训练,VLM+3DGS完成零样本物体材质重建与抓取

VinT-6D:用于机器人手部操作的大规模多模态6D姿态估计数据集

机器人有触觉吗?中科大《NSR》柔性光栅结构色触觉感知揭秘!

波士顿动力最新SOTA!ThinkGrasp:通过GPT-4o完成杂乱环境中的抓取工作

英伟达最新!NaVILA: 用于导航的足式机器人视觉-语言-动作模型

LLM+Zero-shot!基于场景图的零样本物体目标导航(清华大学博士分享)

PoliFormer: 使用Transformer扩展On-Policy强化学习,卓越的导航器

具身硬核梳理

Diffusion Policy在机器人操作任务上有哪些主流的方法?

强化学习中 Sim-to-Real 方法综述:基础模型的进展、前景和挑战

墨尔本&湖南大学 | 具身智能在三维理解中的应用:三维场景问答最新综述

十五校联合出品!人形机器人运动与操控:控制、规划与学习的最新突破与挑战

扩散模型也能推理时Scaling,谢赛宁团队研究可能带来文生图新范式

全面梳理视觉语言模型对齐方法:对比学习、自回归、注意力机制、强化学习等

基础模型如何更好应用在具身智能中?美的集团最新研究成果揭秘!

关于具身智能Vision-Language-Action的一些思考

具身仿真×自动驾驶

视频模型For具身智能:Video Prediction Policy论文思考分析

性能爆拉30%!DreamDrive:时空一致下的生成重建大一统

真机数据白采了?银河通用具身大模型已充分泛化,基于仿真数据!

高度逼真3D场景!UNREALZOO:扩展具身智能的高真实感虚拟世界

MMLab最新FreeSim:一种用于自动驾驶的相机仿真方法

麻省理工学院!GENSIM: 通过大型语言模型生成机器人仿真任务

EmbodiedCity:清华发布首个真实开放环境具身智能平台与测试集!

华盛顿大学 | Manipulate-Anything:操控一切! 使用VLM实现真实世界机器人自动化

东京大学最新!CoVLA:用于自动驾驶的综合视觉-语言-动作数据集

ECCV 2024 Oral | DVLO:具有双向结构对齐功能的融合网络,助力视觉/激光雷达里程计新突破

227

227

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?