本篇分享IJCAI 2022 论文『Boundary-Guided Camouflaged Object Detection』,内大Ð&石大&UAE提出边界引导的伪装目标检测模型BGNet,性能SOTA!代码已开源!

详细信息如下:

- 论文地址:https://arxiv.org/abs/2207.00794

- 代码地址:https://github.com/thograce/BGNet

01

摘要伪装物体检测(COD)是一项有价值但富有挑战性的任务,它可以分割出与周围环境完美融合的物体。现有的深度学习方法往往难以准确识别具有完整和明确对象结构的伪装对象。

为此,在本文中,作者提出了一种新的边界引导网络(BGNet)用于伪装目标检测。本文的方法探索了有价值的和额外的与对象相关的边缘语义,以指导COD的表示学习,这迫使模型生成突出对象结构的特征,从而促进精确边界定位的伪装对象检测。

在三个具有挑战性的基准数据集上进行的大量实验表明,在四个广泛使用的评估指标下,本文的BGNet显著 优于现有的18种最先进的方法 。

02

Motivation伪装是自然界中一种重要的防御机制,帮助某些物种隐藏在环境中,以保护自己免受捕食者的伤害,通过材料、色彩或照明进行隐藏,或作为其他东西进行自我伪装,例如模仿环境的外观、颜色或图案和破坏性色彩。这种机制也影响人类生活,例如艺术、文化和设计(例如,迷彩制服)。

最近,从背景中识别伪装物体,即伪装物体检测(COD),引起了计算机视觉界越来越多的研究兴趣。它在促进不同领域的各种有价值应用方面有着广阔的前景,从动物保护,例如物种发现和动物监测,到视觉相关领域,包括图像合成、医学图像分析和搜索救援。由于伪装的性质,即候选物体和背景之间的高度内在相似性,因此COD是一项非常具有挑战性的任务。

为了解决这个问题,人们提出了许多基于深度学习的伪装目标检测方法,并显示出巨大的潜力。这些方法大致可分为三种类型。一种是设计 有针对性的网络模块/架构 ,以有效探索COD的区分性伪装对象特征,例如C2FNet、UGTR。一种是 将一些辅助任务纳入联合学习/多任务学习框架 ,例如分类任务、边缘提取、显著目标检测和伪装目标排序。这种方法可以从共享特征中挖掘有价值的额外线索,显著增强COD的特征表示。另一种是 仿生方法 ,它模拟自然界中捕食者的行为过程或人类视觉心理模式来设计网络,例如SINet、MirrorNet和PFNet。

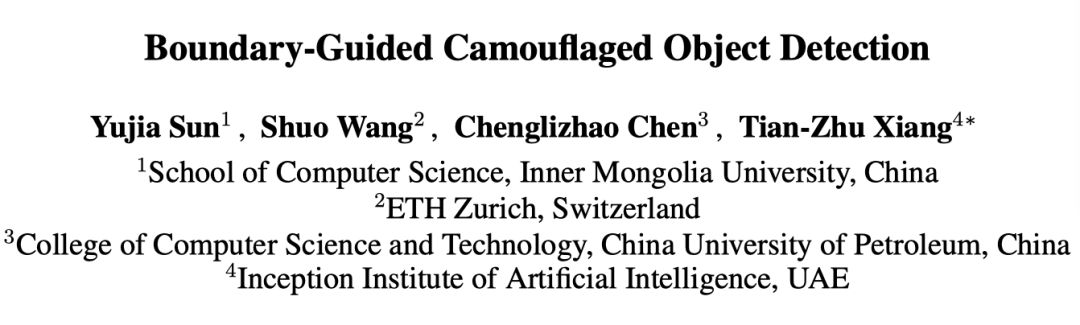

虽然这些最近提出的方法取得了重大进展,但仍存在一些重大问题。由于边缘破坏或身体轮廓伪装,现有方法通常难以有效、完整地识别物体的结构和细节,因此无法提供令人满意的预测结果。如下图所示,由于蝴蝶头/苍鹭腿与其背景环境之间的高度相似性,使得最近最先进的JCSOD和MGL提取的特征具有模糊性。因此,这些模型无法恢复蝴蝶头和苍鹭腿的边界细节。

之前工作表明,边缘先验被广泛用作一种有效的辅助线索,有助于保存对象结构,但对于COD几乎没有研究。从经验上讲,有必要研究如何增强与对象相关的边缘可见性,以促进COD的特征学习。交互图学习模型(MGL)是第一个明确利用边缘信息来提高COD性能的模型。然而,MGL将边缘特征与对象特征一起编码到图卷积网络中,并通过图交互模块增强特征表示。

可以看出,MGL是一个复杂的模型,不可避免地增加了模型的复杂度,并承受着沉重的计算负担。此外,值得注意的是,尽管引入了边缘线索,MGL仍然丢失了一些与边界相关的细节,从而削弱了COD的性能。如下图第2行所示,MGL模型丢失了许多关于鹭腿的细节,并在预测结果中引入了一些明显的背景噪声。

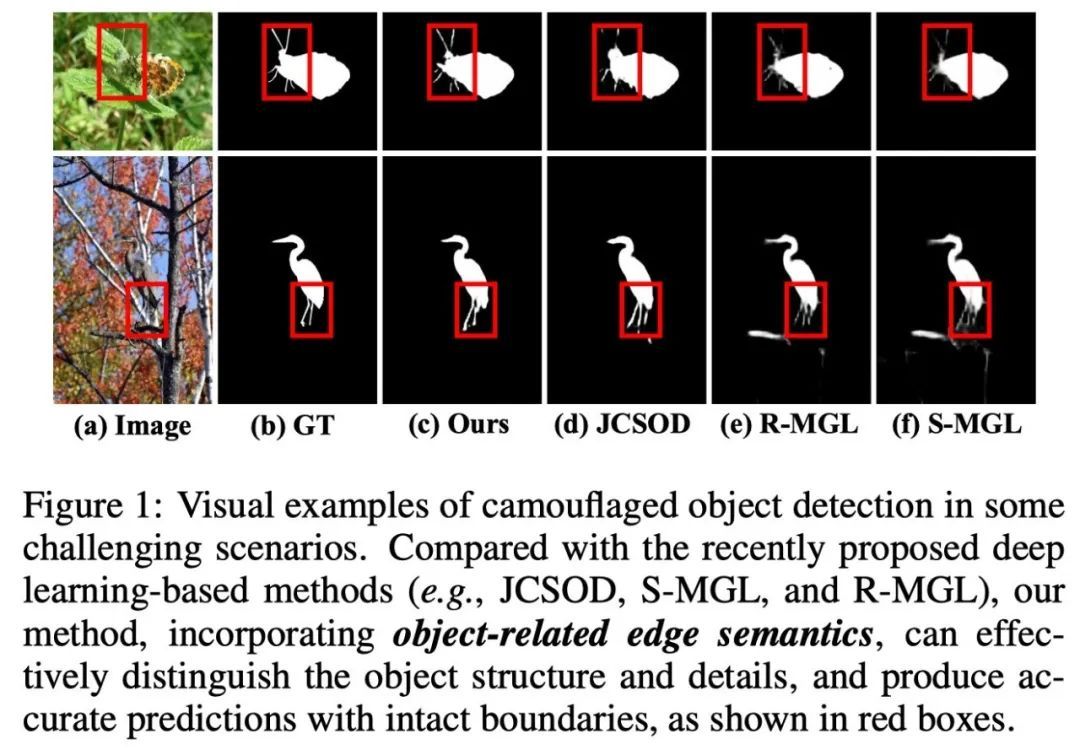

为此,本文提出了一种新的边界引导网络(boundaryguided network,BGNet),该网络明确采用边缘语义来提高伪装目标检测的性能。首先,作者设计了一个简单而有效的 边缘感知模块(EAM) ,该模块集成了低级局部边缘信息和高级全局位置信息,在显式边界监督下探索与对象边界相关的边缘语义。

然后,引入 边缘引导特征模块(EFM) ,将边缘特征与不同层次的伪装对象特征相结合,以指导COD的表示学习。EFM模块可以强制网络更加关注对象结构和细节。然后,从上到下逐步聚合多级融合特征,以预测伪装对象。为了增强特征表示,作者构建了一个 上下文聚合模块(CAM) ,该模块通过一系列螺旋卷积挖掘和聚合多尺度上下文语义,以生成具有更强和更有效表示的特征。

得益于精心设计的模块,本文的BGNet预测具有明确对象结构和边界的伪装对象。注意,与MGL相比,作者设计了一个更简单但更有效的边缘提取模块来挖掘精确的对象边界语义,然后通过提出的EFM和CAM来指导伪装对象的特征表示学习。此外,本文的方法实现了更精确的目标定位和更强的目标结构保留。

综上所述,本文的主要 贡献 如下:

对于COD任务,作者提出了一种新的边界引导网络,即BGNet,该网络挖掘和集成了边界相关的边缘语义,以提高伪装目标检测的性能。

作者设计了边缘引导特征模块(EFM)和上下文聚合模块(CAM),以增强边界语义,并探索有价值和强大的特征表示。

03

方法3.1 Overall Architecture

BGNet的总体架构如上图所示。具体而言,作者采用Res2Net-50作为主干网络,从输入图像中提取多级特征,即。

然后,应用边界感知模块(EAM)从包含局部边缘细节()的低级特征和包含对象边界监督下的全局位置信息()的高级特征中挖掘与对象相关的边缘语义。利用以下多个边缘引导特征模块(EFM)将来自EAM的边缘线索与各级主干特征()集成,以引导特征学习,从而增强边界表示。

最后,使用多个上下文聚合模块(CAM)以自顶向下的方式逐步聚合多级融合特征,并发现伪装对象。在测试中,作者选择最后一个CAM的预测作为最终结果。注意,本文不采用主干特征,因为它离输入太近,有很多冗余信息和一个小的感受野。

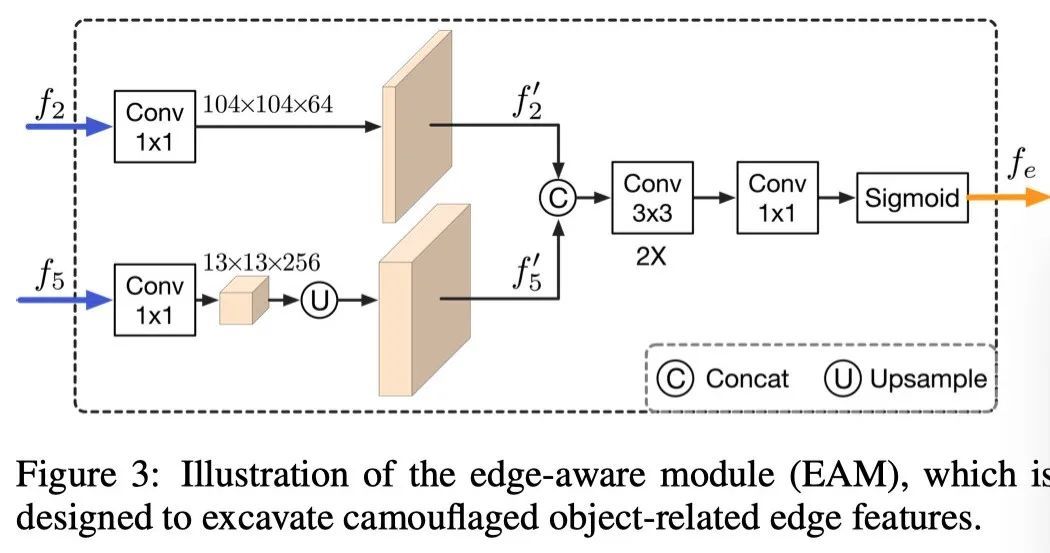

3.2 Edge-aware Module

良好的边缘先验有利于分割和定位中的目标检测。虽然低级特征包含丰富的边缘细节,但它们也引入了许多非对象边缘。因此,需要高级语义或位置信息,以便于探索伪装对象相关的边缘特征。在该模块中,作者结合了低级特征()和高级特征()来建模与对象相关的边缘信息,如上图所示。

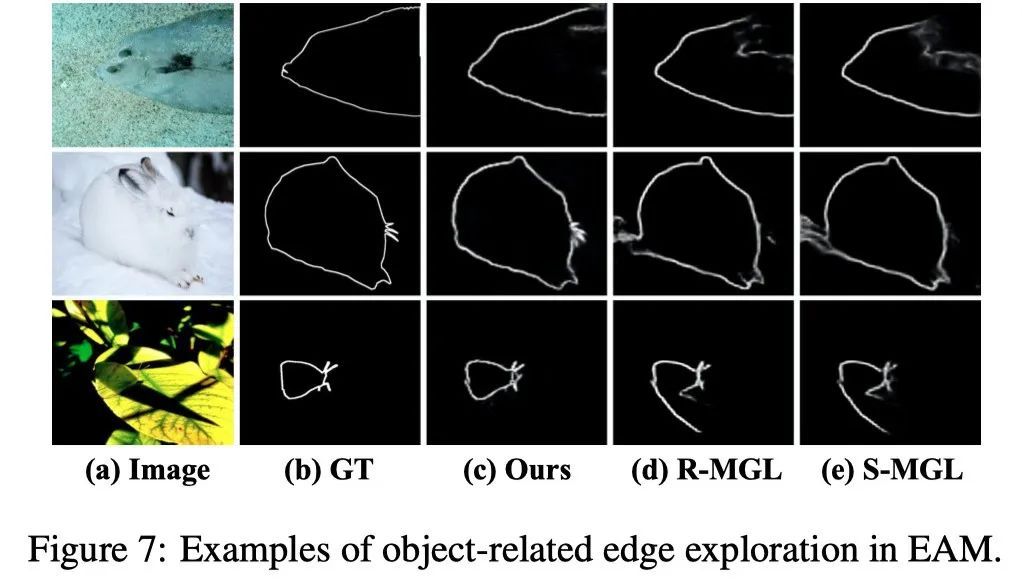

具体来说,首先使用两个1×1卷积层将和的通道分别更改为64()和256()。然后通过concat运算将和上采样的进行集成。最后,通过两个3×3卷积、一个1×1卷积和一个Sigmoid函数得到边缘特征。EAM是一个简单而有效的提取特定边缘特征的模块。如下图所示,EAM完美地学习了对象边界相关的边缘语义。

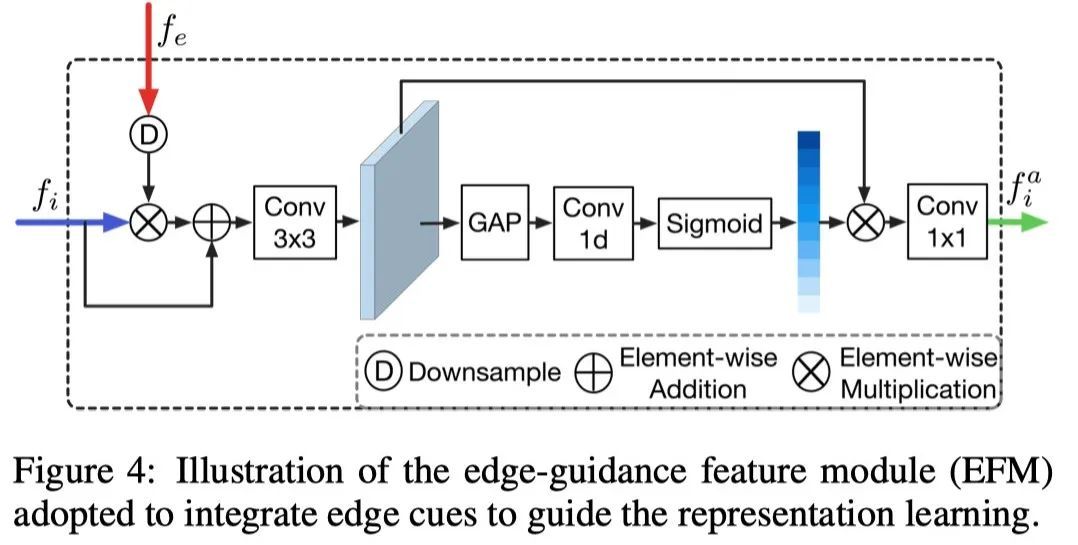

3.3 Edge-guidance Feature Module

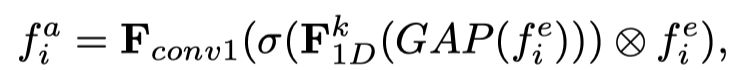

边缘引导特征模块(EFM)旨在将边界相关边缘线索注入表示学习,以增强具有对象结构语义的特征表示。众所周知,不同的特征通道通常包含不同的语义。因此,为了实现良好的集成并获得强大的表示,作者引入了局部通道注意机制来探索跨通道交互并挖掘通道之间的关键线索。

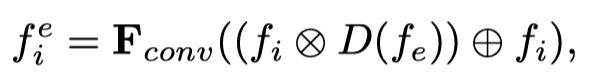

如上图所示,给定输入特征和边缘特征,首先使用额外的残差连接和3×3卷积在它们之间执行元素乘法,以获得初始融合特征,其可以表示为:

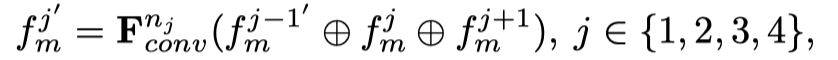

其中D表示下采样,为3×3卷积。⊗ 是元素乘法和⊕ 是元素相加。为了增强特征表示,作者引入局部注意力来探索关键特征通道。具体来说,作者使用通道全局平均池(GAP)聚合卷积特征()。然后,作者通过1D卷积和Sigmoid函数获得相应通道注意力权重。

与全连接操作不同,全连接操作捕获所有通道之间的依赖关系,但显示出高度复杂性,作者探索局部跨通道交互,并以局部方式学习每个注意力,例如,只考虑每个通道的k个邻居。然后,作者将通道注意力与输入特征相乘,并通过1×1减少通道数得到最后的特征:

其中是1×1卷积,是核大小为k的1D卷积,σ表示Sigmoid函数。核大小k可以自适应设置为,其中表示最近的奇数,C是的通道数。核大小与通道尺寸成正比。显然,该注意力策略可以突出关键通道,抑制冗余通道或噪声,从而增强语义表示。

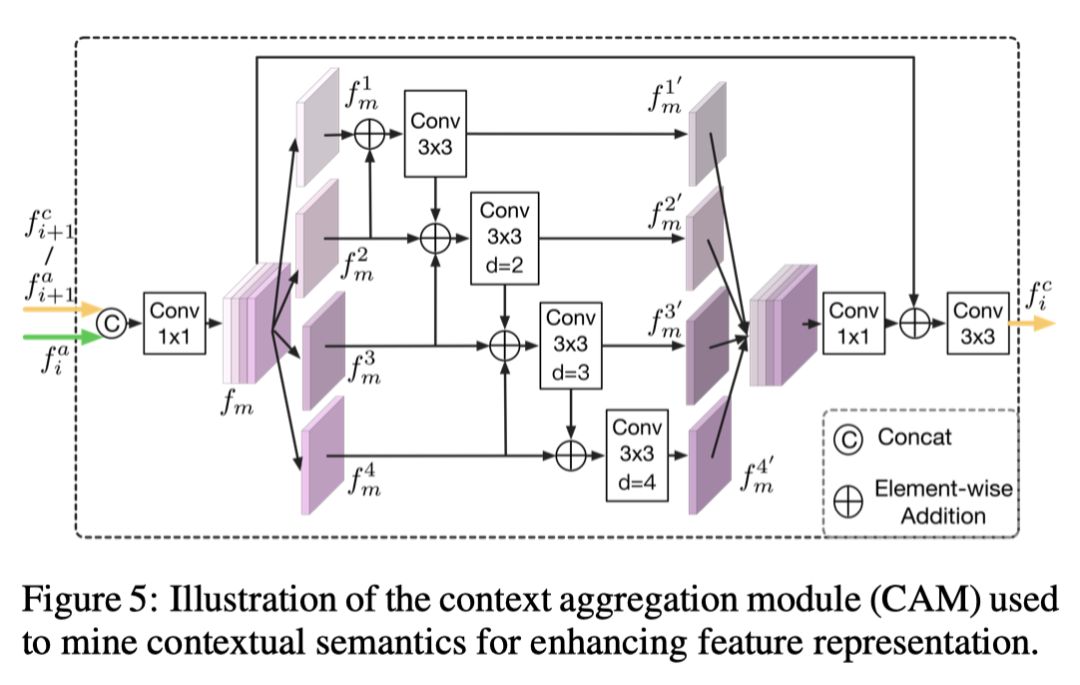

3.4 Context Aggregation Module

为了集成多级融合特征以进行伪装对象预测,作者设计了一个上下文聚合模块(CAM)来挖掘上下文语义以增强对象检测,如上图所示。为了集成多级融合特征以进行伪装对象预测,作者设计了一个上下文聚合模块(CAM)来挖掘上下文语义以增强对象检测,如上图所示。

与BBSNet中的全局上下文模块不同,它只利用几个独立的并行分支来分别提取不同尺度的特征,而不考虑各个分支之间的语义相关性,CAM考虑了跨尺度交互以增强特征表示。

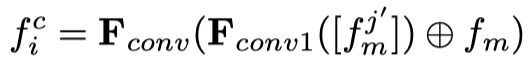

以和为例,作者首先向上采样并concat它们,然后是1×1卷积层,以获得初始聚集特征。接下来,沿着通道维度将平均划分为四个特征映射(),然后执行跨尺度交互学习,即通过一系列空洞卷积来集成相邻分支的特征以提取多尺度上下文特征。它可以公式化为:

其中表示3×3空洞卷积,扩张率为。在本文的实验中,作者将其设置。

此外,对于i=1,只有输入和;对于i=4,只有输入和。然后,将这四个多尺度特征concat起来,然后是1×1卷积、残差连接和3×3卷积,可以表示为:

其中 [∗] 是concat运算,是CAM的输出。对于i = {2,3},将前一个CAM轮的输出 () 与一起用作下一个CAM的输入,以获得。通过另一个1×1卷积来改变特征的通道数,可以获得伪装对象的预测,。

3.5 Loss Function

模型有两种监督:伪装对 象掩码()和伪装对象边缘()。对于掩码监督,作者采用加权二进制交叉熵损失()和加权IOU损失(),它们更关注难像素,而不是为所有像素分配相等的权重。对于边缘监督,作者采用dice loss()来处理正样本和负样本之间的严重不平衡。注意,掩码监督是在三个来自CAM的伪装物体预测()上进行的。因此,总损失定义为:其中λ是一个trade-off参数,设置λ=3。在本文的实验中,是对伪装对象边缘的预测。

04

实验

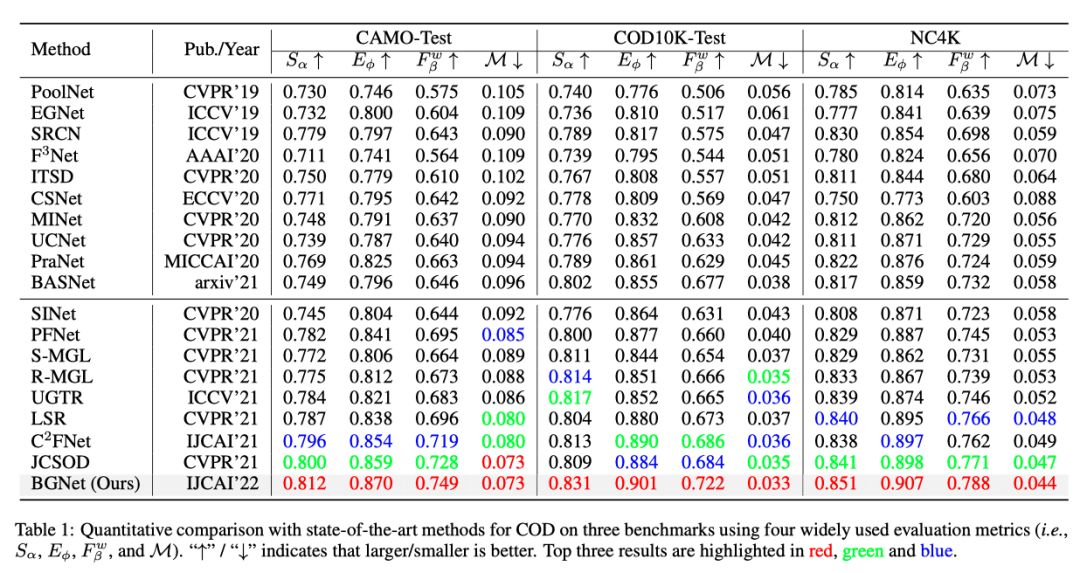

上表报告了本文的方法在三个数据集上对18个竞争方法的定量结果。很明显,在四个评估指标下,本文的方法在三个数据集上优于所有其他模型。

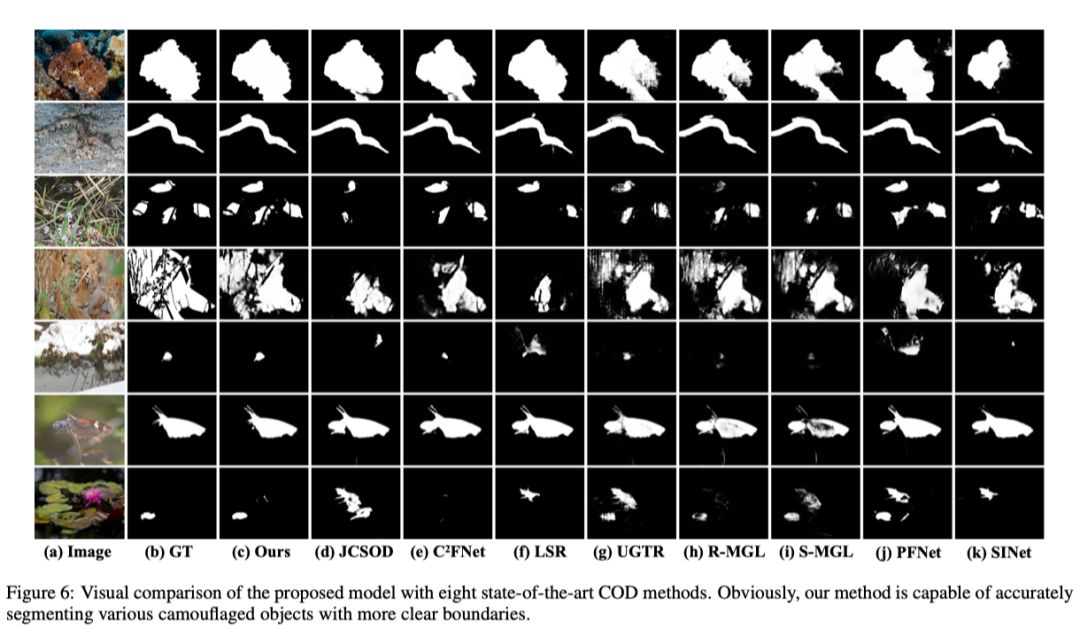

上图显示了COD10K数据集中几个典型样本上不同COD方法的定性比较,涵盖四个超类,即水生、陆地、飞行和两栖。这些结果直观地表明了该方法的优越性能。注意,本文的方法提供了精确的伪装物体预测,具有更完整的物体结构和边界细节。

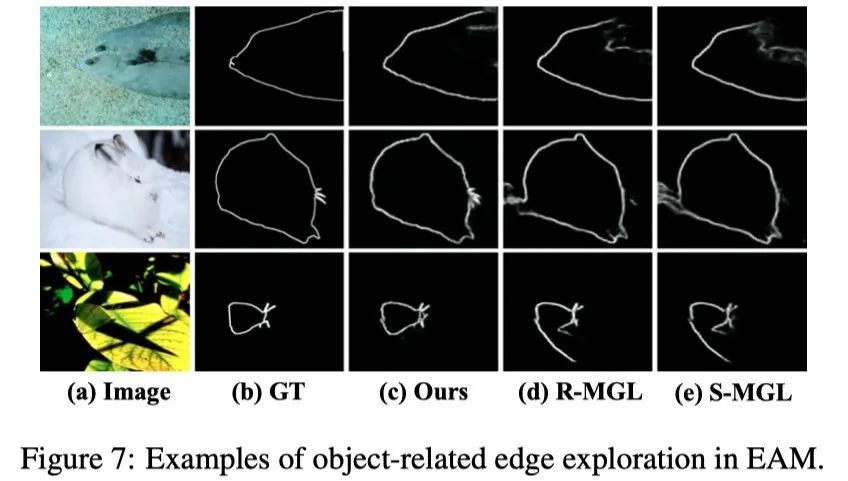

上图显示了本文的模型与MGL在边界相关边缘提取方面的视觉比较。可以看出,尽管MGL提出了一种基于复杂图模型的辅助边缘检测网络,但它仍然丢失了许多结构细节,导致预测中的边界定位较差。事实证明,本文的方法在与对象相关的边缘信息挖掘和伪装对象预测方面取得了优异的性能。

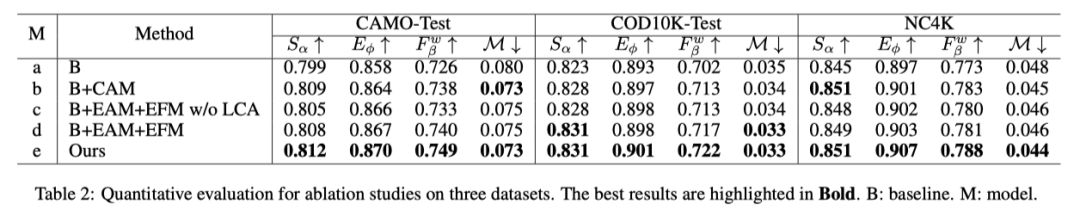

上表展示了本文提出三个结构的消融实验结果,可以看出本文提出的三个关键性结构对于模型性能的提升都是重要的。

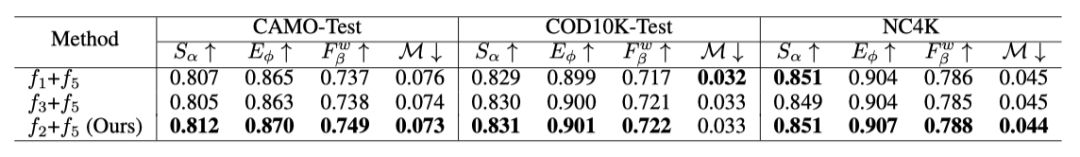

作者还测试了EAM的不同输入的有效性。如上表所示,的组合获得了最佳的伪装目标检测性能。

05

总结通过采用边缘线索,本文的BGNet提供了精确的伪装对象预测,具有完整和明确的对象结构和边界。大量实验表明,本文的方法在三个基准上优于现有的最先进的方法。

参考资料

[1]https://arxiv.org/abs/2207.00794[2] https://github.com/thograce/BGNeth

▊ 作者简介 研究领域:FightingCV公众号运营者,研究方向为多模态内容理解,专注于解决视觉模态和语言模态相结合的任务,促进Vision-Language模型的实地应用。 知乎/公众号:FightingCV

已建立深度学习公众号——FightingCV,欢迎大家关注!!!

ICCV、CVPR、NeurIPS、ICML论文解析汇总:https://github.com/xmu-xiaoma666/FightingCV-Paper-Reading

面向小白的Attention、重参数、MLP、卷积核心代码学习:https://github.com/xmu-xiaoma666/External-Attention-pytorch

2164

2164

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?