✅作者简介:热爱科研的Matlab仿真开发者,擅长数据处理、建模仿真、程序设计、完整代码获取、论文复现及科研仿真。

🍎 往期回顾关注个人主页:Matlab科研工作室

🍊个人信条:格物致知,完整Matlab代码及仿真咨询内容私信。

🔥 内容介绍

随着无人机技术的日益成熟,其应用领域也日趋广泛。尤其是在侦察、巡逻、搜救等任务中,多无人机协同作业能够显著提升效率和鲁棒性。其中,多无人机协同围捕作为一种重要的应用场景,在环境监控、非法入侵追踪、搜寻目标等领域具有极高的价值。然而,多无人机协同围捕任务面临着诸多挑战,例如环境的复杂性、目标的动态性、通信的限制以及计算资源的约束等。传统的控制方法难以适应这些复杂情况,而基于深度强化学习(Deep Reinforcement Learning,DRL)的方法则为解决这些问题提供了新的思路。本文将探讨基于DRL的多无人机协同围捕方法,深入分析其优势、挑战以及未来的发展方向。

多无人机协同围捕的挑战

多无人机协同围捕任务的本质是控制多个无人机,在复杂环境下,通过协调合作,有效地包围并最终控制目标。其挑战主要体现在以下几个方面:

- 环境复杂性:

真实世界的环境往往充满障碍物、干扰以及未知因素。无人机需要具备感知环境的能力,并根据环境信息进行动态规划。传统的路径规划算法难以处理高维、非线性以及不确定性环境。

- 目标动态性:

目标的运动轨迹通常是不可预测的,这要求无人机能够快速适应目标的动态变化,并实时调整围捕策略。传统的控制方法往往难以应对目标速度、方向突变等情况。

- 通信限制:

在实际应用中,无人机之间的通信带宽和距离可能受到限制。如何在高延时、低带宽的通信环境下保持无人机之间的有效协同,是一个重要的挑战。

- 计算资源约束:

无人机的机载计算资源通常比较有限。复杂的算法可能会超出机载计算能力的负荷,导致响应延迟或无法实时运行。因此,需要在算法复杂度和性能之间进行权衡。

- 协同决策复杂性:

多无人机协同需要解决如何分配任务、如何避免冲突、如何协调运动等问题。传统的集中式控制方法难以处理大规模无人机的协同决策,而分布式控制方法则面临着收敛性和稳定性的挑战。

深度强化学习在多无人机协同围捕中的应用优势

DRL作为一种融合了深度学习感知能力和强化学习决策能力的机器学习方法,为解决多无人机协同围捕问题提供了新的契机。其优势主要体现在以下几个方面:

- 强大的感知能力:

深度学习可以从原始传感器数据(如图像、激光雷达数据等)中提取高层次的特征信息,使得无人机能够更好地理解环境。

- 自适应的决策能力:

强化学习可以通过试错的方式学习最优的策略,使得无人机能够根据当前环境状态和目标状态,自主地进行决策。

- 可扩展性:

DRL可以很好地处理大规模无人机的协同问题。通过设计合适的奖励函数和状态表示,可以学习出适用于不同数量无人机的通用策略。

- 鲁棒性:

DRL训练得到的策略具有一定的鲁棒性,可以应对环境中的噪声和不确定性。即使在环境发生变化的情况下,无人机仍然可以有效地完成围捕任务。

- 无需人工设计规则:

DRL 可以通过数据驱动的方式学习最优策略,无需人工设计复杂的规则和参数。这大大简化了系统开发和维护的成本。

基于DRL的多无人机协同围捕方法研究现状

近年来,基于DRL的多无人机协同围捕方法受到了广泛的关注,涌现出了许多优秀的研究成果。这些研究主要集中在以下几个方面:

- 状态表示与奖励函数设计:

状态表示是 DRL 的基础,它决定了无人机能够获取的信息。常见的状态表示包括无人机的位置、速度、目标的位置、障碍物的位置等。奖励函数则用于指导 DRL 算法的学习方向。好的奖励函数应该能够反映围捕任务的完成程度和协同程度。常用的奖励函数包括距离奖励、速度奖励、协同奖励等。

- DRL算法选择:

目前常用的 DRL 算法包括 Deep Q-Network (DQN), Deep Deterministic Policy Gradient (DDPG), Proximal Policy Optimization (PPO) 等。不同的 DRL 算法适用于不同的环境和任务。例如,DQN 适用于离散动作空间,而 DDPG 和 PPO 则适用于连续动作空间。

- 协同策略设计:

多无人机协同需要解决如何分配任务、如何避免冲突、如何协调运动等问题。常见的协同策略包括:

- 集中式控制:

所有无人机的状态和动作都由一个中央控制器进行处理。这种方法可以获得全局最优解,但是计算复杂度高,难以扩展到大规模无人机。

- 分布式控制:

每个无人机都根据自身的状态和邻居的状态进行决策。这种方法计算复杂度低,易于扩展,但是难以保证全局最优解。

- 混合式控制:

将集中式控制和分布式控制相结合。例如,可以使用集中式控制来分配任务,然后使用分布式控制来执行任务。

- 集中式控制:

- 环境建模与仿真:

为了训练 DRL 算法,需要构建一个逼真的环境模型。常用的环境建模方法包括物理引擎仿真和数据驱动仿真。物理引擎仿真可以模拟真实世界的物理规律,但是计算复杂度高。数据驱动仿真则可以通过学习真实数据来构建环境模型,计算复杂度低,但是精度可能不高。

例如,一些研究采用DDPG算法,将无人机及其目标的相对位置、速度等信息作为状态输入,通过设计的奖励函数来鼓励无人机靠近目标并保持适当的距离。另一些研究则采用PPO算法,结合了注意力机制,使得无人机能够更好地关注周围环境中的重要信息,从而做出更明智的决策。在协同策略方面,一些研究提出了基于拍卖机制的任务分配方法,使得无人机能够根据自身的能力和环境状况,动态地参与任务分配。

面临的挑战与未来发展方向

尽管基于DRL的多无人机协同围捕方法取得了显著的进展,但仍然面临着诸多挑战:

- 样本效率:

DRL 算法通常需要大量的训练样本才能学习到有效的策略。如何在有限的样本情况下提高算法的学习效率,是一个重要的挑战。

- 泛化能力:

DRL 算法学习到的策略可能只能在特定的环境中有效。如何提高算法的泛化能力,使得无人机能够在不同的环境中都能够有效地完成围捕任务,是一个重要的挑战。

- 安全性:

在实际应用中,无人机的安全性至关重要。如何保证无人机在围捕过程中不会发生碰撞、坠落等事故,是一个重要的挑战。

- 可解释性:

DRL 算法学习到的策略通常是黑盒的,难以理解。如何提高算法的可解释性,使得人们能够理解无人机的决策过程,是一个重要的挑战。

- 计算资源约束:

在实际应用中,无人机的机载计算资源通常比较有限。如何将 DRL 算法部署到机载平台上,并保证算法的实时性,是一个重要的挑战。

未来的发展方向主要包括:

- 元学习 (Meta-Learning):

元学习可以通过学习多个任务的经验,来快速适应新的任务。可以将元学习应用于多无人机协同围捕任务中,使得无人机能够更快地适应新的环境和目标。

- 迁移学习 (Transfer Learning):

迁移学习可以将从一个任务中学习到的知识迁移到另一个任务中。可以将迁移学习应用于多无人机协同围捕任务中,例如,可以将从仿真环境中学习到的策略迁移到真实环境中。

- 模仿学习 (Imitation Learning):

模仿学习可以通过学习专家的行为,来训练智能体。可以将模仿学习应用于多无人机协同围捕任务中,例如,可以通过学习人类驾驶员的围捕策略来训练无人机。

- 多智能体强化学习 (Multi-Agent Reinforcement Learning,MARL):

MARL 专门研究多个智能体之间的协同问题。可以将 MARL 应用于多无人机协同围捕任务中,例如,可以使用 centralized training and decentralized execution (CTDE) 框架来训练无人机。

- 安全强化学习 (Safe Reinforcement Learning):

安全强化学习旨在保证智能体在学习过程中不会违反安全约束。可以将安全强化学习应用于多无人机协同围捕任务中,例如,可以使用 constrained policy optimization 来保证无人机在围捕过程中不会发生碰撞。

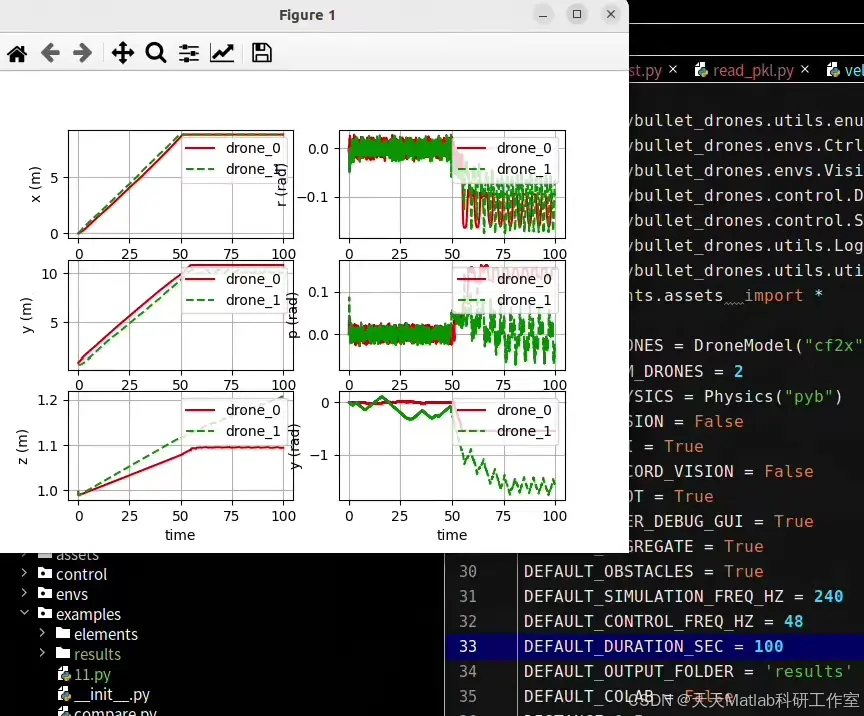

⛳️ 运行结果

🔗 参考文献

📣 部分代码

🎈 部分理论引用网络文献,若有侵权联系博主删除

👇 关注我领取海量matlab电子书和数学建模资料

🏆团队擅长辅导定制多种科研领域MATLAB仿真,助力科研梦:

🌈 各类智能优化算法改进及应用

生产调度、经济调度、装配线调度、充电优化、车间调度、发车优化、水库调度、三维装箱、物流选址、货位优化、公交排班优化、充电桩布局优化、车间布局优化、集装箱船配载优化、水泵组合优化、解医疗资源分配优化、设施布局优化、可视域基站和无人机选址优化、背包问题、 风电场布局、时隙分配优化、 最佳分布式发电单元分配、多阶段管道维修、 工厂-中心-需求点三级选址问题、 应急生活物质配送中心选址、 基站选址、 道路灯柱布置、 枢纽节点部署、 输电线路台风监测装置、 集装箱调度、 机组优化、 投资优化组合、云服务器组合优化、 天线线性阵列分布优化、CVRP问题、VRPPD问题、多中心VRP问题、多层网络的VRP问题、多中心多车型的VRP问题、 动态VRP问题、双层车辆路径规划(2E-VRP)、充电车辆路径规划(EVRP)、油电混合车辆路径规划、混合流水车间问题、 订单拆分调度问题、 公交车的调度排班优化问题、航班摆渡车辆调度问题、选址路径规划问题、港口调度、港口岸桥调度、停机位分配、机场航班调度、泄漏源定位

🌈 机器学习和深度学习时序、回归、分类、聚类和降维

2.1 bp时序、回归预测和分类

2.2 ENS声神经网络时序、回归预测和分类

2.3 SVM/CNN-SVM/LSSVM/RVM支持向量机系列时序、回归预测和分类

2.4 CNN|TCN|GCN卷积神经网络系列时序、回归预测和分类

2.5 ELM/KELM/RELM/DELM极限学习机系列时序、回归预测和分类

2.6 GRU/Bi-GRU/CNN-GRU/CNN-BiGRU门控神经网络时序、回归预测和分类

2.7 ELMAN递归神经网络时序、回归\预测和分类

2.8 LSTM/BiLSTM/CNN-LSTM/CNN-BiLSTM/长短记忆神经网络系列时序、回归预测和分类

2.9 RBF径向基神经网络时序、回归预测和分类

2.10 DBN深度置信网络时序、回归预测和分类

2.11 FNN模糊神经网络时序、回归预测

2.12 RF随机森林时序、回归预测和分类

2.13 BLS宽度学习时序、回归预测和分类

2.14 PNN脉冲神经网络分类

2.15 模糊小波神经网络预测和分类

2.16 时序、回归预测和分类

2.17 时序、回归预测预测和分类

2.18 XGBOOST集成学习时序、回归预测预测和分类

2.19 Transform各类组合时序、回归预测预测和分类

方向涵盖风电预测、光伏预测、电池寿命预测、辐射源识别、交通流预测、负荷预测、股价预测、PM2.5浓度预测、电池健康状态预测、用电量预测、水体光学参数反演、NLOS信号识别、地铁停车精准预测、变压器故障诊断

🌈图像处理方面

图像识别、图像分割、图像检测、图像隐藏、图像配准、图像拼接、图像融合、图像增强、图像压缩感知

🌈 路径规划方面

旅行商问题(TSP)、车辆路径问题(VRP、MVRP、CVRP、VRPTW等)、无人机三维路径规划、无人机协同、无人机编队、机器人路径规划、栅格地图路径规划、多式联运运输问题、 充电车辆路径规划(EVRP)、 双层车辆路径规划(2E-VRP)、 油电混合车辆路径规划、 船舶航迹规划、 全路径规划规划、 仓储巡逻

🌈 无人机应用方面

无人机路径规划、无人机控制、无人机编队、无人机协同、无人机任务分配、无人机安全通信轨迹在线优化、车辆协同无人机路径规划

🌈 通信方面

传感器部署优化、通信协议优化、路由优化、目标定位优化、Dv-Hop定位优化、Leach协议优化、WSN覆盖优化、组播优化、RSSI定位优化、水声通信、通信上传下载分配

🌈 信号处理方面

信号识别、信号加密、信号去噪、信号增强、雷达信号处理、信号水印嵌入提取、肌电信号、脑电信号、信号配时优化、心电信号、DOA估计、编码译码、变分模态分解、管道泄漏、滤波器、数字信号处理+传输+分析+去噪、数字信号调制、误码率、信号估计、DTMF、信号检测

🌈电力系统方面

微电网优化、无功优化、配电网重构、储能配置、有序充电、MPPT优化、家庭用电

🌈 元胞自动机方面

交通流 人群疏散 病毒扩散 晶体生长 金属腐蚀

🌈 雷达方面

卡尔曼滤波跟踪、航迹关联、航迹融合、SOC估计、阵列优化、NLOS识别

🌈 车间调度

零等待流水车间调度问题NWFSP 、 置换流水车间调度问题PFSP、 混合流水车间调度问题HFSP 、零空闲流水车间调度问题NIFSP、分布式置换流水车间调度问题 DPFSP、阻塞流水车间调度问题BFSP

👇

1435

1435

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?