Generalized Focal Loss Learning Qualified and Distributed Bounding Boxes for Dense Object Detection阅读笔记

(一)Title

GFL可以应用于任何单级检测器

前言:这篇文章在GFL和DFL上的数学表示干净漂亮,充分展示了数学之美(主要是咱能看懂一些了),除了合并classfication score和Localization Quality Estimation的工作之外,作者这里对于深度学习中标注的label提出了质疑,同时给出了解决质疑的方法,利用一个通用分布来表示回归的标注。真的是理论很完整的文章。非常推荐大家仔细阅读下

(二)Summary

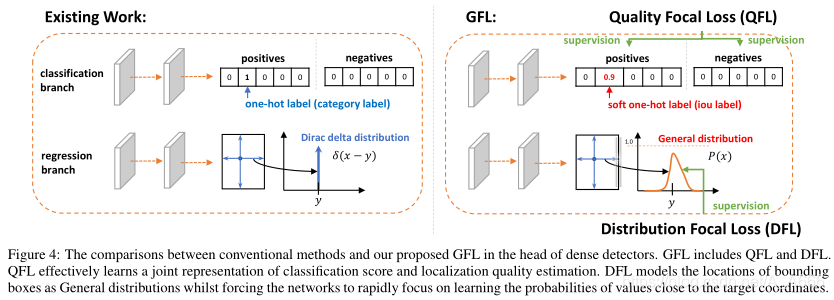

One-stage检测器将目标检测形式化为dense classification和localization。分类通常通过Focal Loss进行优化,bounding box的定位通常利用狄拉克δ分布进行学习。One-stage检测器的最新趋势是引入an individual prediction branch(单独的预测分支)来帮助分类,从而提升检测性能。

作者在实践过程中发现了两个问题:

- 在训练和推断阶段,质量评估和分类使用的不一致(即,单独训练但在测试中复合使用)

- 用于定位的狄拉克δ分布在存在模糊性以及不确定性时存在着不够灵活的特征,而这种模糊性以及不确定性在复杂场景中常常会这样。

为了解决上述的两个问题,作者将quality estimation合并到 class prediction vector 中从而形成一个定位质量和分类的联合表示,此外使用一个vector来表示box位置的任意分布。作者的改进消除了不一致性风险,并准确地描述了真实数据中的灵活分布,但是存在的问题是出现了连续标签,使得Focal Loss无法使用,因此作者将离散形式的Focal Loss 推广到连续形式的Generalized Focal Loss(GFL)上,并能够成功的进行优化。

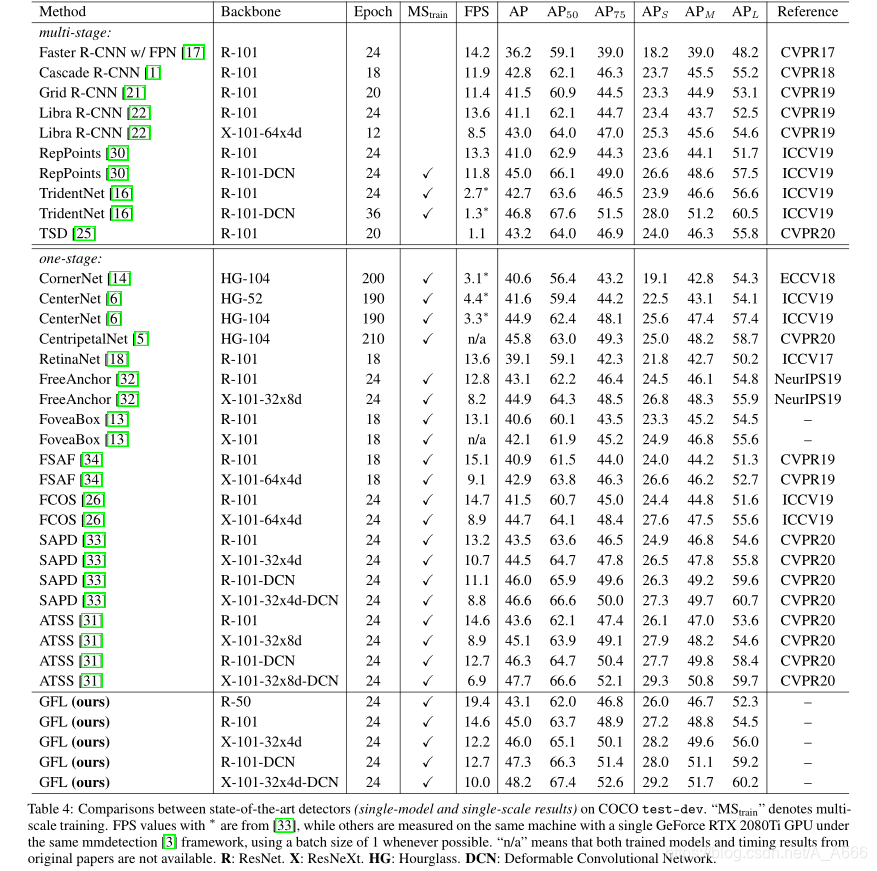

性能表现:

在 COCO test-dev上,45.0% AP using ResNet-101 backbone,同时在速度上具有较大优势, single-scale AP of 48.2%, at 10 FPS on a single 2080Ti GPU

(三)Research Object

本文主要的3个研究对象是:

- localization quality representation(定位质量估计)

我们联合了classification score以及IoU score得到了一个联合的单个变量(文中称之为classification-IoU joint representation),能够进行端到端训练,在推理阶段可以直接使用

消除了classfication score和IoU score之间的不相关性,下图的散点图表示,随机抽样的实例及其预测分数,蓝色表示是之前网络,classification score 和 IoU score 之间相关性较差,作者采用联合分布的形式迫使两者相关,这里我觉得绿点有点夸张,完全等比例关系的话,我们直接使用classification score来做NMS排序不就好了

同时拿负样本训练IoU score分数为0,使得整体的预测更加的可靠,作者提出这对于dense Object detection尤其有利,因为能够得到更加正确的排序,从而保证NMS结果的正确性(我们在inference阶段,使用的预测结果是经过NMS之后的来计算mAP、AR等指标)。

- bounding box representation(边界框的表示)

本文中不引入更强的先验,通过直接学习其连续空间上的离散化概率分布来表示boxes location的任意分布(文中称之为General distribution),从而使得能够获得更可靠和准确的包围盒估计,同时也可以知道bounding box的各种潜在的分布,这里说的分布应该指的是下图中右图的分布(博主个人理解)。

经过上面作者的联合classfication score和IoU score,带来了一个问题,就是我们现在使用连续的IoU label(0~1)作为监督,而类别损失Focal Loss中仅仅支持离散的类别标签{0,1}.因此,作者在这里将FL离散形式进行调整。

- Generalized Focal Loss(GFL)

Generalized Focal Loss(GFL).更具体的来说,GFL可以分成Quality Focal Loss(QFL)以及Distribution Focal Loss(DFL)

QFL专注于a sparse set of hard examples,同时在相应的类别上产生它们的连续0~1之间的localization quality estimation;

DFL使网络能够在任意和灵活的分布下,学习bounding boxes在连续位置上的概率值。

(四)Problem Statement

本文提出了两个问题:

-

由于当前研究关于localization quality estimation在训练和测试阶段不一致,导致的在测试阶段,一些类别置信度较低的目标具有较高的localization quality分数,两者乘积后进行排序,造成一些差样本被NMS挑选了出来作为预测结果,作者提出将localization quality estimation和classification score联合起来。怎么进行联合成为了本文的一个问题。

-

接着作者指出当前bounding boxes表示几乎全是狄拉克 δ \delta δ分布,作者在前面分析了使用 δ \delta δ分布存在的一系列问题,同时指出高斯分布约束过强的问题,如何得到使用一个灵活、并且接近实际的分类来进行bounding boxes的表示成为本文的第二个问题。

(五)Method

5.1 作者基于原始Focal Loss的改动

原始Focal Loss的表现形式为:

F

L

(

p

)

=

−

(

1

−

p

t

)

γ

log

(

p

t

)

,

p

t

=

{

p

,

when

y

=

1

1

−

p

,

when

y

=

0

\mathbf{F L}(p)=-\left(1-p_{t}\right)^{\gamma} \log \left(p_{t}\right), p_{t}=\left\{\begin{aligned} p, & \text { when } y=1 \\ 1-p, & \text { when } y=0 \end{aligned}\right.

FL(p)=−(1−pt)γlog(pt),pt={p,1−p, when y=1 when y=0

从上面可以看出,当我们的类别标签

y

=

1

y=1

y=1时,我们预测

y

=

1

y=1

y=1的概率为

p

p

p,当

p

p

p接近1时,我们在交叉熵项上乘的数相比于

p

p

p接近0时,要小得多,也就是在这里更加看重错误分类的样本。

Focal Loss变换到Quality Focal Loss (QFL)

作者提出的IoU score 和 classification score的联合表示classification-IoU,此时的类别标签对于正例来说不再是0和1了,比如我们在Faster RCNN中iou超过多少时,我们标记当前样本为正样本。这里正样本的标签不再是1,而是a soft one-hot label 软化的独热编码。这个软化的值是什么呢?正样本的目标值就是预测bounding boxes和真实Ground Truth之间的IoU。

作者在软化Ground Truth之后,遇到了一个问题,就是原来的Focal Loss 没有办法再进行使用,作者这里的做的两个调整为:

- 将交叉熵部分展开来写: − log ( p t ) -\log \left(p_{t}\right) −log(pt)写成 − ( ( 1 − y ) log ( 1 − σ ) + y log ( σ ) ) -((1-y) \log (1-\sigma)+y \log (\sigma)) −((1−y)log(1−σ)+ylog(σ))

- 将Focal Loss的 ( 1 − p t ) γ \left(1-p_{t}\right)^{\gamma} (1−pt)γ项增加绝对值符号变成 ∣ y − σ ∣ β ( β ≥ 0 ) |y-\sigma|^{\beta}(\beta \geq 0) ∣y−σ∣β(β≥0),这里使用绝对值是为了保证值非负。

最终得到的Quality Focal Loss(QFL)的表现形式为:

Q

F

L

(

σ

)

=

−

∣

y

−

σ

∣

β

(

(

1

−

y

)

log

(

1

−

σ

)

+

y

log

(

σ

)

)

\mathbf{Q F L}(\sigma)=-|y-\sigma|^{\beta}((1-y) \log (1-\sigma)+y \log (\sigma))

QFL(σ)=−∣y−σ∣β((1−y)log(1−σ)+ylog(σ))

从式中可以看出,当

σ

=

y

\sigma = y

σ=y时,达到了全局最小值,哎,有了式子之后,我们再给他画张图,解释个一段就更清楚了

接着我们再变换到Distribution Focal Loss上

NOTES:这段在说明上是基于博主个人理解来解释的,一些符号用的也就博主自己定义的,跟论文中有一些出入

假定我们需要回归的目标值为 Y Y Y(比如说就是我们的y轴坐标值),为一随机变量

我们y轴坐标的Ground Truth有一个标注(人为标注上去的),这个标注值我们计作 y y y

我们这里将回归目标值 Y Y Y看成一个随机变量的原因是:我们对标注 y y y持有质疑态度,我们认为这个标注结果可能不是正确的。

但是目前大多数回归的做法是,将 Y Y Y ~ p ( x ) p(x) p(x) = δ ( x − y ) \delta(x-y) δ(x−y),其中 x x x表示目标值 Y Y Y的取值,这个是可以变化的,从分布角度来看,表示的是Y的取值范围。

因为 Y Y Y ~ p ( x ) p(x) p(x)为一分布,其满足 ∫ − ∞ + ∞ p ( x ) d x = ∫ − ∞ + ∞ δ ( x − y ) d x = 1 \int_{-\infty}^{+\infty}p(x) \mathrm{d} x=\int_{-\infty}^{+\infty} \delta(x-y) \mathrm{d} x=1 ∫−∞+∞p(x)dx=∫−∞+∞δ(x−y)dx=1,

接着作者在文中提出使用积分形式去恢复

y

y

y的叙述我没有理解

这里我是觉得下面的积分式是在对随机变量

Y

Y

Y取一个期望,也就是我们预测目标的期望

E

[

Y

]

E[Y]

E[Y],这里的这个

p

(

x

)

p(x)

p(x)就相当于我们对于真实目标的一个估计。我们当然希望我们定义的随机变量

Y

Y

Y的某个属性(期望)是我们标注的结果

y

y

y。因此这个地方我的理解是这样的。

y

=

E

[

Y

]

=

∫

−

∞

+

∞

δ

(

x

−

y

)

x

d

x

y=E[Y]=\int_{-\infty}^{+\infty} \delta(x-y) x \mathrm{~d} x

y=E[Y]=∫−∞+∞δ(x−y)x dx

再接着作者提出

由于狄拉克 δ \delta δ分布以及高斯分布并不能够很好地反应真实情况,作者直接提出学习一个通用的分布General distribution P ( x ) P(x) P(x)

按照上面的思路,即

y

=

E

[

Y

]

y=E[Y]

y=E[Y],作者当前假设

Y

Y

Y ~

P

(

x

)

P(x)

P(x),这里的

P

(

x

)

P(x)

P(x)不同于上文的

p

(

x

)

=

δ

(

x

−

y

)

p(x)=\delta(x-y)

p(x)=δ(x−y),我们首先应该研究的是我们的

E

[

Y

]

E[Y]

E[Y]到底是什么?,作者这里也增加了新的约束,此时我们对目标值Y,需要加上新的约束

Y

∈

[

y

m

i

n

,

y

m

a

x

]

其

中

n

∈

N

+

Y \in [y_{min},y_{max}]其中n \in N^+

Y∈[ymin,ymax]其中n∈N+,这个约束相比于高斯分布和狄拉克分布松了太多了。

E

[

Y

]

=

∫

−

∞

+

∞

P

(

x

)

x

d

x

=

∫

y

m

i

n

y

m

a

x

P

(

x

)

x

d

x

E[Y] = \int_{-\infty}^{+\infty} P(x) x \mathrm{~d} x=\int_{y_{min}}^{y_{max}} P(x) x \mathrm{~d} x

E[Y]=∫−∞+∞P(x)x dx=∫yminymaxP(x)x dx

我们最终肯定是想要这个

P

(

x

)

P(x)

P(x)的,比如说,这个

P

(

x

)

P(x)

P(x)的取最大值的位置

x

x

x=x,我们可以看作是真正的真实值为x的可能性比较大。这个x可能和我们的标注

y

y

y相同,也有可能和我们的标注

y

y

y不同。然后我们再利用这个最大概率密度处的x再怎怎做…

因此我们让网络输出这个

P

(

x

)

P(x)

P(x)挺重要的,那么我们怎么让网络输出

P

(

x

)

P(x)

P(x)呢?

作者这里的做法是:我们输出不来所有位于 x ∈ [ y m i n , y m a x ] x \in [y_{min},y_{max}] x∈[ymin,ymax]的 P ( x ) P(x) P(x),但是我们可以离散化处理,我们将 y m i n y_{min} ymin计作 y 0 y_0 y0, y m a x y_{max} ymax计作 y n y_n yn,在中间划分n个长度为 Δ \Delta Δ的区间,区间的端点为 { y 0 , y 1 , … , y i , y i + 1 , … , y n − 1 , y n } \left\{y_{0}, y_{1}, \ldots, y_{i}, y_{i+1}, \ldots, y_{n-1}, y_{n}\right\} {y0,y1,…,yi,yi+1,…,yn−1,yn},分别输出在这n+1个值上的概率,用这个离散概率分布来代替连续的概率密度函数,同时按照黎曼积分定义上述的 E [ Y ] E[Y] E[Y]积分式也可以化简成求和形式.

E ( Y ) = ∑ i = 1 n P ( y i ) y i Δ E(Y) = \sum_{i=1}^{n} P\left(y_{i}\right) y_{i}\Delta E(Y)=i=1∑nP(yi)yiΔ

此外概率密度函数还要满足积分和为1.得到下式:

∑ i = 1 n P ( y i ) Δ = 1 \sum_{i=1}^{n} P\left(y_{i}\right)\Delta=1 i=1∑nP(yi)Δ=1

这里的下标我做了些调整,从 i = 1 i=1 i=1开始,这里还需要注意的是P表示的是概率密度,而不是离散的概率,我们令 Q ( x ) = P ( x ) Δ Q(x) = P(x)\Delta Q(x)=P(x)Δ,再将上式中的 P ( x ) Δ P(x)\Delta P(x)Δ用 Q ( x ) Q(x) Q(x)代替,得到:

E ( Y ) = ∑ i = 1 n Q ( y i ) y i E(Y) = \sum_{i=1}^{n} Q\left(y_{i}\right) y_{i} E(Y)=i=1∑nQ(yi)yi

以及

∑ i = 1 n Q ( y i ) = 1 \sum_{i=1}^{n} Q\left(y_{i}\right)=1 i=1∑nQ(yi)=1

由于目前 Q ( x ) Q(x) Q(x)表示离散的概率值,取值范围为[0,1],因此我们可以直接用Sigmoid函数 S ( ⋅ ) \mathcal{S}(\cdot) S(⋅)来进行估计。

作者这里使用了n+1个输出经过sigmoid来模拟

P

(

y

0

)

.

.

.

P

(

y

n

)

P(y_0)...P(y_n)

P(y0)...P(yn).按照机器学习的思路,我们这里需要给这n+1个输出提供真实值。我们可以提供下面所示的任意形状的值(注意这里应该是离散的,但是论文中没有离散的图,我们就用连续的看看)

从上图中,有一个竖线,这个竖线表示的位置,我们可以认为就是我们的标注

y

y

y,我们从上图(3)中可以看出,这种分布,能够给出一个比较确定的结果,就这个分布比较自信,我们就喜欢这种自信的分布,同时我们还希望我们的自信不是盲目自信,我们最大值应该离竖线很近,也就是我们最大值对应的横轴坐标非常接近标注

y

y

y,我们怎么实现令分布最大值最接近

y

y

y呢?

作者这里提出让和

y

y

y临近的两个点

y

i

y_i

yi以及

y

i

+

1

y_{i+1}

yi+1的概率增加(这里作者使用的方法非常巧妙)

D

F

L

(

S

i

,

S

i

+

1

)

=

−

(

(

y

i

+

1

−

y

)

log

(

S

i

)

+

(

y

−

y

i

)

log

(

S

i

+

1

)

)

=

−

(

(

y

i

+

1

−

y

)

log

(

Q

i

)

+

(

y

−

y

i

)

log

(

Q

i

+

1

)

)

\mathbf{D F L}\left(\mathcal{S}_{i}, \mathcal{S}_{i+1}\right)=-\left(\left(y_{i+1}-y\right) \log \left(\mathcal{S}_{i}\right)+\left(y-y_{i}\right) \log \left(\mathcal{S}_{i+1}\right)\right) = -\left(\left(y_{i+1}-y\right) \log \left(Q_{i}\right)+\left(y-y_{i}\right) \log \left(Q_{i+1}\right)\right)

DFL(Si,Si+1)=−((yi+1−y)log(Si)+(y−yi)log(Si+1))=−((yi+1−y)log(Qi)+(y−yi)log(Qi+1))

从上式我们可以看出,当

y

i

+

1

y_{i+1}

yi+1和

y

y

y非常接近时,损失值会减小,并且

Q

i

Q_i

Qi和

Q

i

+

1

Q_{i+1}

Qi+1值较大时,损失值也较小。从而达到作者上述描述的情况。

进一步深入研究当前的损失函数,我们需要看看DFL取最小值时,对应的网络两个输出节点

Q

i

Q_i

Qi以及

Q

i

+

1

Q_{i+1}

Qi+1的值是多少,(这里假定

y

i

,

y

i

+

1

y_i,y_{i+1}

yi,yi+1以及标注

y

y

y为已知量。)但是,两个变量的最小值根本没法确定,我们可以让

Q

i

Q_i

Qi和

Q

i

+

1

Q_{i+1}

Qi+1输出都为1,那么这样的话,这个函数的最小值就是0了。

作者这里在补充材料中给出了第二个约束条件

Q

i

+

Q

i

+

1

=

1

Q_i+Q_{i+1} = 1

Qi+Qi+1=1.在这两个约束条件的作用下,可以得到DFL取最小值时对应的

Q

i

Q_i

Qi和

Q

i

+

1

Q_{i+1}

Qi+1的值分别是什么?

Q

i

=

y

i

+

1

−

y

y

i

+

1

−

y

i

,

Q

i

+

1

=

y

−

y

i

y

i

+

1

−

y

i

Q_{i}=\frac{y_{i+1}-y}{y_{i+1}-y_{i}}, \mathcal{Q}_{i+1}=\frac{y-y_{i}}{y_{i+1}-y_{i}}

Qi=yi+1−yiyi+1−y,Qi+1=yi+1−yiy−yi

此时我们再来看

E

(

Y

)

=

∑

i

=

1

n

Q

(

y

i

)

y

i

=

Q

i

y

i

+

Q

i

+

1

y

i

+

1

=

y

E(Y) = \sum_{i=1}^{n} Q\left(y_{i}\right) y_{i} = Q_iy_i + Q_{i+1}y_{i+1} = y

E(Y)=∑i=1nQ(yi)yi=Qiyi+Qi+1yi+1=y和我们使用

Δ

\Delta

Δ分布的情况相同。数学简直了!真的很完美。

5.2 统一DFL和QFL到Generalized Focal Loss(GFL)

整理DFL的形式:我们将上面的

y

i

y_i

yi重新计作

y

l

y_l

yl,

y

i

+

1

y_{i+1}

yi+1重新计作

y

r

y_r

yr,将

Q

i

Q_i

Qi计作

p

y

l

p_{y_l}

pyl,将

Q

i

+

1

Q_{i+1}

Qi+1计作

p

y

r

p_{y_r}

pyr,我们同时希望我们网络输出

Q

i

Q_i

Qi,

Q

i

+

1

Q_{i+1}

Qi+1要满足我们对于期望的要求,即

Q

i

y

i

+

Q

i

+

1

y

i

+

1

→

y

Q_iy_i + Q_{i+1}y_{i+1} \rightarrow y

Qiyi+Qi+1yi+1→y,我们将这项作为调制因子乘到DFL上,得到了最终的下式。

G

F

L

(

p

y

l

,

p

y

r

)

=

−

∣

y

−

(

y

l

p

y

l

+

y

r

p

y

r

)

∣

β

(

(

y

r

−

y

)

log

(

p

y

l

)

+

(

y

−

y

l

)

log

(

p

y

r

)

)

\mathbf{G F L}\left(p_{y_{l}}, p_{y_{r}}\right)=-\left|y-\left(y_{l} p_{y_{l}}+y_{r} p_{y_{r}}\right)\right|^{\beta}\left(\left(y_{r}-y\right) \log \left(p_{y_{l}}\right)+\left(y-y_{l}\right) \log \left(p_{y_{r}}\right)\right)

GFL(pyl,pyr)=−∣y−(ylpyl+yrpyr)∣β((yr−y)log(pyl)+(y−yl)log(pyr))

从上面分析DFL的最小值,此处对于GFL同样在

p

y

l

∗

=

y

r

−

y

y

r

−

y

l

,

p

y

r

∗

=

y

−

y

l

y

r

−

y

l

p_{y_{l}}^{*}=\frac{y_{r}-y}{y_{r}-y_{l}}, p_{y_{r}}^{*}=\frac{y-y_{l}}{y_{r}-y_{l}}

pyl∗=yr−ylyr−y,pyr∗=yr−yly−yl这两个位置取得最小值,证明过程(这部分我偷懒了没有看)在补充材料中,同时我们网络估计的输出为

y

y

y也就是真实标签。

关于GFL是DFL和QFL的通用形式可以见补充材料内容(又偷了个懒)。

GFL可以应用于任何单级检测器,在回归时,原来输出1个目标,现在输出(n+1)个目标,这个计算成本很小

5.3 综合上述的DFL和GFL,本文的损失函数为:

L

=

1

N

pos

∑

z

L

Q

+

1

N

pos

∑

z

1

{

c

z

∗

>

0

}

(

λ

0

L

B

+

λ

1

L

D

)

\mathcal{L}=\frac{1}{N_{\text {pos}}} \sum_{z} \mathcal{L}_{\mathcal{Q}}+\frac{1}{N_{\text {pos}}} \sum_{z} \mathbf{1}_{\left\{c_{z}^{*}>0\right\}}\left(\lambda_{0} \mathcal{L}_{\mathcal{B}}+\lambda_{1} \mathcal{L}_{\mathcal{D}}\right)

L=Npos1z∑LQ+Npos1z∑1{cz∗>0}(λ0LB+λ1LD)

其中

L

Q

\mathcal{L}_{\mathcal{Q}}

LQ表示QFL,

L

D

\mathcal{L}_{\mathcal{D}}

LD表示DFL。

L

B

\mathcal{L}_{\mathcal{B}}

LB表示GIoU Loss。

N

p

o

s

N_{pos}

Npos表示正样本数。我们也在训练中利用Quality Score来加权

L

D

\mathcal{L}_{\mathcal{D}}

LD和

L

B

\mathcal{L}_{\mathcal{B}}

LB

(六)Experiment

6.1 实验中的细节设置

- 训练数据使用:trainval35k (115K图像)

- 验证数据:minival (5K图像)作为Ablation Study的交融实验。

- 最终结果我们在test-dev(20K图像)进行验证,可从评估服务器获得。

- 使用mmdetection中的超参数

- 以ResNet-50作为backbone,

- 没有使用多尺度训练。

6.2 QFL作用的研究

6.2.1 我们联合QFL和单独的Quality Branch之间的差异

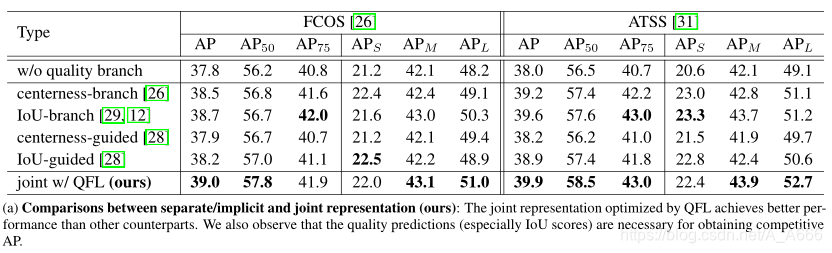

两种表示定位质量的方式:IoU以及Centerness,并且作者的实验证明IoU的性能始终优于Centerness。使用联合的方式QFL要优于单独使用。

6.2.2 我们提出的QFL在one-stage检测器中的作用

加上我们的QFL之后,性能有了较大的提升。

6.2.3 QFL中的 β \beta β超参数

从上述的实验中,用QFL训练的联合表示由于其更可靠的质量估计而有利于检测,并且根据其定义在分类和质量得分之间产生最强的相关性。

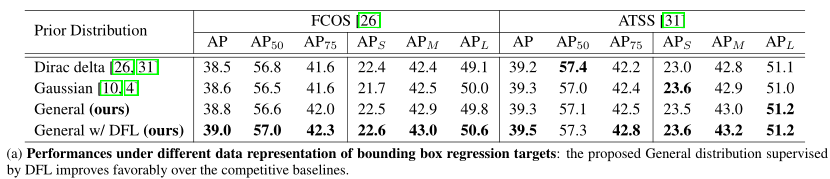

6.3 DFL的有效性

我们比较了不同数据表示对包围盒回归的有效性。我们发现,通用分布实现了卓越或至少可比较的结果,而DFL可以进一步提高其性能。

n

n

n值对性能的影响

Δ

\Delta

Δ值对性能的影响

6.4 DFL和QFL结合在帧率、性能上的表现

性能提升,但是在帧率上变化不大,计算开销可以忽略不计。

6.5 和State-of-art网络的比较

(七)Conclusion

我们提出了Generalized Focal Loss(GFL),它将原来的Focal Loss从离散形式推广到连续形式。GFL可以分为Quality Focal Loss(QFL)和Distribution Focal Loss(DFL)

- QFL鼓励学习更好的classification score和localization Quality estimation的联合表示

- DFL通过将它们的位置建模为Generalized Distribution来提供更丰富和更精确的边界框估计。

大量实验验证了GFL的有效性。我们希望GFL可以作为a baseline.

(八)Notes

1. 当前Object Detection的发展状况

目前dense detectors(密集场景的检测)成为当前目标检测的一个趋势, 在bounding boxes representation 以及 localization quality estimation上都取得了不错的研究。

- 通常bounding box的表示被建模成一个狄拉克Delta分布,

- 在Localization quality estimation上,在FCOS中预测了一个额外的localization quality(IoU scores或者centerness score),结合预测的类别置信度(通常是两者相乘得到一个新的score),利用这个新的score去对NMS进行排序

虽然在上述的两个问题上取得了较为不错的性能表现,但是依旧存在着不少的问题,作者在实验过程中,发现了一些问题:

- 在使用localization quality estimation and classification score时,出现了训练和推理阶段不一致的情况

这个问题的具体表现在:

(1) 如下图所示,localization quality estimation 和 classification score在训练的时候是独立的,但是到了预测阶段通过相乘结合了起来。

(2) 由于在训练阶段,localization quality estimation仅仅分配给正样本,正样本的localization quality estimation(IoU score)可能训练的很好,但是负样本就没有办法控制。如下图所示,绿色的框表示的是背景(负样本),可是输出的IoU score却非常大,使得在推理阶段,虽然其类别置信度比较小,但是IoU score大,导致乘积变大,从而使得一些背景在NMS排序时跑到了前面。

- Inflexible representation of bounding boxes

我们当前广泛使用的bounding box表示其实可以看成关于目标box(Ground Truth)坐标的 δ \delta δ分布,但是我们在标注时,由于物体的边界不是很清楚地表示出来(由于遮挡、阴影以及模糊导致的),没有一个准确的标准说,应该怎样去标注bounding box,导致了我们标注的Ground Truth可能是不可信的。

因此,最近的一些工作,将bounding boxes建模为高斯分布,但是过于简单了,真实分布可以是任意的,同时可以更加灵活。

2. 当前localization quality estimation的研究情况

- Classfication score 独立于localization quality,也就是use a separate branch 来进行localization quality estimation,如Fitness NMS、IoU-Net、MSR-CNN、FCOS以及IoU-aware,这种方式造成的训练和推理不一致的问题,我们在前面已经叙述过了

- assign different weights in classification loss based on their localization qualities,用于平衡类别分数和定位准确率之间的关系,但是并没有改变最佳的损失目标

3. 当前bounding boxes 表示的研究情况

狄拉克 δ \delta δ分布广泛应用,最近也出现了高斯假设,但是作者指出高斯假设的约束过强,不能够反应真实数据的分布,因此作者这里进一步放松假设,仅仅限制label的一个取值范围,使用通用分布来描述回归目标。

1988

1988

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?