Generalized Focal Loss: Learning Qualified and Distributed Bounding Boxes for Dense Object Detection

会议:CVPR 2021

论文:https://arxiv.org/pdf/2006.04388.pdf

代码:https://github.com/implus/GFocal

Abstract

目前的模型大多存在两个问题:

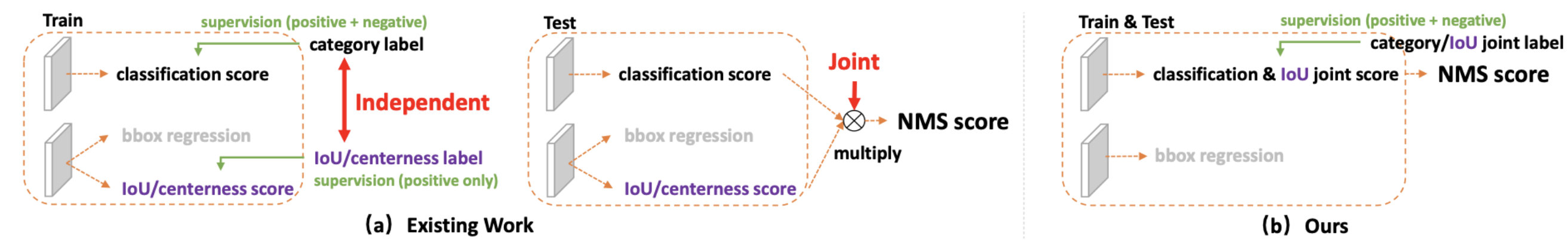

问题一:在训练和推理的过程中,质量评估和分类的方法不一致:

-

他们往往被独立训练,但在推理过程中却被相乘起来联合使用;

-

监督目前只分配给正样本,但有时候负样本可能会提供更高质量的监督,必然会存在一部分分数较低的“负样本”的质量预测是没有在训练过程中有监督信号的,有就是说对于大量可能的负样本,他们的质量预测是一个未定义行为。可能出现的情况就是:一个分类score相对低的真正的负样本,由于预测了一个不可信的极高的质量score,而导致它可能排到一个真正的正样本(分类score不够高且质量score相对低)的前面。

问题二:在复杂的场景中,回归的表示不够灵活,用狄拉克函数(类似于脉冲函数)来进行定位是不准确的:

bbox的坐标可以被视为一个狄拉克分布,但往往没有考虑到模糊边界框,或者被严重遮挡的边界框。虽然最近的一些工作用高斯分布来进行描述,但它过于简单从而不能精确地捕捉到真实的bbox。事实上,这种分布可以更加灵活。

解决一:定位质量评估

保留了分类向量,对于一个类别向量,但是对应类别位置的置信度的物理含义不再是分类的score,而是改为质量预测的score,这样就做到了两者的联合表示,可以端到端的方式进行训练,同时在推理过程中直接使用。

Bounding box 表示

直接学习连续空间上的离散化概率分布来表示盒子位置的任意分布,而不引入任何其他更强的先验。

然而,对于提出的分类IoU联合表示,除了仍然存在的类别不平衡风险外,还面临一个新的问题,即连续IoU标签(0∼1) 作为监督,而原来的FL目前只支持离散的{1,0}类别标签,作者提出了一个Generalized Focal Loss来解决这个问题。又进一步将GFL分解为质量焦损(QFL)和分布焦损(DFL),分别对改进的两种表示进行优化。QFL关注一组比较稀疏的难例,并产生一组连续的0~1的质量评估;DFL使得网络能够在任意灵活分布的情况下,快速地集中学习目标bbox连续位置周围值的概率。

Loss的详细表示

Focal Loss

传统的FL用来解决one-stage检测器前景背景样本不平衡的问题,往往用于训练期间,数学表达式如下:

其中 y y y是前景背景的分类, p p p代表正例类别的估计概率,

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2088

2088

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?