哪些 NVIDIA Jetson 或 DRIVE 模块具有 DLA?

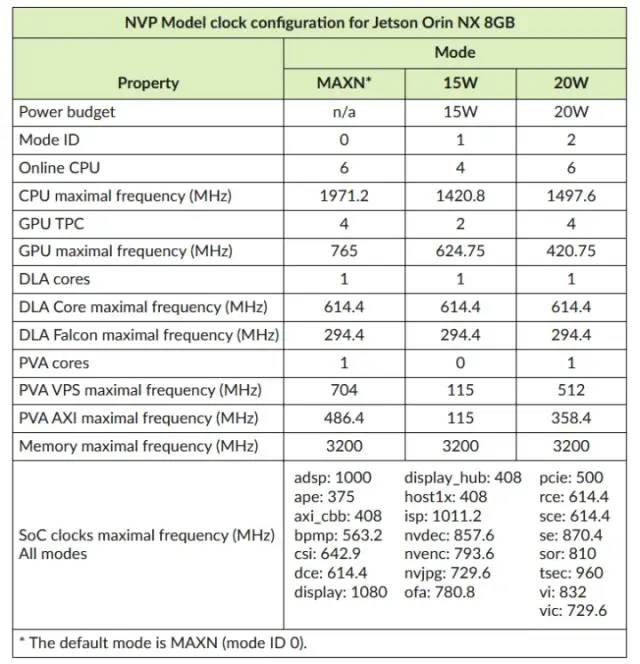

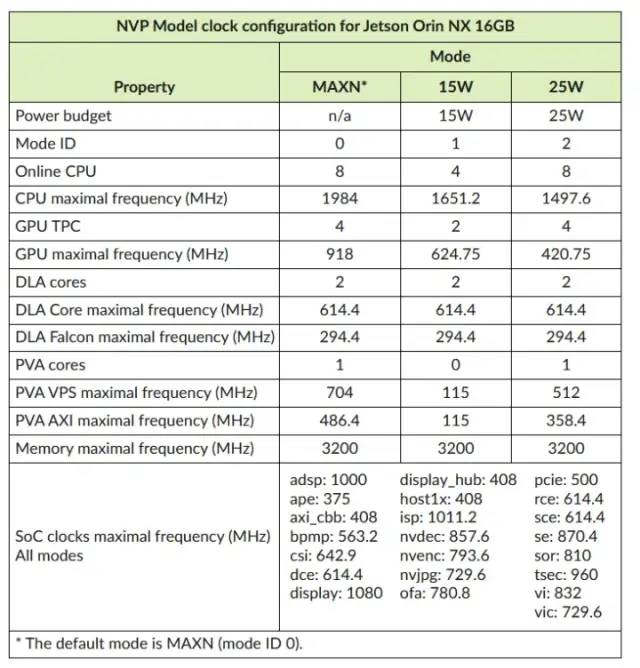

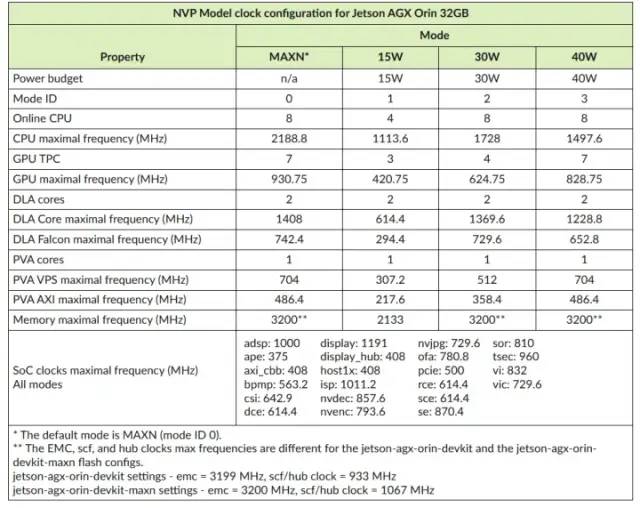

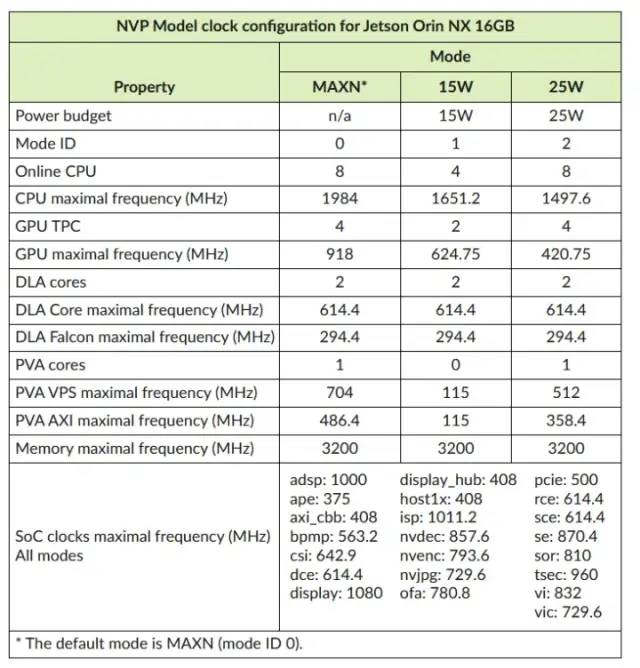

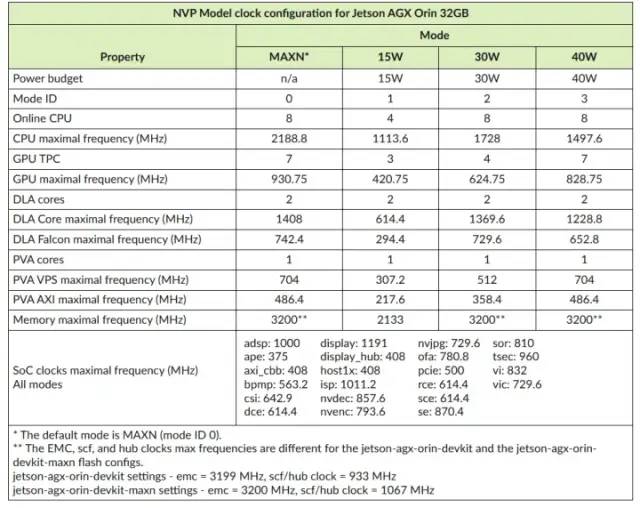

所有 Jetson AGX Orin 和 Orin NX 板以及所有上一代 Jetson AGX Xavier 和 Xavier NX 模块都具有 DLA 内核。对于至少具有一个 DLA 实例及其相应时钟设置的所有平台。

DRIVE Xavier 和 DRIVE Orin 也有 DLA 核心。

所有 Jetson AGX Orin 和 Orin NX 板以及所有上一代 Jetson AGX Xavier 和 Xavier NX 模块都具有 DLA 内核。对于至少具有一个 DLA 实例及其相应时钟设置的所有平台。

DRIVE Xavier 和 DRIVE Orin 也有 DLA 核心。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?