©PaperWeekly 原创 · 作者 | 陈卓群

单位 | 清华大学

基本信息

论文标题:

Search to Capture Long-range Dependency with Stacking GNNs for Graph Classification.

收录会议:

International World Wide Web Conference. (The WebConf) 2023

论文地址:

https://arxiv.org/pdf/2302.08671.pdf

代码链接:

https://github.com/LARS-research/LRGNN

合作机会:

清华大学电子系科研助理、博士后招聘;第四范式实习生招聘(见文末)

引言

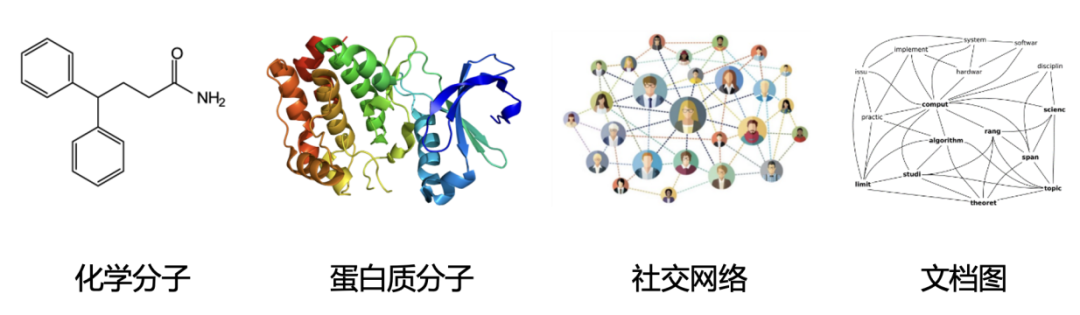

图分类任务有大量的应用场景,比如图 1 中所示的化学/蛋白质分子性质预测,社交网络分析,文档分类等。图神经网络(Graph Neural Network, GNN)已成为目前任务的 SOTA 方案。

▲ 图1:图分类的应用场景示例

捕获远距离节点的信息交互,即长程信息依赖(Long-Range Dependency)对图分类任务的学习至为重要 [1,2]。纵观现有的技术方案,基于堆叠的图神经网络(stacking-based GNN)通过加深模型来扩大节点感受野,进而获取更远端的节点的信息。然而考虑到过平滑(over-smoothing)问题,两至三个聚合操作是常用的配置 [7,8],这限制了模型对于长程信息的获取。

我们在理论和实验上验证了过平滑对图分类任务的影响相比较于节点分类任务更小,并基于堆叠 GNN 提出了一种用于捕获长程信息依赖的自动化图神经网络设计方案 LRGNN(Long-Range Graph Neural Network)。

本文点明了捕获长程信息依赖过程中的两个要素,即足够深的 GNN 模型和自适应的跳跃连接设计(skip-connection scheme)。基于这两个关键点,我们将模型深度和跳跃连接整合为层间连接的方式,基于神经网络结构搜索(Neural Architecture Search,NAS)的方法来设计 GNN。基于此,设计出来的GNN具有自适应的深度和跳跃连接,可以自适应的捕获图中的长程信息依赖。

现有图分类解决方案中,池化操作(pooling operation)可以利用新增的边来加快图上信息传播进而加速长程信息提取,比如 DiffPool [3];整合高阶邻居(higher-order neighbors)信息可以直接获取图中的远距离节点间的交互信息,比如基于 virtual node 的方案 [4],全连接图(fully connected graph)的 [5],和基于 Global-attention 的方案 [6]。

但是这类方案会修改图结构, 造成信息丢失和模型判别能力的下降(参见论文附录A.4)。和此类方案相比,LRGNN 这种基于堆叠 GNN 的方案能够更好的保有图中的结构信息。

本文介绍了LRGNN,一种基于堆叠的图神经网络,旨在解决图分类任务中的长程信息依赖问题。通过神经网络结构搜索,LRGNN自适应地设计深度和跳跃连接,以捕捉图中的长程信息,同时保持结构信息的完整性。实验表明,LRGNN在多个数据集上表现出优越性能,验证了其在捕获长程依赖和避免过平滑问题方面的有效性。

本文介绍了LRGNN,一种基于堆叠的图神经网络,旨在解决图分类任务中的长程信息依赖问题。通过神经网络结构搜索,LRGNN自适应地设计深度和跳跃连接,以捕捉图中的长程信息,同时保持结构信息的完整性。实验表明,LRGNN在多个数据集上表现出优越性能,验证了其在捕获长程依赖和避免过平滑问题方面的有效性。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

897

897

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?