本文来源公众号“码科智能”,仅用于学术分享,侵权删,干货满满。

原文链接:从分割一切到描述一切!从笼统概括到细粒度区域描述!英伟达开源DAM模型:指令控制的字幕生成

问:"师傅,这辆二手车怎么样?我手指的大灯区域和座椅区域有没有问题?"

答:"右前大灯有3cm修复痕迹,座椅调节按钮第三颗镀层脱落..."

如果AI能像上述一样事无巨细地观察世界,会发生什么?之前爆火的SAM模型让我们能"分割一切",但分割后的区域到底意味着什么?进一步地给出该区域的目标类别显然不够,我们还是希望AI能描述该区域的细节内容!

如上所示,点击图中的某个区域,可以给出该区域的详细描述:一把蓝色木椅,高靠背,配有垂直板条。椅座呈矩形,平坦平坦,配有四条结实的椅腿。靠背略微倾斜,以增加舒适度。

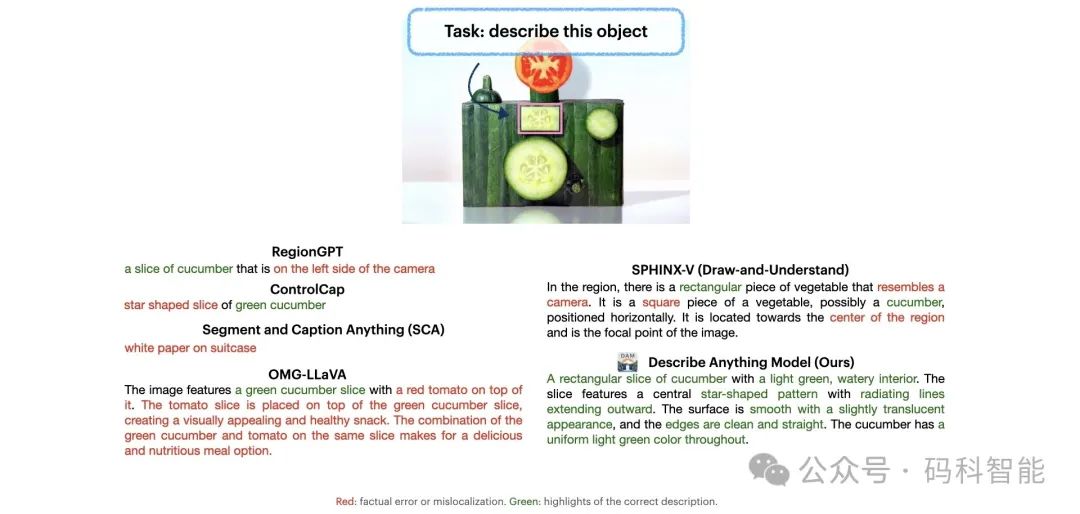

但是不知道你是否试过,让目前的一些图像描述模型来给出上述图像的内容?不出意外,它就像你那个不会拍照的朋友:

✅ 太笼统:仅能生成全局性描述(如“一群人在公园里野餐”),缺乏对细节的捕捉(如“穿红裙子的女孩正在倒柠檬水”);

✅ 瞎指认:无法针对用户指定的特定区域生成定制化描述,你框选小狗,它说"这是棕色沙发";

✅ 不交互:动态交互(如“篮球从传球到扣篮的轨迹”)几乎无法被捕捉;

上面是如何为图像中的特定区域生成详细准确的描述?

最近,英伟达开源了一个可以描述图像或者视频中特定区域任何事物的多模态大语言模型DAM(Describe Anything Model)。用户可以使用点、框、涂鸦或蒙版来指定区域,DAM 将提供这些区域的丰富且符合上下文的描述。

一、描述一切模型效果示例,着重在于局部详细描述

DAM 深入地挖掘用户指定区域的细微细节。其目标不仅是捕捉对象的名称或类别,还包括微妙的属性,如纹理、颜色图案、形状、特点以及任何视觉上独特的特征。来看一下 DAM 的图片描述:一只白色的猫,有着浅橙色的耳朵和粉红色的鼻子。这只猫表情轻松,身上的皮毛柔软洁白。

DAM 图片描述:这座现代化的摩天大楼采用时尚的矩形设计,并配有一系列垂直且间距均匀的窗户。建筑采用阶梯式结构,每个部分都略小于其下方部分,从而营造出层次感。

DAM 视频描述:一头身披深棕色皮毛、臀部有一块浅色斑块的母牛,正以一系列动作展现其姿态。起初,母牛略微低着头,展现出平静的神态。随着画面的推进,母牛开始向前移动,双腿舒展,步态稳健而有节奏。其尾端有簇毛,每走一步都会轻轻摆动,为其动作增添一丝流畅感。

此外,DAM 还可以执行详细的局部视频字幕,描述指定区域随时间的变化。对于局部视频描述,仅指定单个帧上的区域即可。视频描述:一辆造型流畅的银色SUV占据了显著位置,SUV的前部采用大胆的格栅和锐利的前大灯,赋予其动感而自信的外观。随着镜头的推进,SUV稳步向前,车轮在路面上平稳转动。SUV的尾部配备了时尚的尾灯和精致的扰流板,更增添了其运动美感。在整个镜头中,SUV始终保持着恒定的速度,展现出自信而沉稳的驾驶体验,与车流浑然一体。

二、描述一切模型的突破:细粒度、交互式视觉理解!

DAM的核心创新在于Detailed Localized Captioning (DLC),它能根据用户指定的点、框、涂鸦或蒙版,生成高度精细的区域描述。关键能力:

✅ 像素级细节捕捉:通过平衡焦点区域的清晰度和全局上下文,不仅识别物体类别,还能描述纹理、颜色渐变、形状特征等,这远远超出了一般图像级字幕所能提供的范围。

✅ 视频动态跟踪:跨帧分析目标变化(如“红色气球从画面左侧飘向右侧,期间逐渐膨胀”)

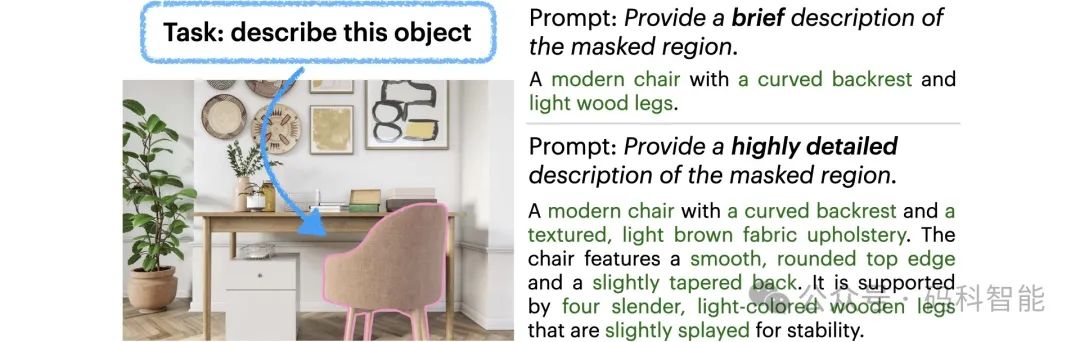

✅ 指令控制的描述:用户可以引导我们的模型生成不同细节和风格的描述。无论是简短的摘要,还是冗长复杂的叙述,模型都能调整输出。

✅ 零样本的区域保证:模型无需额外的训练数据即可回答有关特定区域的问题。用户可以询问该区域的属性,模型会利用其对本地区域的理解,提供准确的、基于情境的答案。

再回顾一下,本文介绍的“描述任何内容”模型 (DAM) 能够为图像和视频中的特定区域生成详细的描述,可用于各种应用,从数据标注到作为下游任务的中间组件。

通用视觉模型的进化速度太快了,每一个面向开放世界的模型都给我们带来了很大的想象空间!目前英伟达已公开发布代码、模型、数据和基准,HuggingFace已上线交互Demo。更多的细节请查看论文及代码,如下:

# 论文链接

https://arxiv.org/abs/2504.16072

# 代码链接

https://describe-anything.github.io/THE END !

文章结束,感谢阅读。您的点赞,收藏,评论是我继续更新的动力。大家有推荐的公众号可以评论区留言,共同学习,一起进步。

5410

5410

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?