两条主线,一共有6种方法。

策略梯度和Q两种

lecture6:Policy OptimizatiobⅡ(策略优化)

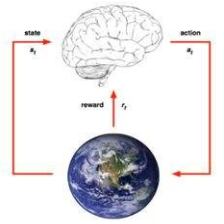

这两堂课内容都是基于策略梯度,基于值函数的是选择最大的Q。基于策略的会给出每个动作的概率,然后采样就可以得到。

一、策略梯度方法

策略的目标是,从策略得到的奖励尽可能大。

天然的baseline—V

然后为了减小方差,引入baseline,天然的baseline—>V。

(1)、对于TD方法:

得到advantage Actor-Critic,这里需要两组参数。

这里可以用TD error来重写advantage function。

这样只需要估计一组参数(V的参数)就可以,可以使训练更加稳定。

(2)、更新V

对于线性方法来说

Ψ 当前状态的特征向量,如同《强化学习导论》中所说的线性方法,去进行更新。

策略函数

对于策略函数,也是根据选取的不同方法计算梯度。

下面分别是这四种的名称

二、 策略优化方法

1、Natural policy gradient

(1)、训练过程不稳定,在监督学习中,样本之间是iid的。但是在RL中是有相关性的,因此如果样本之中有噪声的化,后面的训练也不好。会得到差得策略,然后再交互,就会生成差得样本。。。

解决:

引入信赖域与Natural policy gradient

首先是关于Natural policy gradient(二阶优化方法,一阶的就是SGD)

之前对于参数优化使用梯度的方法,是在参数空间中找的方向

但是d对于模型(策略函数怎么参数化的形式,比如策略用高斯拟合或者softmax拟合)采取什么样的函数是很敏感的(这里是说受模型本身影响大(曲率)),更新d并没有考虑对更新后模型的输出(动作的概率)的影响。

我们想要从最终输出的角度取更新参数。

这里采取KL散度,来衡量两个策略分布之间的近似。

这样就可以在两个实际输出策略相近的情况下更新参数,而不至于对于不同模型来说训练不稳定。

KL散度理解中描述了什么是KL散度,以及KL

散度的意义。

KL散度不能来描述度量,因为他是不满足三角不等式的,同是也是非对称的。

但当d取足够小的时候,可以近似距离的度量。

对他做泰勒展开,一阶导数等于零,二阶导数如下

F是KL散度的二阶导数

入门神经网络优化算法(五):一文看懂二阶优化算法Natural Gradient Descent(Fisher Information)

中关于这部分内容有比较详细的解释。

然后将这个带约束优化问题,利用拉格朗日乘子法进行求解。

具体步骤是首先写成拉格朗日乘子法的形式,然后对每一项进行泰勒展开。然后就是执行拉格朗日乘子法的最有一步,对d求导。

得到 :

由F求逆在乘以原来的策略梯度。

这样利用这样更新后的梯度再进行更新。

其中F前面提到是KL散度的二阶倒数,这里其实可以直接通过score function求出。

这里的E是指求average的意思。

他的几何意义就是在测量模型的曲率,因此除以F就可以把模型的曲率去掉,遮掩就可以与模型没有关系了。即采取怎么样的策略优化形式与怎么有优化独立开。

进一步理解的链接:

2、基于重要度采样的离线策略TRPO

优化的策略和采集数据的策略是一个策略,因此simple effciency非常低。

解决:

使用基于重要度采样的离线策略TRPO

重要度采样:如果要估计一个从分布p采样的样本的期望。但是不知道p分布,只知道一些已知的分布,比如高斯分布。那么我们可以利用 已知的分布去估计

这样J中关于目标策略pi的奖励的期望们就可以转换从行为策略采样的获得。

所以就可以把客观函数变成基于重要度采样的函数:

这样的话就可以用之前采样的数据进行优化了,也就是说可以不用真正的在线运行(因此这里用old)

但是也会有一个问题,就是如果第二个pi很小,会导致比例很大,因此这里引入一个限制。

因此为了使两个策略之间尽可能相近,又可以用上一节用到的KL散度。

这里就引入了TRPO

带约束的优化

这个限制就相当于一个球,这里称之为信赖域。

对两者都进行泰勒展开

这里的H,就是之前的F

我们看到这里更新的更新的公式中,并alpha,这里关于这个的是变量delta。就相当与在圆中。

TRPO是在自然梯度优化的基础上的。

这里为了避免求逆(复杂度高),因此使用以下技巧

为了求x,也就是要求这样遗憾函数的极致,进而导数等于0可以得到等式。

在得到这样的一个无约束优化函数以后,可以调用共轭梯度法求解。

完整算法

论文中证明了J在更新中确实是增加的。

MM算法

希望找到原函数的最大化,但是原函数没办法求最大化,因此我们可以求解另一个函数的,得到交点以后,再更新另一个函数,最终,两者的最大化的点就是一个点。

EM算法是MM算法的一个特例。

TRPO的计算量也是比较大的,H本身计算度大;在近似中也需要很多样本;共轭梯度法也是需要比较大的计算量。

作业:

2145

2145

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?