文章目录

前言

先说总体流程:

1.在x86主机上安装【rknn-toolkit2】

2.使用【rknn-toolkit2】,把onnx模型转换成rknn格式的模型。

3.在板子部署【rknpu2】,在编程时,调用其提供的接口即可。

1.安装rknn-toolkit2

最好先按照这里【ubuntu安装Miniconda】装个miniconda,注意要选择合适的版本。

conda的好处是可以创建独立的环境,防止环境之间污染。

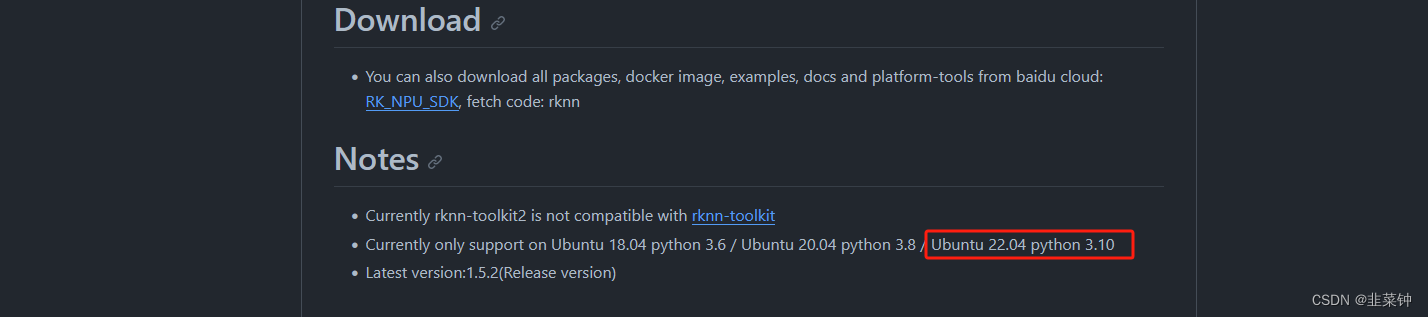

创建虚拟环境之前,我们先看看rknn-toolkit2对环境的要求是啥。

在rknn-toolkit2的官网看到,在Ubuntu 22.04系统下,使用的是python 3.10,理论上我们需要创建一个这样的环境。

1.1 .创建一个名为rknn-toolkit2的虚拟环境

# conda create -n rknn-toolkit2 python=3.10

# conda create -n rknn-toolkit2 python=3.8

conda create -n rknn-toolkit2 python=3.6

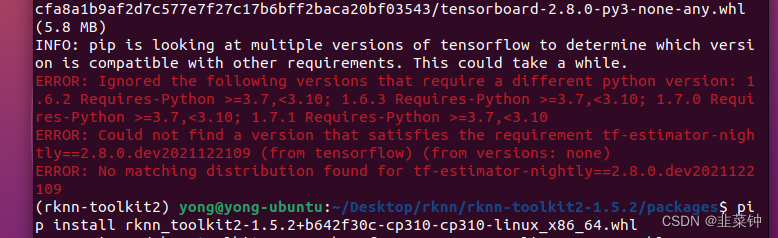

经过实际测试,不能使用3.10、3.8的python,否则在安装到最后时会报类似下面的错误:

ERROR: Ignored the following versions that require a different python version: 1.6.2 Reguires-Python >=3.7,<3.10: 1.6.3 ReguiresPython 2=3,7 ,<3,10: 1.7.0 Reguires-Python >=3.7,<3.10; 1.7.1 Requires-Python >=3.7,<3.10ERROR: Could not find a version that satisfies the reguirement tf-estimator-nightly==2.8.0.dev2021122109 (from tensorflow) (from versions: none)ERROR: No matching distribution found for tf-estimator-nightly==2.8.0.dev2021122109

关于这个错误,评论区有同学指出,可以使用默认源( 也就是添加【-i https://pypi.org/simple/】后缀,

或者直接不添加任何后缀),即可解决此报错问题。各位可以试试

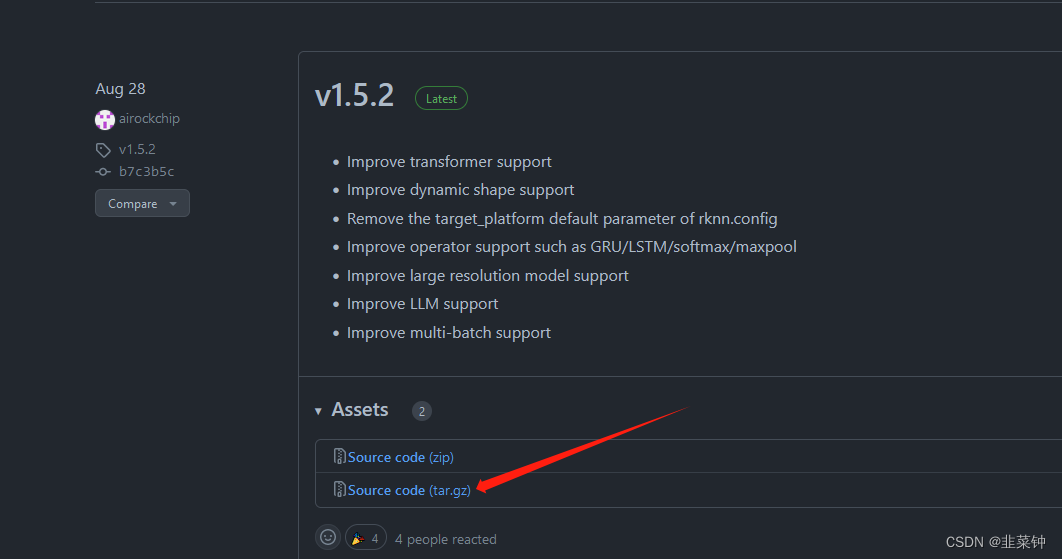

1.2.下载【rknn-toolkit2】

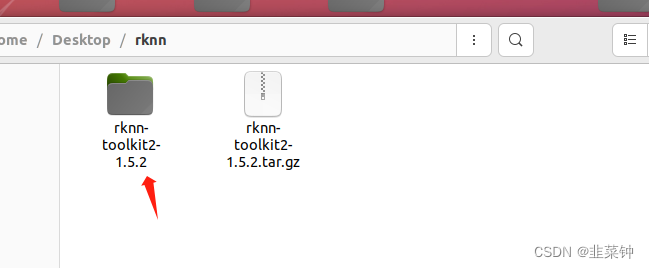

将下载得到的文件放到一个文件夹下,解压

将下载得到的文件放到一个文件夹下,解压

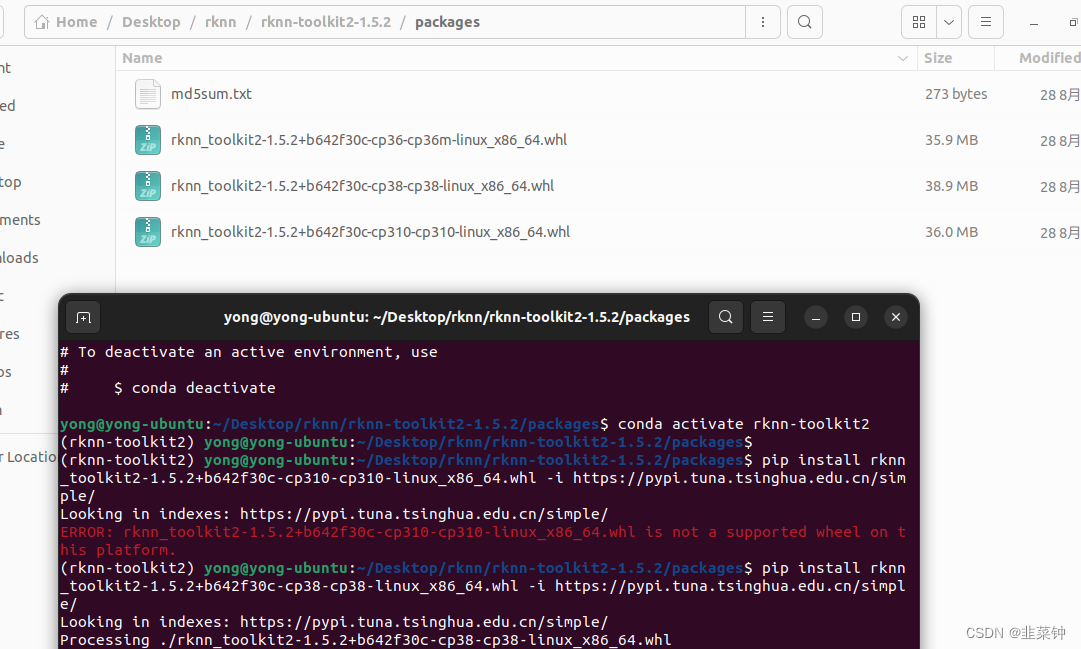

1.3.在此文件夹下打开控制台,激活使用前面创建的conda环境,执行install

conda activate rknn-toolkit2

从packages文件夹中选择合适的文件进行install,我这里是python 3.6的,所以我选择了rknn_toolkit2-1.5.2+b642f30c-cp36-cp36m-linux_x86_64.whl (下面命令中的 -i https://pypi.tuna.tsinghua.edu.cn/simple,是指定源,速度快很多)

cd rknn-toolkit2-1.5.2/packages

pip install rknn_toolkit2-1.5.2+b642f30c-cp36-cp36m-linux_x86_64.whl -i https://pypi.tuna.tsinghua.edu.cn/simple

安装时,会自动下载tensorflow、torch等组件,会占用较大空间,最好要先预留2G以上的空间。

安装起来慢的话,可以分别试试这几个源:

清华大学 https://pypi.tuna.tsinghua.edu.cn/simple/

阿里云 http://mirrors.aliyun.com/pypi/simple/

中国科技大学 https://pypi.mirrors.ustc.edu.cn/simple/

豆瓣(douban) http://pypi.douban.com/simple/

中国科学技术大学 http://pypi.mirrors.ustc.edu.cn/simple/

1.4.验证安装

安装完成之后,执行一下下面的命令,检验是否已经安装好了。假如没报错的话,就是已经成功安装了。

python

from rknn.api import RKNN

2.将onnx模型转为rknn模型

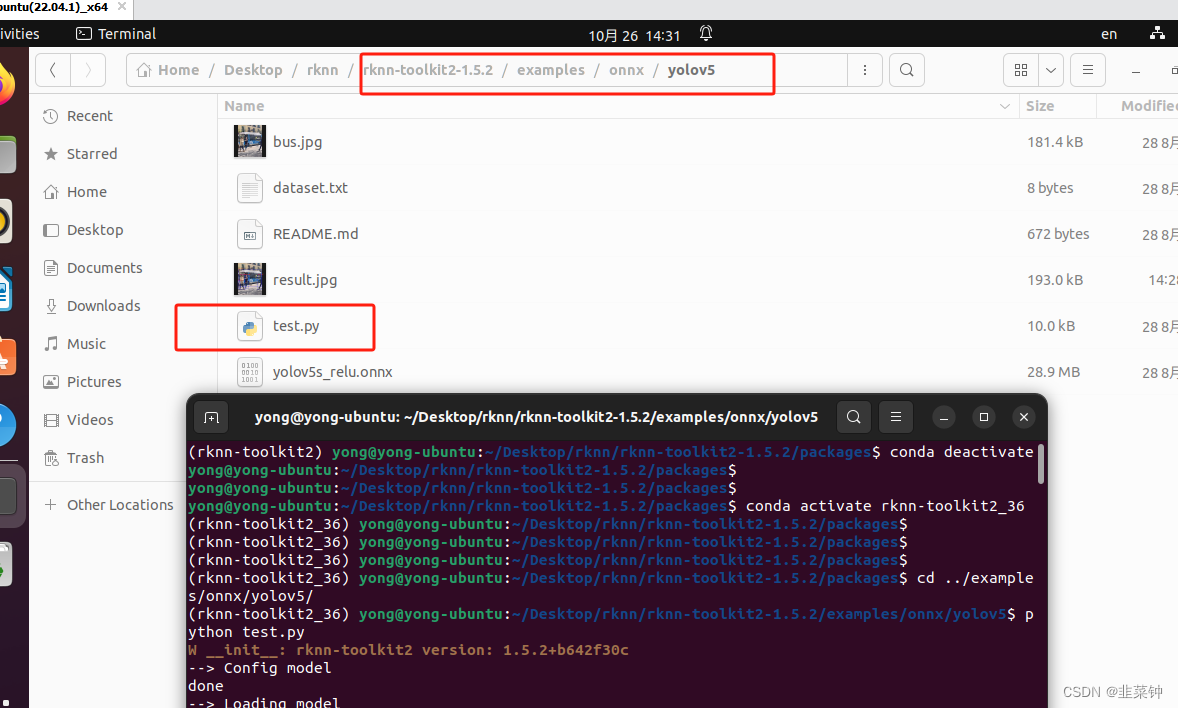

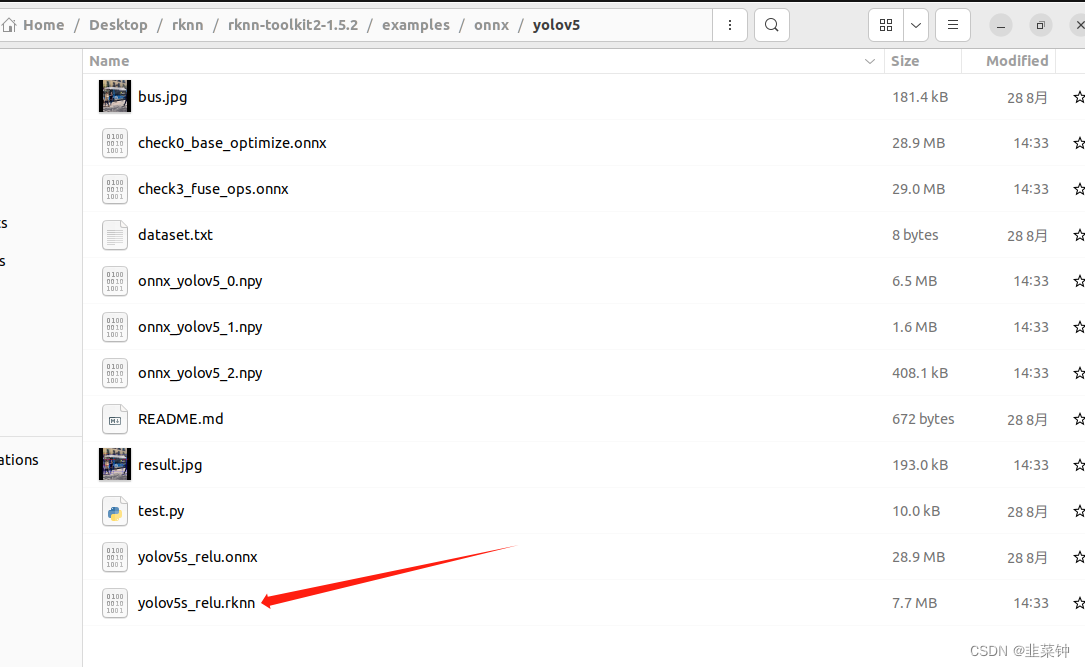

可以先跑一下自带的例程。在 rknn-toolkit2-1.5.2/examples/onnx/yolov5下面。 假如能够顺利跑完,那应该会生成一个yolov5s_relu.rknn。

假如能够顺利跑完,那应该会生成一个yolov5s_relu.rknn。

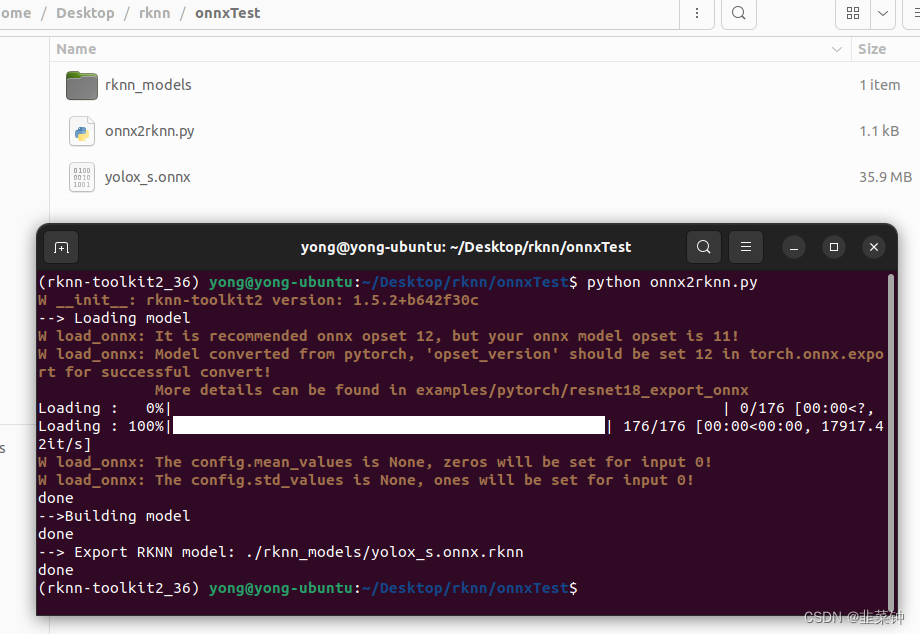

假如我们想转换自己的onnx模型,可以直接利用下面这个代码(代码来源):

假如我们想转换自己的onnx模型,可以直接利用下面这个代码(代码来源):

from rknn.api import RKNN

import os

if __name__ == '__main__':

platform = 'rk3588'

onnxModel = 'yolox_s.onnx'

'''step 1: create RKNN object'''

rknn = RKNN()

'''step 2: load the .onnx model'''

rknn.config(target_platform=platform, optimization_level = 2)

print('--> Loading model')

ret = rknn.load_onnx(onnxModel)

if ret != 0:

print('load model failed')

exit(ret)

print('done')

'''step 3: building model'''

print('-->Building model')

ret = rknn.build(do_quantization=False)

if ret != 0:

print('build model failed')

exit()

print('done')

'''step 4: export and save the .rknn model'''

OUT_DIR = 'rknn_models'

RKNN_MODEL_PATH = './{}/{}.rknn'.format(OUT_DIR, onnxModel)

if not os.path.exists(OUT_DIR):

os.mkdir(OUT_DIR)

print('--> Export RKNN model: {}'.format(RKNN_MODEL_PATH))

ret = rknn.export_rknn(RKNN_MODEL_PATH)

if ret != 0:

print('Export rknn model failed.')

exit(ret)

print('done')

'''step 5: release the model'''

rknn.release()

把模型放到与该脚本同一个文件夹下,修改好脚本中的 platform = ‘rk3588’ 、onnxModel = 'yolox_s.onnx’为你实际的需求。然后执行,就可以得到onnx模型对应的rcnn模型了。

3.通过rknpu2加载rknn模型执行推理

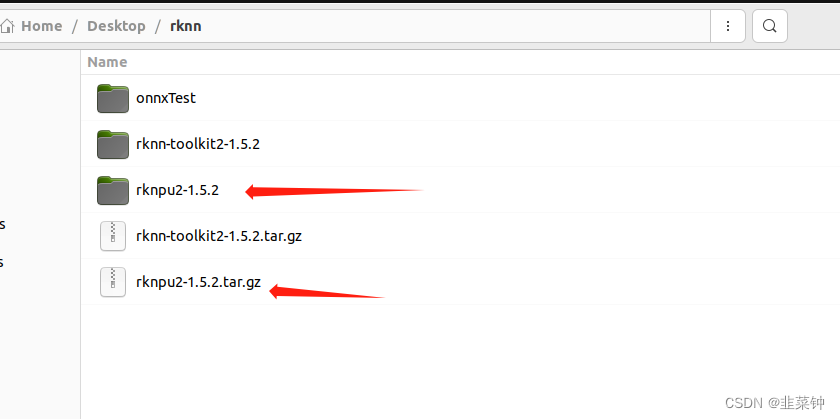

把下载的rknpu2-1.5.2.tar.gz,进行解压,得到rknpu2-1.5.2文件夹

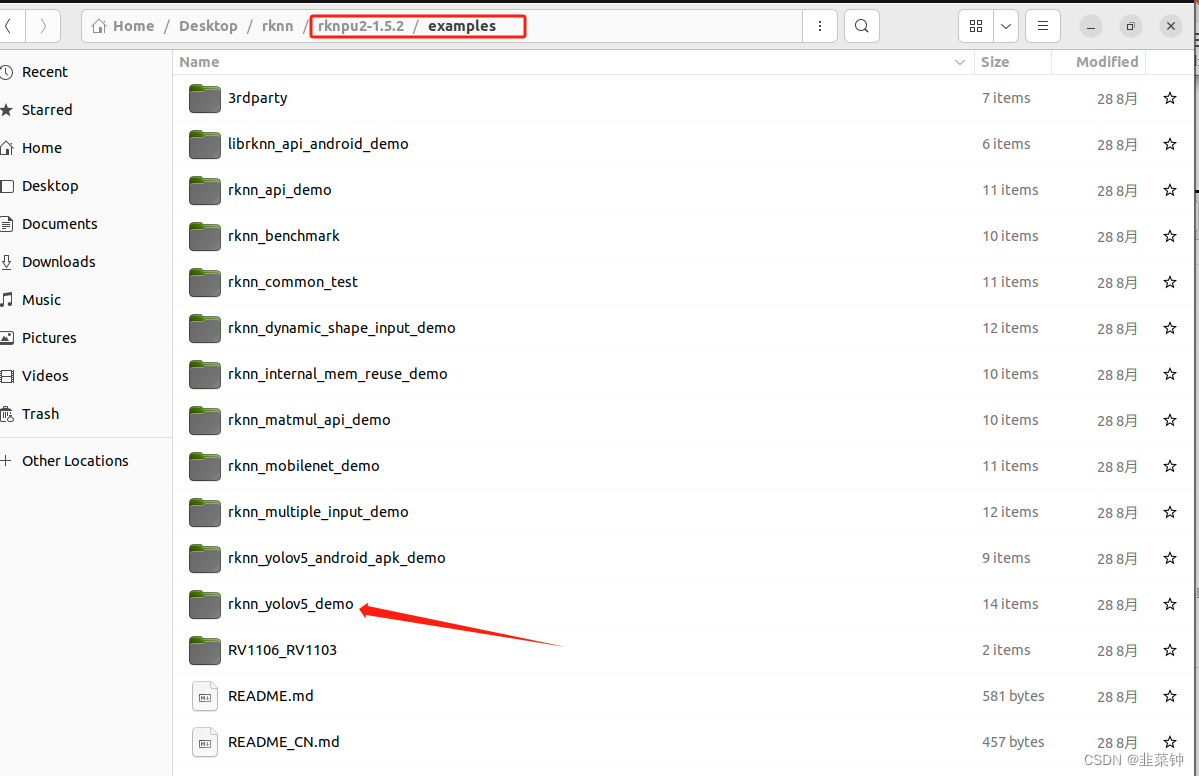

在这个文件夹内,可以找到例子。参考例程代码,编写我们自己的代码即可。

需要注意的是,要用下载的rknpu2里面的librknnrt.so、librknn_api.so、rknn_server等文件,替换板子文件夹/usr里面原来的。复制完之后最好重启一下板子。

需要注意的是,要用下载的rknpu2里面的librknnrt.so、librknn_api.so、rknn_server等文件,替换板子文件夹/usr里面原来的。复制完之后最好重启一下板子。

sudo cp ./runtime/RK3588/Linux/librknn_api/aarch64/* /usr/lib

sudo cp ./runtime/RK3588/Linux/rknn_server/aarch64/usr/bin/* /usr/bin/

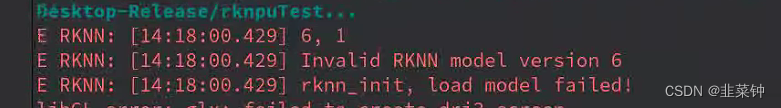

否则会在加载模型时失败,并且报下面的错误:

Invalid RKNN model version 6

1609

1609

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?