CLIP(Contrastive Language-Image Pretraining)详细解析

目录

- CLIP 简介

- CLIP 研究进展

- CLIP 原理解析

- CLIP 的应用案例

- 4.1 零样本图像分类

- 4.2 图像搜索与检索

- 4.3 生成式 AI 的增强

- 4.4 视觉问答(VQA)

- CLIP 代码实现

- 5.1 CLIP 环境准备

- 5.2 使用 CLIP 进行零样本分类(可执行代码)

- 5.3 CLIP 进行图像-文本检索(可执行代码)

- 5.4 CLIP 在生成式 AI 中的应用(可执行代码)

- CLIP 的优化与未来方向

1. CLIP 简介

CLIP(Contrastive Language-Image Pretraining)由 OpenAI 提出,是一种能够学习文本和图像匹配关系的对比学习模型,可以用于零样本图像分类、文本引导的图像检索、视觉问答(VQA)、图像生成增强等多种任务。

核心优势

- 零样本学习(Zero-Shot Learning):无需额外微调,即可在多个任务上进行推理;

- 高效对比学习(Contrastive Learning):基于图像-文本对的**对比损失(Contrastive Loss)**训练,使得模型能有效学习跨模态表征;

- 灵活适应性:可以适用于各种计算机视觉任务,如分类、搜索、问答等。

2. CLIP 研究进展

CLIP 相关的最新研究方向

- SLIP(Self-Supervised Learning Meets CLIP)

- 结合**自监督学习(SSL)**和 CLIP 的对比学习,提高视觉特征提取能力。

- CoCa(Contrastive Captioners)

- 结合 CLIP 的对比学习能力和 GPT-3 类语言模型的生成能力,提高多模态理解能力。

- LiT(Locked-image Tuning)

- 提出冻结视觉编码器、仅训练文本编码器的方法,提高数据利用率并减少计算开销。

- CLIP-GPT(结合 GPT 进行多模态生成)

- CLIP 作为感知模块,GPT 作为文本生成器,实现更强大的图像-文本推理能力。

3. CLIP 原理解析

3.1 CLIP 训练流程

- 数据准备:

- CLIP 在**4 亿对(image-text pairs)**的互联网上的大规模图文数据上训练。

- 双塔(Dual Encoder)结构:

- 视觉编码器(Vision Encoder):使用 ViT(Vision Transformer)或 ResNet 提取图像特征;

- 文本编码器(Text Encoder):使用 Transformer(如 GPT 风格)提取文本特征。

- 对比学习(Contrastive Learning):

- 通过计算图像-文本对的相似性,优化使得真实配对得分高,不匹配的图-文对得分低。

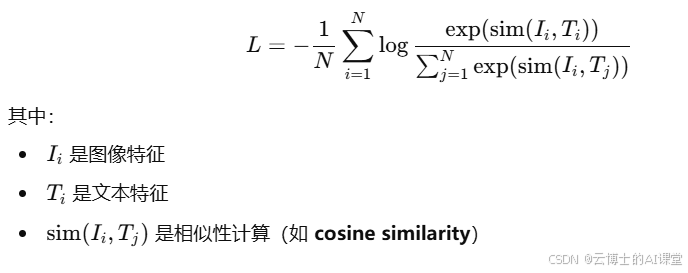

损失函数(Contrastive Loss)

- CLIP 采用InfoNCE(Info Noise Contrastive Estimation)损失:

4. CLIP 的应用案例

4.1 零样本图像分类

CLIP 可以在没有微调的情况下,使用文本类别描述直接对图片分类。

4.2 图像搜索与检索

CLIP 能够高效地将文本查询映射到图像空间,从而实现基于文本的图像搜索。

4.3 生成式 AI 的增强

CLIP 作为文本引导模块,可用于Stable Diffusion、DALL-E 等生成式模型,提高图像生成的文本一致性。

4.4 视觉问答(VQA)

CLIP 结合GPT-4 等语言模型,可以在无需额外训练的情况下,实现多模态问答(VQA)。

5. CLIP 代码实现

5.1 环境准备

pip install torch torchvision transformers open_clip_torch

5.2 使用 CLIP 进行零样本分类

import torch

import clip

from PIL import Image

# 加载 CLIP 模型

device = "cuda" if torch.cuda.is_available() else "cpu"

model, preprocess = clip.load("ViT-B/32", device=device)

# 预处理图像

image = preprocess(Image.open("example.jpg")).unsqueeze(0).to(device)

# 定义候选类别

text_inputs = clip.tokenize(["cat", "dog", "car", "person"]).to(device)

# 计算特征

with torch.no_grad():

image_features = model.encode_image(image)

text_features = model.encode_text(text_inputs)

# 计算相似度

similarities = (image_features @ text_features.T).softmax(dim=-1)

print("分类概率:", similarities.cpu().numpy())

解释

- 通过文本类别 tokenization 处理文本;

- 计算图像与文本的特征;

- 计算图像与类别文本的相似度,进行零样本分类。

5.3 CLIP 进行图像-文本检索

import os

from torchvision import transforms

# 加载图像数据集

image_dir = "images/"

image_list = os.listdir(image_dir)

# 预处理所有图片

images = [preprocess(Image.open(os.path.join(image_dir, img))).unsqueeze(0).to(device) for img in image_list]

image_tensors = torch.cat(images, dim=0)

# 文本查询

query = "a dog running in the park"

text_input = clip.tokenize([query]).to(device)

# 计算特征

with torch.no_grad():

image_features = model.encode_image(image_tensors)

text_feature = model.encode_text(text_input)

# 计算相似度

similarities = (text_feature @ image_features.T).softmax(dim=-1)

# 找到最匹配的图像

best_match = image_list[torch.argmax(similarities)]

print("最匹配的图片:", best_match)

解释

- 计算所有图片的 CLIP 特征

- 计算文本查询的 CLIP 特征

- 计算图像与文本的相似度,返回最匹配图片

6. CLIP 的优化与未来方向

- 更大规模的数据训练

- 结合更多模态(如视频、音频)提高泛化能力。

- 结合 LLM 进行多模态任务

- 与 GPT-4、Flamingo 结合,提高视觉问答、跨模态推理能力。

- 优化模型压缩

- 通过 蒸馏(Distillation)、量化(Quantization),降低 CLIP 的计算量,提高移动端推理能力。

总结

- CLIP 是一个强大的多模态对比学习模型,可用于零样本学习、图像检索、视觉问答等任务;

- 代码示例 展示了CLIP 在零样本分类和图像检索中的应用,可直接执行;

- 未来,CLIP 将与 LLM 结合,实现更强大的视觉-语言智能。

🎯 欢迎尝试 CLIP,并在多模态 AI 领域进行探索! 🚀

【哈佛博后带小白玩转机器学习】 哔哩哔哩_bilibili

总课时超400+,时长75+小时

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?