本文内容来自:Michael Nielsen的《Neural Networks and Deep Learning》中文翻译

学习缓慢问题

产生原因

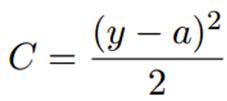

我们之前用的代价函数都是二次代价函数:

a是神经元的输出,假设训练输入x=1,输出y=0,求权重和偏置的偏导数有:

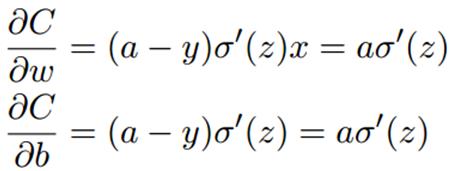

偏导数受激活函数的变化率的影响,假设我们激活函数为sigmoid函数,我们看一下函数图像:

当神经元的输出接近1的时候,曲线非常平缓,求导的值(变化率)会很小,上边式子所求的权重和偏置也会很小,学习速度就会很缓慢(也称作神经元饱和了)。

更换代价函数

为了改进这个问题,引入交叉熵代价函数:

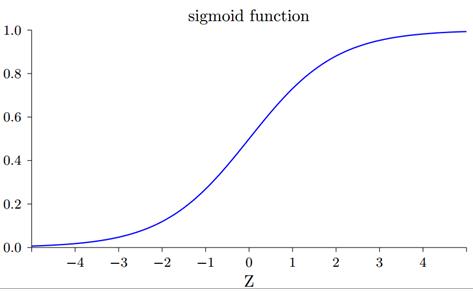

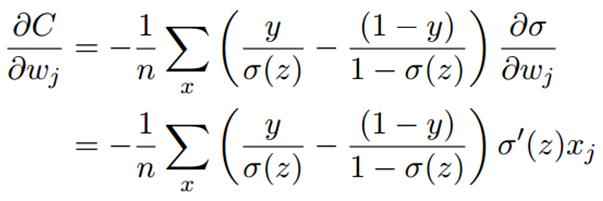

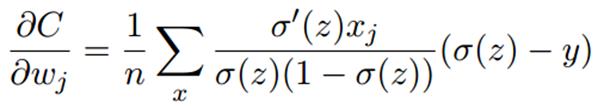

其中n是训练数据总数。这和使用最大似然来训练是等价的,而最大似然的代价函数是负的对数似然,这和交叉熵代价函数等价。交叉熵能作为代价函数有两个原因,第一,交叉熵是非负的;第二,如果神经元的实际输出接近目标值,那么交叉熵接近0。相比于二次代价函数,还避免了学习速度下降的问题,原因如下,先求偏导:

化简:

其中分母就是sigmoid函数求导之后的形式,约去,化简得

本文探讨了神经网络在学习缓慢、过拟合和梯度消失等问题上的解决方案。针对学习缓慢,介绍了更换代价函数如交叉熵和使用softmax方法;对于过拟合,提出了规范化(L1、L2)和dropout策略;为了解决梯度消失问题,推荐使用ReLU激活函数。这些方法有助于提升深度学习模型的性能和泛化能力。

本文探讨了神经网络在学习缓慢、过拟合和梯度消失等问题上的解决方案。针对学习缓慢,介绍了更换代价函数如交叉熵和使用softmax方法;对于过拟合,提出了规范化(L1、L2)和dropout策略;为了解决梯度消失问题,推荐使用ReLU激活函数。这些方法有助于提升深度学习模型的性能和泛化能力。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5942

5942

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?