众所周知,在传统机器人中,常用的地图是「占据栅格地图」。

整个地图全是马赛克画质的小方格,每个格子只会用0和1告诉你“这里有东西”或者“这里没东西”。(本质上是个二进制空间切割器)

倘若只是用来“避障”,自然是够用了。可是如果用在类似于扫地机器人上,那可就“造孽了”。

比如半夜把家猫当成移动障碍物怼来怼去,或者完美绕开所有垃圾,这也就是这种原始地图在实际应用中的“局限性”。

就像是只看到了环境的“骨架”。

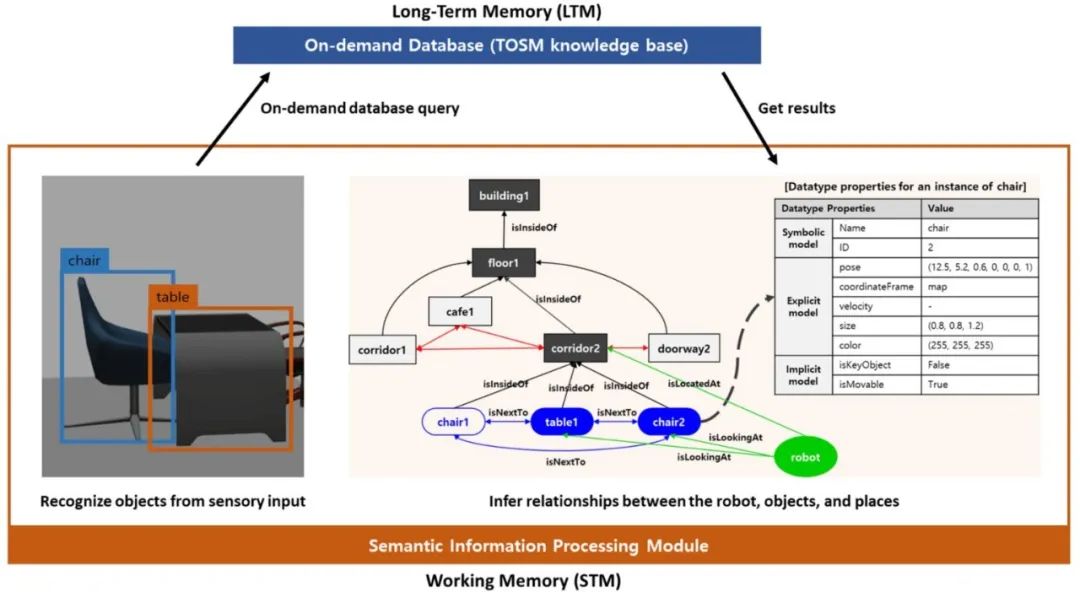

而「语义地图」则更进一步,它不仅知道哪里有东西,还能识别出这些东西是什么。(刻画详尽的知识图谱,多层信息嵌套)

不仅能看清椅子腿和承重墙的区别,还能当场报菜名:这是老板的保时捷车钥匙,那是岳丈最爱的钓鱼杆,前方三米是刚拖过的地板。

如果能完全且高效的实现这一愿景,那么无异于活生生把黑白默片升级成IMAX杜比全景声,堪称机器人界的降维打击。

就像是给环境加上了详细的“标签”。

**而这种从"几何空间"**到"语义空间"的认知跃迁,毫不夸张的说,正在重塑以具身智能为代表的智能系统的进化路径。

接下来,我们将着重介绍语义地图是如何赋能具身智能系统感知、控制、规划等各个模块的。

**01 感知层:**从盲人摸象到开通天眼

传统方法在面对动态环境时,常常会被环境中的运动物体干扰。

比如,动态SLAM的经典难题:

在一个SLAM场景中,当有物体在环境中移动时,位于动态物体上的特征点由于运动的关系很容易出现误匹配,从而影响了地图的全局一致性,最终干扰具身智能系统对环境的建图,导致地图的漂移,或者建立的地图中出现运动物体的伪影。

传统方法为了应对这个问题,会尝试把动态物体从感知中“过滤”掉,只留下静态的物体。

例如当前最先进的动态环境感知框架Gassidy[1]。

也就是实时检测并剔除动态物体(如行人、移动车辆)的特征点,仅保留静态环境的结构信息。

▲图1|Gssidy感知框架

在Gassidy[1]中,作者利用高斯覆盖了场景中的物体,并通过动态物体变化会引起高斯变化的特性,通过实例分割的形式来区分动静态物体,从而在感知环境时实现对于动态物体的分割和剔除,最终实现了对于环境的静态全局一致性感知。

这种方法虽然能提升建图稳定性,但却付出了巨大代价:

-

一是会丢失一些有用的环境信息,毕竟那些被“过滤”的物体也是环境的一部分;

-

二是处理动态物体需要耗费不少计算资源,如Gassidy中对于动态物体的滤除这一过程就消耗了大量的资源,最终导致算法没有体现出非常出色的实时性,场景相对僵化;

-

三是运动物体残留的「轨迹伪影」仍会影响闭环检测。

而语义地图的出现,为解决这一难题提供了新思路。

语义地图通过引入层次化环境理解,构建了全新的动态处理范式。根据语义来区分动态和静态物体,并且在感知过程中巧妙地处理它们之间的关系。

这样一来,具身智能系统既能保留完整的环境信息,又不会被动态物体干扰,感知结果更加准确和稳定,就像是在嘈杂的环境中依然能听清重要信息一样,让具身智能系统在动态环境中也能游刃有余地进行感知和建图[2]。

比如,典型案例Bilitz-SLAM[3]:

▲图2|Bilitz-SLAM处理动态语义流程

我们可以通过下面这个例子进行理解:

当具身智能系统完成对下图环境的感知之后,由于建立了语义地图,因此每个物体都是有语义的。

比如画面中穿着格子衬衫的人,而人作为一个常见的动态物体,具备动态语义,因此具身智能系统在后续的处理过程中,会将含有动态语义的人进行剔除(可以看到红色轮廓的人身上已经没有特征点了),从而一步到位解决了动态物体的干扰。

而对应的实验显示,MIT的HydraMap系统[2]中动态物体追踪精度比Gassidy提升63%,地图更新延迟降低至200ms以内。

像在工业场景中的机械臂识别出传送带上的原料批次标签,实现柔性化生产切换,其核心正是在于将物理环境中的对象信息转化为可理解的语义知识,并动态调整生产策略的结果。

▲图3|通过语义实现动态物体提出

普通机器人看世界就像高度近视没戴眼镜,看见个轮廓稀里糊涂的摸索着。

有了语义地图,直接开启天眼模式——知道厨房台面不是障碍物而是工作区,知道老板掉落的保时捷钥匙必须重点标记……

因此,在感知模块,语义地图它使具身智能系统能够精准识别和理解环境中的物体及场景,有效应对动态环境中的干扰,避免了传统方法因动态物体导致的感知误差和信息丢失问题。

**02 规划层:**从效率陷阱到价值优化

传统路径规划方法通常依赖于简单的几何地图,这些地图只能提供障碍物的位置信息,无法识别障碍物的具体类型和功能。

这其中,还暗藏着一个十分危险的“效率陷阱” 。

像经典路径规划算法(如A*、RRT)专注于寻找几何空间中的最短路径,却忽视了环境语义带来的隐性成本。诸如在医院的消毒机器人场景中,最短路径可能需要穿越无菌病房区域,但这却会引发严重的交叉感染风险。

再例如,在一个复杂的室内环境中,传统方法可能只能识别出墙壁和家具的位置,但无法区分不同类型的家具,这限制了机器人在复杂任务中的灵活性和适应性[4]。

▲图4|基于语义地图的路径规划示例

而语义地图通过引入物体的语义信息,如物体的类别、功能和属性,使机器人能够更细致地理解环境。

例如上方图4所示,机器人不仅知道前方有障碍物,还能识别出这是一个沙发、一个桌子还是一个垃圾桶。这种详细的环境理解使得机器人在规划路径时能够做出更合理的决策,比如选择绕过沙发而不是桌子,因为沙发可能更容易移动,桌子更有可能在下部存在空间,能够直接穿行。

当前已经有研究,采用语义地图为机器人在动态环境中进行有效的运动规划[5]。

如下方图5所示,在动态环境中,物体的位置和状态可能会不断变化。

传统方法在处理动态物体时往往会出现误差,导致路径规划不准确。而语义地图可以通过实时更新语义信息,及时反映环境的变化,使机器人能够动态调整路径,避免碰撞和延误。

▲图5|OPENNI语义地图运动规划框架

从而,在规划模块,语义地图则凭借丰富的语义信息,助力具身智能系统制定更精准、高效的路径规划,使其在复杂环境中灵活调整策略,克服传统方法在动态环境下的局限。

**03 控制层:**从条件反射到预期推理

传统控制系统的局限性:

传统控制策略建立在几何避障的底层逻辑上,例如当AGV(自动导引车)检测到前方障碍物时,会触发预设的减速或绕行程序。这种「刺激-响应」模式在复杂场景中面临多重挑战:

-

无法区分障碍物类型——如固定桌椅vs临时放置的快递箱;

-

对物体状态变化反应滞后——如正在关闭的电梯门;

-

统一功率输出导致能源浪费——如在不同地面材质上驱动力不变。

语义控制,实现智能跃迁:

如果说传统控制逻辑是"感知-动作"的直线反射,那么语义地图则构建了"感知-理解-决策-动作"的闭环。核心解决了如:

-

**结合物体语义属性——**则能够判断易碎品/刚性体;

-

**主动预测人类意图——**手势识别+轨迹预判;

-

**动态调整力矩——**能判定地毯vs大理石地面。

▲图6| Gassidy语义地图构造算法

语义地图与大模型融合:

语义地图还与近期非常火热的大模型概念进行了有机融合,从而提升具身智能系统的规控模块的表现。譬如,香港科技大学和悉尼大学(研究[6])提出了一种使用大模型构建的语义地图(Prompt, Plan, Perform),并将其与大语言模型结合使用,以完成导航任务。

具体方法如下:

**语义地图构造算法:**利用视觉大模型提取环境的语义信息,并将其融合到地图上。更强大的视觉大模型提供了出色的零样本标签识别能力和零样本定位能力,能够更好地感知环境的语义信息。此外,提出了一种对语义信息的降采样和融合方法,将这些语义信息投影到栅格地图上形成语义地图,为机器人执行下游的导航任务提供路径规划依据。

**基于大语言模型的控制框架:**构建本地API库,使得大语言模型根据自然语言指令生成机器人可执行的代码。大语言模型理解自然语言指令,结合构造的语义地图,定位出机器人任务的目的地,通过传统的规划算法规划出最优路径后执行动作完成任务。将大语言模型融入控制中提高了机器人执行更复杂更多样的控制任务的能力。

▲图7| Prompt, plan, perform大语言模型的控制框架

总体来说,语义地图突破了传统控制的两大认知瓶颈:

(1)从「几何空间」到「语义空间」

(2)从「孤立决策」到「全局推理」

在控制模块,语义地图则结合大语言模型等先进技术,让具身智能系统在执行任务时更加灵活、准确,提升了对复杂多变环境的适应能力,显著增强了具身智能系统的整体性能。

04 总结

语义地图的价值,本质是突破了机器认知的"哥德尔极限"。

试想一下,工厂里的机械臂能分清原料和废料了,自动驾驶能辨别路上飘的是塑料袋还是重物了,连医院服务机器人都学会避开无菌病房区域了。

当机器人干活不再像开盲盒,而是直接开启上帝视角;当系统不仅能处理形式化的符号,还能理解符号背后的意义时,智能的涌现将不再局限于预设程序。

当机器人开始基于语义推理而非几何反射做出决策时,具身智能的“环境共融”时代才真正拉开序幕。

欢迎关注,与我们一同见证。

05 参考文献

[1] Gassidy: Gaussian Splatting SLAM in Dynamic Environments

[2] A Survey of Visual SLAM in Dynamic Environment: The Evolution From Geometric to Semantic Approaches

[3] Blitz-SLAM: A semantic SLAM in dynamic environments

[4] A survey on robot semantic navigation systems for indoor environments

[5] OpenIN: Open-Vocabulary Instance-Oriented Navigation in Dynamic Domestic Environments

[6] Prompt, plan, perform: Llm-based humanoid control via quantized imitation learning

3968

3968

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?