时间序列中的多头自注意力机制 (Multi-Head Self-Attention Mechanism) 详细解释及举例

多头自注意力机制是自注意力机制的扩展,通过并行计算多个自注意力层来捕捉更多维度的信息。它能够在不同的子空间中进行注意力计算,从而提高模型的表达能力。

工作原理

1. 输入向量变换为多个查询、键和值矩阵

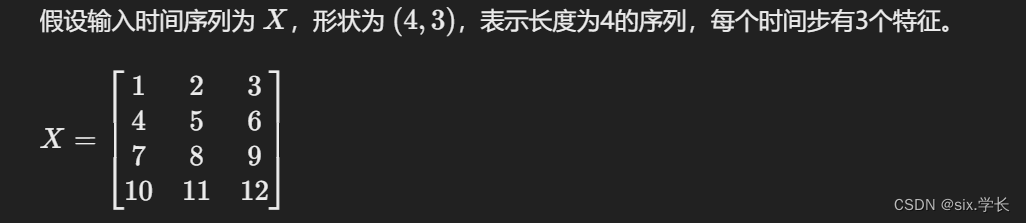

首先,将输入时间序列 (X) 通过线性变换分别生成多个查询矩阵 (Q)、键矩阵 (K) 和值矩阵 (V)。假设有 (h) 个注意力头,每个头的维度为 (d_k)。

2. 计算每个头的注意力得分

3. 连接所有头的输出

4. 最终线性变换

举例说明

假设我们有一个简单的时间序列数据,表示某个传感器在不同时间步的测量值。我们使用两个注意力头来捕捉各时间步之间的相关性。

输入数据

1. 生成多个查询、键和值矩阵

2. 计算每个头的注意力得分

3. 连接所有头的输出

4. 最终线性变换

具体代码实现

下面是一个具体的Python代码示例,演示如何在时间序列中实现多头自注意力机制:

import numpy as np

def softmax(x):

e_x = np.exp(x - np.max(x, axis=-1, keepdims

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1045

1045

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?