视觉语言预训练旨在从大量数据中学习视觉和语言之间的对齐。大多数现有方法仅学习图像-文本对齐。其他一些方法利用预训练的目标检测器在目标 Level 利用视觉语言对齐。

在本文中,作者提出通过一个统一的预训练框架来学习多粒度的视觉语言对齐,该框架同时学习多粒度对齐和多粒度定位。基于此提出了X-VLM,一个具有灵活模块化架构的一体化模型,作者在其中进一步统一了图像-文本预训练和视频-文本预训练。X-VLM能够学习与不同文本描述相关联的无限视觉概念。

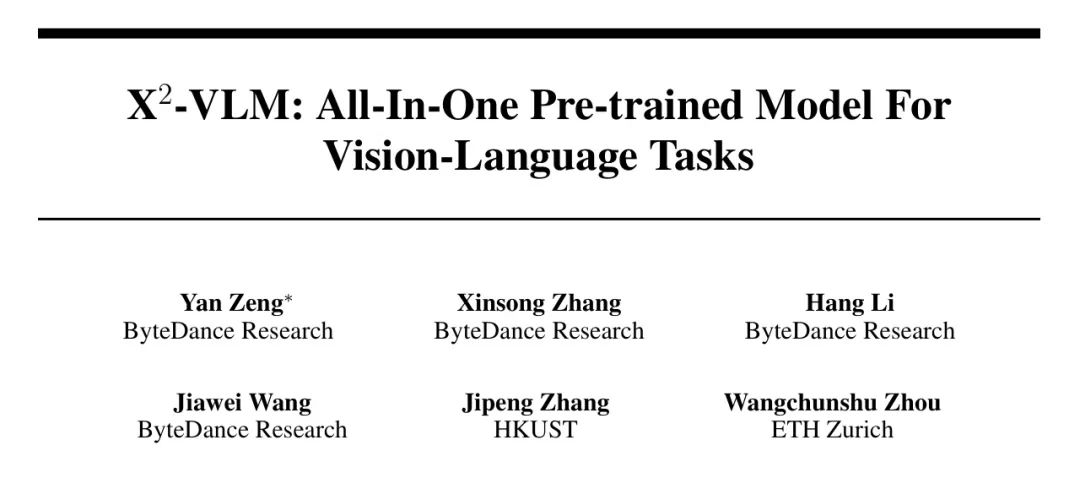

实验结果表明,X-VLM在图像-文本和视频-文本任务的基础和大规模上都取得了最佳性能,同时在性能和模型规模之间取得了良好的平衡。此外,作者展示了X-VLM的模块化设计使其具有很高的迁移性,可以用于任何语言或领域。例如,只需将文本编码器替换为XLM-R,X-VLM就能在没有进行任何多语言预训练的情况下,超越现有的多语言多模态预训练模型。

1 Introduction

视觉语言预训练旨在从大量的图像-文本或视频-文本对中学习视觉语言对齐。经过预训练的视觉语言模型(VLM)在使用少量标记数据微调后,在许多视觉语言(V+L)任务中展示了最先进(SoTA)的性能,例如图像文本检索和视觉问答(VQA)。

现有的学习视觉语言对齐的工作通常分为两类:粗粒度和细粒度。粗粒度方法使用卷积神经网络或视觉 Transformer编码整体图像特征,然而这些方法在从通常是弱相关的噪声图像-文本对中学习细粒度视觉语言对齐,例如目标 Level ,存在困难。为了学习细粒度视觉语言对齐,许多方法采用预训练的目标检测器作为图像编码器。然而,目标检测器输出的以目标为中心的特征无法编码多个目标之间的关系。此外,目标检测器只能识别有限数量的目标类别。

理想情况下,VLM应该在预训练中不受限于目标-文本对齐或图像-文本对齐,同时学习视觉和语言之间的多粒度对齐。然而,学习多粒度对齐是具有挑战性的,之前的工作未能解决这个问题。挑战来自于四个方面:

-

使用何种类型的数据来学习多粒度视觉语言对齐;

-

如何以统一的方式聚合不同类型的数据进行视觉语言预训练;

-

如何通过单一的视觉编码器表示多粒度视觉概念,包括目标、区域和图像;

-

如何从数据中高效地学习多粒度视觉语言对齐。

在本文中,作者提出了一种统一框架下预训练的全能型VLM,即X-VLM,用于学习多粒度视觉语言对齐。作者利用三种类型的数据进行视觉语言预训练,包括图像上的目标标签,如“男人”或“背包”,图像上的区域标注,如“背着背包的男孩”,以及图像的文本描述,例如“对于学生和家长来说,开学的第一天充满了复杂的情感。”。

作者假设,学习多粒度视觉语言对齐可以帮助VLM更好地理解弱相关的图像-文本对,因为模型已经学会了将图像中的组件,例如目标或区域,与文本描述,例如单词或短语进行对齐。作者将所有视觉概念与文本描述而不是类别标签相关联,包括目标、区域和图像。通过将所有视觉概念与语言相关联,模型可以以统一的方式学习由不同文本描述的无限视觉概念。

X-VLM具有灵活的模块化架构,分别包括视觉、文本和融合三个模块。所有模块均基于Transformer。作者使用视觉 Transformer编码图像,并利用某些图像块特征来表示图像中的多粒度视觉概念,这些概念可以是目标、区域或图像本身。通过这种方式,X-VLM以统一的形式输出目标、区域和图像的视觉特征。此外,作者提出直接将多粒度视觉特征与配对的文本特征对齐,并在给定的不同文本描述下,在相同的图像中定位多粒度视觉概念,用于视觉语言预训练。在微调和推理过程中,X-VLM可以利用学到的多粒度对齐执行下游的V+L任务,而无需输入图像中的目标或区域标注。

X-VLM 可以很容易地扩展到视频-文本预训练。对于视频编码,作者分别采样视频帧并用视觉 Transformer 编码帧。然后,作者使用帧的 Patch 特征在时间维度上的平均值来编码一个视频。编码器的参数在视频-文本预训练和图像-文本预训练之间共享。通过这种方式,作者利用视频-文本对使模型能够理解时间维度中的视觉概念并学习更通用的VLM。

此外,作者展示了X-VLM具有模块化架构的灵活性。作者研究在预训练后,跨模态能力是否可以转移到其他语言或领域。在现实应用中,这是一个重要的问题,因为许多多模态任务存在于非英语语言中。然而,由于在某些语言或领域收集图像-文本对或视频-文本对可能是昂贵的,最近的SoTA VLMs是用英语数据进行训练的,仅适用于英语文本,限制了它们的应用范围。作者发现,令人惊讶的是,只需用特定语言或领域的模块替换文本模块,X-VLM就可以有效地适应不同语言或领域的V+L任务,而不需要进一步的预训练。

作者进行了广泛的实验来验证X-VLM的有效性。首先,在基础和大规模上,作者将X-VLM与SoTA图像-文本预训练方法进行了比较,发现X-VLM在图像-文本任务上大幅超过了所有这些方法,包括检索、VQA、推理和定位。此外,在图像标题生成方面,X-VLM优于专为生成任务设计的SimVLM和BLIP。X-VLM还在跨模态理解任务中优于MDETR和OFA,这些任务也利用了目标和区域的图像标注。拥有约590M参数的X-VLM在与约2B参数的CoCa和BEiT-3的竞争中表现出色,尤其是在图像-文本检索和视觉推理方面。

总之,如图1 (a)所示,X-VLM在性能和模型规模之间取得了很好的平衡。此外,作者发现通过用大规模的图像-文本对进行训练,X-VLM学会了在开放域图像中定位多样化的细粒度视觉概念,例如不同的苏打水、汽车、角色和名人。第二,X-VLM在视频-文本任务上也是新的SoTA预训练模型,包括视频-文本检索和视频VQA,如图1 (b)所示。

大多数现有的VLMs只处理图像-文本任务,但X-VLM用一个统一框架在两种类型的任务上都取得了SoTA性能。第三,为了验证模块化设计的灵活性,作者在英语数据上进行视觉-语言预训练后,用XLM-R,一个多语言文本编码器,替换X-VLM的文本编码器。如图1 ©所示,X-VLM优于需要多语言图像-文本对和多语言句子对[28]的SoTA多语言多模态预训练方法,这些对收集起来是昂贵的。

本文的贡献如下:

-

提出通过一个统一的预训练框架来学习多粒度的视觉语言对齐,该框架同时学习多粒度对齐和多粒度定位。基于此展示了X-VLM,一个全能的预训练视觉语言模型,它能处理图像-文本和视频-文本任务。

-

实验结果表明,X-VLM在图像-文本和视频-文本基准测试中,无论是基础规模还是大规模都是最佳模型。此外,结果证实了提出的用于多粒度视觉语言预训练的框架可扩展到大量数据和更大的模型尺寸。

-

揭示了X-VLM模块化设计的潜力,表明它可以被应用于其他语言或领域。在英语数据上预训练后,将文本编码器替换为XLM-R,X-VLM在多语言多模态任务上超过了现有技术水平(SoTA)方法。

2 Related Work

2.1 Image-Text Pre-training

现有的图像文本预训练工作通常分为两类:细粒度和粗粒度。细粒度方法使用一个预训练的目标检测器作为图像编码器,该检测器在常见目标的标注上进行训练,例如COCO和Visual Genome。目标检测器首先识别可能包含目标的的所有区域,然后在每个区域进行目标分类。然后,图像由识别区域的数十个以目标为中心的特征表示。然而,以目标为中心的特征无法表示不同区域中多个目标之间的关系。因此,这种方法难以有效编码多粒度视觉概念。

此外,目标检测器只能检测常见目标,例如COCO数据集上只有80个目标类别。因此,在现实应用中应用这种方法来编码各种视觉概念是次优的。例如,这种方法无法区分“百事”和“可口可乐”或“奥迪”和“宝马”。

相比之下,粗粒度方法通过卷积网络或视觉 Transformer提取和编码整体图像特征来构建视觉语言模型。尽管更有效率,但粗粒度方法的性能通常不如细粒度方法,因为后者利用了目标 Level 的视觉语言对齐,这对于下游V+L任务至关重要。然而,随着先进的视觉 Transformer ,例如Swin-Transformer和BEiT-2的出现,像METER和VL-BEiT这样的最新方法可以超越最强大的细粒度方法VinVL。

还有一些方法尝试同时学习目标 Level 和图像 Level 的对齐。然而,这些方法仍然依赖于目标检测器,因此会受到前述问题的影响。例如,E2E-VLP[36]增加了一个端到端的目标检测模块(即DETR)。KD-VLP依赖于外部目标检测器进行目标知识蒸馏。与这些方法不同,作者提出的用于多粒度视觉语言预训练的框架不依赖于目标检测,并且以一种统一的方式学习不受限于目标 Level 或图像 Level 的视觉语言对齐。

2.2 Video-Text Pre-training

现有的VLM大多仅处理图像-文本任务。只有少数VLM在视频-文本预训练方面开展工作。由于视频由多个图像组成,视频-文本模型在模型架构和训练目标上通常与图像-文本模型有许多相似之处。尽管视频-文本预训练与图像-文本预训练有相似之处,但现有方法无法在两种类型的任务上都达到最先进的表现。

在视频-文本预训练方面的代表性工作包括ClipBERT,Frozen,ALPRO,VIOLET和All-in-one。还有其他针对特定下游任务优化的方法,无论是视频-文本检索还是视频问题回答。最近,提出了OmniVL以支持图像-文本任务和视频-文本任务。它利用3D图像块嵌入处理视频,2D图像块嵌入处理图像,并采用TimeSformer进行视觉编码。

2.3 Multilingual Multi-modal Pre-training

多语言多模态预训练旨在使多模态模型适用于非英文文本。虽然具有吸引力,但多语言多模态预训练有其自身的挑战。与拥有大量平行数据的多语言预训练和多模态预训练不同,现有的多语言多模态语料库数量很少,且其语言覆盖范围也有限。因此,MP 利用覆盖100种语言的101G文本进行预训练。它将英语作为枢纽,在仅限英语的视觉-语言预训练和多语言 Mask 语言建模之间交替进行。

与之不同,UC 将英文的图像-文本对翻译成五种不同的语言,并使用所有数据进行预训练。MURAL 收集了110种语言的大规模图像-文本对。CCLM 利用平行的多语言文本对,并提出了一种简单框架,该框架通过共享架构和目标统一了跨语言和跨模态预训练。所有这些方法都需要额外的数据来进行多语言多模态预训练。相比之下,作者展示了X-VLM可以利用其模块化架构的潜力,无需多语言多模态预训练过程即可适应多语言V+L任务。

3 Method

3.1 Overview

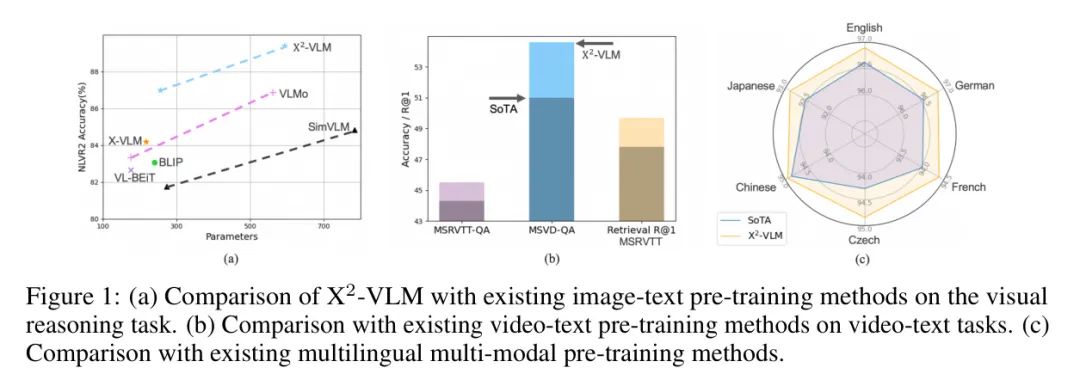

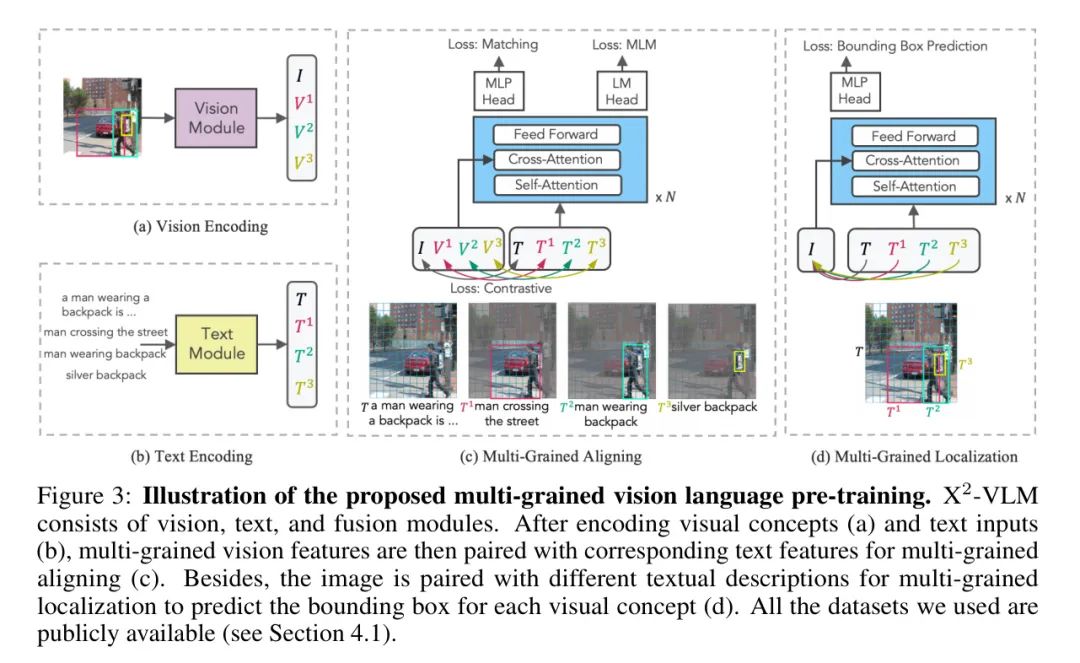

架构:X-VLM包括视觉、文本和多模态融合模块。所有模块均基于Transformer。融合模块以文本特征作为输入,并通过每一层的交叉注意力将视觉特征与文本特征融合在一起,其中文本特征作为 Query ,视觉特征作为键和值。在预训练中,这三个模块作为编码器工作,而文本和融合模块也可以通过应用从左到右的自注意力来适应生成任务,正如作者在图像标题生成实验中所展示的。图3展示了X-VLM的架构以及作者执行多粒度对齐和多粒度定位的方式。

数据:X-VLM是一个统一的方法,将所有视觉概念与文本描述相关联,包括图像-文本对、视频-文本对以及目标和区域的图像标注。也就是说,一个图像可能包含多个视觉概念,每个概念都与一个文本描述相关联,表示为。是目标或区域的图像标注。这里,是由边界框表示的目标或区域,通过边界框的标准化中心坐标、宽度和高度来表示。当图像本身代表一个视觉概念时,。

对于目标的原本是目标标签。如果目标标注包含目标属性(例如颜色),作者会将属性与目标标签拼接作为文本描述。区域的是描述这些区域的短语。注意,如表1所示,一些图像没有关联的文本,即是NaN,一些图像没有标注,即。然而,作者在一个训练批次中混合所有类型的数据,因此对于每个训练迭代,作者同时通过多粒度对齐和多粒度定位来优化模型。

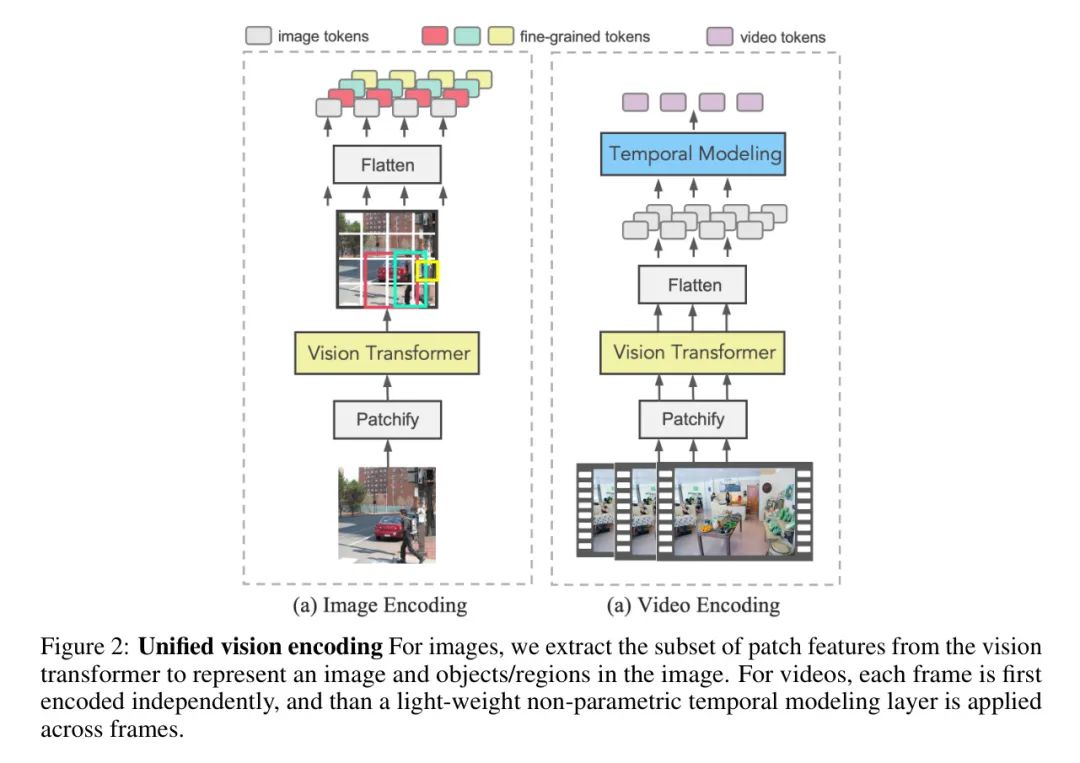

3.2 Unified Vision Encoding

X-VLM统一了图像和视频编码,如图2所示。无论输入是什么,X-VLM的视觉模块都在视觉 Transformer 的潜在特征空间中产生隐藏状态。因此,图像文本预训练和细粒度预训练相互增强。此外,图像理解的能力可以更好地转移到视频理解上。

视觉概念表示 X-VLM提出了一种高效的方法,只需一次视觉 Transformer 的前向传递就能获得图像中所有多粒度视觉概念。首先,作者将图像处理成块特征。然后,X-VLM通过在边界框内的一组块中聚合信息来表示一个目标或区域,例如对应于,如图2所示。具体来说,作者在保持原始位置的同时展平相应的块特征。然后,作者计算块特征的平均值作为[CLS]块并前置它。相应地,通过在所有块之间聚合信息来获得整个图像的表示。

视频表示 由于视频由多个图像组成,为了利用大规模图像文本预训练以获得更好的视频理解,作者以简单高效的方式统一了视频编码和图像编码。首先,作者对视频每秒采样一帧。然后,对于每个训练迭代,作者随机采样视频的几帧。视觉编码器将分别将这些帧编码成块特征。最后,作者在每个帧的块特征上添加时间信息,并在时间维度上计算平均值来表示视频。通过这种方式,视频由一系列块特征编码,与目标/区域/图像相同,因此作者可以为视频文本对和目标/区域/图像文本对应用统一的预训练框架。

3.3 Multi-Grained Vision Language Pre-training

作者将所有类型的数据混合在一个训练批次中,因此对于每次训练迭代,如图3所示,作者同时通过两个目标优化X-VLM:

-

学习视觉概念与文本之间的多粒度对齐;

-

在不同文本描述给定的情况下,在图像中定位多粒度视觉概念。

3.3.1 多粒度对齐

由于作者已经将所有视觉概念与文本描述相关联,作者提出将多粒度视觉概念与相应的文本对齐。具体来说,通过前述方法编码视觉概念后,作者以相同的方式将多粒度的视觉特征与相应的文本特征对齐。作者选择三种损失进行优化,包括对比损失、匹配损失和MLM损失。这些损失已经被之前的研究[11, 50, 5]很好地研究过,但作者提出在视觉概念到文本的层面上应用它们。请注意,本节中的代表一个视觉概念,包括目标、区域、图像或视频。

作者将对比损失应用于从批内负样本中预测(视觉概念,文本)对。给定一对,是的正例,作者将小批量中的其他个文本视为负例。首先,作者定义相似性为:

其中和分别是视觉编码器和文本编码器的输出[CLS]嵌入。和是将[CLS]嵌入映射到归一化低维表示的变换。基于此,作者计算批内视觉到文本的相似性为:

类似地,文本到视觉的相似性为:

其中 是一个可学习的温度参数。令 和 分别表示 GT 的一热相似度,其中只有正对具有概率一。最后,对比损失定义为交叉熵 之间的 和 :

作者还利用匹配损失来确定一对视觉概念和文本是否匹配。对于小批量中的每个视觉概念,作者按照方程式 2 中的 采样一个批内困难负文本。与概念更相关的文本更有可能被采样。作者还为每个文本采样一个困难负视觉概念。然后作者把这些对作为融合模块的输入,然后使用融合模块输出的 [CLS] 嵌入 来预测匹配概率 ,损失为:

其中 是一个二维一热向量,表示 GT 标签。

此外,作者应用 Mask 语言建模损失来根据视觉概念预测文本中的 Mask 词。作者以 40% 的概率随机 Mask 输入标记,并用 10% 随机标记,10% 不变,80% 的 [MASK] 标记替换。作者使用融合编码器的输出,并附加一个线性层,然后是 softmax 进行预测。令 表示一个 Mask 的文本, 表示融合模块预测的 Mask 标记 的概率。作者最小化交叉熵损失:

损失函数 定义为:

其中 是一个单热分布,在该分布中, GT 标记 的概率为1。

3.3.2 Multi-Grained Localization

作者已经在不同粒度上将视觉概念与文本对齐。作者进一步通过训练X-VLM来定位给定相应文本描述的同一图像中的不同视觉概念。具体来说,作者在视觉语言预训练中引入了边界框预测任务,模型需要预测视觉概念的边界框:

其中Sigmoid用于归一化,MLP表示多层感知机,是融合模块在给定(整个图像)和(视觉概念的描述)的特征下的[CLS]输出嵌入。

对于边界框预测,是最常用的损失函数。然而,它对于大小框具有不同的尺度,即使它们的相对误差相似。为了减轻这个问题,作者使用了损失和广义交并比(IoU)损失的线性组合,后者是尺度不变的。总体损失定义为:

最后,X-VLM的预训练目标定义为:

4 Experiment

4.1 Pre-training Datasets

作者使用两套数据集对X-VLM进行预训练。4M预训练数据集包括两个领域内数据集,COCO 和 Visual Genome (VG) ,以及两个领域外数据集,SBU Captions 和 Conceptual Captions (CC) 。这个预训练数据集被之前的工作广泛使用,因此作者选择这种设置以便与其他方法进行公平的比较。作者还根据OFA 和 MDETR 的做法,包括了来自 RefCOCO,GQA,和 Flickr entities 的COCO和VG图像的标注。

然后,作者通过包括来自Conceptual 12M数据集 (CC-12M) 和 LAION 的领域外和噪声更大的图像-文本对,以及Objects365 和 OpenImages 的目标标注,来扩大预训练数据集。此外,为了支持视频-文本下游任务,作者在预训练中还包括了来自WebVid2.5M,Howto100M,和 YT-Temporal 180M 的视频-文本对。

请注意,作者使用的所有数据集都是公开可用的,并已被之前的工作 [5, 13, 20, 22, 43] 利用。另外,由于大多数下游任务都是建立在COCO和VG之上的,作者排除了所有在下游任务测试集中出现的图像,以避免信息泄露。作者在附录中提供了数据过滤的细节。

4.2 Implementation Details

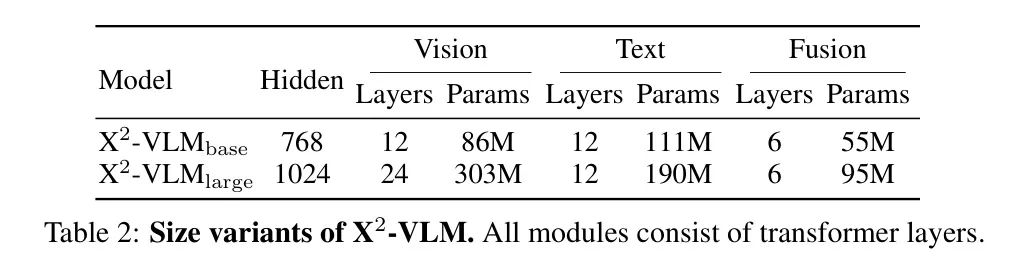

表2列出了X-VLM的参数。考虑到性能与模型规模之间的权衡,X-VLM也使用了12层的文本编码器。视觉编码器使用BEiT-2进行初始化。文本编码器使用BERT进行初始化。X-VLM在图像分辨率为,使用的 Patch 大小进行预训练。作者在训练批次中混合所有类型的数据,因此在每个训练迭代中,作者同时通过多粒度对齐和多粒度定位来优化模型。

使用4M数据,作者在8个A100上以批量大小1024预训练X-VLM 500K步,在16个A100上预训练X-VLM 250K步,大约需要1周的时间。X-VLM的学习率在前2500步预热到,然后按照线性计划衰减。X-VLM的学习率为。使用大规模数据,在32个A100上训练X-VLM的基础模型需要2-3周,在大模型上需要64个A100。作者在附录中描述了实现细节。

4.3 Image-Text Downstream Tasks

作者比较了X-VLM与五个广泛使用的图像-文本下游任务中最知名的最先进方法。通常,作者遵循之前工作中关于微调的设置。以下是作者如何实现微调的描述。

4.3.1 Image-Text Retrieval

作者在MSCOCO和Flickr30K 数据集上评估了X-VLM。对于这两个数据集,作者采用了广泛使用的Karpathy划分。作者优化了和进行微调。作者将批量大小设置为1024。输入图像的分辨率设置为384x384。遵循之前的工作,X-VLM首先分别编码图像和文本,并计算批内文本到图像和图像到文本的相似性以获得前个候选,然后使用融合编码器对候选进行重新排序。对于MSCOCO数据集,设置为80,对于Flickr30K,设置为32。

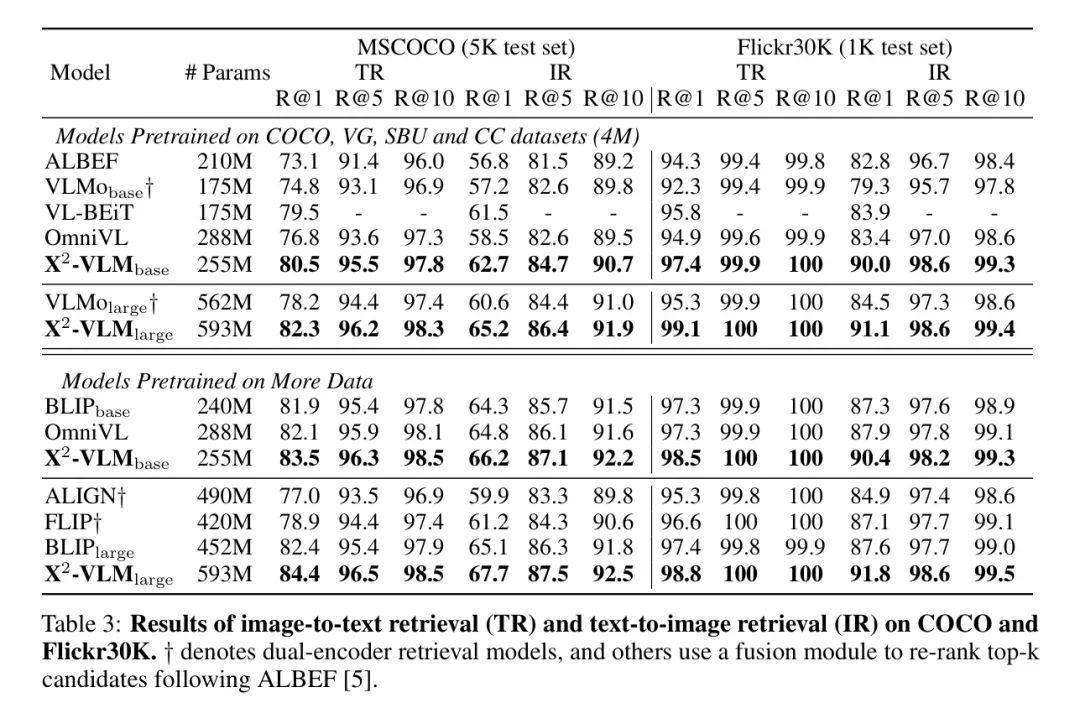

表3显示,尽管现有方法要么具有更多的模型参数,要么具有更多的训练数据,但X-VLM在图像文本检索任务上特别是在Flickr30K基准上达到了SoTA结果。具体来说,-优于FLIP,和,后者也利用了来自LAION的大规模图像文本对,而-进一步提高了图像文本检索性能。与同时支持图像文本任务和视频文本任务的OmniVL相比,-在用4M数据或更多数据进行预训练时,其性能明显优于OmniVL。这些结果验证了学习多粒度视觉语言对齐的优势。

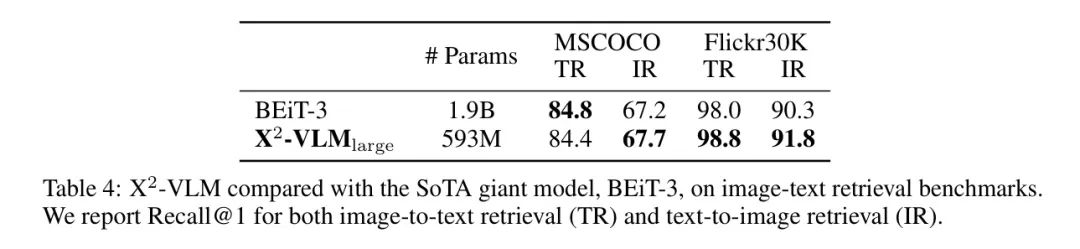

作者还将在表4中将-与拥有1.9B模型参数的巨大基础模型BEiT-3进行比较。实验结果表明,尽管-体积小得多,但与BEiT-3相比,其性能相当甚至更好。此外,如表3所示,-在4M设置中明显优于BEiT-3的基础版本VL-BEiT。另一方面,当比较表3中-VLM在不同设置下的性能时,作者可以看到所提出的多粒度视觉语言预训练框架具有良好的可扩展性,可以从更大的模型尺寸和大规模的领域外图像文本对中受益。

4.3.2 Visual Question Answering

该模型需根据给定的图像和问题预测答案。作者在VQA v2.0数据集[65]上评估-VLM。遵循现有方法[7; 11; 5],作者使用训练集和验证集进行训练,并包含来自Visual Genome的额外问题-答案对。按照ALBEF的做法,作者使用六层Transformer解码器根据融合模块的输出生成答案。然后,通过优化自回归损失对模型进行微调。在推理过程中,作者将解码器限制仅从3,129个候选答案中生成,以便与现有方法进行公平比较。请注意,这里有一个NULL答案。因此,实际的候选答案数量为3,128。遵循之前的工作[22, 23, 24],输入图像的分辨率设置为768x768。

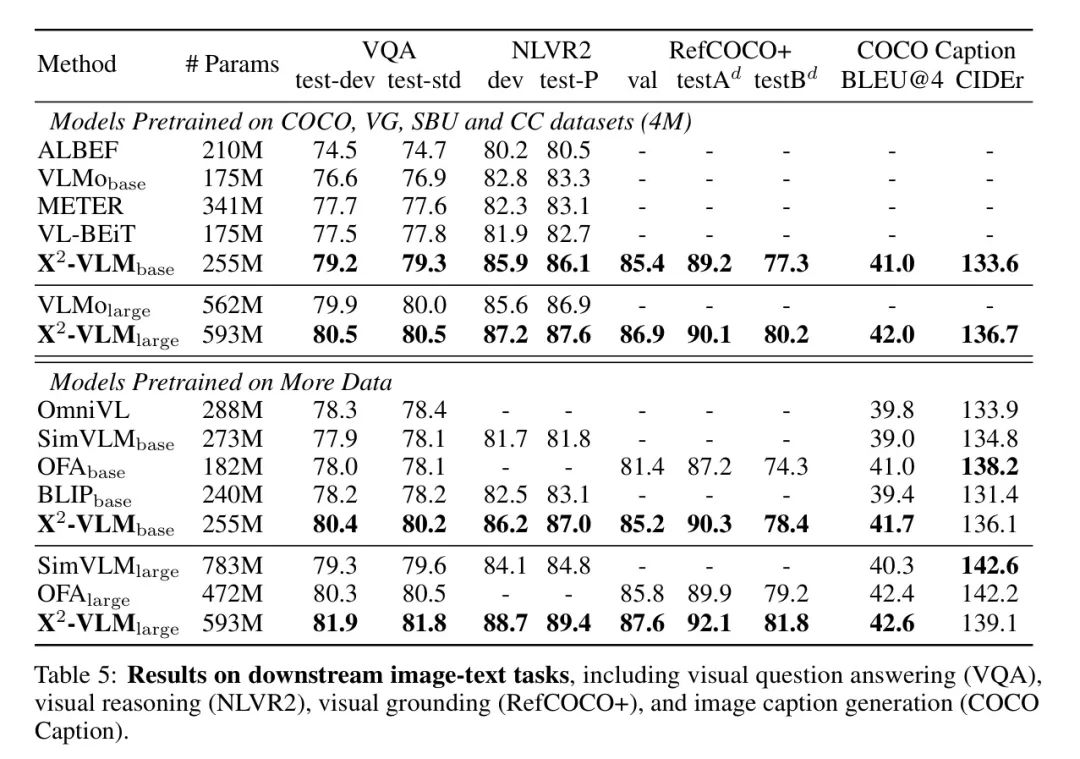

作者在表5中报告了VQA的实验结果。可以看出,-和-在类似规模的模型大小下优于其他方法。特别是,-在4M设置下明显优于ALBEF、VLMo、METER和VL-BEiT。此外,通过更多的预训练数据,-也优于同样利用来自LAION的大规模图像-文本对的BLIP。与同时支持图像-文本任务和视频-文本任务的OmniVL相比,-明显优于它,实现了2%的绝对改进。-VLM还在基础和大型规模上明显优于SimVLM和OFA。

SimVLM利用了一个内部的1.8B图像-文本数据集。OFA也像-VLM一样利用了目标和区域的图像标注。这些结果证实了所提出的多粒度视觉语言预训练框架的有效性。此外,当比较表5中-VLM在不同设置下的表现时,作者可以看出所提出的框架具有良好的可扩展性,能够从更大的模型大小中受益。当使用更多数据预训练更大模型时,性能的改进更为显著。

4.3.3 Visual Reasoning

作者在广泛使用的基准测试NLVR2 上评估了 -VLM。该任务让模型判断一段文本是否描述了两张图片之间的关系。遵循之前的工作 [67, 35],作者将三元组输入形式化为两个图像-文本对,每个对包含文本描述和一张图像。然后,作者将这两个对的融合模块的最终输出 [CLS] 特征进行拼接,以预测标签。输入图像的分辨率设置为384x384。

根据表5的结果,作者可以观察到视觉推理任务更多受益于模型大小,而不是预训练数据规模。与其他基础规模模型(例如ALBEF、VLMo、VL-BEiT、SimVLM和BLIP)相比,- 的性能要好得多,无论使用400万数据还是更多噪声数据进行预训练,都实现了约3-4%的绝对提升。- 也明显优于其他大规模模型,包括 和 。

4.3.4 视觉定位

作者在RefCOCO+ 上评估了X-VLM。给定一张图像作为输入和一个文本描述作为 Query ,利用融合模块的最终输出 [CLS] 特征来预测视觉概念所在的边界框。输入图像的分辨率设置为384x384。如表5所示,X-VLM 超过了 OFA,后者也利用目标和区域的图像标注进行预训练。不同的是,采用编码器-解码器架构的 OFA 将所有数据格式化为序列到序列的形式。此外,针对一般V+L用途的 X-VLM 优于专门针对视觉定位任务的 MDETR,在指标上平均实现了约7%的绝对提升。这些结果证实了与利用目标和区域的图像标注的其他方法相比,所提出的多粒度视觉语言预训练的有效性。

4.3.5 Image Captioning

作者让模型生成输入图像的文本描述。尽管X-VLM更偏向于跨模态理解,但作者也对其在COCO字幕数据集上的生成性能进行了评估。遵循UniLM和BEiT-3的方法,作者使用自左至右的MLM进行生成。具体来说,作者将文本模块和融合模块作为解码器,采用自左至右的自注意力,并采用[70]中减少精调与生成之间差异的方法在MLM生成中。输入图像的分辨率设置为480x480。作者在Karparthy测试集上报告了BLEU-4和CIDEr得分。

如表5所示,X-VLM在生成任务上优于BLIP和SimVLM,它们专门为生成任务而设计。BLIP使用了与X-VLM相同的大规模图像-文本对来自LAION。SimVLM利用了一个内部1.8B的图像-文本数据集。在BLEU-4方面,X-VLM在图像字幕生成上的表现也优于OFA。OFA拥有编码器-解码器架构,并将所有下游任务形式化为序列到序列形式进行预训练。总的来说,尽管X-VLM更适用于跨模态理解,但与SoTA生成方法相比,它的表现具有竞争力,有时甚至更好。

4.3.6 Winoground

Winoground 提出了一个具有挑战性的任务:给定两张图片和两个标题,目标是正确地将它们匹配起来,其中标题包含相同的一组单词,但顺序不同。使用了三种度量标准来评估性能,分别是文本(模型是否能为给定图片匹配正确的标题)、图像(反之亦然)和组(模型是否能为每对匹配),一些有竞争力的视觉语言模型(VLMs)已经被证明其表现接近甚至低于随机水平。

表6中的实验结果显示,即使在400万数据上训练,X-VLM 也显著优于其他模型,例如基于大型预训练目标检测器的UNITER,以及由巨大的ViT和FlanT5大型语言模型组成并预训练在包含1.29亿图像的更大数据集上的BLIP-2。值得注意的是,通过增加模型大小或预训练数据集,X-VLM 的性能还可以进一步改进。

4.3.7 Open-vocabulary Attribute Detection

开放词汇属性检测(OVAD)旨在识别图像中的开放集合目标,并为每个目标识别开放集合的属性。作者遵循这一基准,并在框-oracle设置下评估视觉语言模型在属性上的零样本性能。实验结果如表6所示。使用400万数据集预训练的X-VLM已经可以与使用1.29亿数据集预训练的BLIP相媲美。X-VLM还在性能上超过了OVADetector,后者由一个冻结的CLIP文本编码器和一个基于Faster-RCNN的目标检测器组成。此外,像在其他任务中一样,通过扩大预训练数据集或模型大小来扩展X-VLM,其性能也一致得到提升。

4.4 Video-Text Downstream Tasks

X-VLM统一了图像文本和视频文本的预训练。在本节中,作者在三个广泛使用的视频文本任务上评估X-VLM,包括视频文本检索(MSRVTT)和视频问题回答(MSRVTT-QA 和 MSVD-QA)。作者实现的文本到视频检索模型与图像文本检索相同,首先计算top-候选,然后使用融合模块对候选进行重新排序。设置为32。在训练和推理过程中,作者每个视频采样五帧。图像分辨率为384。视频问题回答要求模型在给定视频和问题的情况下生成答案。

遵循先前的工作,作者将它制定为一个分类任务,给定候选答案。在训练和推理过程中,作者对MSRVTT数据集中的每个视频采样五帧,对MSVD数据集采样八帧。MSRVTT的图像分辨率为320,MSVD为224。作者与现有的最先进的视频语言基础模型进行了比较:ALPRO,VIOLET,以及All-in-one。作者还比较了X-VLM和OmniVL,后者同样支持图像文本任务和视频文本任务。还有其他专门针对视频文本检索或视频问题回答的方法,这些方法没有包括在作者的比较中。

结果在表7中给出。作者可以看到,X-VLM在视频问题回答和文本到视频检索上都超过了先前的视频语言基础模型,而X-VLM进一步提升了性能,实现了视频文本预训练的新SoTA结果。此外,作者在图像文本(表3和表5)和视频文本基准上比较了X-VLM和OmniVL。总的来说,X-VLM在所有图像文本下游任务上都显著优于OmniVL,包括图像文本检索、视觉问题回答、图像标题生成和视频问题回答。

4.5 Multilingual Multi-modal Tasks

在X-VLM架构中,文本编码、视觉编码和融合是分离的。因此,在替换文本编码器时,视觉编码和融合的能力得以保持,这导致了新文本编码器的有效适配。作者的研究证明,在英文数据上进行预训练后,可以用特定语言或领域的文本编码器替换文本编码器,以支持不同语言或领域的更多应用。这种特性在OFA和BEiT-3这样的统一模型中难以实现。例如,BEiT-3在单个Transformer中共享图像、文本和融合,因此替换文本编码器也可能导致图像编码和融合能力的丧失。

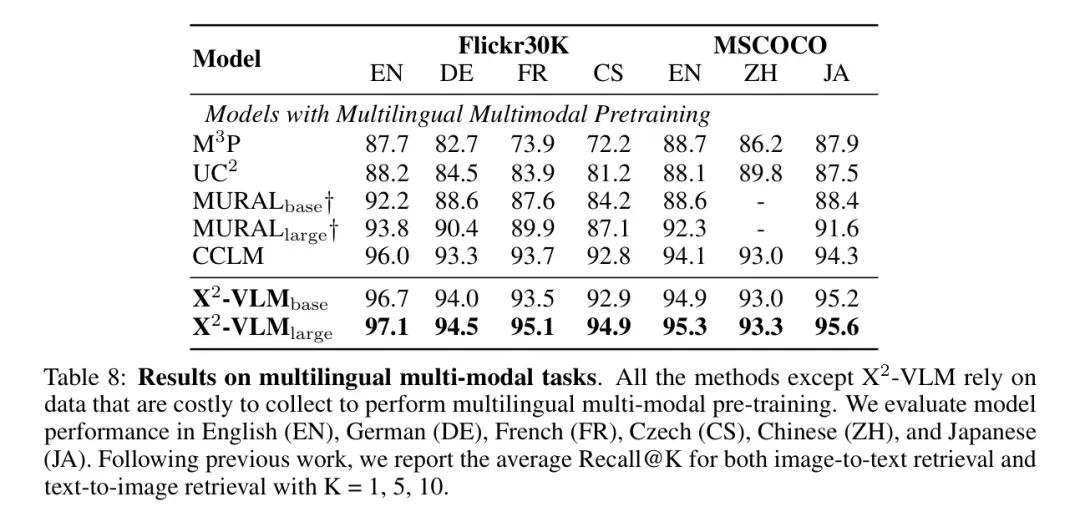

在本节中,作者将X-VLM的英文文本编码器替换为多语言文本编码器XLM-R。然后,在没有进行第二阶段的多语言多模态预训练的情况下,作者仅在多语言多模态下游任务上对X-VLM进行微调。由于其他多语言多模态基准测试(如IGLUE)没有训练集,作者选择Multi30K和多语言MSCOCO进行评估。遵循之前的工作,作者计算图像到文本检索和文本到图像检索的平均Recall@K(K = 1, 5, 10)作为评估指标。

作者将X-VLM与现有的多语言多模态预训练方法进行比较。MP使用了覆盖100种语言的101G文本。UC将英文的图像-文本对翻译成五种不同的语言。MURAL在110种语言中收集大规模的图像-文本对。CCLM利用平行的多语言文本对。所有这些方法都依赖于收集成本高昂的数据,而X-VLM减轻了多语言多模态预训练过程。

如表8所示,X-VLM在所有六种语言上意外地超过了所有这些方法。结果表明,X-VLM具有潜力,使用不同的文本编码器应用于其他领域或语言,而无需进一步预训练。

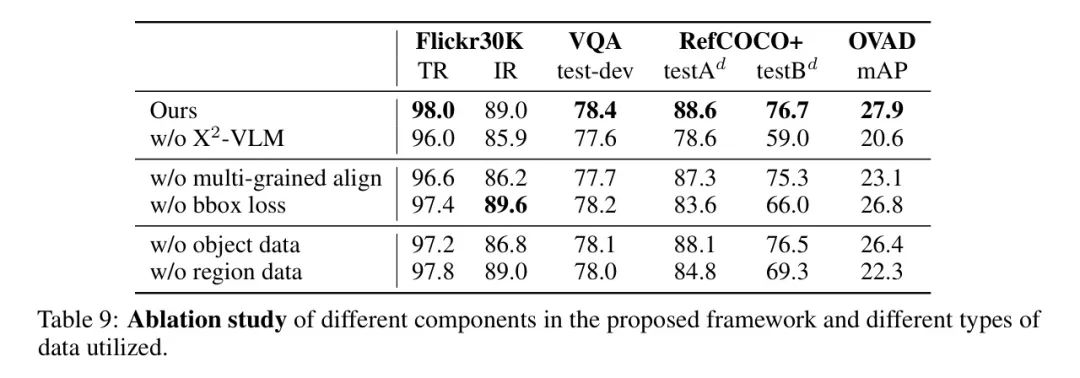

4.6 Ablation Study

作者进行了深入的消融研究,结果如表9所示。作者在附录中描述了实验设置。首先,作者研究了所提出框架中不同组件的作用,并分别对多粒度对齐和框预测损失进行了消融实验。需要注意的是,在这两个变体中均使用了目标和区域数据。

实验结果表明,在所有任务中,多粒度对齐对于模型性能的重要性超过了框预测损失,视觉定位任务除外。框预测损失对视觉定位任务的性能至关重要,将框预测与多粒度对齐结合使用可以进一步提高模型性能(作者的方法与无bbox损失对比)。

其次,作者探讨了X-VLM中使用的不同类型标注数据的影响,并分别消融目标数据和区域数据。在这两个变体中均应用了多粒度对齐和框预测损失。结果表明,这两种类型的标注对性能都很重要。目标数据提高了图像-文本检索的性能,而区域数据对视觉定位和开放词汇属性检测至关重要。结合目标和区域数据可以获得最佳性能(作者的方法与无目标和无区域对比)。消除了多粒度对齐和框预测损失,或同时消除了目标和区域数据的w/o X-VLM变体,在所有任务中的性能最差。作者在附录中还提供了关于时间建模方法的消融研究。

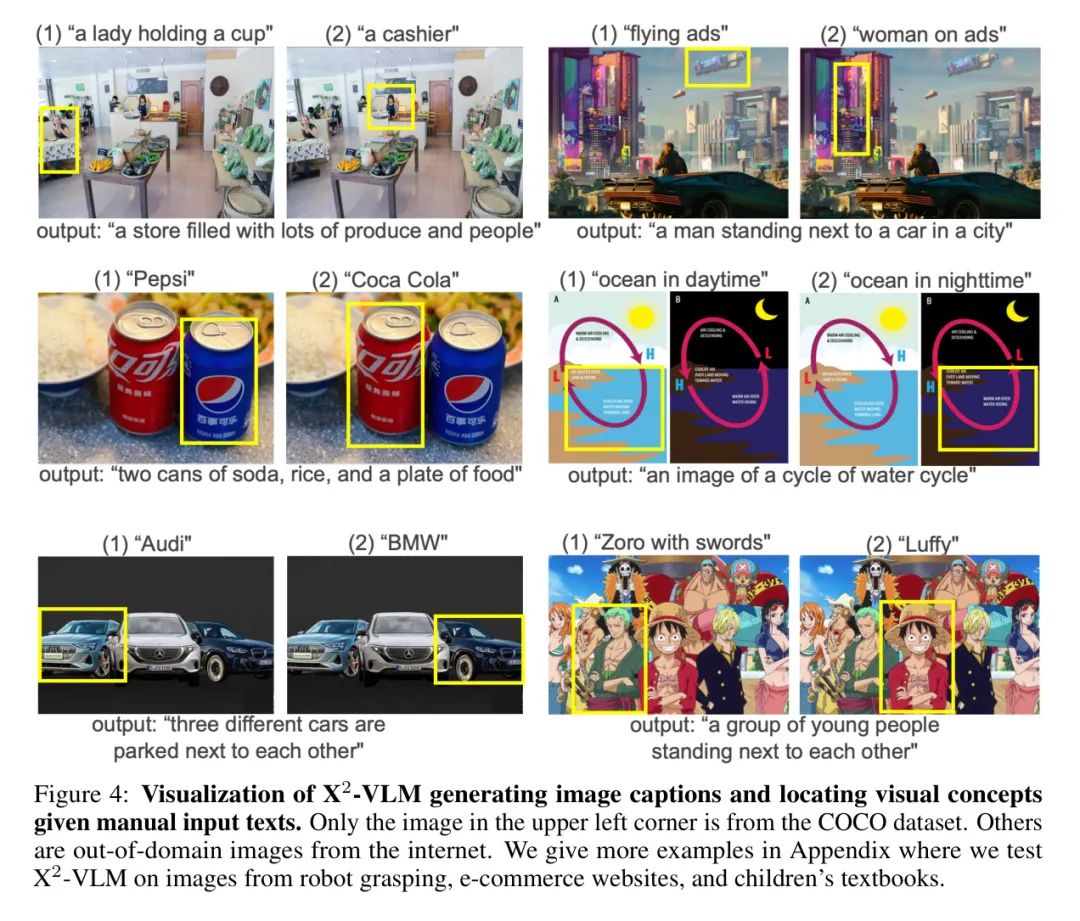

4.7 Qualitative Study of Multi-Grained Alignments

在本节中,作者提供了关于X-VLM学会了哪些视觉语言对齐的定性研究。为此,作者让X-VLM生成图像标题,以观察它是否能够适当地描述一幅图像。作者还让X-VLM根据手动输入的描述在图像中定位视觉概念,以查看它是否能够理解图像中的细粒度目标或区域。作者分别在这项评估中使用在COCO Caption和RefCOCO+数据集上微调的X-VLM。

作者在图4中可视化了结果,其中作者选择了一些来自科学海报、视频游戏、卡通等领域的图像。可视化示例显示,X-VLM可以适当描述所有这些图像,并对主要角色或目标及其关系有精确的理解。当根据作者提供的描述让X-VLM在图像中定位视觉概念时,作者发现它可以捕捉到背景中的小物体或部分遮挡的物体。此外,X-VLM能够识别不同品牌的汽水或汽车,或是将“路飞”和“索隆”与其他卡通角色区分开来。

作者在附录中提供了更多示例,其中X-VLM还能够识别“爱因斯坦”、“爱迪生”、“奥特曼”和“哆啦A梦”。这是令人惊讶的,因为作者利用的预训练中的目标或区域标注仅关于诸如“汽水”、“汽车”或“男人”之类的常见目标。结果表明,X-VLM学会了从大规模噪声图像-文本对中定位多样化的细粒度视觉概念。

5 Conclusion and Discussion

在本论文中,作者提出了在预训练过程中学习视觉与语言之间的多粒度对齐。为此,作者提出了一个统一的多粒度视觉语言预训练框架,该框架直接将多粒度视觉特征与配对的文本特征对齐,并在给定不同文本描述的情况下,在同一图像中定位多粒度视觉概念。基于此,作者展示了X-VLM,一个具有灵活模块化架构的全能预训练视觉语言模型,其中作者进一步统一了图像编码和视频编码,使其能够处理图像文本任务和视频文本任务。

作者进行了广泛的实验来验证X-VLM的有效性。结果显示,在许多下游图像文本任务中,X-VLM在基础和大规模上均显著优于现有技术水平(SoTA)的图像文本预训练方法,在性能和模型规模之间取得了良好的平衡。X-VLM也是视频文本任务上的新SoTA预训练模型,包括视频文本检索和视频视觉问答。实验结果还表明,所提出的多粒度视觉语言预训练框架可扩展到大规模数据和更大的模型尺寸。此外,作者揭示了X-VLM模块化设计的潜力,表明它可以用于其他语言或领域。在英语数据上预训练后,用XLM-R替换文本编码器,X-VLM在多语言多模态任务上超过了现有技术水平。

作者还提供了深入的消融研究,以探讨所提出框架中不同组件的作用。实验结果表明,多粒度定位和多粒度对齐是所提出方法的关键组成部分。此外,作者对X-VLM所学到的视觉语言对齐进行了定性研究。作者发现,通过大规模图像文本对的训练,X-VLM能够定位开放领域图像中多样的细粒度视觉概念,如不同品牌的苏打水、汽车和角色或名人。

如何学习大模型 AI ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

- 硬件选型

- 带你了解全球大模型

- 使用国产大模型服务

- 搭建 OpenAI 代理

- 热身:基于阿里云 PAI 部署 Stable Diffusion

- 在本地计算机运行大模型

- 大模型的私有化部署

- 基于 vLLM 部署大模型

- 案例:如何优雅地在阿里云私有部署开源大模型

- 部署一套开源 LLM 项目

- 内容安全

- 互联网信息服务算法备案

- …

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名大模型 AI 的正确特征了。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1654

1654

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?