大型语言模型(LLMs)在材料科学和工程等领域的应用进步依赖于微调策略的发展,这些策略能够使模型适应专业化、技术化的能力。在本项工作中,我们探索了持续预训练(Continued Pretraining, CPT)、监督式微调(Supervised Fine-Tuning, SFT)以及基于偏好的优化方法,包括直接偏好优化(Direct Preference Optimization, DPO)和赔率比偏好优化(Odds Ratio Preference Optimization, ORPO),对微调后LLM性能的影响。我们的分析显示了这些策略如何影响模型结果,并揭示了多个微调模型的合并可以导致能力的出现,这些能力超越了原始模型的单独贡献。我们发现模型合并不仅仅是一个聚合过程,而是一种变革性的方法,可以通过模型参数之间的高度非线性相互作用来推动模型能力的显著提升,从而在特定领域的评估中提高性能。我们研究了影响模型合并成功的关键因素,如父模型之间的多样性和所采用的微调技术。这些见解强调了策略性模型合并在解锁LLMs新能力方面的潜力,为应对复杂挑战提供了有效的工具。我们展示了不同模型架构的实验,包括Llama 3.1 8B和Mistral 7B系列模型,观察到了类似的行为。为了探索这些结果是否也适用于更小的模型,我们使用了一个具有17亿参数的小型LLM,并表明非常小的LLMs在模型合并下不一定具有突现能力,这表明模型规模可能是一个关键组成部分。在人类与AI模型之间的开放式但一致的聊天对话中,我们的评估揭示了不同模型变体的表现,并显示出最小的模型在包括推理深度、创造力、清晰度和定量精度在内的关键标准上获得了高智能分数。其他实验包括开发图像生成提示,这些提示寻求对不同的生物材料设计概念进行推理,以创造新的微观结构、建筑概念和基于生物材料启发的构造原则的城市设计。我们以一系列关于规模和突现的问题结束,这些问题可以在未来的研究中得到解决。

关键词:大型语言模型、人工智能、工程科学、材料科学、自然语言处理

1 引言

大型语言模型(LLMs)的发展【1, 2, 3, 4, 5, 6】已经增强了我们在科学和工程应用中的自然语言处理(NLP)能力,由于在多个领域的显著进步,从通用应用到像材料科学和工程这样的专业领域【7, 8, 9, 10, 11, 12, 13, 14】。这些模型,包括像Llama和Mistral这样的著名开源架构,已经在理解和生成类人文本方面展示了强大的能力。然而,它们在技术领域的应用需要微调策略,以使这些模型适应特定的领域挑战和技术要求,这些要求通常理解不足。例如,在生物材料组学领域,研究人员旨在开发系统性的知识探索,跨越尺度、领域和应用领域,包括生物材料设计灵感【15, 16, 17, 18, 19, 7】。这些和其他挑战可以通过使用多模态推理引擎协同解决,其核心能力源自LLMs。一个理由是,LLMs已经展示了强大的能力,能够整合多样化的概念,并为生物材料工程中看到的多样化背景提供一种综合性建模策略【20, 7】。

对领域特定应用微调LLMs涉及的不仅仅是在专业数据上重新训练;它需要探索策略,以赋予模型新知识,同时保留早期训练阶段学到的能力,以获得最佳的模型性能。这是特别具有挑战性的,因为大多数情况下,从头开始训练模型是不可行的,由于成本原因,或者因为原始数据集不可用。这是开源模型如Llama或Mistral特别关注的问题,其中一些关于训练过程的细节已经发布,但预训练、微调和对齐阶段的完整数据集是未知的【6, 4】。

在早期工作中使用的一个通常有效的策略是低秩适应(LoRA),其中一组小的可训练低秩张量被添加到较大模型的线性层中,以使其适应新的能力【21, 22, 14】。虽然这可以是一种有效的方法,但一个模型可以改进的程度和可以合并的新知识量是有限的。其他研究表明,继续在领域特定的语料库上进行预训练(CPT)可以帮助更好地引入目标领域的新知识,增强其相关性和准确性。然而,这通常需要大量的额外策略来使模型适用于下游应用,如指令遵循、聊天互动、代理使用、工具调用等。监督式微调(SFT)是一种通过策划的数据集直接教授模型执行特定任务的方法。然而,通过先进的优化技术进一步提高模型性能和解锁新能力的潜力仍然是一个关键的探索领域。在这种情况下,基于偏好的优化策略,如直接偏好优化(DPO)和赔率比偏好优化(ORPO),已成为有希望的方法。与传统的强化学习方法不同,后者通常需要显式的奖励函数和复杂的环境模型,DPO和ORPO专注于基于直接反馈或偏好优化模型。这些方法提供了一种灵活高效的方式来完善模型行为,特别是当目标是使模型的输出与人类期望或特定领域的标准一致时,例如能够在特定领域进行推理或逻辑推断。

另一个近期感兴趣的领域是模型合并的实践【27, 28, 29】,其中多个不同训练的模型被结合起来,创造出一个可能具有更高级能力的新型模型。早期的实验表明,这个过程不仅仅是加性的;正如我们将展示的,它导致了合并模型参数之间的高度非线性相互作用,从而产生了新的功能,这些功能是任一父模型单独无法拥有的。这种突现行为表明,模型合并可能是一个强大的工具,用于推进LLM能力,使模型不仅更准确,而且更能适应复杂的现实世界挑战。

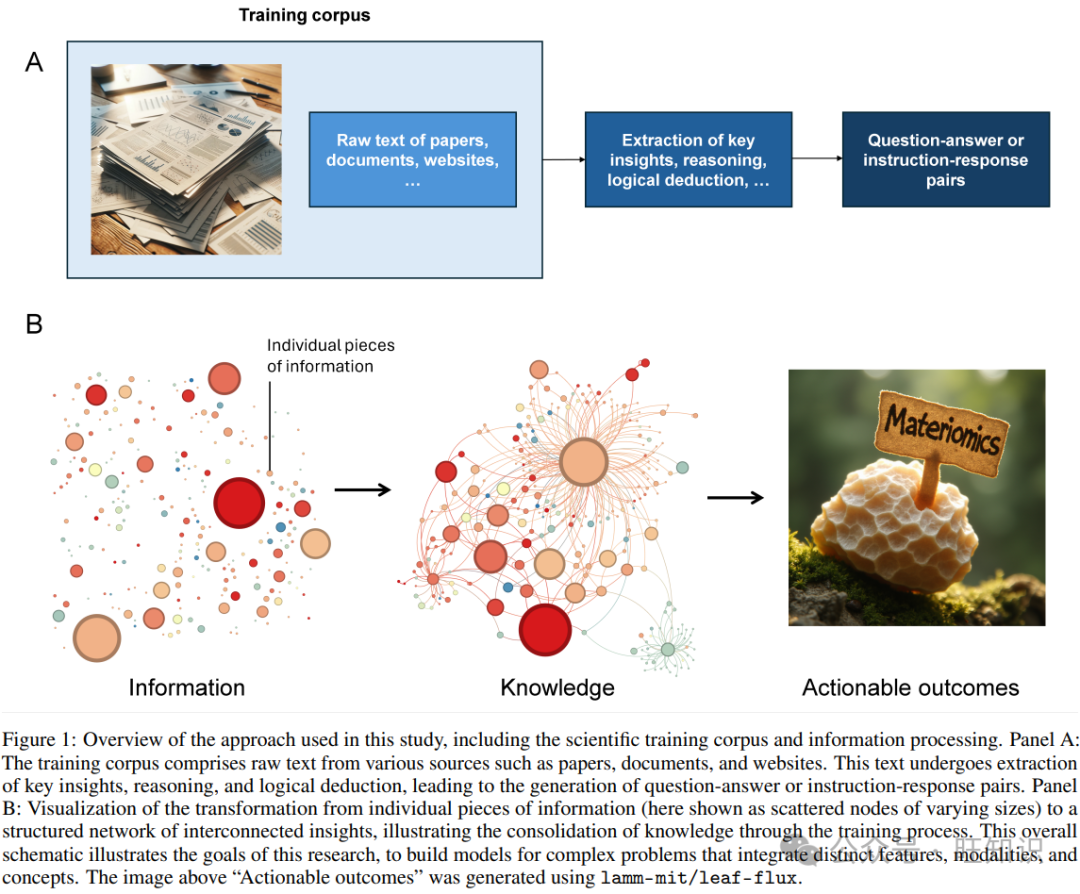

正如这个简短的回顾所示,有许多可能的策略,但相对缺乏系统探索的数据。LLMs是非常复杂的模型,训练是昂贵和耗时的,并且开发者通常专注于一种产生了可接受结果的方法。在这里,我们采取了不同的方法,特别调查了各种微调和优化策略对LLM性能的影响,重点关注一组系统、一致的实验,如表1所总结。图1显示了训练语料库和信息处理的概述,涵盖了使用不同类型的数据(原始的、处理过的/蒸馏的、对话的等)的一般过程,以及从单个信息片段到结构化互联洞见网络的转变的可视化。

图1:本研究中使用的方法概述,包括科学训练语料库和信息处理。A面板:训练语料库由来自各种来源的原始文本组成,如论文、文件和网站。这些文本经过关键洞见的提取、推理和逻辑演绎,导致生成问答或指令响应对。B面板:将单个信息片段(此处显示为大小不一的散布节点)转化为结构化的互联洞见网络的可视化,展示了通过训练过程知识整合的过程。整体意图展示了本研究的目标,即构建能够整合不同特征、模态和概念的复杂问题模型。上图“可操作的结果”是使用lamm-mit/leaf-flux生成的。

图1:本研究中使用的方法概述,包括科学训练语料库和信息处理。A面板:训练语料库由来自各种来源的原始文本组成,如论文、文件和网站。这些文本经过关键洞见的提取、推理和逻辑演绎,导致生成问答或指令响应对。B面板:将单个信息片段(此处显示为大小不一的散布节点)转化为结构化的互联洞见网络的可视化,展示了通过训练过程知识整合的过程。整体意图展示了本研究的目标,即构建能够整合不同特征、模态和概念的复杂问题模型。上图“可操作的结果”是使用lamm-mit/leaf-flux生成的。

2 结果与讨论

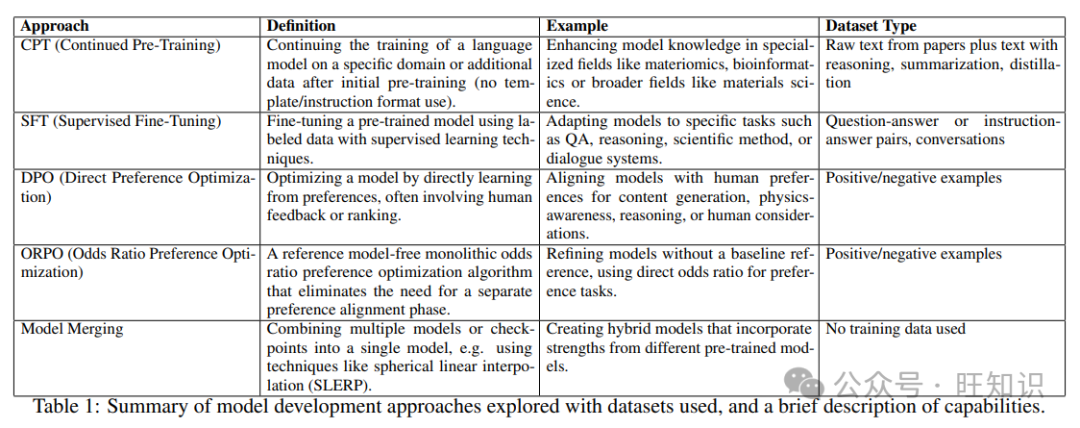

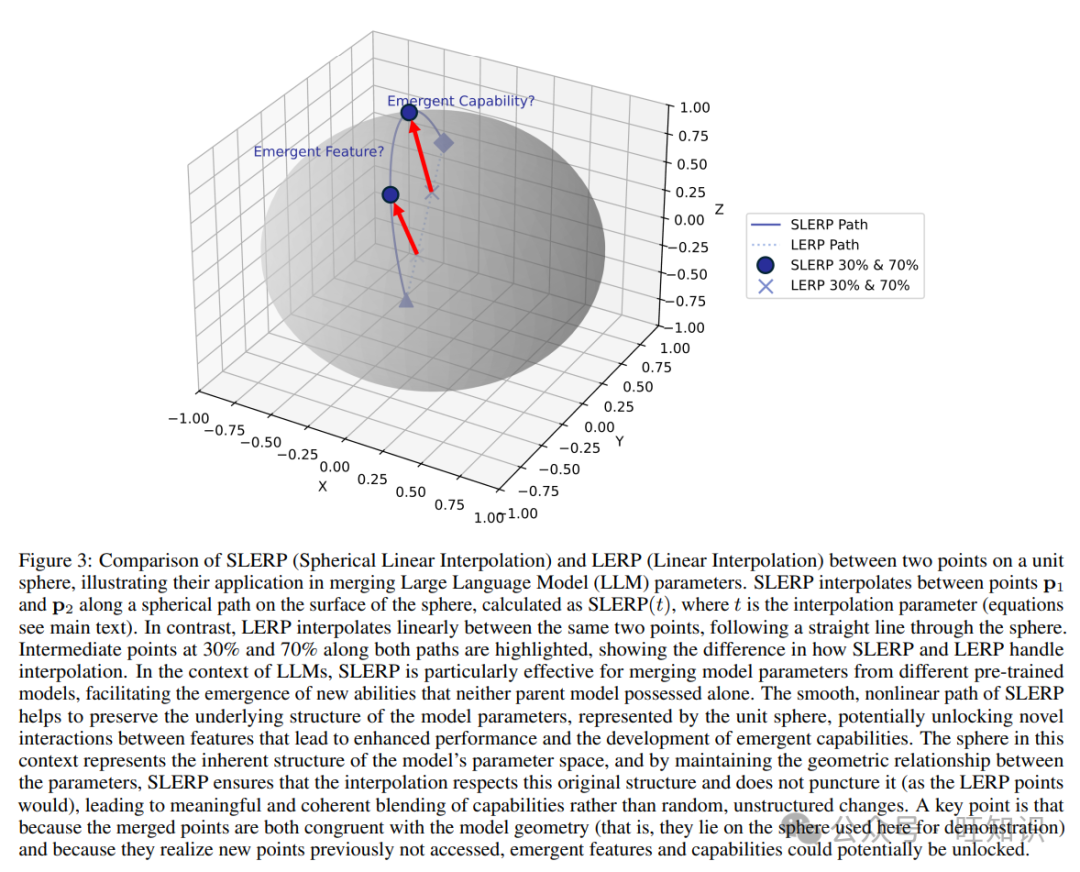

我们遵循图2中描述的过程来开发模型并进行评估。图2A展示了一个传统的线性训练流程,其中基础模型经历了持续预训练(Continued Pre-Training, CPT),然后是监督式微调(Supervised Fine-Tuning, SFT),接着使用直接偏好优化(Direct Preference Optimization, DPO)或赔率比偏好优化(Odds Ratio Preference Optimization, ORPO)等方法进行优化,以产生一个训练好的模型。图2B展示了一个替代流程,其中在CPT、SFT和优化(例如DPO、ORPO)之后,模型通过与另一个微调模型(例如一个通用模型)合并而得到进一步增强。我们注意到,模型合并可以在不同的训练阶段进行,例如在CPT、SFT或最终阶段之后。

表1总结了我们探索的模型开发方法、使用的数据处理类型以及每种方法的简要描述。

表1总结了我们探索的模型开发方法、使用的数据处理类型以及每种方法的简要描述。

图2:模型训练、合并和评估阶段。A面板:传统的训练流程,其中基础模型经历了持续预训练(CPT),然后是监督式微调(SFT),接着使用直接偏好优化(DPO)或赔率比偏好优化(ORPO)等方法进行优化,以产生一个训练好的模型。可以在每个阶段对模型进行评估,例如使用SFT结果进行基准测试。B面板:一个替代流程,其中在CPT、SFT和优化(例如DPO、ORPO)之后,模型通过与另一个微调模型(例如一个通用模型)合并而得到进一步增强。合并可以在不同的训练阶段进行,例如在CPT、SFT或最终阶段。

图2:模型训练、合并和评估阶段。A面板:传统的训练流程,其中基础模型经历了持续预训练(CPT),然后是监督式微调(SFT),接着使用直接偏好优化(DPO)或赔率比偏好优化(ORPO)等方法进行优化,以产生一个训练好的模型。可以在每个阶段对模型进行评估,例如使用SFT结果进行基准测试。B面板:一个替代流程,其中在CPT、SFT和优化(例如DPO、ORPO)之后,模型通过与另一个微调模型(例如一个通用模型)合并而得到进一步增强。合并可以在不同的训练阶段进行,例如在CPT、SFT或最终阶段。

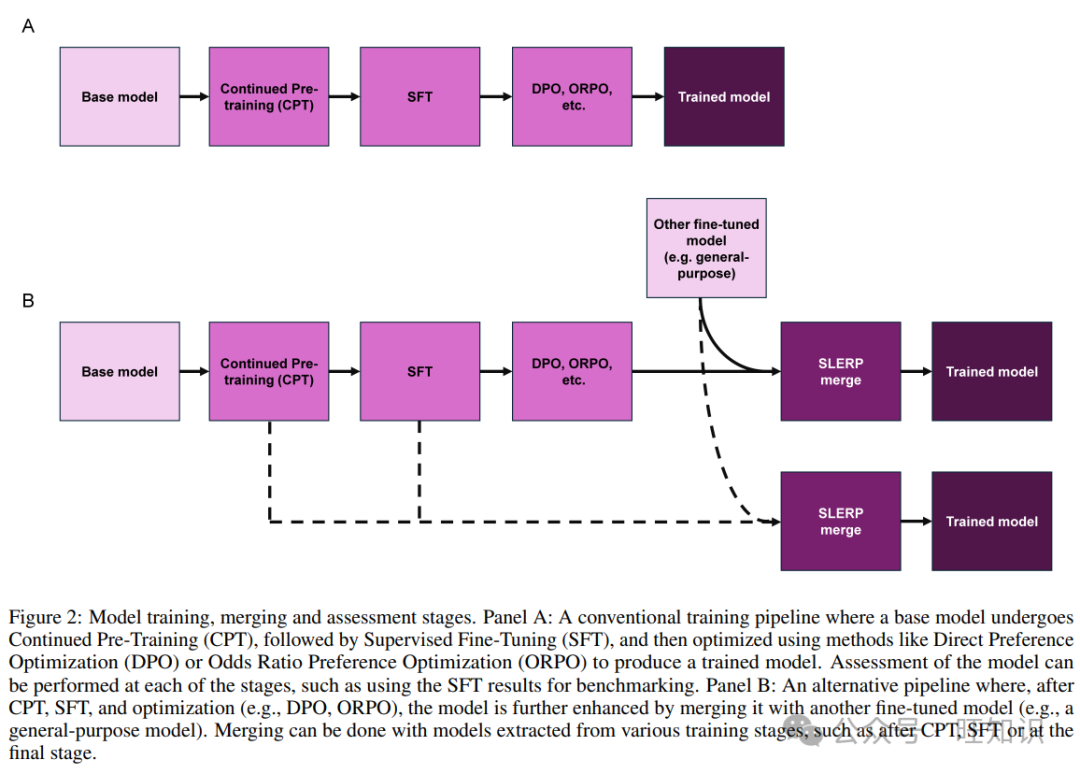

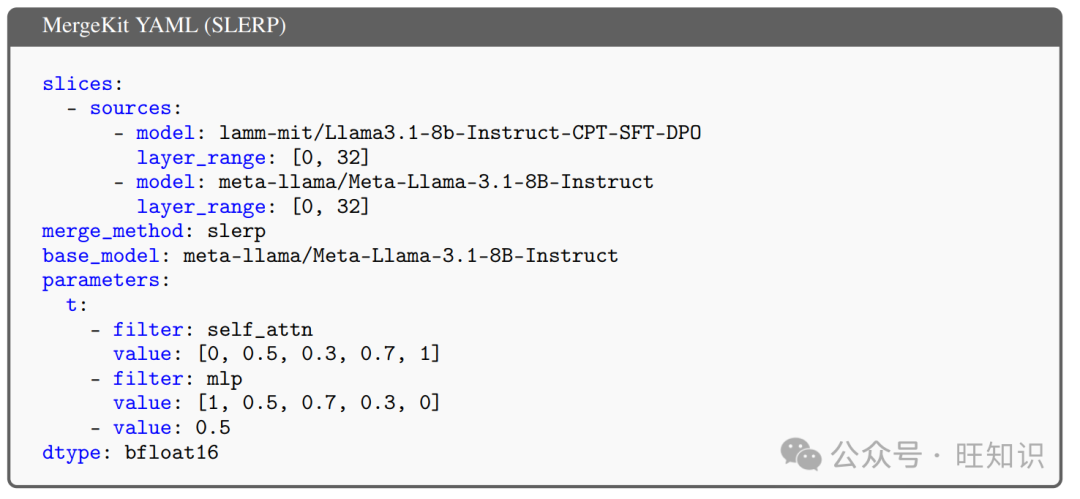

对于分析的目的,我们深入了解了模型合并策略的细节。在这项工作中,我们专注于(球面线性插值(Spherical Linear Interpolation, SLERP),详细信息请参见材料和方法,第4节),因为我们发现它是最有效的方法。SLERP最初是在计算机图形学领域引入的一种数学技术,用于平滑插值旋转,这些旋转由四元数表示。SLERP已经在需要平滑转换方向或状态的各种领域中找到了广泛的应用,包括机器人技术、物理模拟以及实时图形。例如,在机器人技术中,SLERP用于旋转的实际参数化,允许无缝的运动规划和控制。在物理模拟和计算机图形中,SLERP对于可视化和动画旋转至关重要,它以保持运动的连续性和平滑性的方式呈现【32, 33】。通过保持插值状态之间的几何关系,SLERP确保转换既平滑又物理上有意义,使其成为需要精确和连续插值的场景中的有用工具。图3展示了SLERP(与线性插值,LERP)的基本概念,视觉上。这种策略的一个关键方面是,平滑的非线性路径有助于保持模型参数的底层结构。在这个上下文中,球体代表了模型参数空间的固有结构,通过保持参数之间的几何关系,SLERP确保插值尊重这个原始结构,不会像线性组合的点那样穿透它,从而导致更有意义和连贯的能力融合,而不是随机的、无结构的变化。由于合并的点都与模型几何(即,它们位于这里用于演示的球体上)一致,并且因为它们实现了以前未访问过的新的点,可能会解锁新的特征和能力。

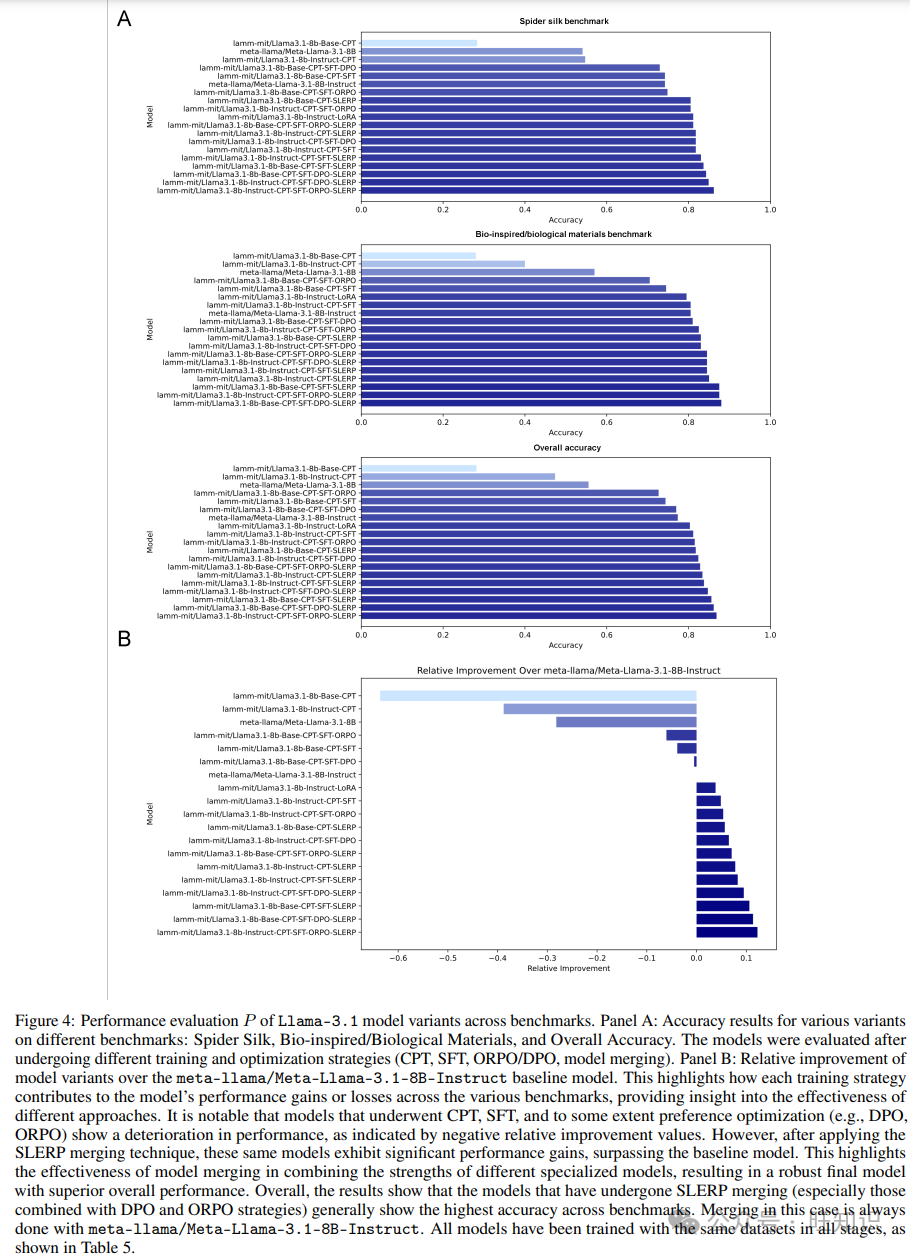

在接下来的部分中,我们将展示使用不同模型家族和训练/合并策略(有关训练、模型、数据集和评估基准的详细信息,请参见材料和方法)进行的一系列评估实验的结果。图4描述了Llama-3.1模型变体在基准测试中的一系列性能评估。我们使用两个基础模型作为我们训练的基础。首先,meta-llama/Meta-Llama-3.1-8B,这是Llama家族的基础模型,尚未进行微调和对齐。其次,meta-llama/Meta-Llama-3.1-8B-Instruct模型已经进行了微调和对齐,以进行问答互动,以及一系列其他能力。除了LoRA案例,我们所有的实验都包括CPT(有关训练阶段和使用的缩写的概述,请参见表1)作为第一步,目的是赋予基础模型来自我们的材料科学论文语料库的领域知识,以及来自科学研究的提取、提炼和处理的数据。然后我们实施了一系列变体,如仅CPT、CPT-SFT、CPT-SFT-ORPO和CPT-SFT-DPO。在每个阶段,我们还与meta-llama/Meta-Llama-3.1-8B-Instruct模型一起实施了模型合并。总体而言,结果揭示了经历了SLERP合并的模型(特别是那些结合了DPO和ORPO策略的模型)通常在基准测试中显示出最高的准确性。没有模型合并的最佳策略是Instruct-CPT-SFT-DPO策略。

我们现在使用Mistral-v0.3模型变体在基准测试中进行相同系列的实验。与之前的一组结果一样,我们使用相同的数据集进行所有案例,并展示了非合并案例以及与mistralai/Mistral-7B-Instruct-v0.3模型的合并。图5描述了这种情况下跨基准的性能评估的概述。与之前一样,结果表明,这些经历了SLERP合并的模型通常在基准测试中显示出最高的准确性。没有模型合并的最佳策略是Base-CPT-SFT策略,尽管Instruct-CPT-SFT策略的性能非常相似。

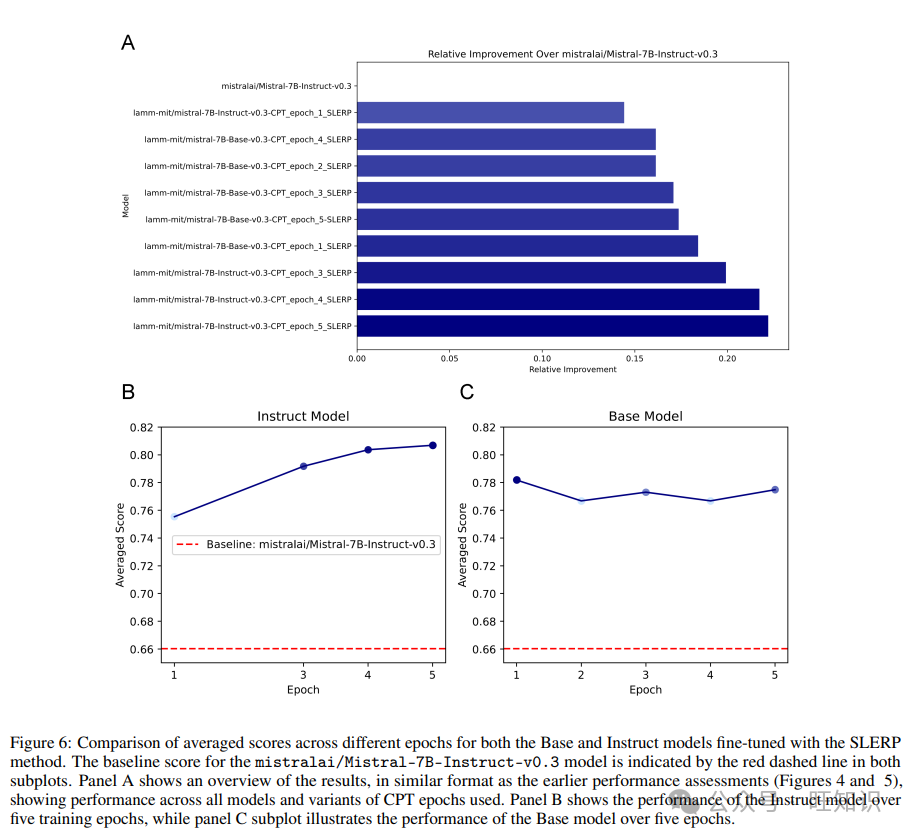

CPT阶段涉及五个训练周期。为了探索这一阶段训练周期数量的影响,我们计算了不同训练周期的直接CPT-SLERP合并对Mistral模型的性能。值得注意的是,图5中评估的原始合并(以及SFT、DPO/ORPO训练阶段)是基于第五个训练周期的CPT结果。图6描述了不同训练周期的平均分数比较,对于基础和指令模型,使用SLERP方法。图6A显示了结果的概述,格式与早期的性能评估类似,显示了所有模型和使用CPT周期的变体的性能。图6B显示了指令模型在五个训练周期中的性能,而图6C的子图展示了基础模型的性能。我们可以看到,指令模型在每个训练周期中都表现出一致的性能提升,到第五个训练周期达到最佳分数,表明它从持续训练中显著受益。相比之下,基础模型显示出更加波动的性能,其最高分数在第一个训练周期,随后略有下降,到第五个训练周期只有轻微的恢复。这表明,尽管基础模型一开始就很强大,但随着额外训练的进行,它并没有一致地改进,可能表明了一个饱和点。然而,两个模型都持续超越了原始的mistralai/Mistral-7B-Instruct-v0.3模型设定的基线分数,强调了SLERP方法的有效性,与早期结果一致。指令模型相对于基线的更大幅度的改进突出了其在指令调整任务中的稳健性,使其成为此类应用的首选,特别是当可以进行扩展微调时。

2.1 模型合并关键因素的详细分析

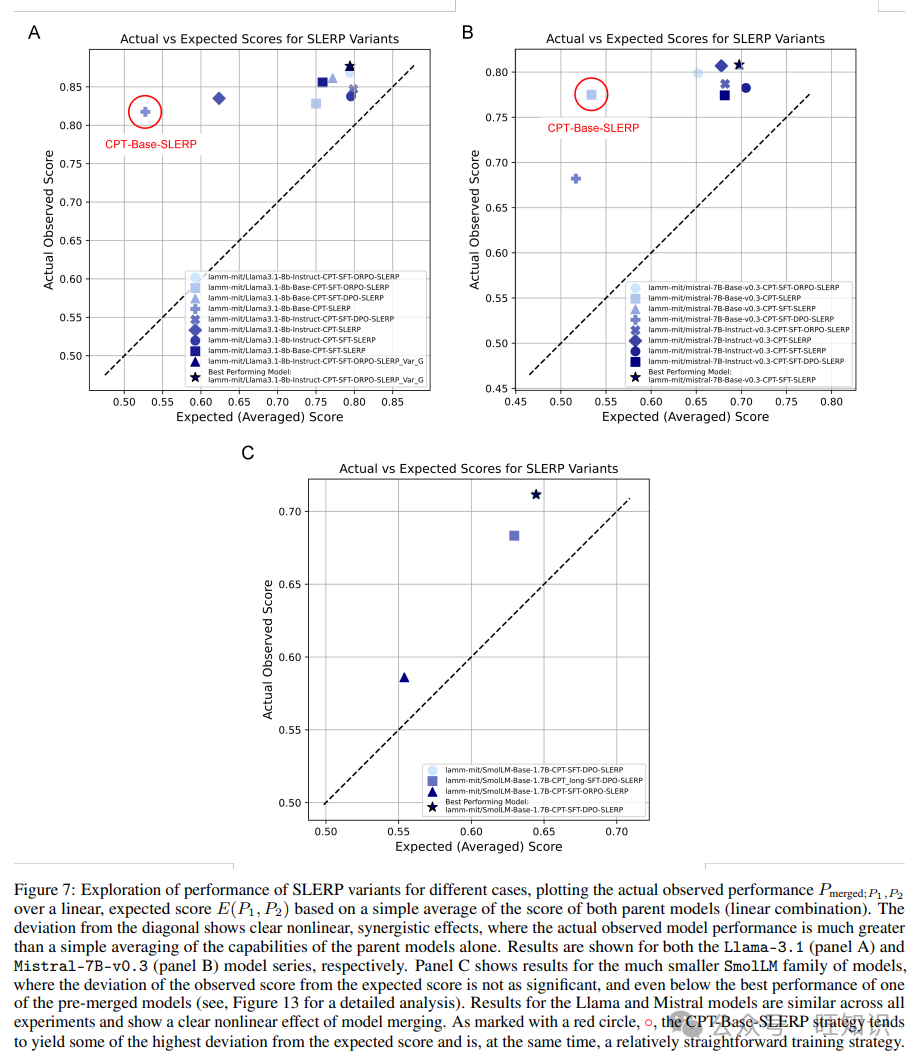

正如图4和5中的结果清楚地揭示的,SLERP似乎显著提高了模型性能,这归功于它尊重参数空间的几何属性的能力。然而,这一分析尚未揭示我们是否具有显著的协同效应。为了检验这一点,我们以不同的方式绘制结果,比较实际测量的性能与通过简单地平均两个父模型的分数计算出的预期性能。为了正确定义所有关键变量,合并模型的性能定义为Pmerged;P1,P2(通过基准测试测量),而预期的平均分数E(P1, P2)计算为两个父模型性能的线性平均值:E(P1, P2) = (P1 + P2) / 2

使用这些指标,图7展示了不同情况下SLERP变体性能的详细探索,绘制了实际观察到的性能Pmerged;P1,P2与基于两个父模型(线性组合)的简单平均分数E(P1, P2)的预期分数。值得注意的是,与对角线的显著偏差揭示了非线性的协同效应,实际观察到的模型性能远远大于父模型能力的简单平均。结果分别显示了Llama-3.1-8B和Mistral-7B-v0.3模型系列,分别用于各种训练策略和数据集。我们发现结果对于两个模型是相似的。在分析中可以看到的一个重要区别是,对于Llama模型,表现最好的模型(lamm-mit/Llama3.1-8b-Instruct-CPT-ORPO-SLERP)是基于Llama Instruct模型的,而对于Mistral模型(lamm-mit/mistral-7B-Base-v0.3-CPT-SFT-SLERP),它是基于Mistral基础模型的。

为了更好地理解观察到的效应背后的机制,我们简要讨论了SLERP合并的数学原理。与线性插值不同,后者假设了一个平坦的欧几里得空间,SLERP通过在单位球面上的曲线路径上插值来探索更丰富的参数空间(我们也参考了图3)。这种方法允许SLERP揭示可能代表比任一模型单独更有效的参数组合的参数空间区域。SLERP进一步平衡了每个模型学到的专业知识,结合它们的优势,而不是简单地平均它们。通过避免线性插值可能穿过的高损失区域,SLERP确保了更平滑的过渡,可能导致合并模型更好的泛化。SLERP的非线性路径还考虑了参数之间的复杂相互作用,这可以揭示简单线性组合会错过的有益相互作用。此外,SLERP可能作为一种正则化形式,防止对单一模型训练数据的特异性过度拟合,从而增强泛化。最后,SLERP有助于减轻灾难性遗忘的影响,保留一个模型在另一个模型之后进行微调或训练时的知识。这些因素结合起来,使SLERP成为模型合并的强大工具,导致合并后的模型通常比任一原始模型单独表现更好。

因此,我们认为SLERP在合并模型中的观察到的有效性可以归因于其通过探索参数空间的球面几何来增强参数之间的非线性相互作用的能力。给定两组模型参数θ1和θ2,每个参数可以被视为高维空间中的一个向量。SLERP执行的插值尊重这个空间的曲率,允许参数组合不仅仅是线性的,而是涉及更深层次的非线性协同作用(见图3)。考虑参数θ1和θ2由神经网络的给定层中的各个组成部分θ1,i和θ2,i组成。SLERP将这些参数组合如下:θi,merged = ∥θ1∥1−t∥θ2∥t sin((1 − t)ω) / sin(ω) ˆθ1,i + sin(tω) / sin(ω) ˆθ2,i

这种组合允许θ1,i和θ2,i之间的相互作用是非线性的。例如,如果θ1,i和θ2,i代表网络中连接到不同特征的权重,它们的球面组合可以激活一个在任一模型单独不存在的新特征ϕi:ϕi = f (θi,merged · xi)

其中xi是输入特征,f(·)是激活函数。参数的非线性组合可能导致新的行为或能力,因为插值参数可能以单个模型无法实现的方式协同增强或抑制特征。

SLERP通过保持参数向量之间的角关系来避免破坏性干扰,这可以防止任一模型学到的专业特征的丢失。SLERP通过球面对称性引入了正则化效果,平滑了模型之间的过渡,并使合并模型能够更好地泛化。这个过程通常会导致新能力的出现或性能的改进,这是任一原始模型所不具备的。

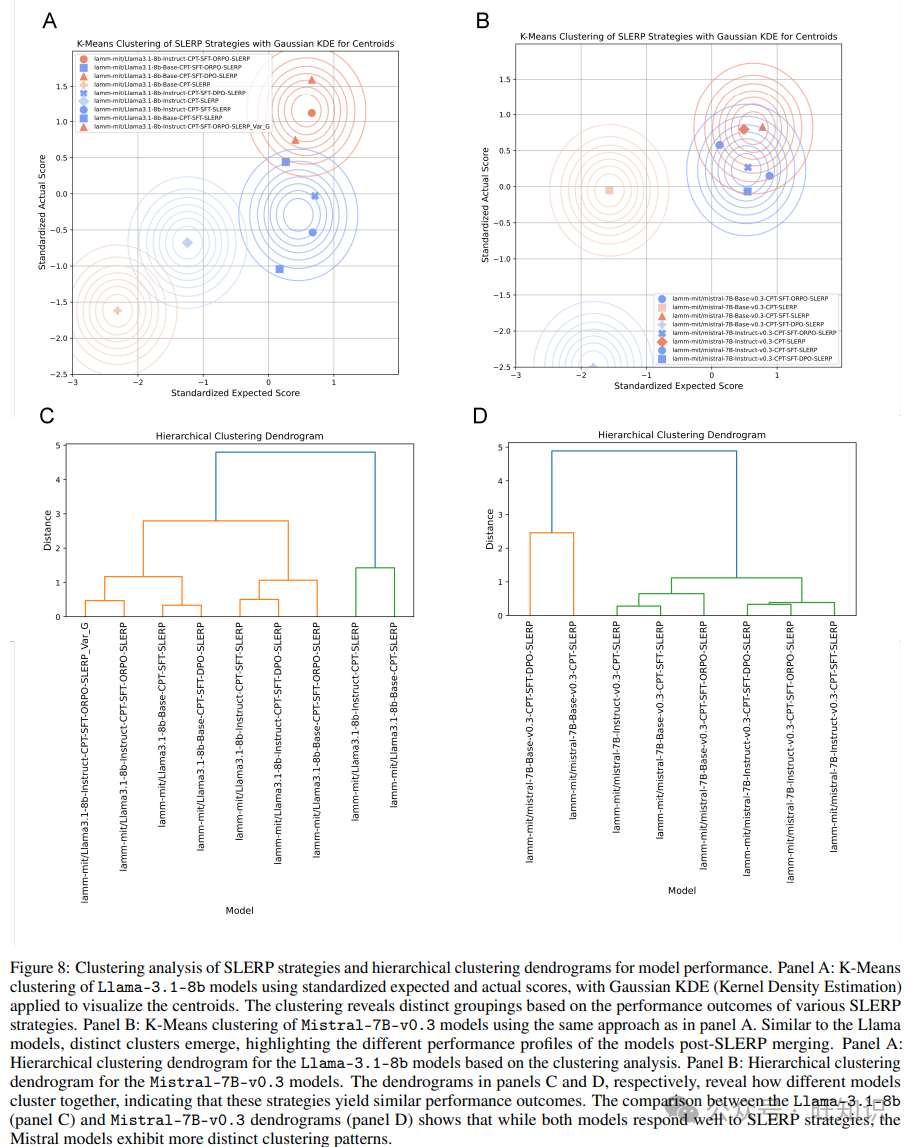

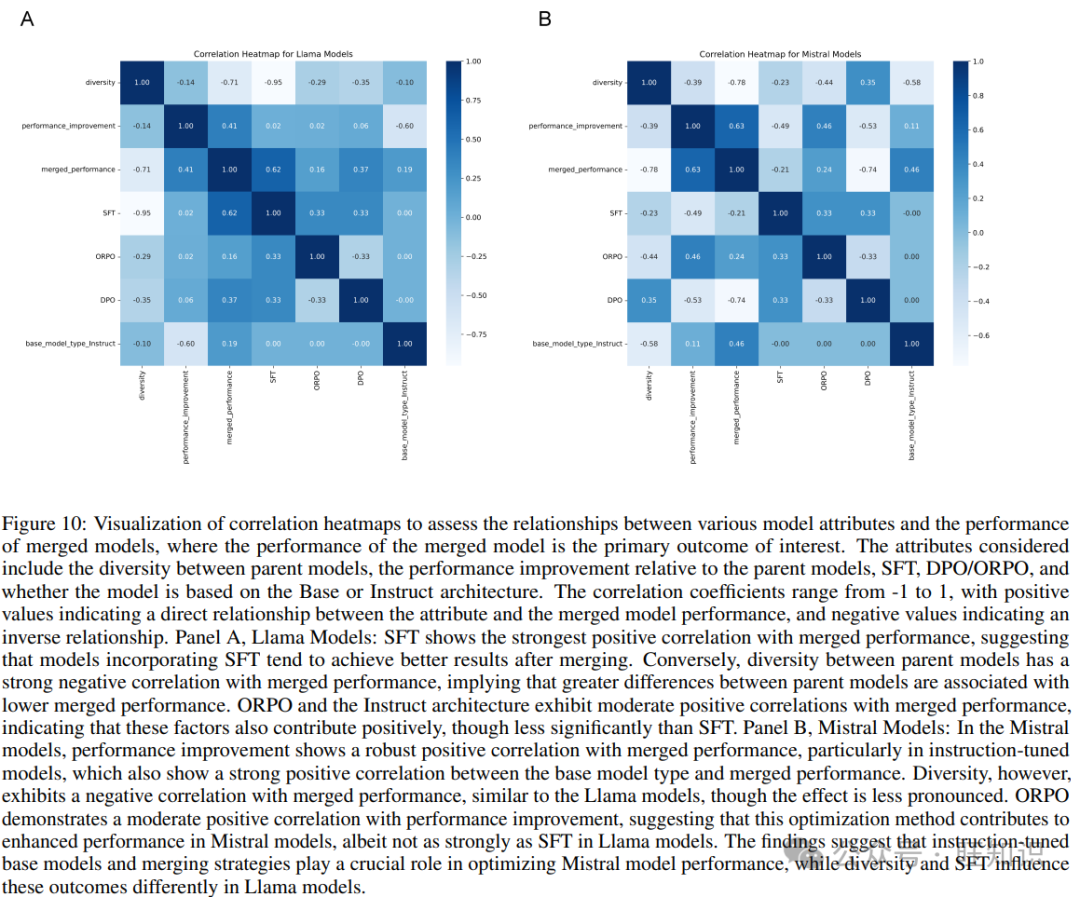

我们通过聚类分析来检查使用SLERP策略的变化和潜在趋势。图8提供了应用于Llama-3.1-8b和Mistral-7B-v0.3模型的SLERP策略的全面聚类分析,以及它们对性能的影响。我们探索了两种方法。首先,K-Means聚类,这是一种基于划分的方法,通过最小化数据点与聚类中心之间的距离,将数据分组到预定数量的聚类中,提供了基于预期和实际性能的模型自然分组的洞察。其次,我们使用层次聚类,这是一种聚合方法,创建树状结构,即树状图,显示模型在不同相似性水平上的嵌套关系,揭示数据的层次组织和潜在的子分组。

图8A说明了使用标准化预期和实际分数对Llama-3.1-8b模型进行K-Means聚类的分析,应用高斯KDE(核密度估计)来可视化质心。分析揭示了与不同SLERP策略相对应的不同分组,表明特定的合并技术产生了密切相关的性能结果。图8B展示了使用相同方法对Mistral-7B-v0.3模型进行的类似K-Means聚类。在这里,也出现了明显的聚类,表明SLERP策略显著影响了模型的性能概况。值得注意的是,与Llama模型相比,Mistral模型中观察到的聚类模式更加明显,这表明Mistral架构可能对这些优化和合并策略更敏感。

在Llama和Mistral模型中,K-Means分析清楚地划分了两个基于性能的聚类。采用多种微调策略的模型,尤其是ORPO,一致地形成了具有更高实际分数的聚类,超过了依赖于更简单策略的模型。这表明微调过程的复杂性和彻底性在实现更好的模型性能方面起着关键作用,如聚类结果所示。接下来我们探索层次聚类,以更好地细分这些区别。

为此,我们使用树状图分析。树状图是一种树状图,显示了通过层次聚类生成的聚类安排。这种可视化有助于阐明模型之间的关系,相关性较高的模型(在性能方面)聚集在一起。树状图揭示了采用类似训练策略的模型被分组到不同的子聚类中,突出了这些方法在塑造模型性能方面的有效性。图8C介绍了基于聚类分析的Llama-3.1-8b模型的层次聚类树状图,图8D为Mistral-7b模型。树状图展示了不同模型如何聚集在一起,表明这些策略产生了相似的性能结果。比较Llama-3.1-8b(图8C)和Mistral-7B-v0.3树状图(图8D)时,很明显,尽管两种模型都对SLERP策略反应良好,但Mistral模型显示出更明显的聚类模式。

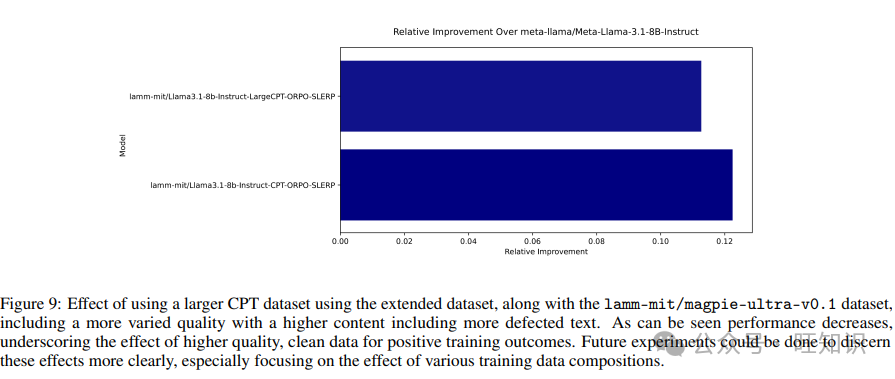

图9展示了使用扩展数据集时的影响,该数据集包括8000篇论文,但格式更加多样,包括更多有缺陷的文本,用于训练Llama系列。可以看到,性能下降,强调了高质量、干净数据对积极训练结果的影响。如前所述,扩展数据集是使用PDF2Text和Nougat OCR构建的;我们发现这些方法产生了更多变化的文本质量。虽然Nougat能够成功地以标记格式呈现方程,但它也导致了未知符号、页面断裂、重复字符和其他缺陷的相对频繁出现。这些方法在将数据进一步处理成问答对或摘要、合理解释等时并未引起问题,但对CPT有明显的负面影响,因为数据是以原始格式提供的。

同样,对Mistral系列模型进行了类似的扩展数据集测试。在原始集成数据集上训练的变体实现了最佳的整体基准0.81,而在扩展数据集上训练的变体实现了0.80。这些结果表明,未来的实验可以评估这种特定数据集变化对该模型架构性能的影响。我们将此留作未来的工作;注意到模型合并和使用基础与指令模型作为基础的总体效应是稳定的,但在哪种确切策略产生最佳结果方面存在差异:对于Llama和Mistral模型,分别是Instruct-CPT-SFT-ORPO-SLERP和Instruct-CPT-ORPO-SLERP。这些观察结果因提示的影响而变得更加复杂,提示可能会使结果向一个方向或另一个方向倾斜。然而,一个总体主题是,SLERP合并始终表现出色。对于一种简单且计算有效的微调策略,Instruct-CPT-SLERP程序可能是最佳的整体选择。虽然它并不总是为所有场景提供最佳性能,但它通常提供强大的性能。差异表明,细致的基准测试和提示工程可能至关重要。

2.2 用非常小的LLMs进行对比评估

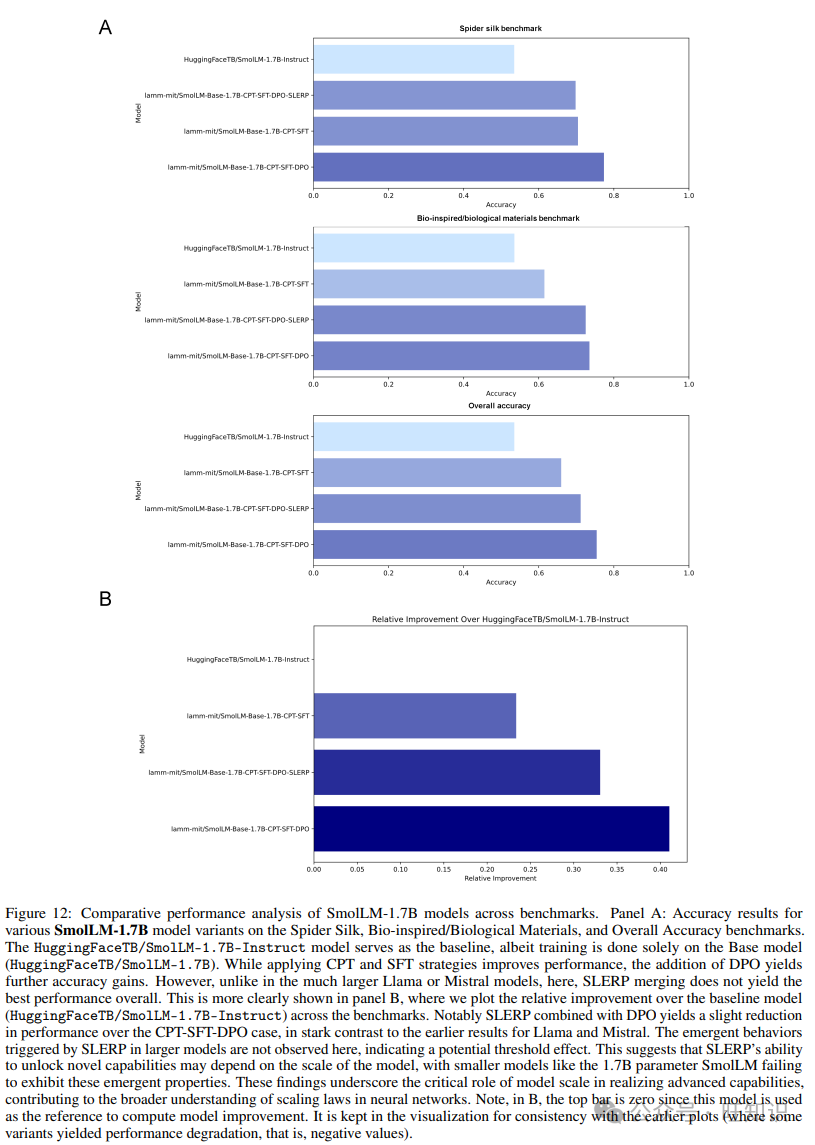

虽然前面研究的模型规模适中,大约7-8十亿参数,但最近的研究已经产生了更小但有用的模型,这些模型可能特别适用于边缘计算应用,或部署在移动电话或机器人系统等设备上。我们现在检查这些模型是否也显示出由于模型合并而观察到的显著效应。我们使用SmolLM模型系列进行这项分析,特别是具有17亿参数的模型。这个选择部分是由于模型、训练策略和训练数据的完全开放访问。与前面的分析一样,我们从基础模型开始,依次应用CPT、SFT和DPO(我们发现对于这个小模型,DPO比ORPO更有效)。尽管从未达到经过微调的7B或8B模型的绝对性能水平,但在几乎所有微调案例中,我们发现SmolLM的CPT-SFT-DPO版本是最高性能变体。

如图12所示,虽然我们在7B和8B参数范围内的大型语言模型中观察到了显著的新能力出现,但在较小的模型中,如具有17B参数的模型,这些新能力并未出现。这可能表明存在阈值效应,SLERP解锁新能力的潜力取决于模型规模。较小的模型可能缺乏与较大的7B到8B模型相同的复杂性,后者在参数空间和能力方面特别丰富,尤其是在推理和知识回忆方面。这些发现强调了模型规模在实现新属性中的重要性,并为神经网络的缩放定律提供了关键见解。我们的结果有助于更广泛地理解神经网络的缩放定律,突出了实现高级能力的条件。图7C中概述了观察到的性能超过预期、平均性能的基线模型。

2.3 进一步量化所有模型架构中模型合并的效果

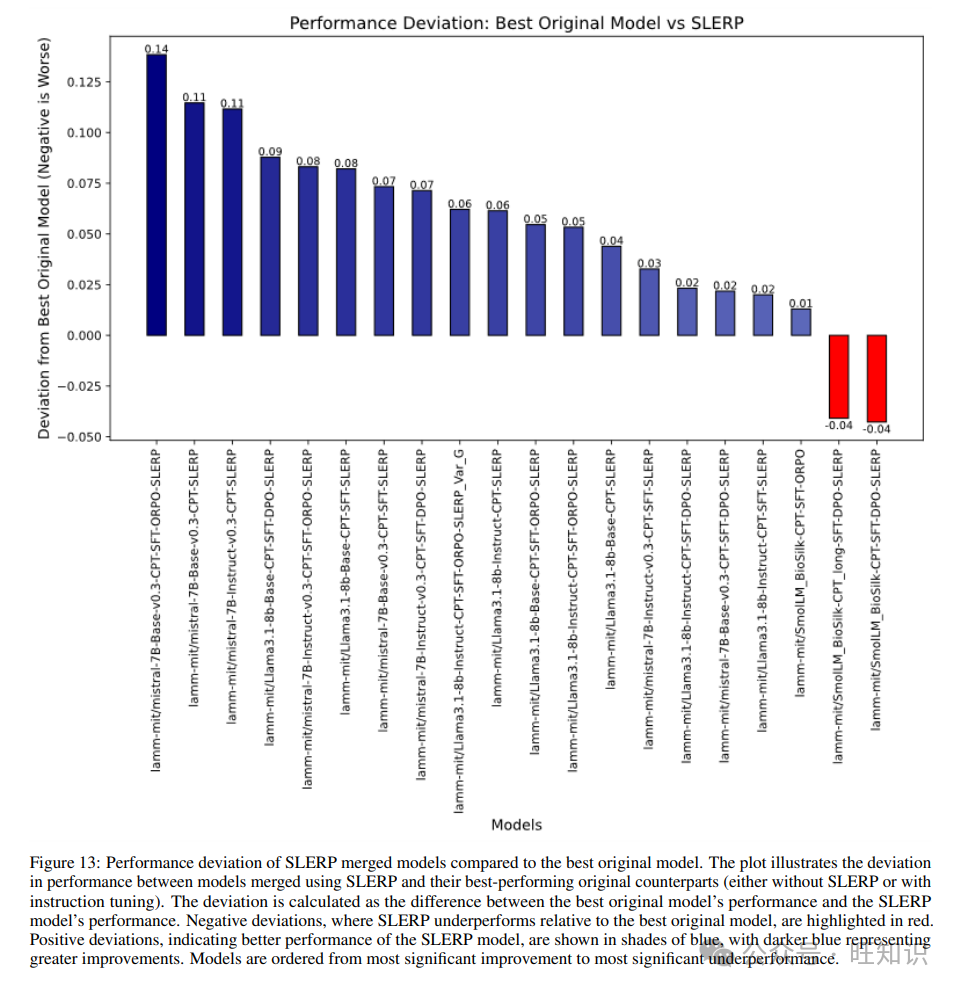

为了更好地理解模型合并是否以及在多大程度上提高了使用SLERP合并的两个模型的性能,我们展示了图13中的分析。该图显示了SLERP合并模型与最佳原始模型的性能偏差。因此,偏差计算为最佳原始模型的性能与SLERP模型的性能之间的差异。因此,负偏差,SLERP相对于最佳原始模型表现不佳,用红色突出显示。正偏差,表明SLERP模型的性能更好,用蓝色阴影显示,更深的蓝色表示更大的改进。

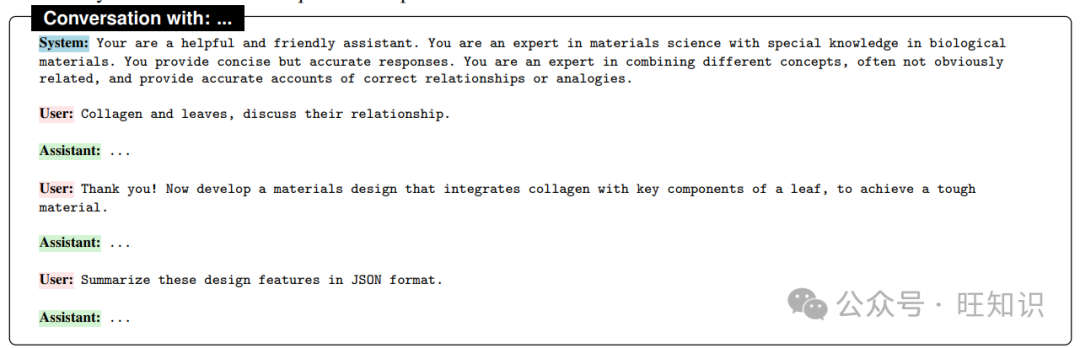

2.4 交互式示例,用于开放式跨材料推理和材料设计任务

在我们的下一个实验中,我们与一组模型进行了交互式对话,使用一致的系统提示和相同的用户输入。我们的目标是测试模型的多轮能力,评估对系统提示和指令的响应能力,以及产生结构化输出(JSON)的能力。我们将进一步评估每个模型的综合质量,沿着一系列标准,包括推理深度、创造力、清晰度以及是否包含定量预测。每个对话如下展开:

文本框4、5、6、7和8展示了人类用户与选定的五种模型(最佳性能模型和DPO训练模型)的对话结果。

所有五个模型都展示了将看似不相关的概念(如胶原蛋白和叶子)联系起来,并提出创新材料设计的强烈能力。输出以丰富的标记格式(注意,这里显示的是原始源)为特点。模型在涉及生物学和材料科学概念方面表现出一致的理解,表明它们在领域特定内容上的微调是有效的。响应之间的差异主要涉及解释的深度、提出的设计的创造力以及自然语言和JSON等结构化格式中的输出清晰度。

如文本框4所示,模型lamm-mit/Llama3.1-8b-Instruct-CPT-SFT-DPO提供了一个组织良好且详细的讨论,清晰地描绘了胶原蛋白和叶子之间的结构和功能相似性。提出的材料设计是稳健的,整合了胶原蛋白基质、类血管通道和类叶肉细胞等关键组成部分。该响应以其对每个组成部分角色的全面分解而著称,从而导致了全面且科学合理的设计。JSON摘要是精确的,有效地反映了所提出设计的结构。

文本框5显示了lamm-mit/Llama3.1-8b-Instruct-CPT-SFT-ORPO-SLERP-Var_G模型的结果。该模型提供了一个更简洁但同样富有洞见的胶原蛋白和叶子分析。材料设计侧重于将胶原蛋白纤维与纤维素微纤维和类叶绿体纳米颗粒整合。这类似于一种创新的方法,以增强材料的属性。该模型在确定设计材料的潜在应用方面表现出色,展示了更广泛的愿景。JSON表示是清晰且结构良好的,有效地总结了设计特点。

文本框6捕捉了lamm-mit/mistral-7B-v0.3-Base-CPT-SFT-DPO模型的结果。响应被发现是全面的,特别关注胶原蛋白和叶子的机械性能。提出材料设计是详细的,整合了胶原蛋白纤维、纤维素纳米纤维、丝素蛋白和基于纳米纤维素的基质。该模型尤其以强调这些组成部分的整合以增强材料的韧性和耐用性而脱颖而出。JSON摘要是全面的,捕捉了设计的复杂性及其潜在应用。

接下来,文本框7展示了lamm-mit/mistral-7B-v0.3-Base-CPT-SFT-SLERP模型的结果。这个结果展示了一个相对直接且不太详细的分析,与其他人相比。虽然胶原蛋白和叶子之间的联系得到了充分的解释,但材料设计更简单,侧重于胶原蛋白纤维、纤维素纳米纤维、叶绿素和果胶。这个响应以其清晰和简单性而著称,使其易于访问,但可能缺乏其他模型所展示的深度。JSON摘要是基础但清晰的,有效地传达了设计的关键元素。

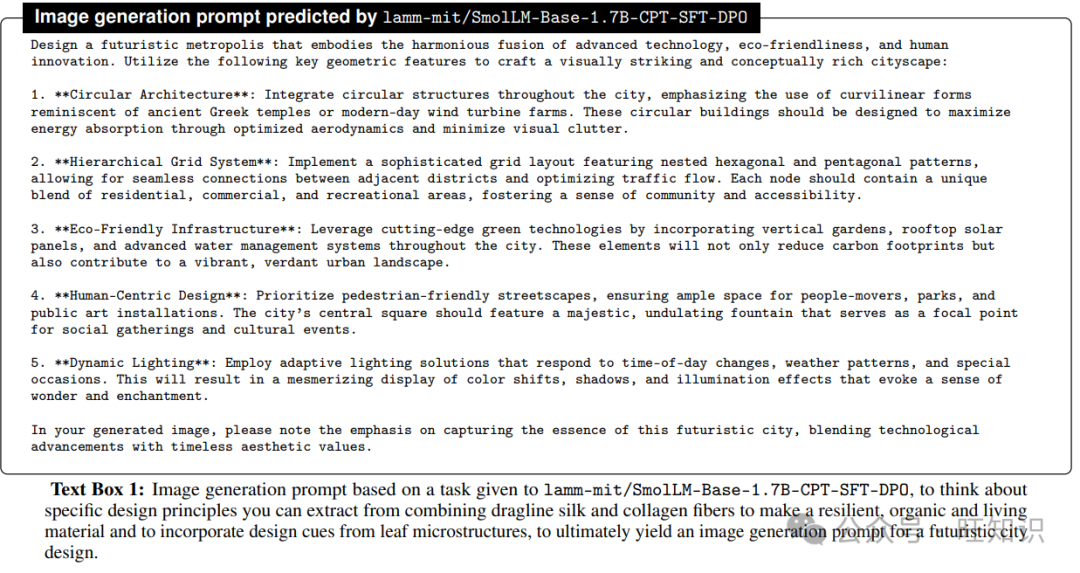

最后,文本框8展示了本研究中最小的模型lamm-mit/SmolLM-Base-1.7B-CPTSFT-DPO的结果。该模型提供了一个创新、详细且具有高度创造力的响应,整合了胶原蛋白纤维、纳米晶体纤维素和海藻酸粘合剂等广泛组成部分,产生了一种创造性地称为“叶珊瑚(LC)复合材料”的材料。该模型在提出具有自愈和形状记忆特性的新型复合材料方面表现出色,反映了相对高水平的创造力和技术理解。JSON摘要是全面的,有效地传达了设计的独特方面及其潜在应用。尽管规模较小,但该模型提供了出色的响应。

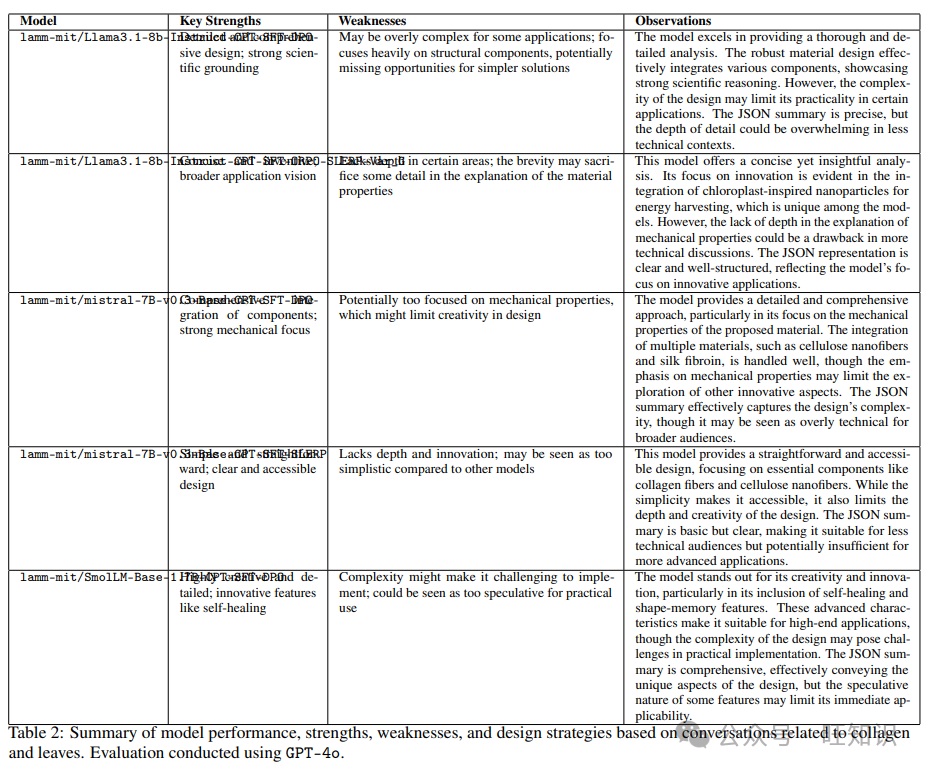

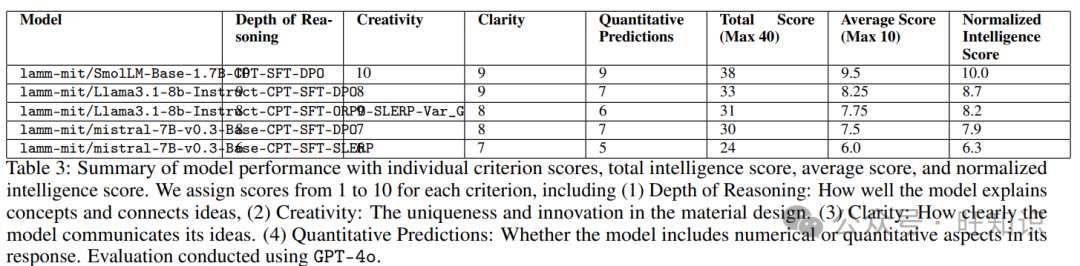

模型性能、优势、劣势和设计策略的总结显示在表2中。我们可以看到,每个模型在不同领域表现出优势,从详细的解释和创新设计到清晰和简洁的JSON摘要。模型之间的深度、创造力和技术细节的差异突出了方法的多样性以及每个模型可能适合不同类型的任务或应用的潜力。总体而言,这些模型为生物启发材料设计领域提供了坚实的基础,用于进一步探索和发展。使用GPT-4o对原始文本进行分析的详细分析显示在表3中,显示了通过与GPT-4o共享原始文本并提示模型识别标准并评估不同版本的分析结果。

表2:基于与胶原蛋白和叶子相关的对话的模型性能、优势、劣势和设计策略的总结。使用GPT-4o进行评估。

表2:基于与胶原蛋白和叶子相关的对话的模型性能、优势、劣势和设计策略的总结。使用GPT-4o进行评估。

表3:模型性能的总结,包括每个标准的个别得分、总智能得分、平均得分和标准化智能得分。我们为每个标准分配1到10的分数,包括(1)推理深度:模型解释概念和连接想法的能力如何,(2)创造力:材料设计的独创性和创新性。(3)清晰度:模型传达其想法的清晰度。(4)定量预测:模型的响应中是否包含数值或定量方面。使用GPT-4o进行评估。

表3:模型性能的总结,包括每个标准的个别得分、总智能得分、平均得分和标准化智能得分。我们为每个标准分配1到10的分数,包括(1)推理深度:模型解释概念和连接想法的能力如何,(2)创造力:材料设计的独创性和创新性。(3)清晰度:模型传达其想法的清晰度。(4)定量预测:模型的响应中是否包含数值或定量方面。使用GPT-4o进行评估。

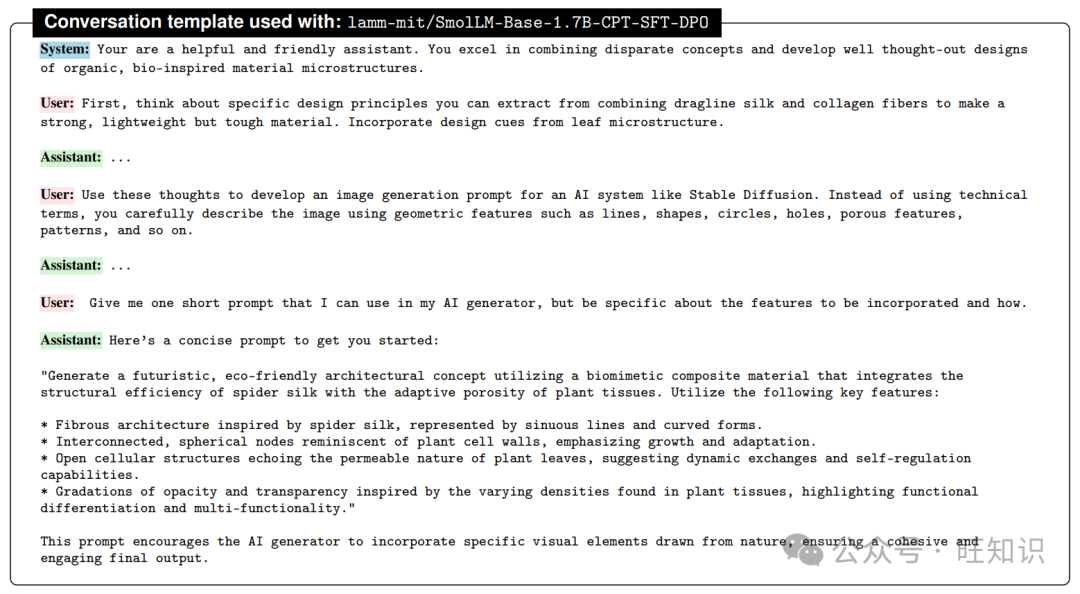

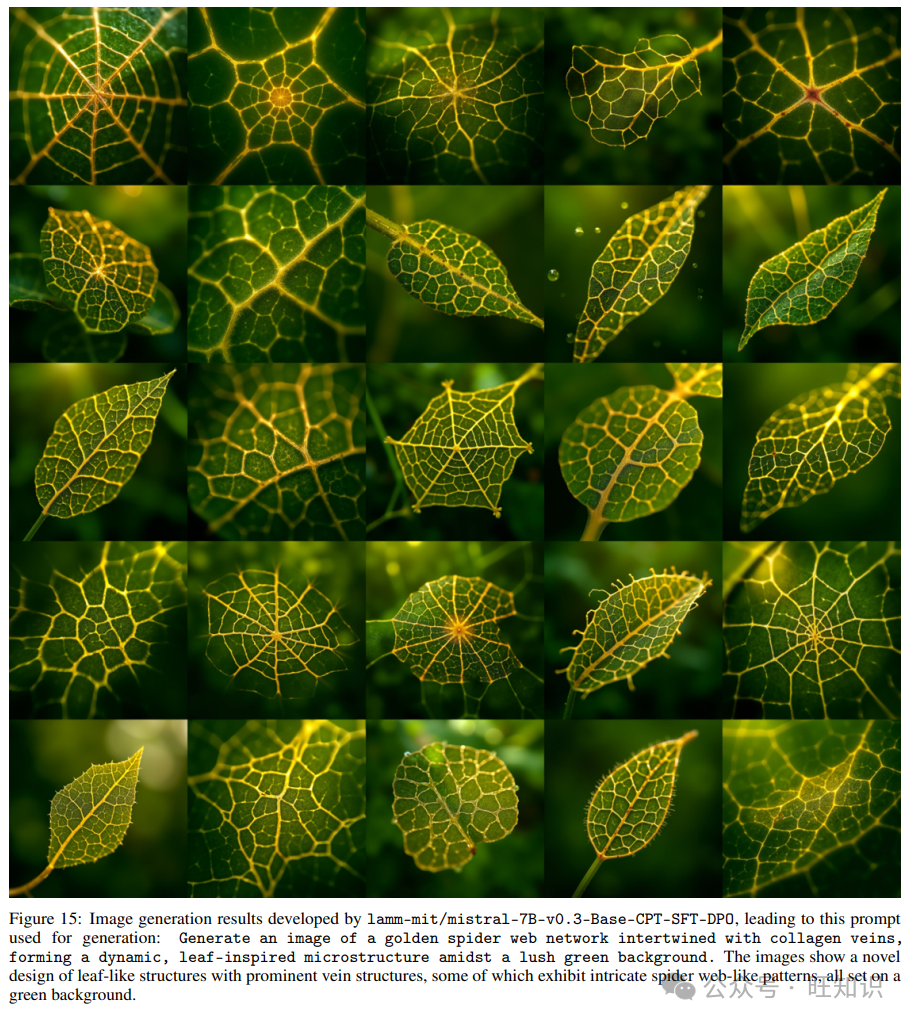

2.5 智能体在图像生成中的使用:跨领域知识整合在材料和城市设计中的应用

我们展示了几个示例,突出了微调后的LLMs的能力和潜力,展示了一个特定的应用在材料设计中。总体目标是探索LLMs如何推理复杂的材料原理,并使用多步骤提示通过多智能体框架中的模型交互来创建图像生成提示。我们注意到,我们基于SmolLM的微调模型在这项任务中表现非常出色,产生了非常创造性的提示,整合了各种想法和概念(强调了其作为创意智能体的潜力)。

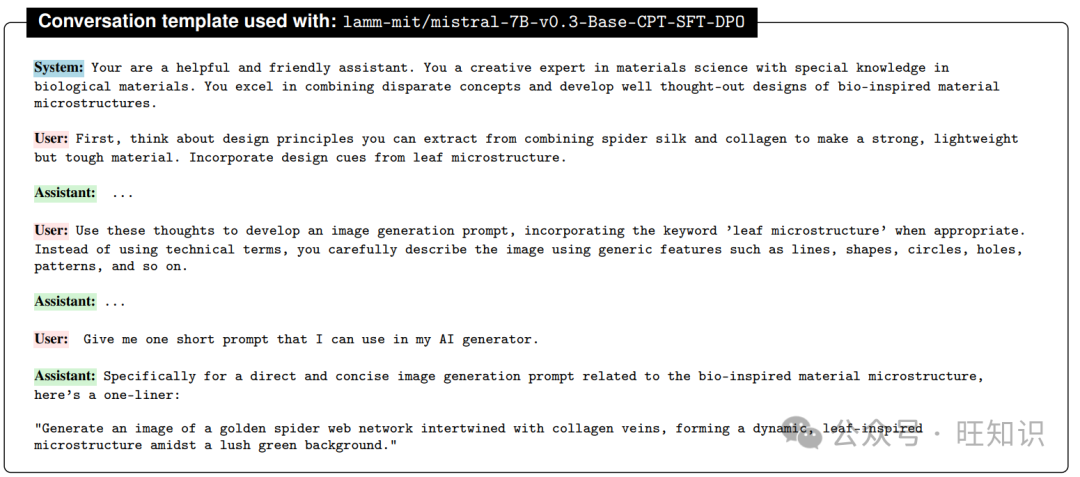

虽然使用了轻微变化的提示来产生不同的例子(这里展示的每个结果都包括所有特征的详细展示),但一般目标是考虑从结合不同生物材料中提取的设计原则。例如,我们要求模型思考如何结合蜘蛛丝和胶原蛋白的设计元素,以制造一种坚固、轻质但坚韧的材料,并从叶子的微观结构中汲取设计线索。这种方法可以直接关注材料微观结构,也可以用来产生跨领域的结果,如建筑理念或城市设计。

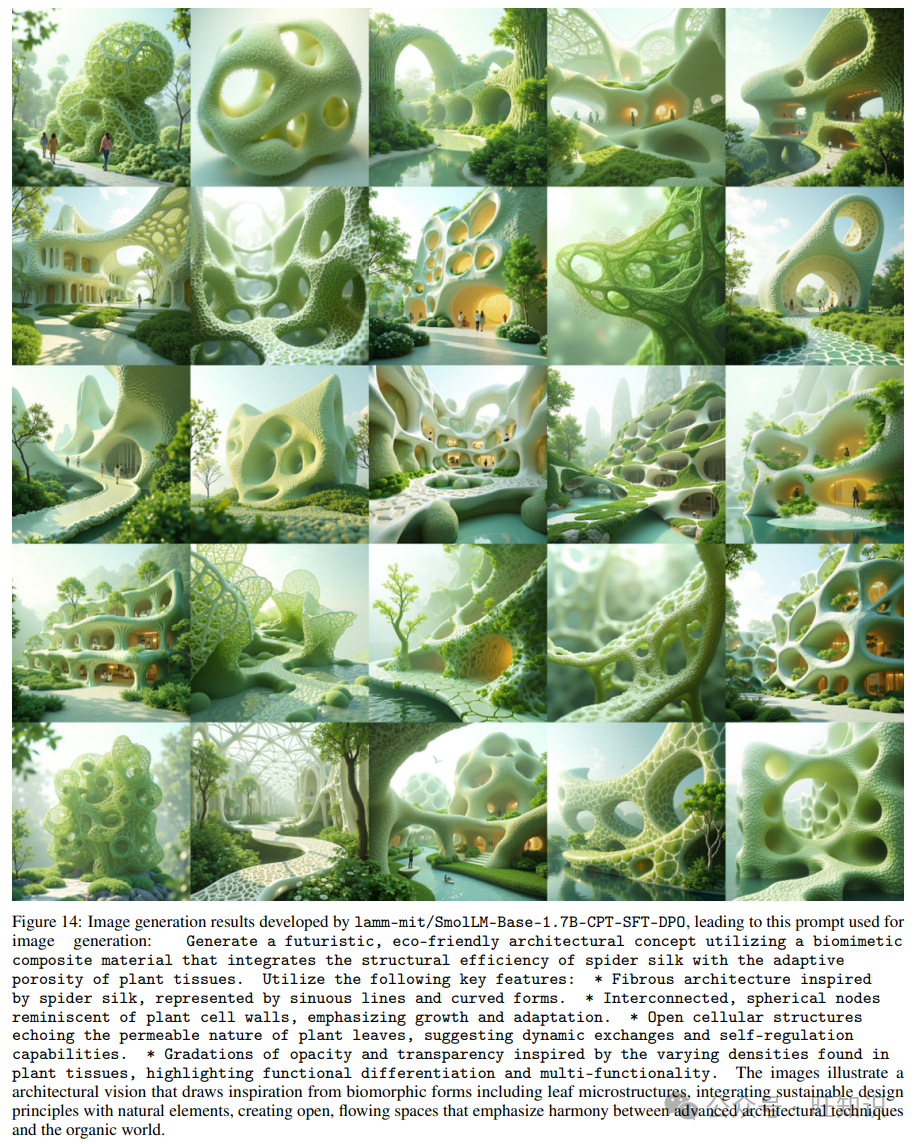

在我们的第一个示例中,我们提示lamm-mit/SmolLM-Base-1.7B-CPT-SFT-DPO模型如下(文本框9显示了整个对话):

图14展示了以这种方式产生的一系列图像。这些图像类似于一个有远见的建筑概念,其中生物形态结构与自然无缝融合,创造了一个未来主义和可持续的环境。这些设计以流体、曲线形式和复杂的格子状框架为特征,唤起有机世界。这些结构与绿色植物整合,强调与环境的和谐,并暗示使用创新的、环保的材料。在一些图像中,这些设计中的人形突出了宜居性和以社区为中心的设计,表明了一个愿景,即技术和自然和谐共存。通过仔细检查生成的设计,进一步表明了叶子微观结构模式的出现,这是由于提示和微调后的生成模型的精细调整能力。

这些设计理念有潜力被实施,强调特定的功能。生物启发建筑的现实生活例子包括“蜂巢”,这是由Heatherwick Studio设计的NUT校园的一栋建筑。其蜂窝结构反映了蜂巢的细胞组织,提供了改进的模块化六边形形式,通过优化气流和通风系统来提高结构效率。另一个引人注目的例子是纽约的“小岛”,它被设计成类似于漂浮的叶子,创造了一个动态的城市景观。该设计显示出对气候变化的适应性,提供了适应水位变化的灵活性。

然而,为了在现实世界中实现这些设计,还需要进一步的研究,这包括研究风效应和考虑整合扩展植物的立面分析,并确保负载和结构完整性,以及选择与绿色植物兼容的材料。

图15展示了以这种方式产生的一系列图像。图像展示了一种新型生物材料的特写视图,突出了它们的复杂静脉图案和微观结构。叶子展示了各种几何静脉排列,从多边形到放射状图案,所有这些都与明亮的黄色到金色静脉形成鲜明对比,背景为绿色叶面。叶子形状和静脉结构的多样性提供了多种结构选择,包括突出的蜘蛛网状图案。图像中的一些叶子图案类似于蜘蛛网或蜘蛛网状结构。这些特定叶子中的静脉形成放射状图案,汇聚于中心点,非常像二维轨道蜘蛛网的结构。这种相似性在一些叶子中尤为明显,其中静脉网络更对称且间距均匀,创造了网状外观。这些蜘蛛网状图案,其中一些类似于各种3D网的投影,如茧网和床单网,为自然设计和仿生学研究提供了有趣的视觉效果。仔细检查生成的图像显示,纹理和深度都被精细捕捉。我们发现柔和但专注的照明突出了这些图案。

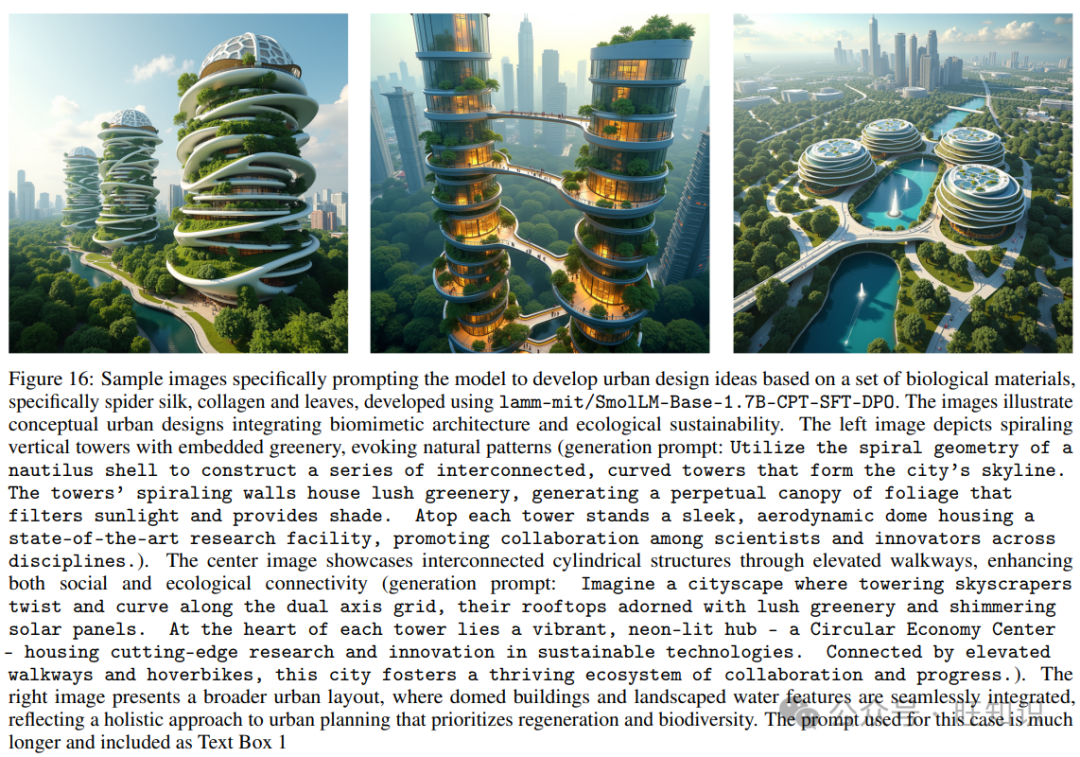

图16展示了一些额外的样本图像,专门提示模型基于一组生物材料,包括蜘蛛丝、胶原蛋白和叶子,开发城市设计理念,由lamm-mit/SmolLM-Base-1.7B-CPT-SFT-DPO开发。这里展示的图像描绘了一种概念性的城市规划方法,该方法将先进的建筑技术与生态整合和可持续性原则相结合。这些结构展示了仿生设计,以螺旋形、有机形式为特征,模仿自然模式,可能受到叶子微观结构的影响。这种设计理念与生物亲和建筑原则一致,旨在通过将自然元素融入建筑环境,重新连接城市环境与自然世界。

几个类似的建筑设计理念已经实现,验证了这些生成概念的潜力。例子包括东京的Azabudai Hills,一个以曲线形种植屋顶为特色的区域;新加坡的CapitaSpring摩天大楼,其立面嵌入了正交条形植物;以及由Stefano Boeri Architetti设计的“垂直森林”,它将住宅建筑与多样的绿色植物整合在一起。然而,仍然有很大的潜力在扩展的城市系统中探索和扩展这些想法,例如,如何连接各个结构,确保它们与其他设施的无缝集成,并与整体城市规划策略保持一致。

将自然融入建筑的理念源于像弗兰克·劳埃德·赖特倡导的有机建筑运动,其中人类居住与自然世界的和谐是最重要的。这里提出的设计,然而,将这一概念推向更远,通过将广泛的绿色植物直接嵌入建筑框架中,创建垂直花园和绿色露台,这些是建筑结构不可或缺的一部分,而不是附属元素。此外,建筑物通过高架走道相互连接,这不仅促进了人类移动,还促进了生态连通性,可能作为城市野生动物的走廊,并有助于生物多样性。这种相互连接性表明了一种系统思考方法的城市设计,其中建筑环境被视为更大生态网络的一部分,而不是孤立的实体。

这些图像中展示的设计理念可能被视为城市规划中的潜在范式转变,我们不仅关注可持续性,还专注于再生设计。这种方法旨在创建不仅最小化生态影响,而且积极恢复和增强自然环境的城市环境。这种模式可能代表了城市生态学的一个重要进步,提出了一个未来,城市作为生活系统运作,与周围生态系统集成并支持它们。需要更多的工作来探索这一点,但这示例说明了如何使用这里开发的方法指导创造性研究和技术发展。

3 结论

本研究解决了特定领域知识微调大型语言模型(LLMs)的基本问题,探索了不同的优化策略和数据集如何影响模型性能,并评估了模型规模和能力的效果。我们的调查集中在一致地应用于不同模型/架构和参数数量的一系列技术,包括持续预训练(Continued Pre-Training, CPT)、监督式微调(Supervised Fine-Tuning, SFT)、直接偏好优化(Direct Preference Optimization, DPO)和赔率比偏好优化(Odds Ratio Preference Optimization, ORPO)。目标是确定这些方法如何影响LLMs的专业化,特别是在工程或科学领域。

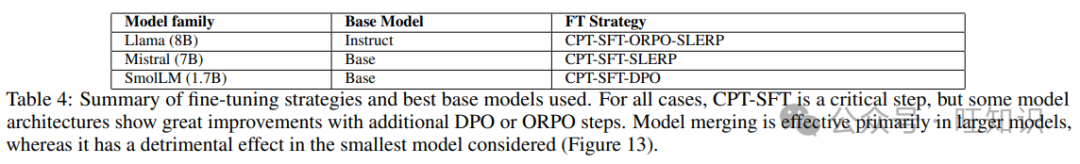

我们研究的一个关键发现是模型规模在微调策略的有效性中起着至关重要的作用。较大的模型,如具有7B和8B参数的模型,不仅在特定领域的任务中表现出显著的性能提升,而且还显示出新能力的突现——这在像1.7B参数的SmolLM模型这样的较小模型中未观察到。这一观察,如图13所示的比较图表明,存在一个阈值效应,即高级优化技术的好处,包括通过SLERP(球面线性插值)模型合并,随着模型规模的增加而显著变得更加明显。Llama和Mistral模型家族之间的差异值得进一步研究。然而,由于缺乏有关训练期间使用的数据集(在预训练和微调期间)的详细信息,以及缺乏有关特定训练方法的详细信息,这些研究受到了阻碍。表4总结了关键见解,包括最有效的方法。

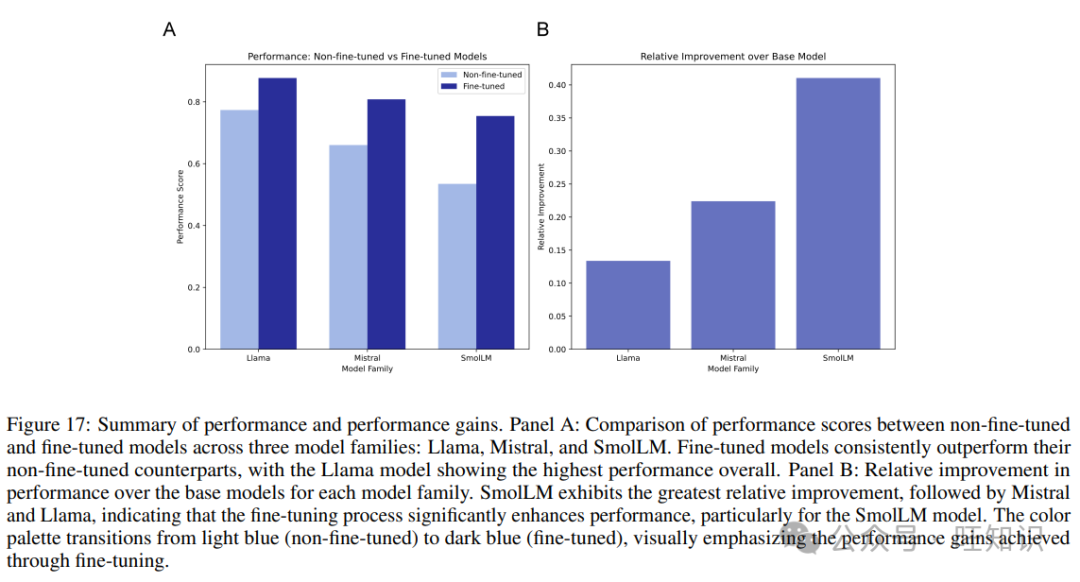

Llama-3.1-8b和Mistral-7B-v0.3模型之间的比较突出了当SLERP与SFT、DPO和ORPO结合使用时,如何有效地解锁协同属性,导致精炼的性能结果,在我们的分析中明显地聚集在一起。然而,这些改进并未在较小的SmolLM-1.7B模型中反映出来,该模型在模型合并下显示出性能下降,强调了规模在实现微调技术的全部潜力中的重要性。图17显示了通过微调在不同模型系列中实现的显著性能提升,强调了像Llama和Mistral这样的大型模型在这些高级技术方面从绝对性能水平上受益更多。

如图17A所示,微调一致地增强了模型性能,Llama在绝对性能得分方面领先。然而,图17B揭示了一个有趣的趋势:尽管SmolLM的基线较低,但其相对于微调的改进最为显著,表明即使较小的模型无法达到其较大对应物的峰值性能,但仍然可以从针对性的优化策略中获得实质性的提升。这种差异性的改进模式强调了模型规模在微调过程的有效性和范围中的关键作用。因此,虽然较大的Llama和Mistral模型更适合利用像DPO和ORPO这样的高级优化技术的全谱,但SmolLM表明,即使是较小规模的模型也可以实现有意义的性能提升,尽管受到其较小容量的限制。

图18显示了性能与预训练令牌数量的关系(注意,SmolLM使用了1万亿,Mistral使用了8万亿,而Llama-3.1使用了15万亿)。虽然这是一项近似分析,因为每个模型/架构都有其独特的特征,但总体趋势是,更多的预训练会产生更好的性能,但也减少了可以通过微调实现的相对改进。这与一般共识一致,即对于基于变压器的模型,随着训练数据和模型规模的增加,似乎有递减的回报,这意味着随着性能的提高,必须使用更大、更好的数据集和更大的模型。

这里报告的结果有助于正在进行的关于微调LLMs的最佳策略的讨论,特别是在需要精确和复杂理解的专业领域。结果表明,虽然CPT和SFT是基础,但应用像DPO和ORPO这样的高级优化方法,特别是当与像SLERP这样的模型合并技术结合使用时,对于在较大模型中实现高性能结果至关重要。数据显示,每个模型都有优化性能的空间,需要对不同的基础模型如何表现以及如何最好地改进它们有基本的了解。总体而言,使用CPT、SFT和ORPO/DPO后跟模型合并可以被视为实现强大领域性能的可行方法。使用CPT和其他步骤往往比像LoRA这样的简单方法产生更好的结果,尽管计算成本要高得多。对于较小的模型,可能不建议进行模型合并,尽管我们建议对模型架构进行实验,以探索这一特定特性,并确定模型规模的阈值,在这个阈值下,新能力显著出现。

还有许多其他参数和角度需要探索。首先,提示的效果。我们在所有实验中保持了一致的提示。然而,每个模型或模型系列可能会对提示做出不同的响应,并且有可能通过提示工程实现额外的性能提升。我们在这里故意没有解决这个问题,因为我们想专注于一个总体的、一致的比较。在一些初步评估中,我们确实注意到对于Mistral模型,CPT-SFT-DPO系列的基准性能相当低;其中仔细检查表明,这可能是由于在遵循指令方面的能力有限,以及回答过长。我们的基准测试在测试不仅领域知识,还测试模型如何遵循指令以某种方式(单个词,如这里所做的)回答问题方面是一致的。对Mistral CPT-SFT-DPO系列的进一步实验可能包括在DPO期间使用更多样化的数据集,包括额外的指令遵循焦点。这些和其他变化留作未来的工作。

我们展示了各种材料特定的模型应用,这些应用超出了问答基准测试,专注于一般推理能力,以整合复杂的、不同的生物材料概念,逐步分析,结构化输出等。与各种模型的一致提示的人类用户对话的结果在文本框4、5、6、7和8中显示。这些人类用户与模型的对话提供了对模型在现实用例中的不同优势和劣势的重要见解。

在此基础上,专注于我们模型的另一个现实世界用例,我们提示LLMs开发图像生成提示,展示了LLMs与图像生成模型管道结合的强大用例(见图14、15和16,从未来主义建筑、生物启发材料微观结构到城市/城市景观设计)。这些研究可以通过引入反馈循环进一步扩展,在多智能体框架中,生成的图像可以由视觉LLMs(例如Cephalo)分析,并将洞察反馈到LLMs中,以改进推理和调整。

未来的研究可以更深入地探讨观察到的突现行为背后的机制,探索如何利用这些机制跨不同架构和领域,也许可以使用统计力学或热力学的工具,这可能为如何模拟多粒子系统的行为提供基本视角。其他工作可以关注可解释性洞察,以帮助理解。此外,了解较小模型的局限性和潜力仍然是一个重要的研究领域,特别是当我们寻求为特定任务微调LLMs而不使用大型模型所需的大量计算资源时。还可以对SmolLM进行更多研究。我们基于SmolLM的结果很有趣,因为它们提供了一个在很小规模上具有合理性能的模型;这个模型可以与上下文学习(如检索增强生成(RAG))结合使用,成为一种有效的工具。

本研究揭示了模型规模和微调策略在开发特定领域LLMs中的微妙作用。通过推进我们对这些动态的理解,我们更接近于解锁AI在专业领域的全部能力。跨参数和变量的高复杂性使得这是一个具有挑战性的领域,提供了许多未来研究的机会。更多的工作可以在改进数据集方面完成。我们发现使用更大的数据集并不一定对下游性能有益。我们还发现了Mistral模型的类似结果,我们没有看到显著的下降,而是几乎相同的性能。结合最近的其他研究,这表明数据质量是一个主要问题,可以通过进一步的蒸馏、处理和可能的过滤数据组件以提高相关性来解决。使用DPO或ORPO特别有趣,因为它提供了改进科学准确性和使模型与特定响应风格(例如,系统地推理,逐步)对齐的途径。数据集策展可以针对这些方面进行更多的实验,以阐明这些对性能的影响。同样,将视觉线索(例如图表、图像、微观结构等)纳入(如最近的工作)可以是数据的另一个来源。

4 材料和方法

我们提供了进行本研究所使用的材料和方法的详细信息。

4.1 数据集策展和处理

用于训练的数据集包括来自生物材料、力学/机械性能和蜘蛛丝广泛领域的科学论文。早期的工作集中在大约1000篇论文上进行训练;在这里,数据集包括原始训练集和额外的约4300篇关于蜘蛛丝的论文。所有训练除非特别说明,否则都使用这个集成数据集。在“扩展数据集”的少数实验中,还包括了约3826篇生物材料相关论文的训练,以探索更大、格式更多样化的数据的影响。这包括了更多的论文,但格式多样,由于使用了效果较差的PDF到文本转换方法,错误数量很大。

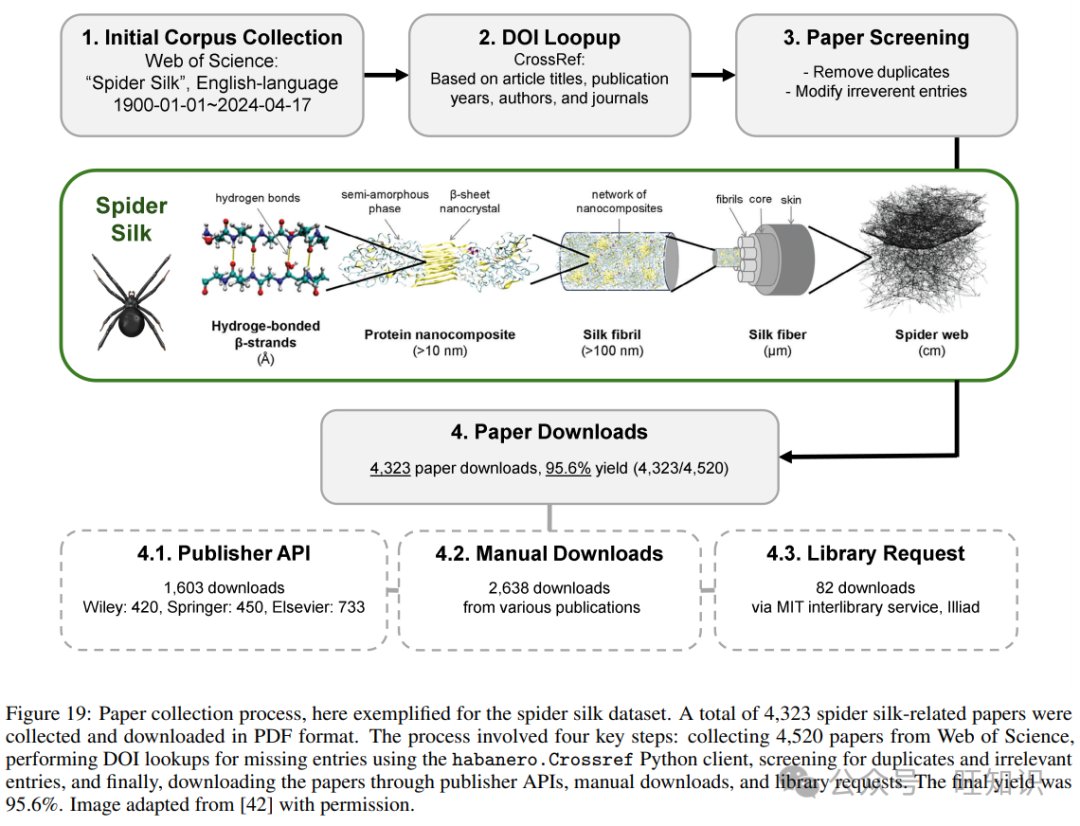

4.1.1 蜘蛛丝材料数据集

我们引入了一个新的数据集,专门针对蜘蛛丝研究。作为第一步,我们使用图19中概述的方法策划了一系列PDF文件。该过程包括四个关键步骤:

-

从Web of Science收集4520篇论文,

-

对缺少条目的条目使用habanero.Crossref Python客户端进行数字对象标识符(DOI)查找,

-

筛选重复和不相关条目,

-

通过出版商API、手动下载和图书馆请求下载4323篇论文。

总共下载了4323篇与蜘蛛丝相关的论文,以PDF格式用于训练。2024年4月17日,从Web of Science搜索引擎收集了4520篇论文,使用关键词“spider silk”。搜索限制在1900-01-01至2024-04-17之间发表的英文文章。对于缺少DOI的收集论文,我们使用habanero.Crossref Python客户端与CrossRef API进行交互,根据文章标题、出版年份、作者和期刊(如有)进行DOI查找。在初始收集后,对论文条目进行了筛选,然后下载。最终,成功下载了4323篇PDF格式的论文,收率为95.6%。其余论文由于重复、不相关内容或不可用而未下载。

在4323篇论文中,1603篇通过三个出版商的API下载(Wiley 420篇,Springer Nature 450篇,Elsevier 733篇),2638篇手动下载,MIT Illiad提供的98个图书馆请求中有82个被提供。所有收集的论文详细信息都在相应的补充信息(‘SI_source_articles_1.csv’)中总结,以便于识别。

4.1.2 生物材料数据集

原始的1034篇生物材料论文数据集在早期工作中描述。原始生物材料数据集的详细信息在补充信息‘SI_source_articles_2.csv’中总结。还创建了一个更大的次要数据集,我们称之为“扩展数据集”。这个扩展数据集包括3826篇生物材料相关论文,涵盖了比之前搜索词“生物材料机械层次结构”更广泛的搜索词,包括“生物材料机械结构”。在结果中,只有部分条目是从API支持的出版商那里检索的,包括Elsevier的2159篇文章,Wiley的749篇文章,和Springer Nature的998篇文章,总共3826篇文章。这些文章也以纯文本格式通过出版商API或使用python包PDF2TEXT处理PDFs检索,导致通常更不可预测和多样化的文本和格式。其余文章可以通过遵循先前建立的程序检索,理想情况下全部以PDF格式,但对于本研究的范围,更大的数据集为我们提供了一个短暂的了解训练时使用更大、更多样化数据集的影响。关于扩展生物材料数据集的详细信息可在‘SI_source_articles_3.csv’中找到。

4.1.3 集成数据集

除非特别说明,所有训练都使用原始1034篇生物材料论文和4323篇蜘蛛丝论文的组合。在选择“扩展数据集”的少数情况下,使用了1034篇生物材料论文、4323篇蜘蛛丝论文和3826篇扩展生物材料论文的组合进行训练,以探索更大、格式更多样化的数据的影响。这个数据集包括了更多的论文,但格式多样,由于使用了效果较差的PDF到文本转换方法,错误数量很大。

4.2 数据集处理和准备

对于CPT中使用的最高质量的原始数据集,我们使用Marker https://github.com/VikParuchuri/marker,这是一个将PDF转换为标记格式的工具。我们发现这总体上工作得很好,质量一致。

4.3 数据集蒸馏和准备用于监督学习

科学论文的原始文本通过一般用途的大型语言模型(大部分是GPT-4o或GPT-4o-mini)以不同方式处理,以产生更高质量的数据,包括适合监督学习的数据,由问答对组成。我们使用了以下策略和目标:

-

问答对:基于文本块,我们开发了问答对

-

定量材料属性提取:我们从论文中提取定量材料属性,得出材料的事实和关键发现列表

-

提取摘要:基于文本块,我们开发了内容摘要,为研究提供合理、清晰的描述

-

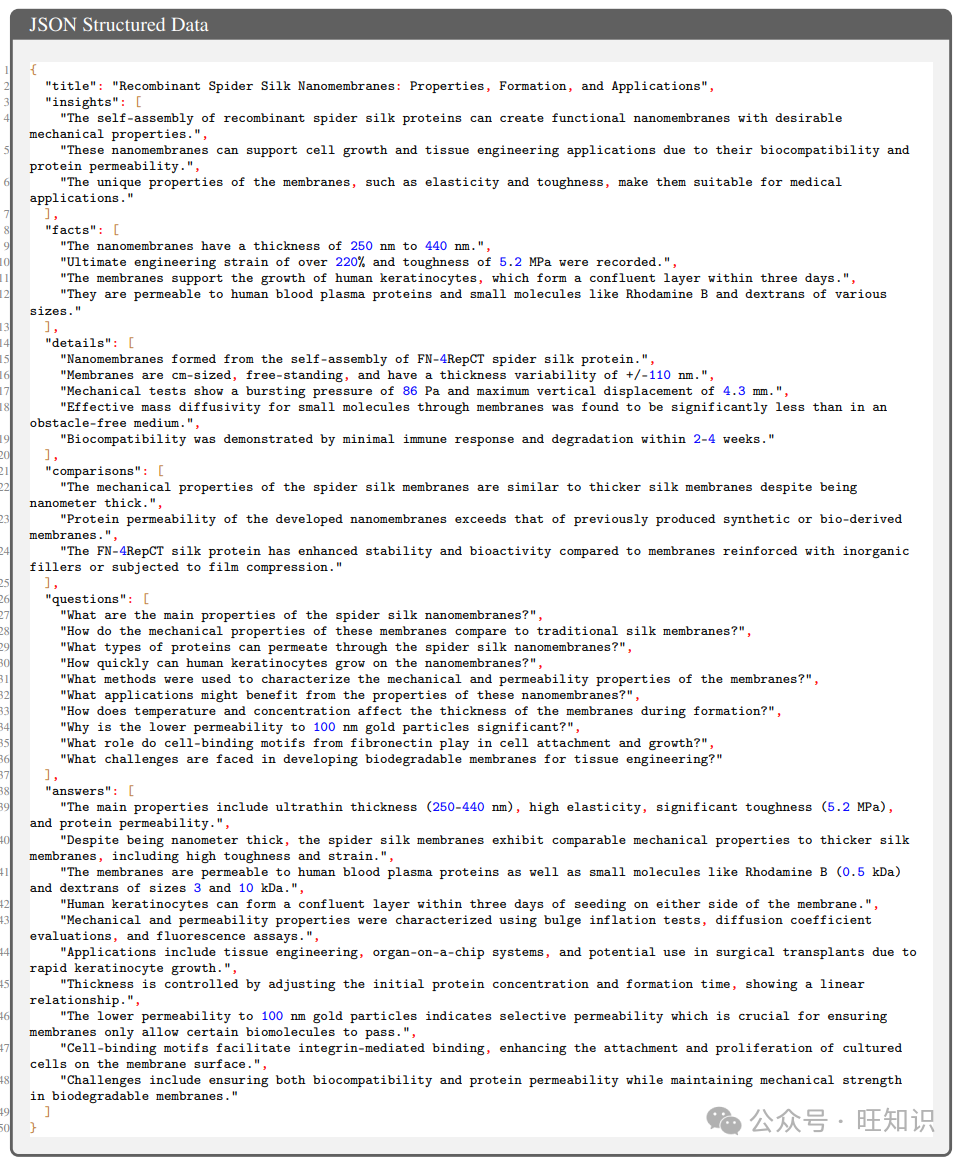

将研究内容组织成结构化的JSON格式,包括以下关键组成部分:

-

标题:标题键包含文章的标题,概括了研究的主要焦点。

-

洞见:洞见键包括一个关键发现或解释的数组,这些是从研究中得出的。每个条目都提供了重要的洞见摘要。

-

事实:事实键由一个事实声明的数组组成,基于研究期间观察或得出的结果。这些条目提供了简洁、可验证的信息。

-

细节:细节键提供了对研究特定方面的更详细探索。这个数组包括方法、结构特征和其他与研究相关的技术元素的信息。

-

比较:比较键包括研究中进行的比较分析的数组。这些比较可能涉及与其他蛋白质的结构相似性或进化类比。

-

问题:问题键列出了研究旨在解决的主要研究问题。每个条目对应研究框架内的一个重要查询。

-

答案:答案键提供了对应于问题键列出的每个研究问题的答案。这些条目总结了研究对每个问题的结论或发现。

这种方法涉及从科学论文中提取研究内容,允许从整个科学论文的上下文中清晰、简洁地提取数据。该过程从开发问答对开始,以解决特定的研究问题。此外,提取定量材料属性,以编制可验证的事实和关键发现。生成内容摘要,为研究提供合理、清晰的描述。

JSON格式包括关键组成部分,如论文的标题、洞见、事实声明、详细方法、比较、研究问题和相应的答案,创建了一个全面且有组织的表示研究。

例如:

对于DPO/ORPO,我们另外构建了拒绝答案,通过指示LLM开发一个科学上不正确、错误的回答。这里是一个例子:

整个科学论文被用来构建这个结构化数据。为每篇论文准备了五套不同的数据,蜘蛛丝数据集大约有21000套,生物启发材料数据集大约有5000套。

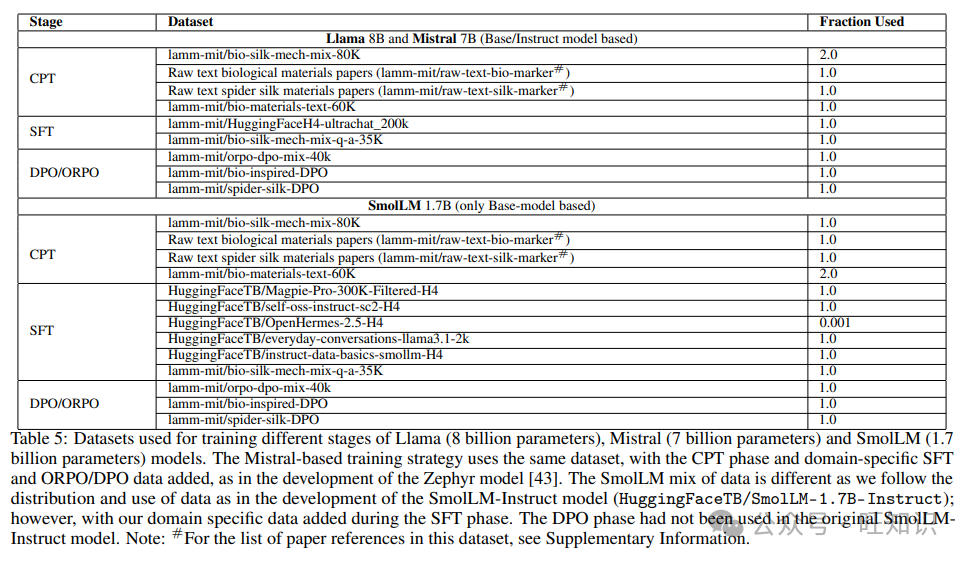

这种结构化方法确保数据集包含了从高层次的洞见到详细的事实信息,促进了全面分析和有效的训练。在CPT期间,这些高质量的数据与原始文本一起使用(见表5的详细分解;其中未结构化文本意味着我们只是将问答对、摘要等内容串联起来)。对于SFT,我们只使用问答对。对于DPO/ORPO,使用提示、响应、拒绝响应的三元组。有关每个模型和训练阶段使用的具体训练集的详细信息如表5所示。

4.4 基准开发和提示

在我们的基准测试策略中,我们评估了模型通过使用结构化提示方法选择正确答案的能力。主要提示功能指示模型如下:

您用一个词或字母回答。选择这个问题的正确答案:{q}

然后是:正确答案是:这限制了模型的响应为一个词或字母,非常适合多项选择或二元(真/假)问题。基准测试在没有采样(即T = 0)的确定性设置中进行,以确保结果的一致性。使用自定义答案检查将模型的响应转换为对应正确选择的单个字母(例如,A、B、C,以及T或F)。

基准测试包含一系列多项选择(MC)和真/假(TF)问题,重点关注生物材料属性、应用和生产,分为生物学、材料科学、基因研究和方法论等主题。这些问题评估了对事实和概念信息的理解,其中一些涉及数值计算或实验技术。基于场景的问题探索了例如蜘蛛如何根据特定环境因素调整其网设计,而逻辑相关和释义任务评估了推理技能。内容强调了生物材料在先进技术中的潜力,如生物技术和材料工程。

4.5 模型评估基准开发

开发了两个基准数据集,一个专注于蜘蛛丝材料(“蜘蛛丝基准”,可在lamm-mit/spider-silk-benchmark找到),另一个是一般生物和生物启发材料(“生物启发/生物材料基准”,可在lamm-mit/bioinspired-benchmark找到)。

一般基准开发过程遵循早期工作,包括开发多项选择题。这些问题由领域专家根据相关文章中提取的知识开发。在本研究中开发的基准每个都包含一个问题和答案、问题类型、知识类别、评估领域和参考论文(如果有),用于问题开发。为蜘蛛丝开发了新的基准,以评估新的训练语料库,并将原始的生物启发材料基准扩展到双倍数量的问题。

表5:用于训练Llama(80亿参数)、Mistral(70亿参数)和SmolLM(17亿参数)模型的各个阶段的数据集。Mistral基础的训练策略使用了相同的数据集,增加了CPT阶段和领域特的SFT和ORPO/DPO数据,如Zephyr模型开发中所述。SmolLM混合数据与原始SmolLM-Instruct模型(HuggingFaceTB/SmolLM-1.7B-Instruct)的开发一致,但加入了领域特定数据到SFT阶段。DPO阶段未在原始SmolLMInstruct模型中使用。注意:#有关此数据集中论文参考列表,请参阅补充信息。

表5:用于训练Llama(80亿参数)、Mistral(70亿参数)和SmolLM(17亿参数)模型的各个阶段的数据集。Mistral基础的训练策略使用了相同的数据集,增加了CPT阶段和领域特的SFT和ORPO/DPO数据,如Zephyr模型开发中所述。SmolLM混合数据与原始SmolLM-Instruct模型(HuggingFaceTB/SmolLM-1.7B-Instruct)的开发一致,但加入了领域特定数据到SFT阶段。DPO阶段未在原始SmolLMInstruct模型中使用。注意:#有关此数据集中论文参考列表,请参阅补充信息。

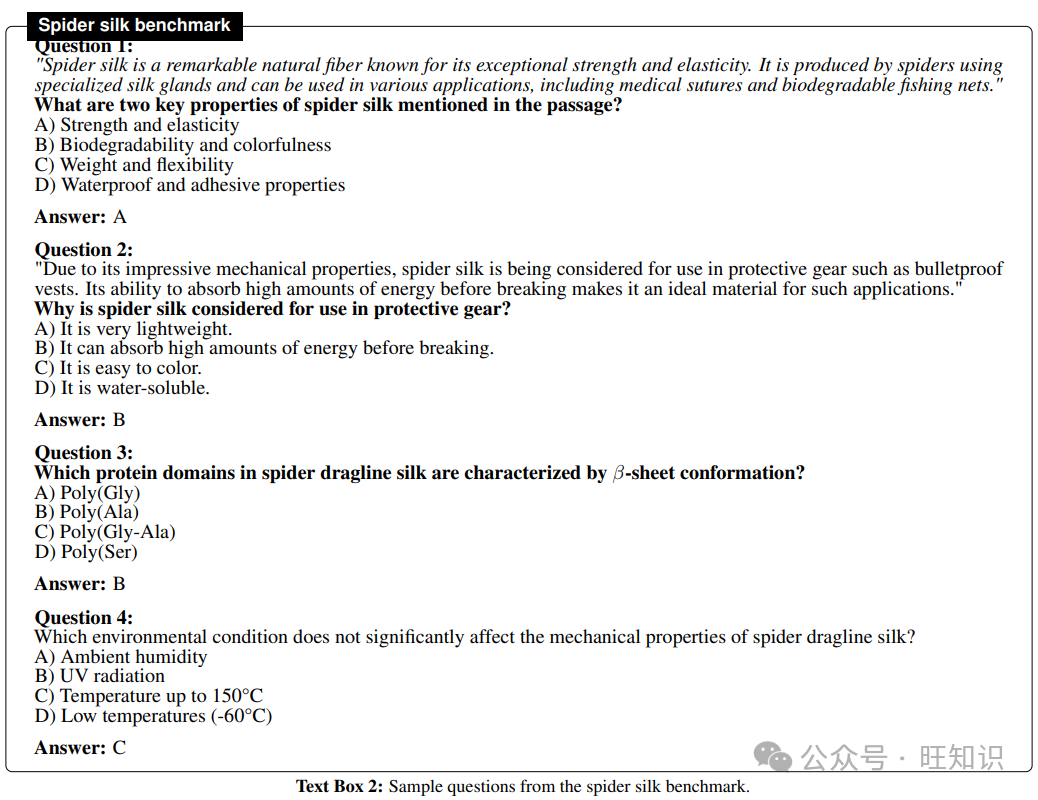

4.5.1 蜘蛛丝基准

我们建立了一个专门针对蜘蛛丝的基准,包括159个问答对,旨在评估模型性能。问题类型包括多项选择和真或假,可以分为两组,每组设计用于不同目的:(1)105个基本问题主要评估对蜘蛛丝的知识和理解,而(2)其余54个高级问题探索涉及逻辑、推理等的各种场景。

详细信息如下:

-

基本查询集:我们首先准备了一个问题集,重点关注对蜘蛛丝的知识理解,包括105个问答对,其中50个多项选择题和55个真或假问题。这些问题进一步分类为描述性、概念性、分析性、数值性、比较性和实验性类别,涵盖材料、生物学、应用、基因、生产和方法论等各种研究领域。

-

高级查询集:为了进一步评估涉及逻辑、推理和创造力的不同场景,设计了54个额外问题。这些问题按问题类型分类为31个多项选择题和23个真或假问题。此外,这个高级查询集还按任务类型组织,包括(1)基于场景的问题(例如,在特定场景下的实验设计,蜘蛛行为或在特定条件下蜘蛛网和丝的机械性能),(2)高级推理问题(例如,阅读理解、总结/简化、释义、数值计算)和(3)逻辑相关问题(例如,谬误识别、否定、语义解析、矛盾)。

这个专门针对蜘蛛丝的基准旨在评估模型不仅在知识回忆方面,而且在逻辑、推理和创造力方面的能力,确保全面评估LLMs的认知和推理能力。基准查询集记录在补充信息中,每个条目包含问题和答案、问题类型、知识类别、评估领域和参考论文(如果有),用于问题开发。文本框2显示了一些样本问题。

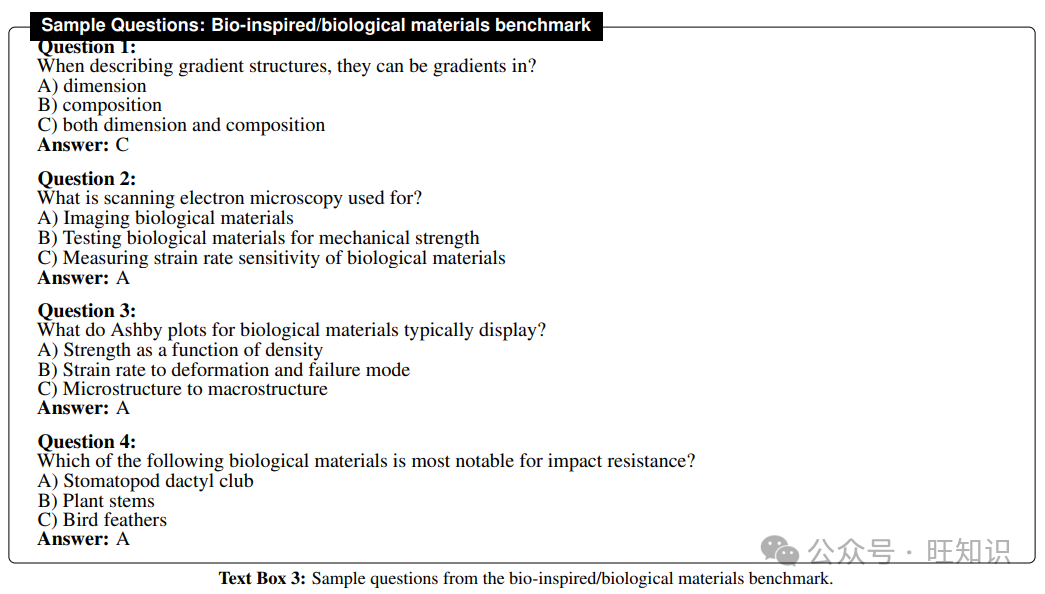

4.5.2 生物启发/生物材料基准

在早期工作中,开发了一个包含100个多项选择题的基准,这些问题侧重于生物材料力学的挑战性问题。由于生物材料涵盖了广泛的物种和材料,因此为这一领域开发了四个类别:

-

一般问题(80):涵盖广泛主题和一般趋势

-

特定问题(80):专注于独特的生物材料力学或文章特定现象

-

数值问题(20):要求特定量化值的问题,记录在文献中

-

非生物问题(20):探测模型区分合成和生物材料的能力,这是基础LLMs的一个常见弱点

在这项工作中,我们扩展了基准测试,并将问题数量翻倍,遵循上述相同的类别。文本框3显示了一些样本问题。

4.6 训练方法

表5总结了每个训练阶段使用的数据集。虽然我们对Llama和Mistral模型使用了相同的数据,但我们改变了SFT和DPO/ORPO训练数据的混合,以匹配原始SmolLM-Instruct模型的开发,但加入了领域特定数据。

Llama和Mistral模型的训练是在一台带有8个GPU的8xH100节点上进行的,而SmolLM模型的训练则是在单个GPU上进行的。所有训练都是使用Hugging Face对齐手册(https://github.com/huggingface/alignment-handbook)和TRL训练器(用于SFT、DPO和ORPO)进行的。有关每个训练阶段使用的所有参数的详细信息,请参见以下各节。

4.6.1 持续预训练(CPT)

在CPT期间,我们向模型提供原始文本。在每个文本块的开始处添加了一个起始标记。我们通过使用样本打包来提高训练效率,即将多个短示例打包到同一个输入序列中,以匹配使用的总序列长度。在https://github.com/lamm-mit/LLM-finetuning上提供了指定所有参数的训练脚本。

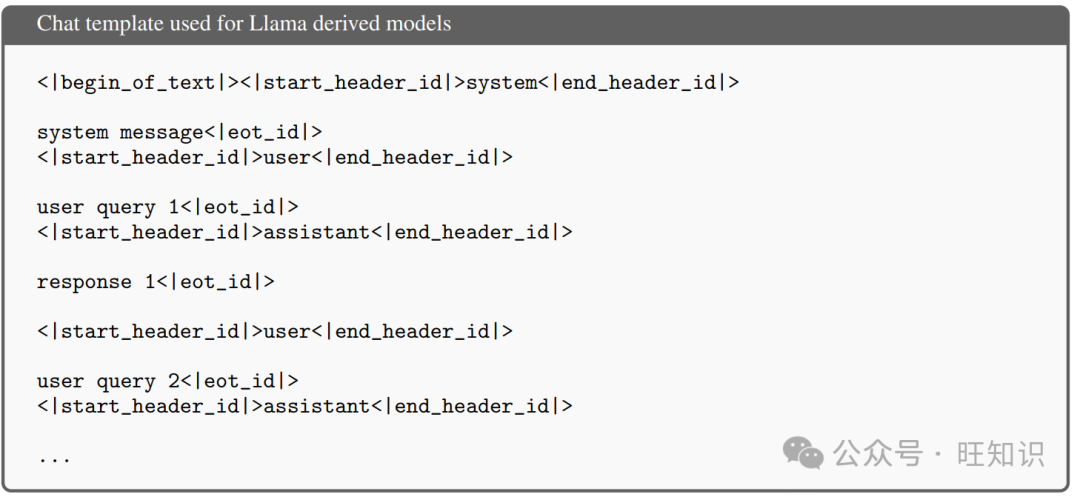

4.6.2 监督式微调(SFT)

我们使用与每个模型相关联的聊天模板来提供以问答格式的样本,其中用户角色用于问题,助手角色用于答案。与CPT一样,我们使用样本打包,将多个短示例打包在一起,以匹配使用的总序列长度。在https://github.com/lamm-mit/LLM-finetuning上提供了指定所有参数的训练脚本。

4.6.3 DPO训练

我们采用了直接偏好优化(DPO)作为微调策略,以增强我们的语言模型生成基于人类反馈的首选响应的能力。如中介绍的,DPO微调使用带有选定和拒绝样本的数据集。在每个提示中,一个响应被标记为“选定”(首选选项),另一个被标记为“拒绝”(较不受欢迎的选项)。这种偏好数据训练模型以区分并优先考虑与数据中指示的偏好一致的响应。

我们使用了Hugging Face DPO训练器和Transformer Reinforcement Learning库,通过直接最大化DPO损失的对数似然来微调模型。这种优化过程专门设计用于增强模型复制数据中指示的偏好的能力。

训练是通过特定的模型聊天模板进行的,这使得交互式微调成为可能,通过将直接反馈纳入模型的学习过程中。这种方法确保了模型不仅在生成正确响应上接受训练,而且还与对话环境中期望的输出对齐。

在https://github.com/lamm-mit/LLM-finetuning上提供了指定所有参数的训练脚本。

4.6.4 赔率比偏好优化(ORPO)训练

我们采用了赔率比偏好优化(ORPO)作为偏好对齐策略来微调我们的模型。ORPO通过直接优化模型,将附加到负对数似然(NLL)损失的对数赔率比项,从而消除了额外的参考模型或偏好对齐阶段的需求(实现了一种偏好对齐的SFT)。这种方法减少了计算和内存开销,同时保持了强大的偏好适应性。这简化了将语言模型与人类偏好对齐的过程,消除了复杂的强化学习框架如RLHF(从人类反馈中强化学习)的需求。与拟合奖励模型然后优化它不同,DPO通过最大化首选响应相对于不受欢迎响应的对数似然来直接调整模型的参数。这种方法比传统的基于RL的方法更稳定、高效且计算成本更低。

在我们的ORPO训练中,我们使用了与DPO训练相同的数据集格式,包含三个关键组成部分:提示、选定响应和拒绝响应。对于每个提示,提供了一对响应,其中一个被标记为“选定”(首选响应),另一个被标记为“拒绝”(较不受欢迎的响应)。这种数据集结构允许ORPOTrainer通过最小化NLL损失来优化模型,对拒绝响应施加额外的惩罚,并对选定响应施加强烈的适应信号。

我们使用了Hugging Face ORPO训练器和Transformer Reinforcement Learning库,利用ORPO算法在没有参考模型的情况下微调模型。这种设置通过将对数赔率比直接集成到训练过程中,允许模型以简化的方式从人类偏好中学习。使用聊天模板促进了交互式微调,确保模型针对生成与期望输出一致的响应进行了优化。

在https://github.com/lamm-mit/LLM-finetuning上提供了指定所有参数的训练脚本。

4.6.5 终止和填充标记

在SFT、ORPO和DPO阶段,我们将填充标记设置为与EOS标记不同,以确保在训练期间不会屏蔽掉终止标记。

4.7 模型合并

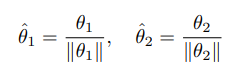

我们使用MergeKit来合并模型。模型合并的主要方法是球面线性插值(SLERP),我们发现它总体上表现最佳。给定两组模型参数θ1和θ2,SLERP在它们之间进行插值如下。首先将两组参数归一化,使其位于单位超球面上:

使用点积计算两个参数向量之间的余弦角ω:

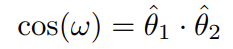

然后,沿着单位超球面上的球面路径对两个向量进行插值:

其中t ∈ [0, 1]是插值参数。当t = 0时,SLERP(t)返回ˆθ1,当t = 1时,它返回ˆθ2。

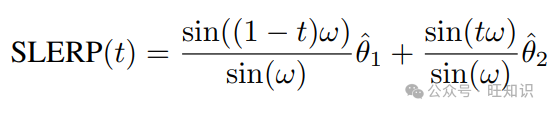

最后,重新调整插值后的参数向量的大小:

SLERP允许我们以一种尊重权重空间底层几何的方式合并神经网络权重。通过沿着球面路径插值,SLERP避免了线性插值的缺点,例如在参数空间的高损失区域通过,导致更平滑、更有效的合并。这种方法在转移学习、集成方法或创建结合不同预训练模型优势的混合模型等场景中特别有用。

SLERP的有效性可以联系到过度参数化和集成方法中观察到的原则。过度参数化的神经网络由于其高容量,即使在训练到接近零误差时也倾向于泛化良好。SLERP利用这种容量通过非线性组合参数,使新能力通过复杂相互作用出现,这可能是线性插值会错过的。

此外,SLERP与集成方法有相似之处,这些方法从模型的多样性中受益。SLERP中的插值过程充当一个连续的集成,其中模型参数的非线性组合沿着球面路径可以激活任一模型单独未展现的新特征。当被合并的模型学习了互补特征时,SLERP特别有效地协同增强它们的优势并产生新功能。

SLERP在发现新能力和提高性能方面的总体有效性可以推测为与被合并模型之间的多样性和它们的总参数数量成比例。

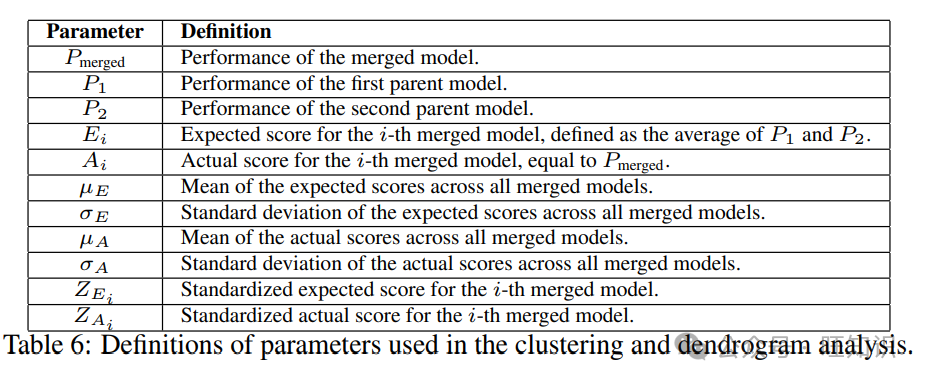

4.8 聚类分析和树状图

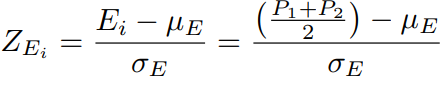

在本分析中,我们标准化了合并模型的性能分数,以便在不同模型之间进行有意义的比较。合并模型的性能表示为Pmerged,而两个父模型的性能表示为P1和P2。标准化分数的计算方法如下。

预期分数Ei对于第i个合并模型是计算两个父模型性能的平均值:Ei = (P1 + P2) / 2。让µE和σE分别代表所有合并模型预期分数的平均值和标准差。然后,第i个合并模型的标准化预期分数ZEi使用以下公式计算:

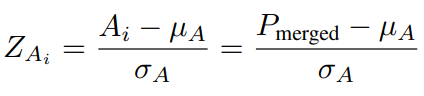

实际分数Ai对于第i个合并模型是其观察到的性能:

让µA和σA分别代表所有合并模型实际分数的平均值和标准差。然后,第i个合并模型的标准化实际分数ZAi使用以下公式计算:

见表6有关参数定义和使用的总结。

表6:聚类和树状图分析中使用的参数定义。

表6:聚类和树状图分析中使用的参数定义。

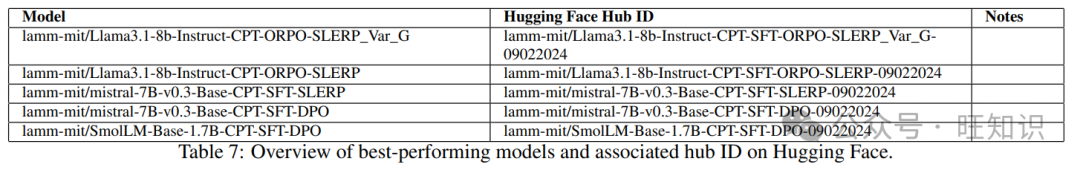

4.9 Hugging Face上最佳性能模型的总结

在Hugging Face上发布的最佳性能模型及其相应的Hub ID总结在表7中。

表7:Hugging Face上最佳性能模型的概述和相关Hub ID。

表7:Hugging Face上最佳性能模型的概述和相关Hub ID。

4.10 多轮人类-AI对话

我们为所有实验一致地定义了人类输入和系统提示。我们使用topk=512,topp = 0.9,repetition_penalty = 1.1。我们将生成的最大令牌数设置为1024,以允许在多轮对话中产生长而详细的输出。

4.11 图像合成

图像合成是使用lamm-mit/leaf-FLUX.1-dev进行的。这个模型是基于black-forest-labs/FLUX.1-dev基础模型的微调版本,使用了带有关键词‘’的叶子图像,遵循了中提出的概念。训练集可以在lamm-mit/leaf-flux-images-and-captions找到。该模型训练了N = 2,000步,使用adamw8bit,在0.0001的学习率下,应用了LoRA适配器到所有线性层,秩r = 16,α = 16。展示使用生物启发线索的图像生成模型的目的,是为了将解决方案引向有机的、抽象的、生物形态。图像生成通常使用25个去噪步骤和指导比例=3.5。另一个可用的模型是lamm-mit/leaf-L-FLUX.1-dev,训练了N = 4,000步,使用adamw8bit,在0.0001的学习率下,应用了LoRA适配器到所有线性层,秩r = 64,α = 64。较大的FLUX模型提供了更强的诱导叶子微观结构模式的效果。

对于针对图像合成的对话,我们使用topk=512,topp = 0.9,repetition_penalty = 1.1。我们将生成的最大令牌数设置为1024,以允许模型产生长而详细的输出。

如何学习大模型 AI ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

- 硬件选型

- 带你了解全球大模型

- 使用国产大模型服务

- 搭建 OpenAI 代理

- 热身:基于阿里云 PAI 部署 Stable Diffusion

- 在本地计算机运行大模型

- 大模型的私有化部署

- 基于 vLLM 部署大模型

- 案例:如何优雅地在阿里云私有部署开源大模型

- 部署一套开源 LLM 项目

- 内容安全

- 互联网信息服务算法备案

- …

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名大模型 AI 的正确特征了。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?