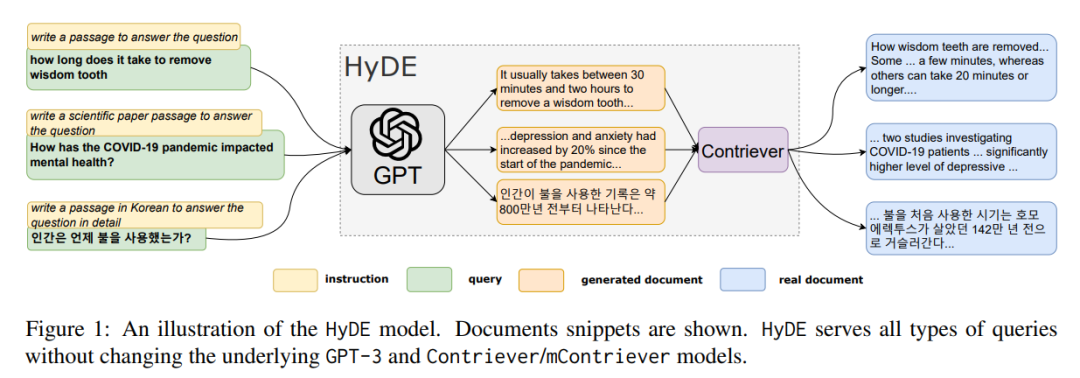

在 RAG 系统中,检索的精准度直接决定了后续生成结果的质量。但传统密集检索模型离不开大量标注数据,零样本场景下的检索效果往往不尽人意。卡内基梅隆&滑铁卢团队在2023 ACL会议提出的 HyDE(假设文档嵌入)方法,凭借“生成假设文档+检索”的创新思路,在无任何相关性标签的情况下,实现了媲美微调模型的检索性能,也是现在RAG优化的经典方案。

01 — 研究背景: 零样本检索的双重痛点

密集检索通过将查询和文档编码为向量、利用语义相似度匹配实现高效检索,已在网页搜索、问答、事实验证等任务中证明其价值。但在实际应用中,它面临两大核心难题,这也成为 HyDE 方法诞生的关键背景:

标注数据依赖:有监督模型的“致命短板”

传统有监督密集检索的性能提升,高度依赖大量“查询-相关文档”配对的标注数据。例如主流的 DPR、ANCE 模型,均需在 MS-MARCO 等百万级标注数据集上训练才能达到理想效果。

但现实场景中,这类标注数据不仅获取成本高(需人工判断文档相关性),还存在商业使用限制(如 MS-MARCO 无法自由应用于所有商业场景),导致有监督模型难以落地到小众领域或新业务中。

短查询对齐难题:原始查询与文档的“语义鸿沟”

更易被忽视的痛点是——用户输入的原始查询通常较短(如“智齿拔除需要多久”“新冠如何影响心理健康”),而语料库中的索引文档多为长文本(如学术论文段落、新闻报道)。传统密集检索直接将短查询与长文档编码后计算相似度,往往因“语义维度不匹配”导致检索偏差:短查询无法覆盖文档的核心信息,或文档中的关键细节未被短查询捕捉,最终造成“想找的找不到,找到的不相关”。

正是为解决这两大痛点,HyDE 提出解决思路:不依赖标注数据,而是通过大模型生成“假设文档”作为中间桥梁,用假设文档的长文本语义,填补短查询与索引文档之间的对齐鸿沟。HyDE 的核心逻辑是:利用 LLM 自身学习到的知识,生成一份能回答用户查询的“理想文档”(假设文档),再用这份长文本假设文档与索引中的真实文档做相似性匹配——既避开了标注数据缺失的问题,又解决了短查询难以对齐长文档的难题。

02 — 核心思路: 把检索变成“生成+匹配”的两步走

HyDE 的创新之处在于,它没有直接建模“查询-文档”的相似度,而是通过“生成假设文档”重构检索逻辑,将原本需要标注数据的复杂任务,拆分为两个可复用预训练模型完成的子任务:

-

生成任务:用 LLM 补全“理想答案”

给指令跟随型大模型(如 InstructGPT)输入用户的短查询,再搭配特定指令(如“撰写一段回答该问题的内容”),让模型生成一份“假设文档”。这份文档不需要完全真实(允许包含虚假细节),但必须能覆盖查询的核心意图、捕捉“相关文档应具备的语义模式”——比如查询“智齿拔除需要多久”,生成的假设文档会包含“拔除时间受牙齿位置、复杂程度影响,简单情况几分钟,复杂情况需20分钟以上”等信息,这些信息正是真实相关文档会涵盖的核心内容。

-

匹配任务:用对比编码器过滤噪声、精准检索

用无监督对比学习编码器(如 Contriever)将假设文档编码为向量。编码器的“密集瓶颈”特性会自动过滤掉假设文档中的虚假细节(如虚构的“某医院数据显示”),只保留核心语义特征;再用这个向量在语料库的文档向量索引中检索,找到语义最相似的真实文档——此时匹配的不再是短查询与长文档,而是“长文本假设文档”与“长文本真实文档”,语义对齐度大幅提升。

简单来说,HyDE 相当于让大模型先“脑补”一份理想答案,再根据这份理想答案的“语义模板”去真实语料中找最接近的结果,完美避开了零样本场景下的两大痛点。

03 — 技术细节: HyDE 的工作原理

预备知识:传统密集检索的困境

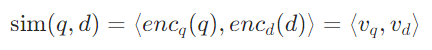

传统密集检索通过内积计算查询向量 和文档向量

和文档向量 的相似度:

的相似度:

其中 和

和 分别是查询编码器和文档编码器。

分别是查询编码器和文档编码器。

零样本场景下,由于没有相关性标签,无法训练这两个编码器映射到同一个能捕捉“查询-文档相关性”的向量空间;同时,短查询的向量维度有限,与长文档向量计算相似度时,极易丢失关键信息,这两大问题共同导致传统方法检索效果不佳。

HyDE 的核心设计

HyDE 彻底绕开了“双编码器训练”和“短查询对齐”的难题,直接复用预训练模型,具体步骤如下:

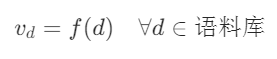

步骤1:文档编码——统一向量空间

使用无监督对比学习编码器(如 Contriever)作为唯一的文档编码器 f ,将所有语料库文档编码为向量。这个编码器无需任何微调,其在预训练阶段已通过“对比学习”学会捕捉文档间的语义相似性,能将内容相近的文档映射到向量空间的邻近区域:

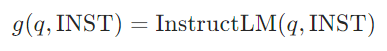

步骤2:生成假设文档——补全语义信息

根据任务类型,给指令跟随型 LLM(如 InstructGPT)输入定制化指令和用户查询,生成 N 份假设文档。

例如:

- 网页搜索任务:指令为“撰写一段回答该问题的内容”;

- 事实验证任务:指令为“撰写一段支持/反驳该主张的科学论文段落”;

- 多语言任务(如韩语):指令为“用韩语撰写一段详细回答该问题的内容”。

生成多份假设文档是为了覆盖查询的不同表述角度,减少单一文档的随机性影响。

步骤3:查询向量构建——融合假设与原始查询

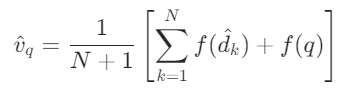

将生成的NNN份假设文档通过编码器 f 编码为向量,再取平均值;同时,为了保留原始查询的核心意图,将查询本身也作为一份“特殊假设文档”编码后加入计算,最终得到查询向量:

此时的查询向量,既包含了假设文档的长文本语义信息,又保留了原始查询的核心意图,能更精准地与真实文档向量对齐。

步骤4:相似性匹配——检索真实文档

计算查询向量 与所有文档向量

与所有文档向量 的内积,按相似度从高到低排序,返回排名靠前的真实文档,完成检索流程。

的内积,按相似度从高到低排序,返回排名靠前的真实文档,完成检索流程。

整个过程中,假设文档的虚假细节会被编码器的“密集瓶颈”过滤(如编码器不会关注假设文档中“某专家表示”这类具体表述,只会提取“拔牙时间范围”这类核心语义),最终实现精准检索。

04 — 实验结果: 零样本场景下的碾压性表现

HyDE 在网页搜索、低资源检索、多语言检索三大场景中,均展现了远超基线的性能,甚至比肩微调模型,充分验证了“假设文档”思路的有效性。

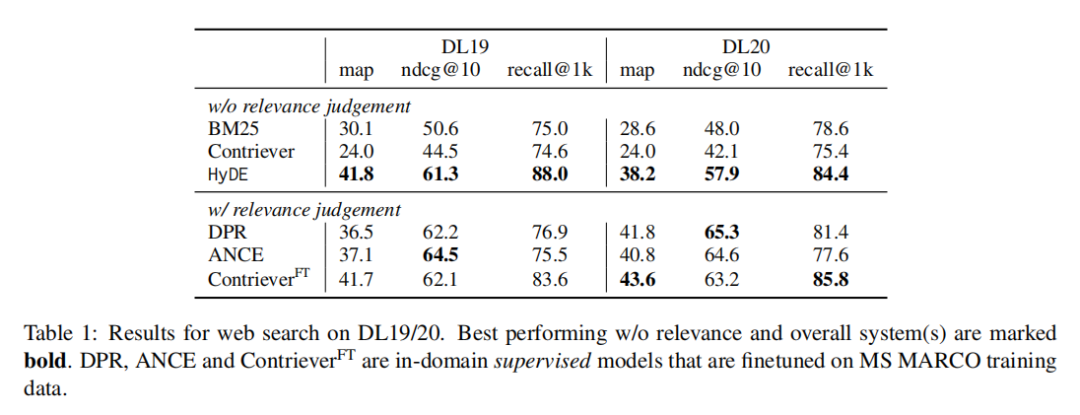

网页搜索:超越无监督,逼近微调

在 TREC DL19/20 数据集(基于 MS-MARCO,主流网页搜索评测基准)上,HyDE 大幅超越无监督基线,甚至接近有监督微调模型:

- DL19 数据集:HyDE 的 MAP(平均准确率)达到 41.8,远超无监督 Contriever(24.0)和传统词法检索 BM25(30.1),与在 MS-MARCO 上微调后的 ContrieverFT(41.7)几乎持平;

- DL20 数据集:HyDE 的 NDCG@10(前10结果的归一化折扣累积增益)达到 57.9,显著优于无监督模型,仅比微调模型低约 10%,但无需任何标注数据。

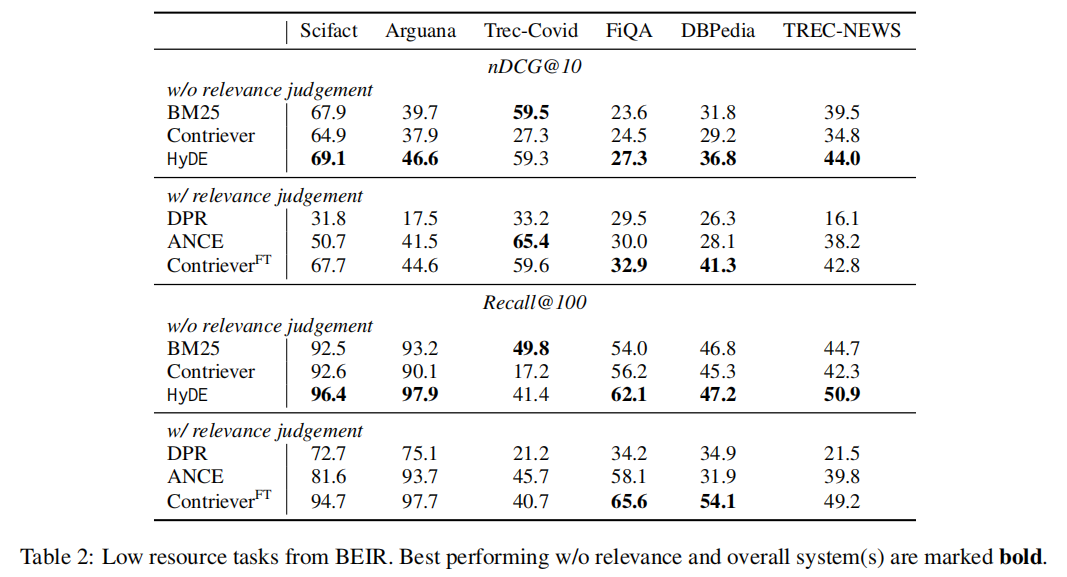

低资源检索:优势更明显

在 BEIR 数据集的 6 个低资源任务中(如 SciFact 事实验证、FiQA 金融问答),HyDE 的优势进一步放大:

- 仅在 TREC-Covid 任务中,NDCG@10 略低于 BM25(59.3 vs 59.5),其余任务均大幅领先;

- 相比 DPR、ANCE 等在 MS-MARCO 上微调后迁移的模型,HyDE 在大多数任务中表现更优,尤其在召回率上优势显著(如 Scifact 任务召回率@100 达 96.4%),证明其在数据稀缺场景下的强适应性。

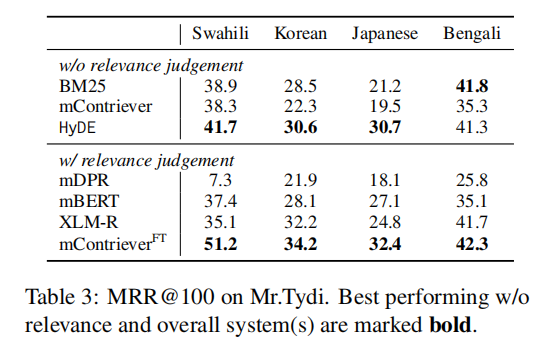

多语言检索:跨语言能力突出

在 Mr.Tydi 数据集的斯瓦希里语、韩语、日语、孟加拉语任务中(小语种场景,标注数据极少),HyDE 克服了“小语种模型训练不足”的难题:

- 所有语言任务中,HyDE 均优于无监督 mContriever 和 BM25;

- 虽不及专门针对小语种微调的 mContrieverFT,但已远超其他迁移学习模型(如 mDPR、微调 mBERT),证明其“生成假设文档”的思路可跨语言复用。

消融实验:生成模型越大,效果越好

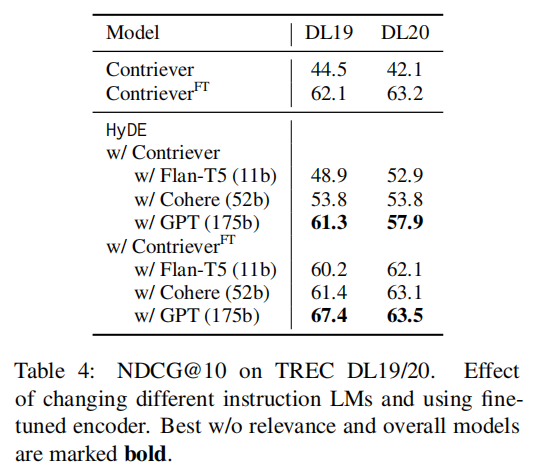

为验证“假设文档生成”的关键作用,研究团队测试了不同规模生成模型对 HyDE 性能的影响:

- 模型规模与性能正相关:175B 参数的 GPT-3(InstructGPT)表现最佳,52B 的 Cohere 次之,11B 的 FLAN-T5 仍能显著提升基线(如 DL19 数据集 NDCG@10 达 48.9,远超 Contriever 的 44.5);

- 微调编码器兼容:即使将 HyDE 与微调后的编码器结合,InstructGPT 仍能进一步提升性能(如 DL19 数据集 NDCG@10 达 67.4,超过 ContrieverFT 的 62.1),说明生成模型能捕捉微调编码器未覆盖的语义信息。

05 — 核心价值与应用场景

核心优势

- 零标注依赖:无需任何“查询-文档”配对数据,开箱即用,解决标注成本高、获取难的问题;

- 无模型微调:直接复用预训练 LLM(如 GPT-3)和对比编码器(如 Contriever),部署成本极低,无需复杂训练流程;

- 语义对齐强:通过假设文档将短查询补全为长文本,解决短查询与长文档的对齐难题,提升检索精准度;

- 泛化能力广:适配多任务(搜索、问答、验证)、多语言(从英语到小语种),无需调整架构,适用性强。

适用场景

- 新搜索系统冷启动:新业务初期无用户日志、无标注数据时,用 HyDE 快速提供高质量检索服务,避免“冷启动期检索效果差”的问题;

- 低资源领域检索:如小众专业领域(如古籍修复、特殊疾病诊疗)、小语种场景,缺乏标注数据时,HyDE 仍能保持高检索性能;

- RAG 系统优化:作为 RAG 中的 query 优化算子,用假设文档重构查询向量,提升检索精准度,进而改善后续生成结果的质量;

- 快速原型验证:无需投入标注和训练资源,用 HyDE 快速验证检索方案的可行性,缩短研发周期。

如何高效转型Al大模型领域?

作为一名在一线互联网行业奋斗多年的老兵,我深知持续学习和进步的重要性,尤其是在复杂且深入的Al大模型开发领域。为什么精准学习如此关键?

- 系统的技术路线图:帮助你从入门到精通,明确所需掌握的知识点。

- 高效有序的学习路径:避免无效学习,节省时间,提升效率。

- 完整的知识体系:建立系统的知识框架,为职业发展打下坚实基础。

AI大模型从业者的核心竞争力

- 持续学习能力:Al技术日新月异,保持学习是关键。

- 跨领域思维:Al大模型需要结合业务场景,具备跨领域思考能力的从业者更受欢迎。

- 解决问题的能力:AI大模型的应用需要解决实际问题,你的编程经验将大放异彩。

以前总有人问我说:老师能不能帮我预测预测将来的风口在哪里?

现在没什么可说了,一定是Al;我们国家已经提出来:算力即国力!

未来已来,大模型在未来必然走向人类的生活中,无论你是前端,后端还是数据分析,都可以在这个领域上来,我还是那句话,在大语言AI模型时代,只要你有想法,你就有结果!只要你愿意去学习,你就能卷动的过别人!

现在,你需要的只是一份清晰的转型计划和一群志同道合的伙伴。作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

- 硬件选型

- 带你了解全球大模型

- 使用国产大模型服务

- 搭建 OpenAI 代理

- 热身:基于阿里云 PAI 部署 Stable Diffusion

- 在本地计算机运行大模型

- 大模型的私有化部署

- 基于 vLLM 部署大模型

- 案例:如何优雅地在阿里云私有部署开源大模型

- 部署一套开源 LLM 项目

- 内容安全

- 互联网信息服务算法备案

- …

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名大模型 AI 的正确特征了。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1165

1165

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?