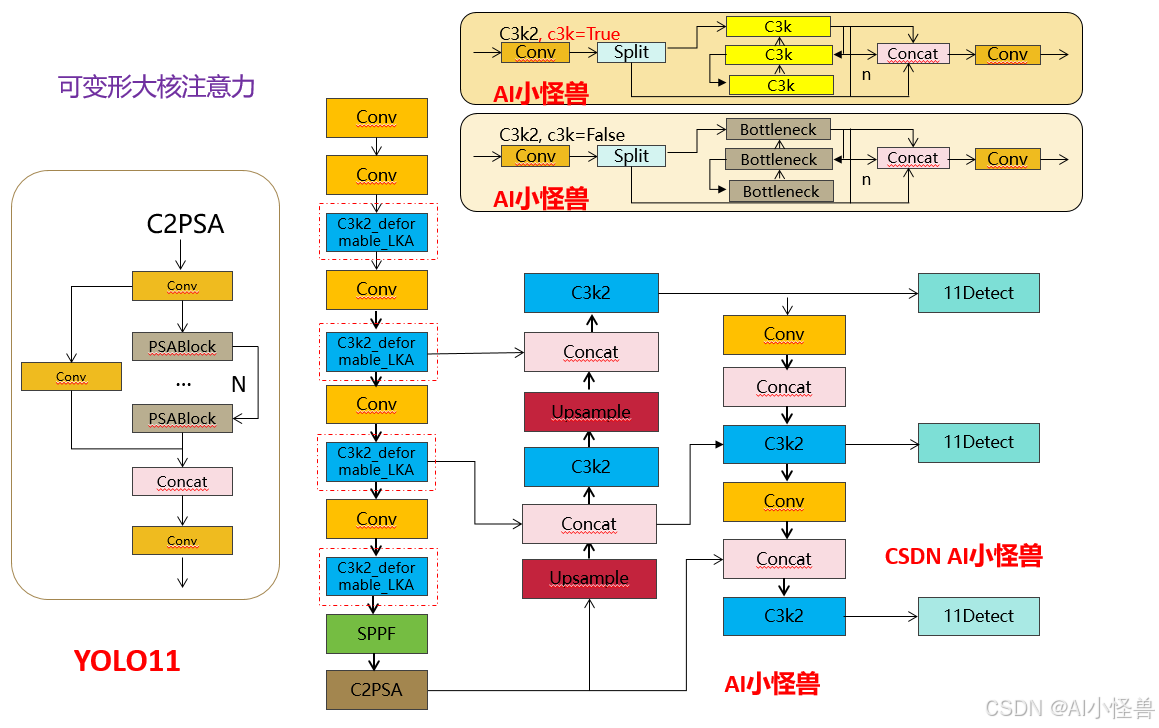

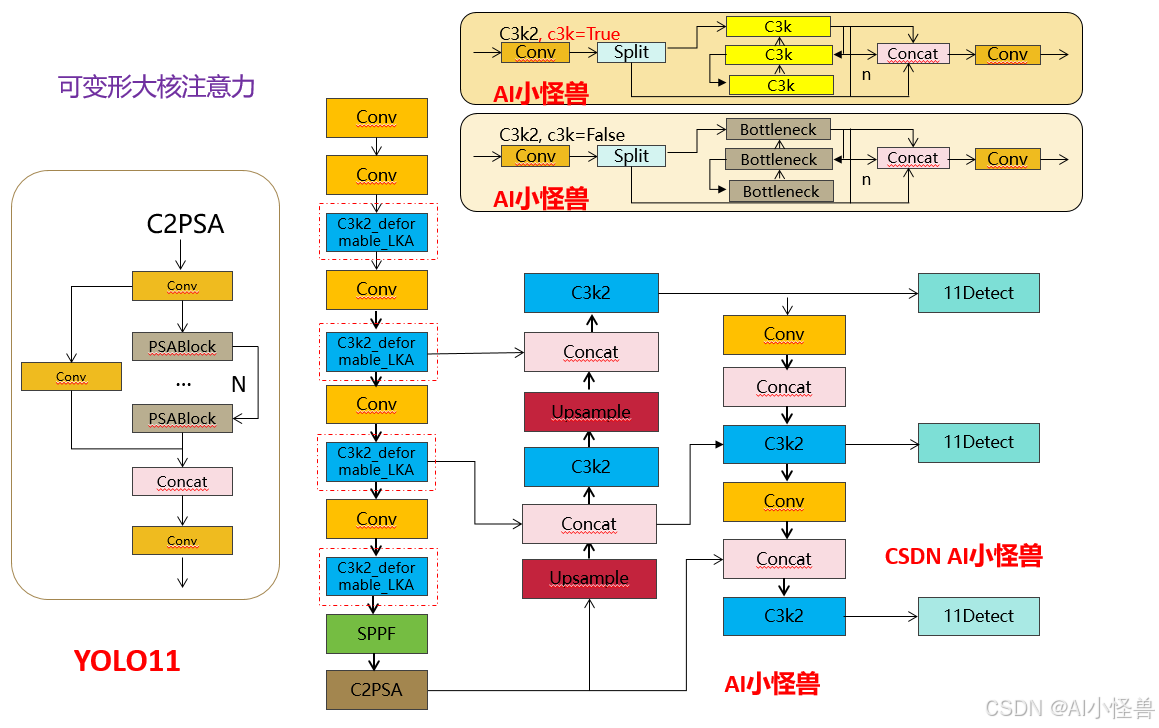

💡💡💡本文独家改进:可变形大核注意力(D-LKA Attention),采用大卷积核来充分理解体积上下文的简化注意力机制,来灵活地扭曲采样网格,使模型能够适当地适应不同的数据模式

D-LKA Attention | 亲测在多个数据集能够实现大幅涨点

改进结构图如下,提供多种改进方式:

《YOLOv11魔术师专栏》将从以下各个方向进行创新:

链接:

💡💡💡本文独家改进:可变形大核注意力(D-LKA Attention),采用大卷积核来充分理解体积上下文的简化注意力机制,来灵活地扭曲采样网格,使模型能够适当地适应不同的数据模式

D-LKA Attention | 亲测在多个数据集能够实现大幅涨点

改进结构图如下,提供多种改进方式:

《YOLOv11魔术师专栏》将从以下各个方向进行创新:

链接:

4856

4856

739

739

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?