Abstract

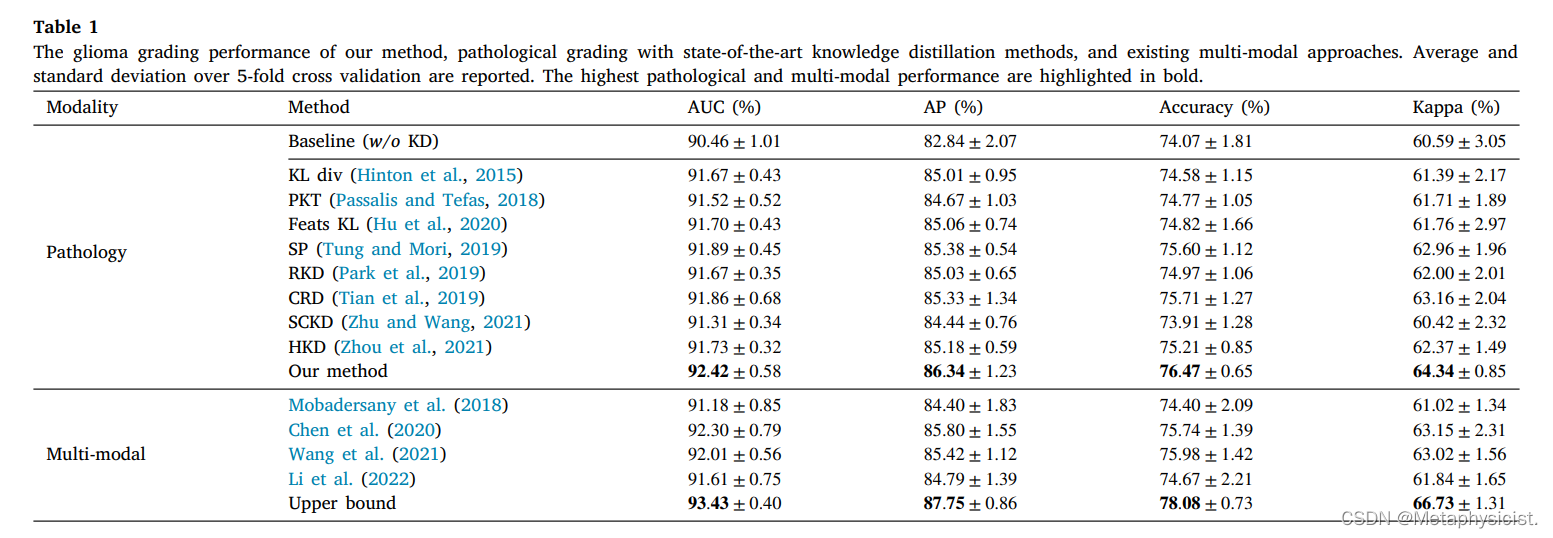

多模态数据(例如病理切片和基因组图谱)的融合可以提供补充信息并有益于神经胶质瘤分级。然而,由于成本高和技术挑战,基因组图谱难以获得,从而限制了多模态诊断的临床应用。在这项工作中,调查了一个现实问题,即在训练期间可以使用配对的病理基因组数据,而只有病理切片可用于推理。针对这一问题,该文提出一种综合学习和适应性教学框架,通过将特权知识从多模态教师转移到病理学学生身上,提高病理分级模型的性能。为了全面学习多模态教师,提出了一种新颖的显著性感知掩蔽(SA-Mask)策略,通过掩蔽最显着的特征来探索两种模式中更丰富的疾病相关特征。对于病理学学生的自适应教学,首先设计了一个局部拓扑保留和差异消除对比蒸馏(TDC-Distill)模块,以调整教师和学生模型的特征分布。此外,考虑到多模态教师可能包含不正确的信息,提出了一个梯度引导知识细化(GK-Refine)模块,该模块构建了一个知识库,并根据他们在梯度空间中的一致性自适应地吸收可靠的知识。在TCGA GBMLGG数据集上的实验表明,提出的蒸馏框架改善了病理性胶质瘤分级,并优于其他KD方法。值得注意的是,使用唯一的病理切片,方法实现了与现有多模式方法相当的性能。

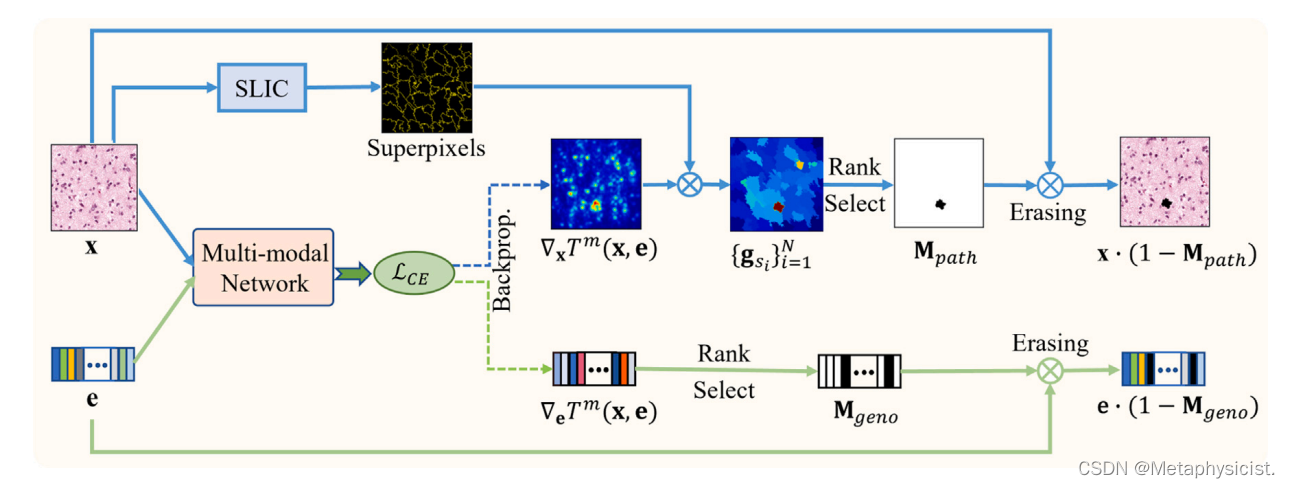

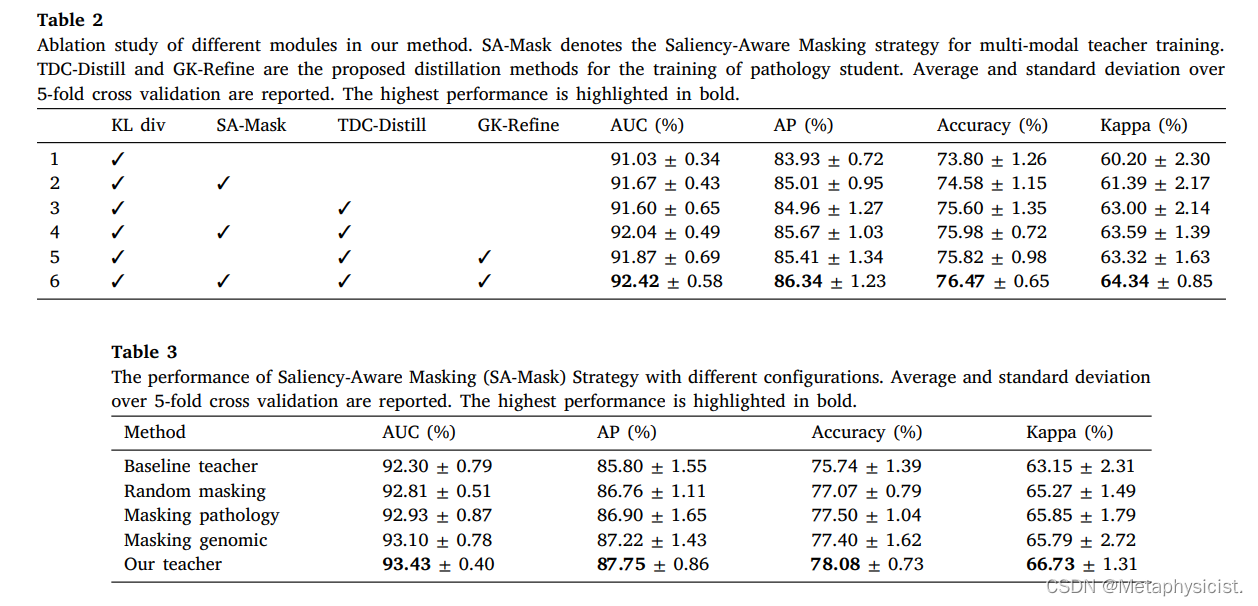

本文提出了一个两阶段的综合学习和适应性教学框架,通过病理学切片将病理基因组知识转移到更准确的神经胶质瘤分级上。在综合学习阶段,提出了一种多模态教师培训的显著性感知掩蔽(SA-Mask)方法。通过掩盖每种模态中最显着的特征,多模态教师将被迫挖掘其他被忽略但有用的特征,从而从两种模态中提取更全面的任务相关知识。在自适应教学阶段,首先设计了一个局部拓扑保留和差异消除对比蒸馏(TDC-Distill)模块,以调整教师和学生模型的特征分布。具体而言,基于对比蒸馏范式,TDC-Distill 模块利用多个最近邻作为正对来正化这些模型的局部拓扑之间的一致性,并根据教师模型和学生模型之间的置信度差异重新加权查询样本。

为了减少来自多模态教师的误导性知识,进一步提出了一种梯度引导知识细化(GK-Refine)方案,以自适应地吸收来自多模态教师的有益知识。具体来说,GK-Refine构建了一个知识库,以提供互补的指导,并根据梯度空间中的一致性自适应地提炼多个知识。这三个模块可以更有效地蒸馏,并导致更准确的病理学学生。主要贡献总结如下:

• 提出了一个新颖的综合学习和适应性教学框架,以提炼病理基因组知识,并通过病理切片对神经胶质瘤进行分级。

• 为了实现多模态教师的全面学习,提出了一个SA-Mask策略,以探索两种模态中被忽视但有用的特征,从而为学生提供更好的榜样。

• 针对单模态学生的自适应教学,设计了一种新颖的TDC-Didistill模块,以有效的方式对齐特征分布,并设计了一种GK-Refine方案,以实现自适应知识吸收。

• 实验表明,提出的蒸馏框架显着改善了病理分级,并优于最先进的 KD 方法。使用唯一的病理切片,我们的方法实现了与现有多模式方法相当的胶质瘤分级性能。

这项工作以会议论文(Xing et al., 2022a)为基础,并在以下方面进行了扩展:

(1)引入了一种新的SA-Mask策略,用于多模态教师的培训。与会议论文中的普通教师模型相比,采用SA-Mask策略训练的教师能够从两种模式中探索更全面的信息,并提高知识蒸馏的上限。

(2)设计了一种新颖的TDC-蒸馏模块,用于高效的知识蒸馏。与会议论文中的DC-Distill相比,TDC-Distill进一步引入了相邻的正对,以保持局部拓扑结构。此外,与DC-Distill中的对比对选择相比,TDC-Distill中的查询样本重新加权更简洁,在缓解师生差异方面更有效。

(3) 纳入了相当多的新实验结果,包括与最新方法的更多比较研究、更多的消融实验和可视化结果。

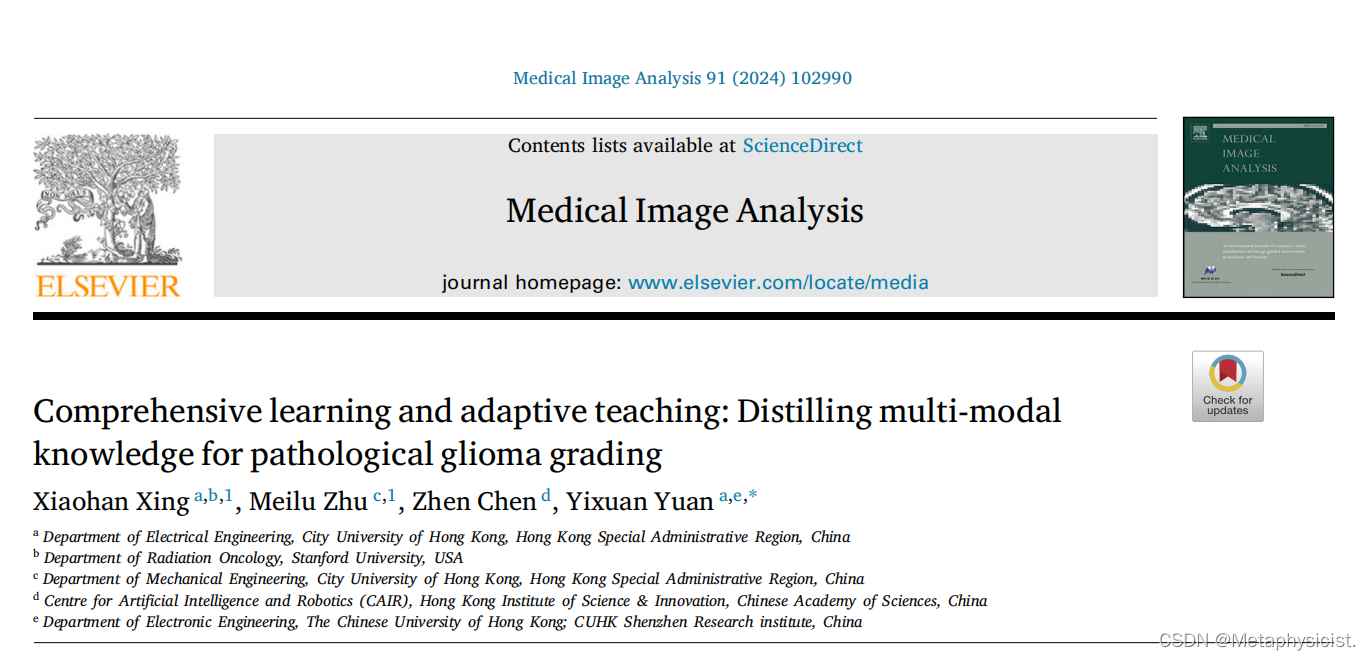

图 1.方法的框架。(A) 在第一阶段,多模态教师接受以病理切片和基因组数据作为输入的培训。提出了一种显著性感知掩蔽 (SA-Mask) 策略,以探索两种模式的更全面的特征。(B) 在第二阶段,病理学学生通过 KL 发散和我们提出的局部拓扑保留和差异消除,从多模态教师 和病理学教师那里提炼知识

所提出的综合学习和适应性教学框架的整体训练过程如图1所示,主要包含两个阶段。在第一阶段,多模态教师接受病理切片和基因组数据作为输入的培训。这两种模式通过Kronecker融合。为了提高教师模型的性能,设计了一种新颖的显著性感知掩蔽(SA-Mask)策略,帮助教师从两种模式中探索更全面的特征,从而为学生模型提供丰富的知识。在第二阶段,病理学学生通过常用的 KL 散度和提出的局部拓扑保留和差异消除对比蒸馏(TDC-Distill)模块从固定的多模态教师 T m 和病理学教师中提炼知识来训练。为了最大限度地吸收教师的有益信息,同时屏蔽误导性知识,我们提出了一种梯度引导知识细化(GK-Refine)方案,该方案构建了知识库,并根据他们在梯度空间中的一致性对知识进行细化。在推理过程中,病理模型使用唯一可用的病理切片执行神经胶质瘤分级。使用更高级的教师模型(使用 SA-Mask 策略训练)和自适应蒸馏方法(即 TDC-Distill 和 GK-Refine),病理学模型将获得性能提升。

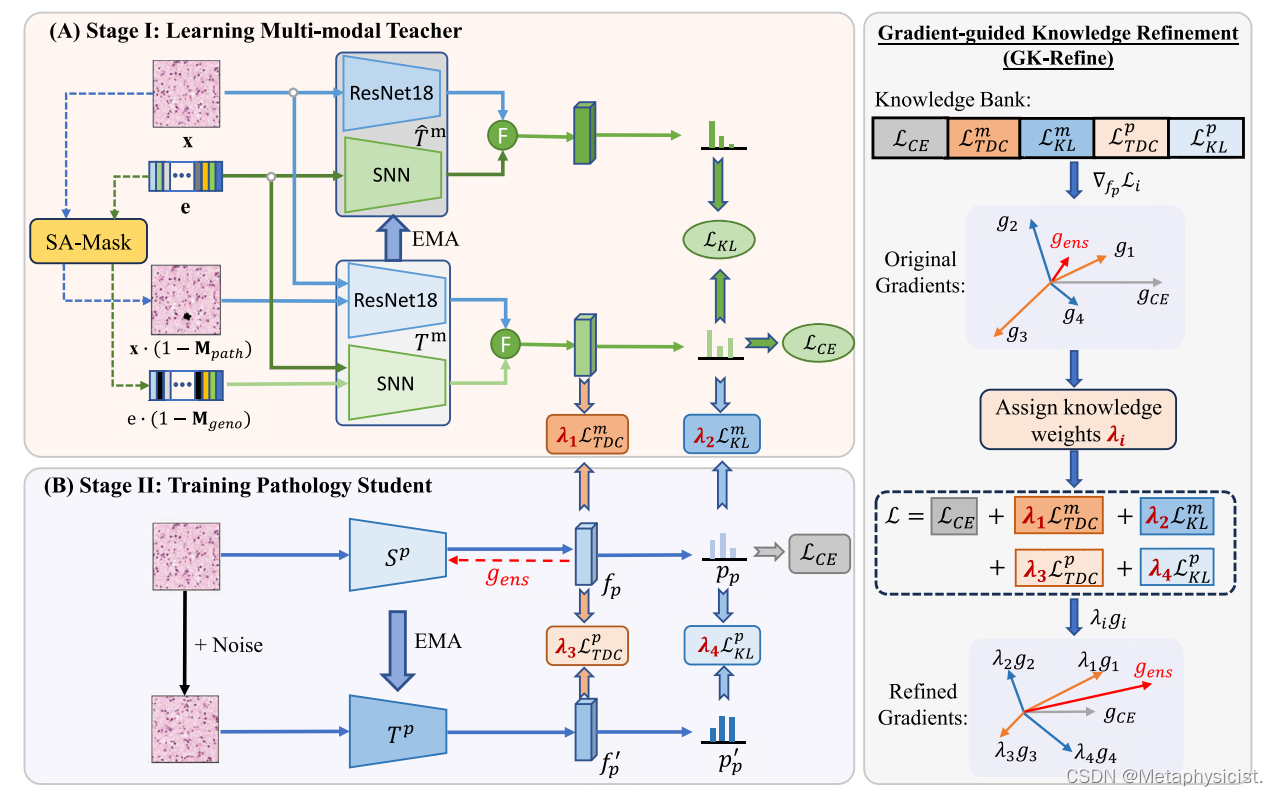

图 2.提出的显著性感知遮掩码(SA-Mask) 模块的插图。

图 3.提出的TDC-Distill模块的图示。(a) 对于学生模型中的查询,TDC-Distill 模块将其吸引到教师模型中及其相邻的正对,同时将其从负对中排斥。(b) 根据教师模型和学生模型之间的置信度差异对查询样本进行重新加权。

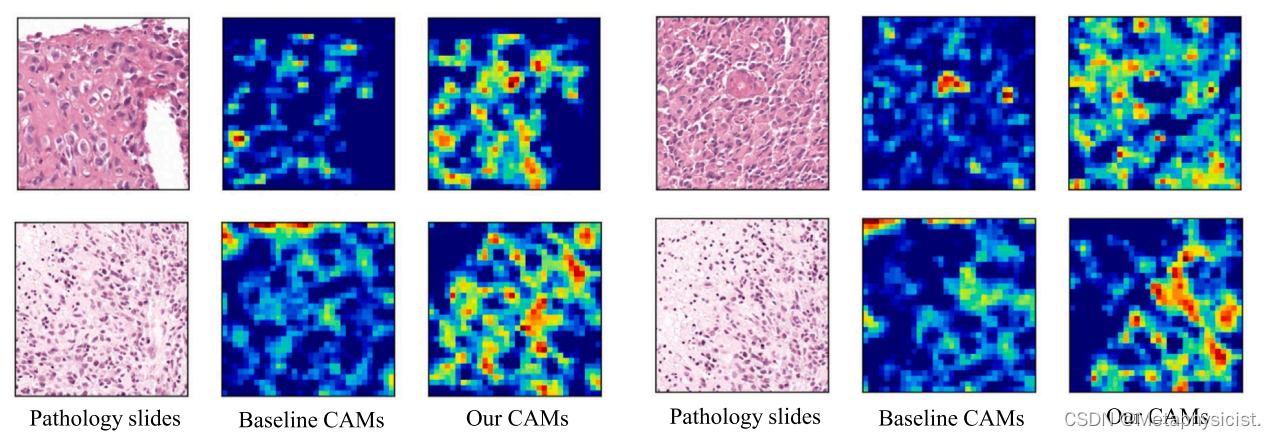

图 4.基线多模态教师和多模态教师使用 SA-Mask 策略训练获得的班级激活图 (CAM) 的可视化

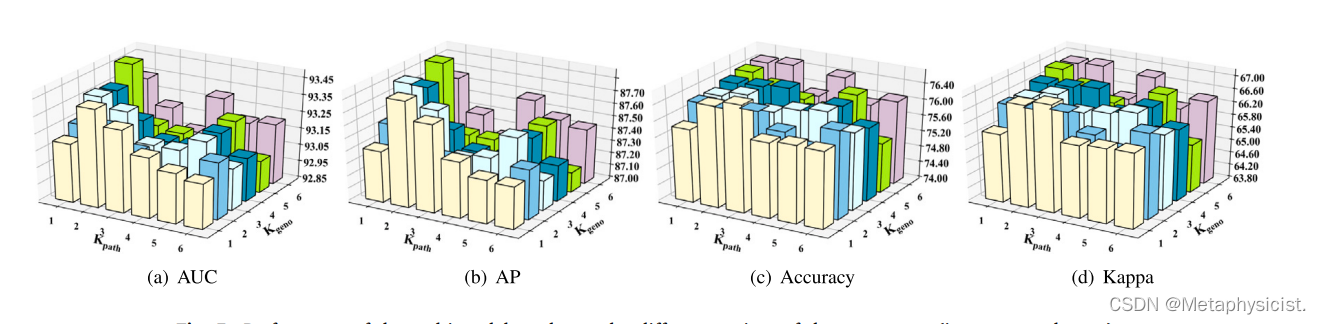

图 5.多模态教师在不同参数设置(即 Kpath 和 Kgeno)下的性能。

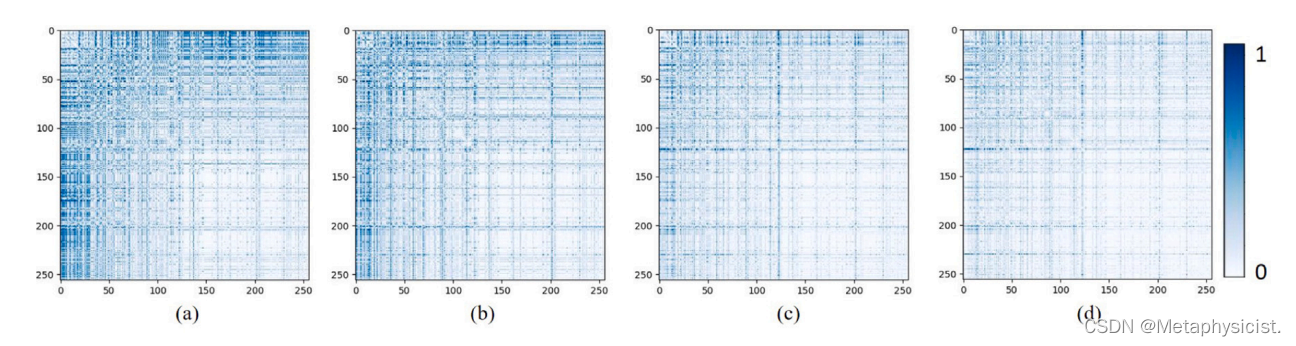

图 6.使用不同的蒸馏方法可视化教师模型和学生模型的相关矩阵之间的距离,包括 (a) 基线模型 (w/o KD)、(b) KL div (Hinton et al., 2015)、(c) CRD (Tian et al., 2019) 和 (d) 我们的 TDC-Distill 方法。较小的距离(即颜色较浅)表明 (d) 我们的 TDC-Distill 模块能够更有效地传授知识,并更好地协调教师和学生。

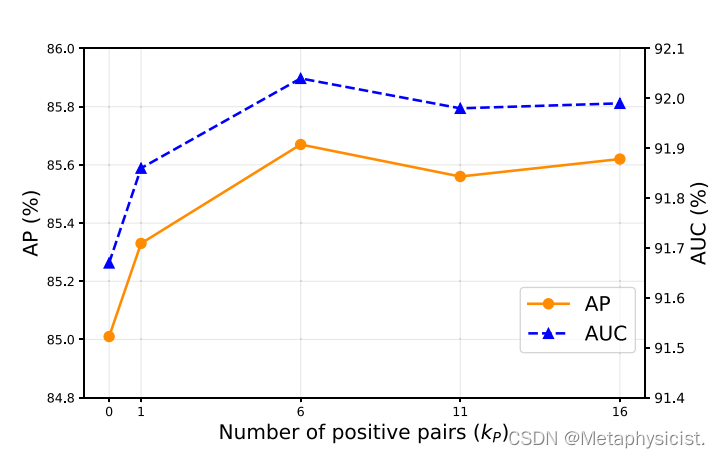

图 7.平均精度 (AP) 和 AUC w.r.t. 不同数量的正对 (kP)。

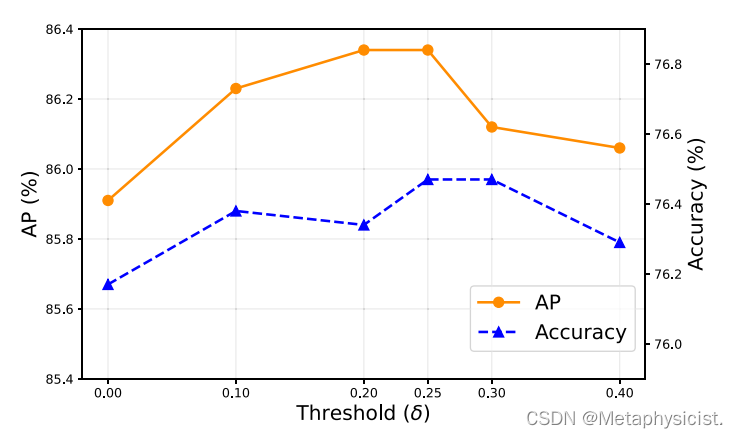

图 8.平均精度 (AP) 和神经胶质瘤分级精度与提出的 GK-Refine 模块中阈值 (δ) 的不同值不同。

3631

3631

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?