论文地址:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=11092578

针对Segment Anything Models在低质量图像上性能下降的问题,本文提出了GleSAM框架,通过生成性潜在空间增强技术,显著提升了模型在退化图像上的分割鲁棒性,同时保持了对清晰图像的泛化能力。

引言

Segment Anything Models(SAMs)作为基础分割模型,因其出色的零样本分割能力而在计算机视觉领域产生了重大影响。然而,当面对现实世界中常见的低质量图像(如噪声、模糊和压缩伪影等退化图像)时,SAMs的性能会显著下降,这严重限制了其在实际应用中的有效性。

传统方法通过基于蒸馏的一致性学习来增强退化鲁棒性特征,但在处理复杂退化图像时仍然面临挑战。本文提出的GleSAM(Generative Latent space Enhancement SAM)创新性地将生成扩散模型的强大能力整合到SAM的潜在空间中,通过重建高质量特征表示来改善分割性能。

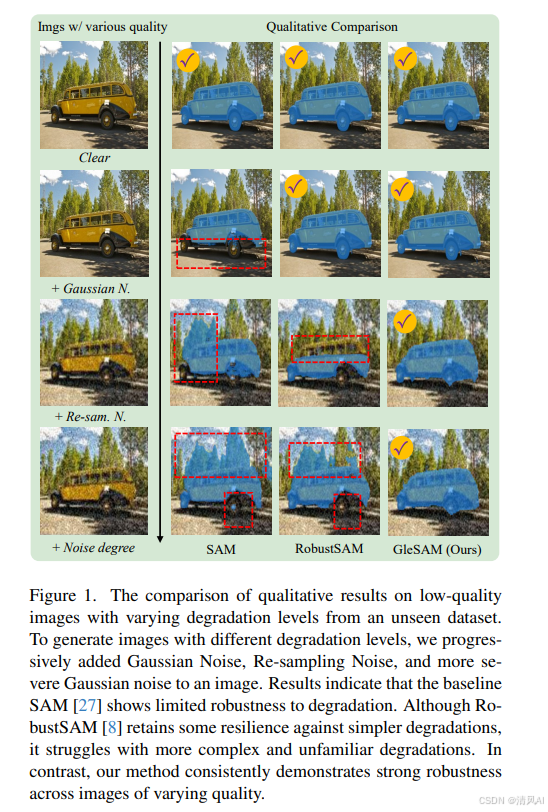

从图1可以看出,基线SAM在退化图像上表现出有限的鲁棒性,而我们的方法在各种质量图像上都保持了一致的强大鲁棒性。

方法概述

GleSAM的核心思想是利用预训练扩散模型的生成先验来增强SAM的潜在空间表示。整个

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

484

484

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?