人们倾向于仅使用Transformer的编码器而不使用解码器的原因:

-

无监督学习和特征提取:

在许多场景下,特别是在无监督学习或特征提取的任务中,人们更关心**数据的表示**而不是生成。Transformer的编码器可以提供对输入数据的强大表示,这些表示可以用于各种任务,例如聚类、分类或生成对抗网络(GAN)的生成器。因此,使用Transformer的编码器可以为许多任务提供有用的特征。 -

计算效率:

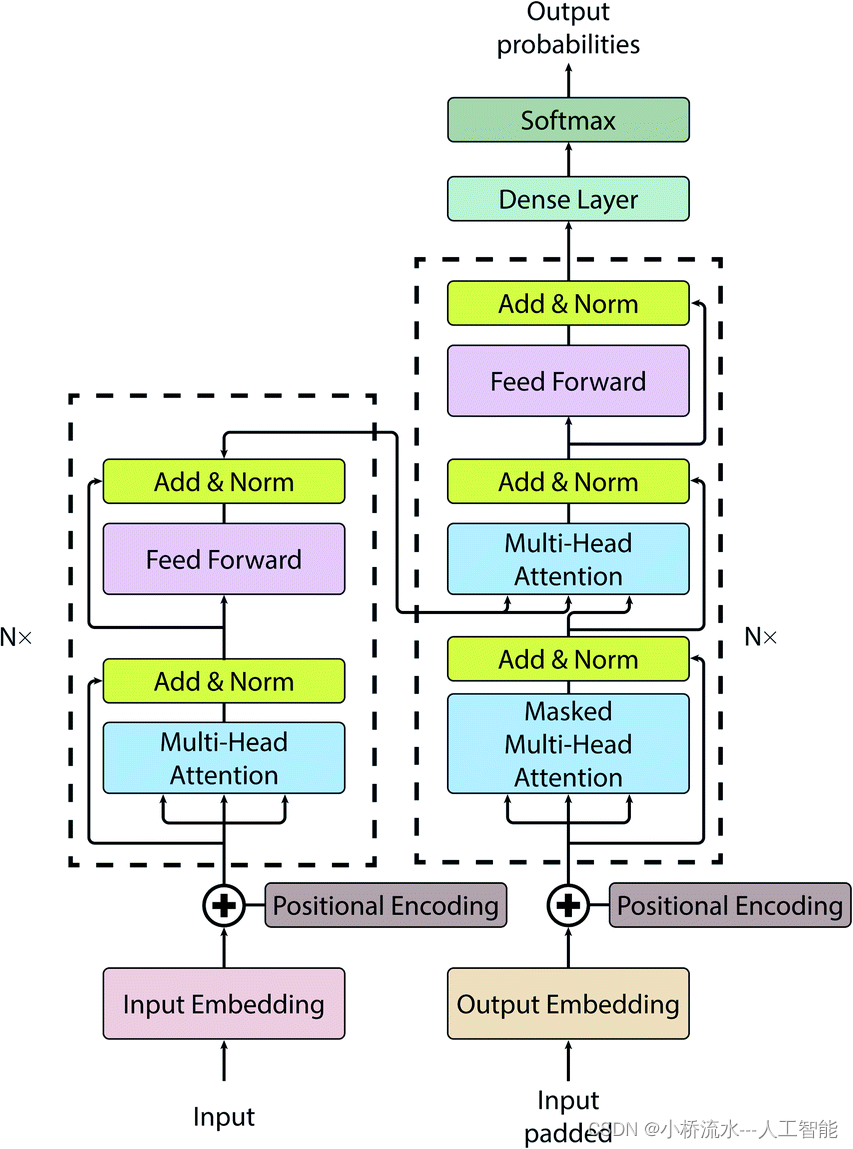

编码器部分通常比完整的Transformer模型更简单,并且由于不涉及解码器的自注意力和编码-解码注意力操作,因此计算成本更低。在一些资源有限的环境下,仅使用编码器可以提供更高的效率。 -

特定任务的需求:

在某些任务中,特别是那些不需要生成输出序列的任务中,解码器部分可能不是必需的。例如,当进行图像分类或语义分割时,只需将输入图像的特征表示传递给分类器或分割器,而不需要生成任何输出序列。 -

领域适应和迁移学习:

在某些情况下,人们只关心将预训练的Transformer模型应用于特定的领域或任务中。在这种情况下,他们可能只使用编码器部分,并且可以通过微调或其他领域适应技术来进一步优化模型以适应他们的任务。

652

652

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?