视觉空间与语义空间相互生成并利用循环一致损失

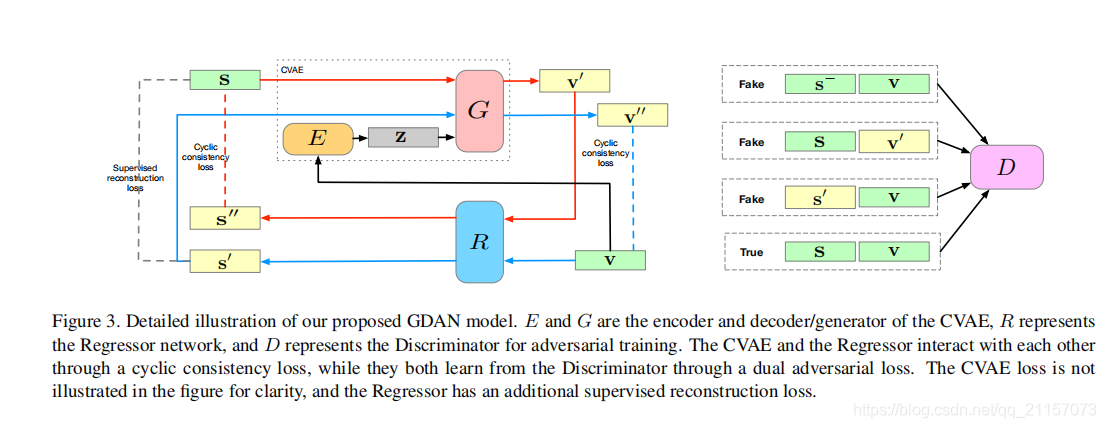

Generative Dual Adversarial Network for Generalized Zero-shot Learning

- 视觉 ——》语义——》视觉;语义——》视觉——》语义

- 使用cycleLoss衡量视觉——视觉;语义——语义的损失

- 使用Discriminator进行real/fake判别

- 在测试时,首先生成新的unseen类别特征,然后将生成的特征与seen特征融合,最后进行分类器的训练

Generative Model with Semantic Embedding and Integrated Classifier for Generalized Zero-Shot Learning

- 视觉——》语义——》视觉的映射

- 基于度量学习的Integrated Classifier模块,保证在测试新类时,无需生成大量的fake样本

CANZSL: Cycle-Consistent Adversarial Networks for Zero-Shot Learning from Natural Language

- 视觉——》语义——》视觉的映射

- 使用cycle consistency loss计算损失

- 语义表示使用文本,不是明确的semantic vector

Feature Generating Networks for Zero-Shot Learnin

比较靠前的使用对抗生成网络解决zero-shot,只有语义——》视觉。没有花狸狐哨的各种损失,最后测试阶段,也是通过生成unseen样本来解决。

Self-supervised Domain aware Generative Network for Generalized Zero-shot Learning

出发点:

使用自监督,产生attribute对应的anchor参照,配合生成网络将source data与target data区分开来(Domain aware)

自监督来自于所有类别共享的attribute分类权重,以此作为anchor调整生成特征,并配合两个损失完成训练。但是attribute权重是如何得到的???

关键点:

- domain aware 生成网络区别对待source data与target data

- 使用自监督产生anchor参照,重塑feature,使source feature与target feature分离

本文探讨了零样本学习中视觉与语义空间的相互转换,重点介绍了几种利用循环一致损失和生成对抗网络的方法,如Generative Dual Adversarial Network和Cycle-Consistent Adversarial Networks,它们在生成未见类别的特征方面表现突出。

本文探讨了零样本学习中视觉与语义空间的相互转换,重点介绍了几种利用循环一致损失和生成对抗网络的方法,如Generative Dual Adversarial Network和Cycle-Consistent Adversarial Networks,它们在生成未见类别的特征方面表现突出。

318

318

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?