期刊:ICCV

年份:2023

代码:https: //gitee.com/mindspore/models 和 https:// github.com/Carol-lyh/ECENet.

摘要

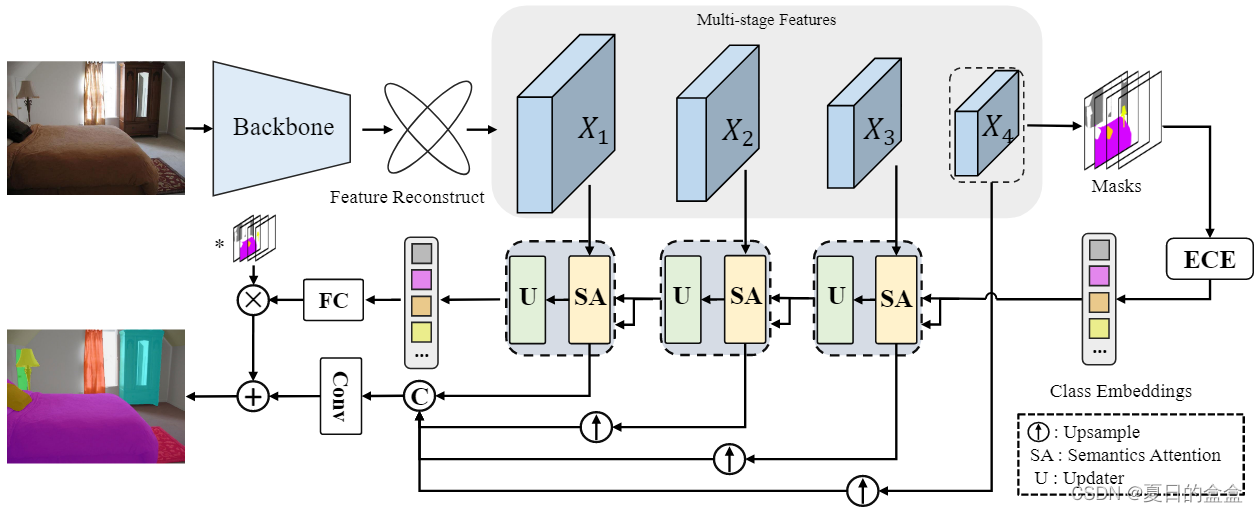

语义分割是一项计算机视觉任务,它将标签与图像中的每个像素相关联。现代方法倾向于将类嵌入引入语义分割中,以深度利用类别语义,并将监督类掩码视为最终预测。在本文中,我们探索了类嵌入的机制,并深入了解可以基于类掩码故意生成更明确和更有意义的类嵌入。根据这一观察,我们提出了一种新的分割范式ECENet,在该范式中,在与多阶段图像特征交互过程中显式获得和增强类嵌入。在此基础上,我们回顾了传统的解码过程,探索了分割掩码和类嵌入之间的倒信息流。此外,为了保证主干特征的可区分性和信息性,我们提出了一个特征重构模块,该模块将内在分支和多样化的分支结合在一起,以确保特征的多样性和冗余性的一致性。实验表明,我们的ECENet在ADE20K数据集上的性能优于同类产品,计算成本要低得多,并在PASCALContext数据集上实现了新的最先进的结果。

Introduce

动机:作者观察到,可以通过类别掩膜有意识地生成更明确和有意义的类别嵌入。

主要贡献:

- 颠覆了传统的解码过程,提出了显式且一致有意义的类别嵌入,明确定义的类嵌入的指导下,属于同一类别的区域倾向于组合在一起并返回增强的代表性特征。

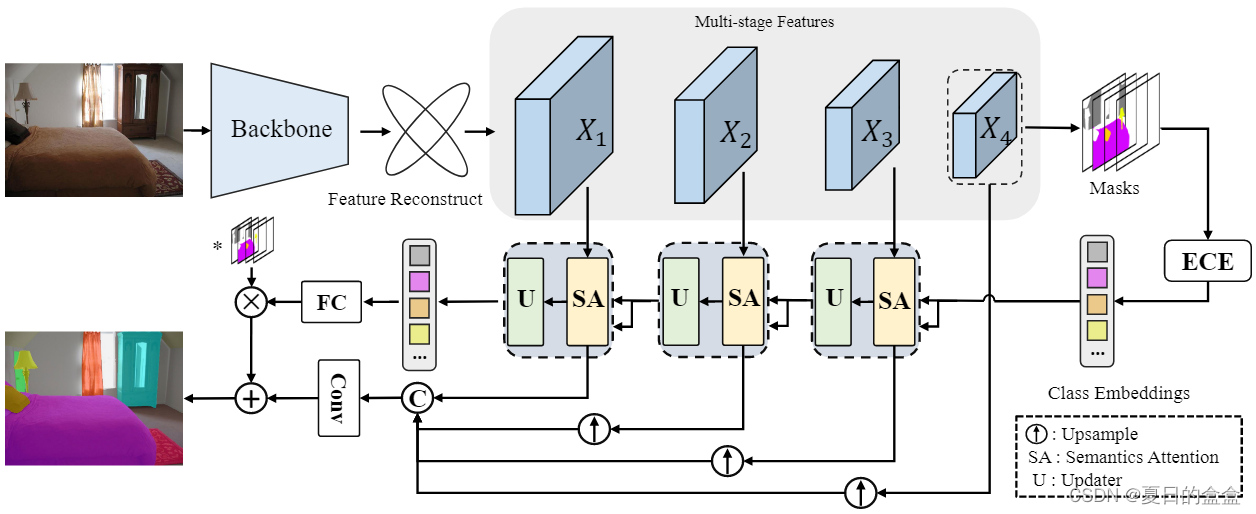

- 提出了基于这一洞见的ECENet网络,由FR、ECE和SAU组成,证明是有效和高效的。

- 在具有挑战性的基准测试中进行了广泛的实验,结果表明ECENet在常见分割数据集上取得了有竞争力的性能,并且计算成本更低。

Method

主要模块:

- 特征重建模块(Feature Reconstruction, FR):为确保来自主干网络的特征具有可判别性和信息性,作者提出了特征重建模块,该模块结合了内在和多样化的分支,确保特征的多样性和冗余性共存。

- 显式类别提取(Explicit Class Extraction, ECE):通过空间池化和单次线性投影,从掩膜中提取类别嵌入。

- 语义注意力与更新器(Semantics Attention & Updater, SAU):利用相似性图作为额外的掩膜,并通过门控机制进一步增强先前的类别嵌入。

2.1 Encoder

在这里引入了典型的分层变压器主干作为我们的编码器。然而,提出的方法也适用于普通 ViT 或 CNN 主干。

2.2 Feature reconstruction(FR)

问题识别:传统的卷积神经网络(CNN)通常缺乏对长距离依赖关系的捕捉能力,这限制了它们在语义分割任务中的表现。此外,特征图(feature maps)中的多样性和冗余性是成功网络的一个重要特征,但这些特征的控制往往难以捉摸。

FR 模块的目标:Feature reconstruction(FR) 模块旨在确保特征图具有更好的表示能力,这有助于后续获得高质量的语义嵌入。

模块设计:FR 模块包含两个主要分支:内在特征(intrinsic features)和多样化特征(diverse features)。

- 内在特征:通过 1x1 卷积后跟范数层提取每个阶段输出特征图的内在特征。这有助于提取特征图中最重要的部分。

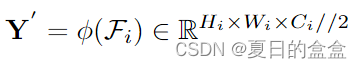

其中为backbone每个阶段输出特征图,经过处理之后通道数减少

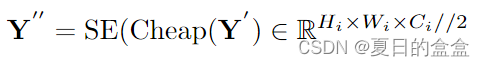

- 多样化特征:通过在内在特征上应用廉价的线性操作(如 GhostNet 中的操作)来增加特征的多样性。然而,我们认为这种转换是不可控的,这表明对信息特征的敏感性较低。因此,我们应用 Squeeze-and-Excitation(SE) 模块重新校准通道特征响应,确保更有用的特征被更多地利用。

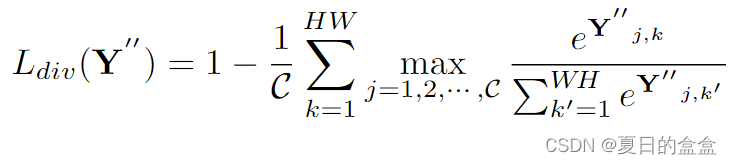

- 此外,对每个通道应用 Softmax 函数,以专门专注于最显着的区域。然后对特征图上的所有“max”值进行求和,目的是确保每个像素都被唯一地覆盖,特别是对于我们的像素级密集预测任务。

此时公式里面的C应该为原始通道数的一半 - 最后,将 Y' 和 Y'' 连接在一起并投影到初始形状。通过这种方式,我们确保每个阶段的代表性特征图中存在的多样性和冗余。

2.3 Explicit class extraction (ECE)

目的:ECE 模块旨在利用预测的掩膜来生成与类别明确相关的嵌入向量,这些嵌入向量在训练的早期阶段就具有一致和有意义的特征。

关键创新点:将信息流从传统的“从特征到掩膜”转变为“从掩膜到特征”,这允许模型利用掩膜中的类别信息来增强特征表示。

预测掩膜的生成:在特征重构之后,模型会生成一个统一的特征表示,其中

,C 是统一的维度,通常设置为 256,

和

分别是第 𝑖 阶段特征图的高度和宽度。

详细过程:

- 掩码生成:将线性变换应用于最后一阶段的特征映射

其中、

都为1 x 1卷积层的线性变换,此时

表示N个类别数的中间掩码,表示不同类别的潜在分布

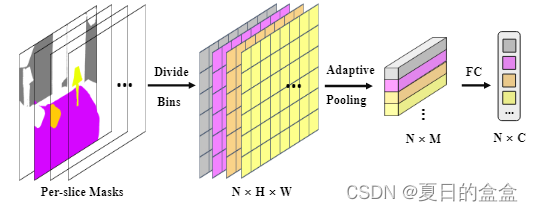

- ECE模块:

- 采用显式类提取模块,掩码的每个切片被划分为bins(以捕捉空间上的局部信息)。然后我们在每个空间 bin 中进行无参数池化以收集子区域表示。

其中使用空间金字塔池来维护局部和全局信息, ψ 是一个简单的线性变换 - 弥合分割掩码和类嵌入之间的差距,允许信息流反向获得显式类嵌入,而不是盲目随机初始化,这完成了最近分割任务中拼图的最后一块。

2.4 Semantics attention & updater (SAU)

目标:通过与显式类别嵌入的交互来加强特征图的语义表示,并更新类别嵌入以更好地捕捉不同尺度和上下文信息。

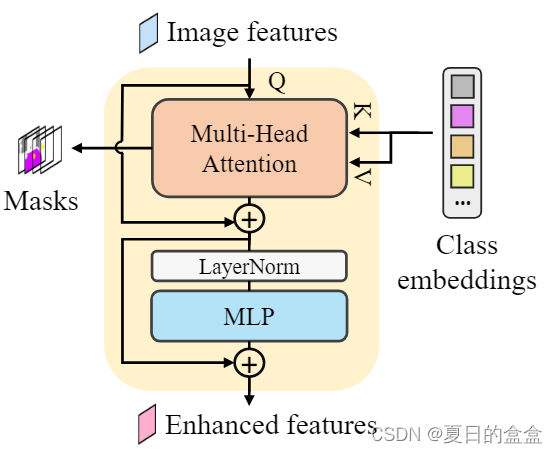

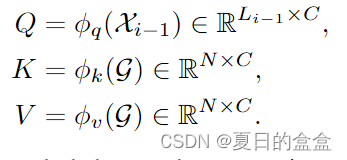

Semantics Attention(语义注意力):

- 早期的特征

作为查询,类嵌入

作为键和值。首先,应用线性变换形成查询(Q)、键(K)和值(V)

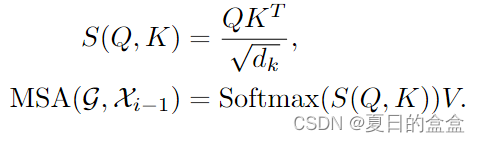

- 遵循缩放的点积注意力机制,Q 和 K 被交互以测量类特征相似度。相似度图和注意图计算如下:

其中,

,明确定义的类嵌入的指导下,属于同一类别的区域倾向于组合在一起并返回增强的代表性特征

- 应用三层的 MLP 块,采用 3×3 深度卷积,它考虑了零填充对泄漏位置信息的影响。在每个块之前应用LayerNorm (LN)。

Class Updater(更新类别嵌入):

明确定义的类嵌入最初来自最终阶段的特征。然而,在分割任务中,模型需要识别尺度变化的区域,这需要多尺度的空间信息增强。对于我们的显式类嵌入也是如此。

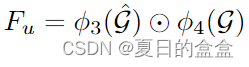

- 重塑并利用这个相似图作为新的生成掩码

- 使用显式类提取 (ECE) 模块来获得新获得的类嵌入

- 应用门控机制来进一步刷新以前的类嵌入。具体来说,我们首先将新的类与之前的类融合为

其中,

是线性变换

- 学习更新门 U 并与投影

相乘。最后,我们将其与之前的 G 相加以获得更新的类嵌入

其中 σ 是 Sigmoid 函数,ψ1,ψ2 是全连接 (FC) 层,然后是 LayerNorm (LN),

这种语义注意和更新器模块在剩余的多阶段特征上逐步重复,从而产生信息量很大的类嵌入。此外,在 ClassFeature 交互过程中增强了具有代表性的图像特征,消除了不同层的语义差距。

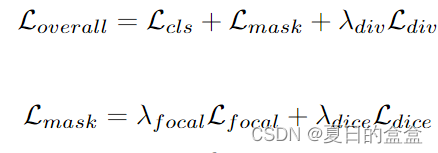

2.4 损失函数

分类损失 () 由 CrossEntropy 损失实现,掩码相加,由掩码损失 (

) 监督,掩码损失是焦点损失和骰子损失的线性组合乘以超参数

和

。

应用于每个阶段的“多样化”分支特征。下一节的实验表明,这种设计是有效的并且效果很好。

Result

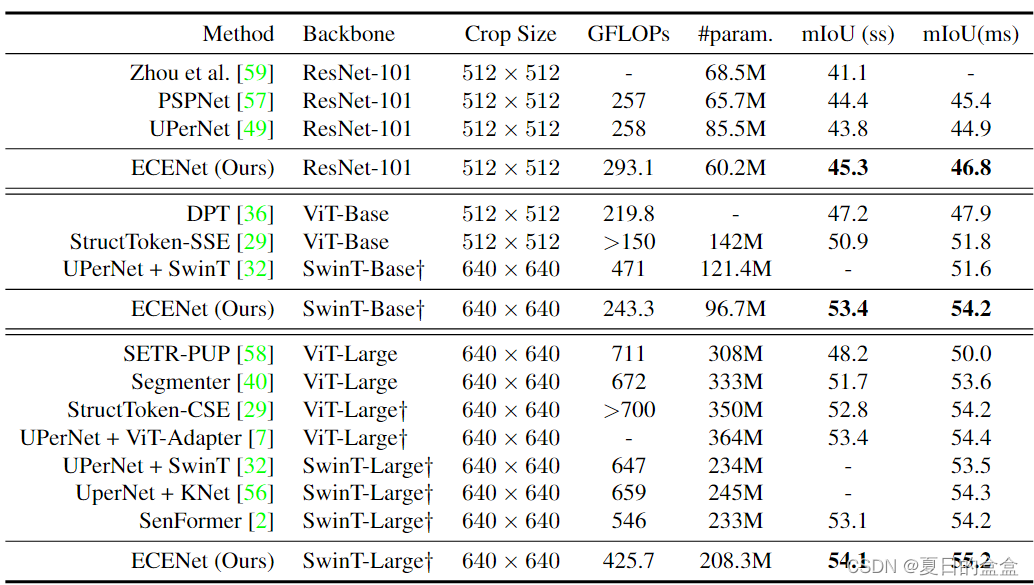

ADE20K val.split的实验结果。†表示模型的权重在 ImageNet-22K 上进行了预训练。GFLOPs是用给定作物大小的单尺度推理来衡量的。请注意,我们还使用扩张的 ResNet-101 作为主干。

Conclusion

这项工作利用显式类嵌入来提高语义分割的性能。与现有的随机初始化类嵌入是内容忽略和隐式的,我们使用粗略预测的分割掩码生成它们,这使得它们最初保持一致和有意义。此外,在明确定义的类嵌入的指导下,属于同一类别的特征图中的区域倾向于组合在一起并返回增强的代表性特征。显式类嵌入还缓解了不同层的语义差距。此外,我们还提出了一种新的特征重构模块,该模块保证了主干特征的可区分性和信息性。我们的方法在 PASCAL-Context 上以更少的计算成本实现了新的最先进的性能。值得注意的是,我们相信这可能会激发更多兴趣来揭示类别语义背后的真实含义。

414

414

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?