资讯

人脸识别315躺枪,支付宝、商汤、云从等回应

2017年的“315”落下帷幕,人脸识别技术公司纷纷躺枪。16日一大早,大家纷纷发表声明,表示自家的人脸识别技术还是相当安全的。

晚会现场,主持人现场演示了攻破人脸识别手段。在演示过程中,一张他人的静态自拍照,通过技术处理,可以变成能眨眼睛、能微笑的“伪活人”。甚至还可以利用这张自拍照,借助3D建模技术,让自己“变脸”成另一个人,轻易骗过登录系统,成功“黑”进对方账号。

百度在节目播出后5分钟内立刻作出回应——邀请百度深度学习实验室主任林元庆,在百度科技园的人脸识别闸机做一次亲身验证,看百度人脸识别系统究竟能否被一段视频“骗过”。阿里巴巴的支付宝也很快作出回应:“你们都觉得我躺枪了吗?”

3月16日早,我们看到国内众多人脸识别创业公司的回应,包括云从科技、商汤科技等。

百度推出 AI 语音转录软件 SwiftScribe

百度深度学习研究院推出百度第一个 AI 驱动的转录软件 SwiftScribe 的 beta 版。SwiftScribe 的核心技术是百度的语音识别引擎 Deep Speech 2。它的神经网络使用数千小时的有标注语音数据训练,学习将声音与特定的词汇和短语对应起来。除了先进的 ASR 技术,百度还设计了一个直观的快捷键和创新的人机交互系统,以解决不连续的问题,这是用户在转录时的最大障碍之一。

百度 SVAIL 开发了 SwiftScribe 的各个组件,包括语音识别系统和用户界面。这种方法的一个很大的有点是,当用户在使用 SwiftScribe 进行转录和编辑时,系统同时也在学习和提升。正是这种精细的端到端的方法,使 SwiftScribe 不同于市场上其他同类产品。

DeepMind 让AI 拥有记忆并实现序列学习

在 AlphaGo 获胜一周年之际,DeepMind 发表最新研究成果,让神经网络成功在学习新任务的同时,不忘老的任务,向着自适应学习迈出重要一步。

计算机程序在学习执行一项任务后,通常也很快就会忘记它们。DeepMind 在最新的 PHAS 论文中,提出可以修改学习规则从而克服程序遗忘的方法,让程序在学习一个新任务时能够记得旧的任务。这是程序朝向更智能化,能够持续、自适应地学习迈出的重要一步。

Keras 2发布:实现与TensorFlow的直接整合

Keras 在 2015 年 3 月首次推出,现在用户数量已经突破了 10 万。其中有数百人为 Keras 代码库做出了贡献,更有数千人为 Keras 社区做出了贡献。

近日,Keras 2推出,它带有一个更易使用的新 API,实现了与 TensorFlow 的直接整合。这是在 TensorFlow 核心整合 Keras API 所准备的重要一步。

AI创新者

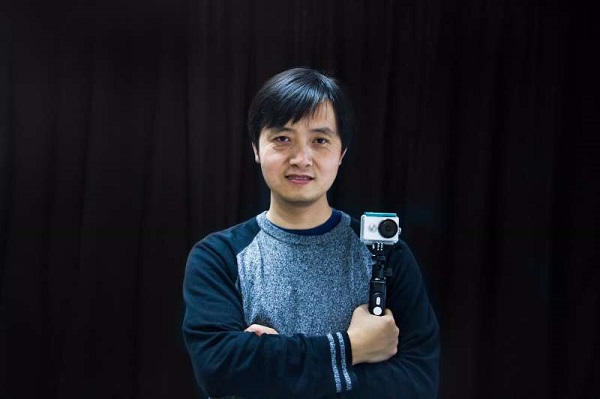

小蚁首架张骏峰:让图像AI人尽可用

张骏峰,小蚁科技首席架构师,负责小蚁AI图像相关算法架构。张骏峰于2015年加入小蚁,此前,张就职于微软长达14年,参与过Windows, .Net Framework, MSN, Office, Lync, Skype等产品的研发工作。

本文中,张骏峰就小蚁的图像算法,包括:应用在小蚁智能摄像机及行车记录仪上的图像分割、物体识别、目标跟踪算法,以及应用在小蚁微单APP上的图像风格迁移技术展开探讨。列举了小蚁在这两方面的研发过程中采取的方案及遇到的突破。

技术

无人驾驶硬件平台

本文是无人驾驶技术系列的第十篇,是这一系列目前为止阐述最全面的一篇。着重介绍无人驾驶硬件平台设计。无人驾驶硬件系统是多种技术、多个模块的集成,主要包括:传感器平台、计算平台、以及控制平台。本文将详细介绍这三个平台以及现有的解决方案。希望本文对无人驾驶从业者以及爱好者选择硬件的时候有帮助。

作者唐洁,华南理工大学计算机科学与工程学院副教授;刘少山,PerceptIn联合创始人。加州大学欧文分校计算机博士,

Google Brain对NMT训练成本过高的几点发现

在过去几年里,基于神经机器翻译(NMT)技术的产品系统被越来越多部署在终端客户端中,NMT本身也因此获得了巨大进步。但目前,NMT构架还存在着一个很大的缺点,即训练它们的成本太高,尤其是GPU的收敛时间,有时会达到几天到数周不等。这就使得穷举超参数搜索(exhaustive hyperparameter search)的成本和其他常见神经网络结构一样,让人望而却步。

为此,Google Brain首次对 NMT 架构的超参数进行了大规模分析,报告了数百次实验测试的经验结果和方差数(variance numbers),这相当于在标准WMT英译德任务上运行超过250,000 GPU小时数的效果。从实验结果中,提出了有关建立和扩展NMT构架的创新观点,也提供了一些实用建议。

- 使用 2048 维的大型嵌入(embeddings)有最优实验结果,不过优势不大;仅有 128 维的小型嵌入似乎也有足够的能力去捕捉绝大多数必要的语义信息。

- LSTM Cell 始终比 GRU Cell表现得好。

- 2-4 层的双向编码器性能最佳。更深层的编码器在训练中不如2-4层的稳定,这一点表现得很明显。不过,如果能接受高质量得优化,更深层的编码器也很有潜力。

- 深度 4 层解码器略优于较浅层的解码器。残差连接在训练 8 层的解码器时不可或缺,而且,密集的残差连接能使鲁棒性有额外增加。

- 把额外的关注度参数化(Parameterized additive attention),会产生总体最优结果。

- 有一个调适良好、具有长度罚分(length penalty)的集束搜索(beam search)很关键。5-10集束宽度搭配1.0长度罚分的工作效果好像不错。

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?