最近,大规模语言模型(LLM)爆火,DeepSeek、ChatGPT、GPT-4、文心一言等频繁出现在大家的视野里,它们强大的语言理解和生成能力,让不少人都感到惊艳。今天,咱们就深入探讨一下大规模语言模型,看看它到底是什么,经历了哪些发展阶段。

一、什么是大规模语言模型

大规模语言模型(Large Language Models,LLM),也叫大语言模型或大型语言模型,是用包含数百亿以上参数的深度神经网络构建的语言模型。它通常采用自监督学习方法,通过大量无标注文本进行训练。

2018 年以来,Google、OpenAI、Meta、百度、华为等公司和研究机构纷纷发布了 BERT、GPT 等多种模型。这些模型在几乎所有自然语言处理任务中都表现出色。2019 年大模型迎来爆发式增长,2022 年 11 月 ChatGPT 发布后,更是引发全球关注。用户能用自然语言与系统交互,完成问答、分类、摘要、翻译、聊天等各种任务,这充分展示了大语言模型强大的世界知识掌握能力和语言理解能力。

语言模型

要理解大语言模型,得先了解语言模型的基本概念。

语言模型(Language Model,LM)目标是建模自然语言的概率分布 词汇表 V 上的语言模型由函数 P(w1w2...wm) 表示,表示词序列w1w2...wm作为一个句子出现的可能性大小。对于任意词串 w1w2...wm∈ V+,则有 P (w1w2...wm ) ⩾ 0,并且对于所有词串,函数 P (w1w2...wm ) 满足归一化条件:

![]()

由于联合概率 P (w1w2...wm ) 的参数量十分巨大,直接计算 P (w1w2...wm ) 非常困难。如果把w1w2...wm看作一个变量,那么它具有 |V|m 种可能。 按照《现代汉语词典(第七版)》包含7万词条,句子长度按照20个词计算,模型参数量达到7.9792* 1096的天文数字。

为了减少 P (w1w2...wm ) 模型参数量,可以利用句子序列通常情况下从左至右的生成过程进行分解,使用链式法则得到:

由此, w1w2...wm的生成过程可以看作单词逐个生成的过程。首先生成 w1,之后根据 w1 生成 w2,再根据 w1 和 w2 生成 w3,以此类推,根据前 m − 1 个单词生成最后一个单词 wm

不过,仅靠这个过程,模型参数量还是没下降,P (wm| w1w2...wm-1) 的参数量依旧庞大。于是,人们进一步简化模型,出现了 n 元语言模型和基于分布式表示和神经网络的语言模型。

语言模型的训练过程虽然采用的有监督方法,但是由于训练目标可以通过原始文本直接获得,从而使得模型的训练仅需要大规模无标注文本即可。语言模型也成为了典型的自监督学习(Self-supervised Learning)任务。

n 元语言模型

语言模型通常用于反映一个句子出现的可能性,给定由单词序列w1w2...wn组成的句子S,可以利用语言的特性,使用链式法分解则得到:

其中,词 wi 出现的概率受它前面的 i − 1 个词 w1w2...wi−1 影响,我们将这 i − 1 个词 w1w2...wi−1称之为词 wi 的历史。 如果历史单词有 i − 1 个,那么可能的单词组合就有 |V|i−1 种。 最简单的根据语料库对 P (wi|w1w2...wi−1) 进行估计的方法是基于词序列在语料中出现次数(也称为频次)的方法:

随着历史单词数量增多,绝大多数的历史并不会在训练数据中出现,这也意味着 P (wi|w1w2...wi−1) 就很可能为 0,使得概率估计失去了意义。为了解决上述问题,可以进一步假设任意单词 wi 出现的概率只与过去 n − 1 个词相关

满足上述条件的模型被称为n元语法或n元文法(n-gram) 模型。其中 n-gram 表示 n 个连续单词构成的单元,也被称为n元语法单元。

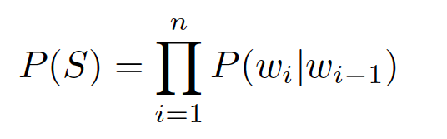

以二元语法为例,一个词的概率只依赖于前一个词,则句子 S 的出现概率可以表示为:

尽管 n 元语言模型能缓解句子概率为 0 的问题,但语言是由人和时代创造的,具备无穷的可能性,再庞大的训练语料也无法覆盖所有的 n-gram,而训练语料中的零频率并不代表零概率。因此,需要使用平滑技术(Smoothing)来解决这一问题,所以需要平滑技术调整概率,让整体概率分布更均匀。

平滑是指为了产生更合理的概率,对最大似然估计进行调整的一类方法,也称为数据平滑(Data Smoothing)。平滑处理的基本思想是提高低概率,降低高概率,使整体的概率分布趋于均匀。

但 n 元语言模型存在缺点,n元语言模型从整体上来看与训练语料规模和模型的阶数有较大的关系,不同的平滑算法在不同情况下的表现有较大的差距。

平滑算法虽然较好解决了零概率问题,但是基于稀疏表示的n元语言模型仍然有三个较为明显的缺点:

(1)无法建模长度超过n的上下文;

(2)依赖人工设计规则的平滑技术;

(3)当n增大时,数据的稀疏性随之增大,模型的参数量更是指数级增加,并且模型受到数据稀疏问题的影响,其参数难以被准确学习。

此外,n元文法中单词的离散表示也忽略了单词之间的相似性

基于分布式表示和神经网络的语言模型

为解决这些问题,Bengio等人在2000年提出了使用前馈神经网络对![]() 进行估计的语言模型。

进行估计的语言模型。

词的独热编码被映射为一个低维稠密的实数向量,称为词向量(Word Embedding)。

循环神经网络、卷积神经网络、端到端记忆网络等神经网络方法都成功应用于语言模型建模。

相较于n元语言模型,神经网络方法可以在一定程度上避免数据稀疏问题,有些模型还可以避免对历史长度的限制,从而更好建模长距离依赖关系。这类方法通常称为神经语言模型(Neural Language Models,NLM)。

循环神经网络语言模型由三部分组成:输入层、隐藏层和输出层

深度神经网络训练需要采用有监督方法,使用标注数据进行训练,因此,语言模型的训练过程也不可避免需要构造训练语料。 但是由于训练目标可以通过无标注文本直接获得,从而使得模型的训练仅需要大规模无标注文本即可。语言模型也成为了典型的自监督学习(Self-supervised Learning)任务。 互联网的发展,使得大规模文本非常容易获取,因此训练超大规模的基于神经网络的语言模型也成为了可能。

预训练语言模型

以ELMo为代表的动态词向量模型开启了语言模型预训练的大门。此后,以GPT和BERT为代表的基于Transformer 架构的大规模预训练语言模型的出现,使自然语言处理全面进入预训练微调范式新时代。这类方法通常称为预训练语言模型(Pre-trained Language Models,PLM)

2020 年,OpenAI 发布了由包含1750 亿参数的神经网络构成的生成式大规模预训练语言模型GPT-3(Generative Pre-trained Transformer 3)。开启了大语言模型的新时代。在不同任务上都进行微调需要消耗大量的计算资源,因此预训练微调范式不再适用于大语言模型。 通过语境学习(In-Context Learning,ICL)等方法,直接使用大语言模型就可以在很多任务的少样本场景下取得很好的效果。此后,研究人员提出了面向大语言模型的提示词(Prompt)学习方法、模型即服务范式(Model as a Service,MaaS)、指令微调(Instruction Tuning)等方法。

Kaplan 等人在中提出了缩放法则(Scaling Laws),指出模型的性能依赖于模型的规模,包括参数数量、数据集大小和计算量,模型的效果会随着三者的指数增加而线性提高。大语言模型的缩放法则如下:

综上所述:以 ELMo 为代表的动态词向量模型开启了语言模型预训练的大门,随后基于 Transformer 架构的大规模预训练语言模型 GPT、BERT 等出现,自然语言处理进入预训练微调范式新时代。2020 年,OpenAI 发布 GPT-3,开启大语言模型新时代。由于微调大语言模型计算资源消耗大,研究人员提出语境学习、提示词学习方法、模型即服务范式、指令微调等新方法。Kaplan 等人提出缩放法则,指出模型性能依赖于模型规模,包括参数数量、数据集大小和计算量,三者指数增加时模型效果线性提高。

二、大语言模型发展历程

大语言模型发展虽不到五年,但速度惊人,截至 2023 年 6 月,国内外已发布超百种大模型。其发展可分为基础模型阶段、能力探索阶段和突破发展阶段。

基础模型阶段(2018 年 - 2021 年):2017 年,Vaswani 等人提出 Transformer 架构,在机器翻译领域取得突破。2018 年,Google 提出 BERT,OpenAI 提出 GPT-1,开启预训练语言模型时代。2019 年,OpenAI 发布 GPT-2(参数量 15 亿) ,Google 发布 T5 模型(参数规模 110 亿)。2020 年,OpenAI 发布 GPT-3,参数量达 1750 亿。这一阶段主要研究语言模型本身,包括不同模型结构,模型参数量在 10 亿以上时,微调计算量高,影响力不如 BERT 类模型。

能力探索阶段(2019 年 - 2022 年):大语言模型难以针对特定任务微调,研究人员开始探索新方法。2019 年,Radford 等人用 GPT-2 研究大语言模型零样本任务处理能力 ,Brown 等人在 GPT-3 上研究语境学习少样本学习方法 。指令微调将多种任务统一为生成式自然语言理解框架并微调。2022 年,Ouyang 等人提出 InstructGPT 算法(“有监督微调 + 强化学习”)。这些方法提升了模型在零样本和少样本学习的性能。

突破发展阶段(2022 年 11 月至今):2022 年 11 月 ChatGPT 发布,通过简单对话框就能实现多种自然语言处理功能。2023 年 3 月 GPT-4 发布,有明显进步,具备多模态理解能力,在多种基准考试测试中表现出色。各大公司和研究机构纷纷发布类似系统,如 Google 的 Bard、百度的文心一言、科大讯飞的星火大模型等,2025 年 1 月 26 日,DeepSeek大模型引爆全球。

(DeepSeek介绍与部署_deepseek私有化部署的出处和背景介绍-CSDN博客)

三、国家备案AI大模型汇总

截止到2025年3月底,国内已经有303个大模型服务备案,信息地址如下(自行下载查看):

大规模语言模型发展到现在,已经取得了巨大的成就,但也面临着诸多挑战,比如模型的可解释性、数据隐私问题等。未来,大语言模型会如何发展,又会给我们的生活带来哪些新的变化?让我们一起拭目以待!希望这篇文章能让大家对大规模语言模型有更深入的了解,欢迎在评论区分享你的看法和疑问。

8117

8117

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?