AURELION-概述

为了实现物理级别传感器仿真,dSPACE研发了AURELION软件。该软件用来支持基于物理渲染的Camera模型、Lidar的3D点云仿真和Radar射线跟踪与距离多普勒图谱绘制。

而传感器强度,依据线束的几何路径和材质的反射率。基于多普勒效应仿真,可以搭建聚类和原理仿真。关键技术点见如下:

用集成的物理模型实现非真实的3D环境以及动画显示

基于GPU的物理传感器模型仿真

全覆盖的灯光和天气条件仿真

AURELION-基于物理的传感器仿真模型

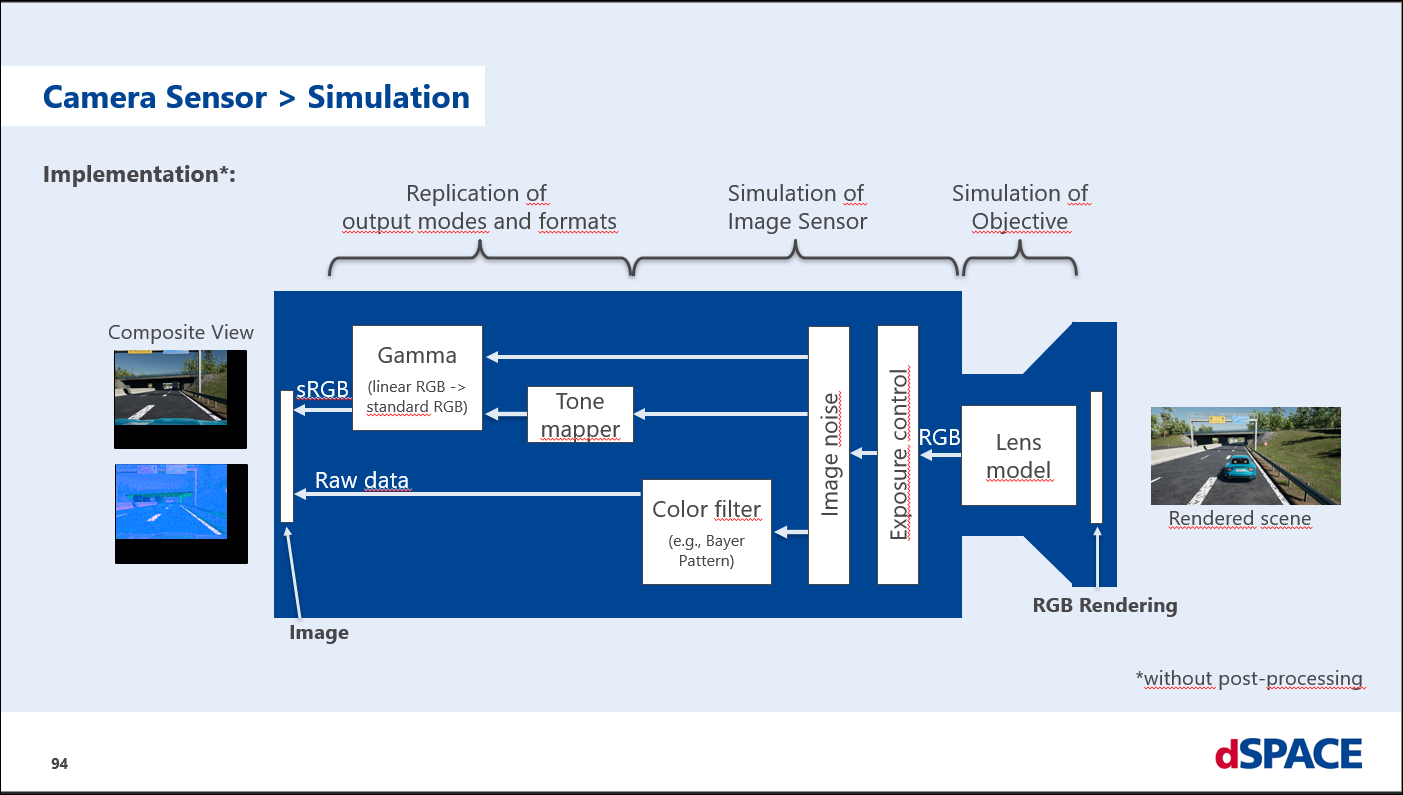

摄像头传感器模型:基于物理渲染和逼真的光照配置以及镜头轮廓配置,实现图像修改和故障注入,以及语义分割和边界框路面真值数据计算。

雷达传感器模型:

支持雷达信道极化运算,

可实现镜面反射和漫反射,

支持射线多路径传播的设置,

支持与每个物体交互产生自适应射线反射

激光雷达传感器模型:

支持可扩展的点云数据和原始数据输出

支持扫描式传感器和基于闪光的传感器模型

支持滚动快门效果

支持导入扫描模式

AURELION--Camera sensor特性

AURELION使用Epic Unreal引擎创建照片,原理是基于物理渲染(PBR),灯光反射是基于实际世界的材质属性和双向分布函数(BDF)来实现。

1. 支持镜头畸变仿真-Lens Distortion:

透镜径向畸变(例如鱼眼镜头的桶形畸变和长焦镜头的枕形畸变)

计算径向畸变使用的是Adobe直线几何失畸变模型和鱼眼几何畸变模型

2. 支持伽马编码仿真-Gamma Encoding

γ编码(这种根据人眼敏感度,将较暗的用较大的区间来表示,较亮的用较小的区间来表示的变换,就是伽马编码(gammar encoding))

使用Gamma Encoding/ γ编码,将线性RGB转换为sRGB线性空间存储,用于在AURELION界面输出显示

伽马编码的应用是为了让视野中的物体可以对用户和OTA仿真传感器同时可见

3. 支持曝光控制仿真-Exposure Control(配置曝光控制在AURELION应用和显示)

AURELION曝光控制器通过创建和分析图像对数亮度值的柱状图,来计算曝光值。

可以设置自动或者手动实现曝光控制

手动计算曝光值,需要在JSON文件中中设置曝光时间(/s)、快门速度和以ISO值表示的胶片感光度

4. 支持色调映射仿真-Tone Mapping

采用HDR(High Dynamic Range)渲染出来的亮度值会超过显示器能够显示最大值,此时我们需要将光照结果从HDR转换为显示器能够正常显示的LDR,这一过程我们通常称之为Tone Mapping。

5.支持镜头光晕仿真-Lens Flare

镜头光晕通常发生在相机镜头对准明亮光源的方向时,例如,太阳或汽车前灯。镜头耀斑会引起眩光,由于对比度和色彩饱和度降低,图像似乎被冲淡或漂白。

AURELION使用虚幻引擎为相机传感器的图像添加人工彩色反射点。客户可以指定一个像素强度阈值,该阈值确定镜头耀斑场景中的光源。场景中超过这个阈值的每个像素都会产生耀斑。

6.支持Camera传感器的图像噪声仿真-Camera Sensor Image Noise

相机传感器图像噪声是一种图像扰动效应,可以由例如来自相机图像传感器的电子信号或光子的量化引起,这被称为拍摄噪声。

光子发射噪声依赖于单个像素点的照明强度。它会导致图像像素的颜色、强度和亮度偏差。图像也可能出现颗粒状。环境噪声参数可以设置电子源噪声,亮度噪声参数可以设置光子散射噪声。

客户可以使用环境噪声和亮度噪声参数指定相机传感器图像噪声。环境噪声采用高斯分布模型,用均值和标准差参数化。亮度噪声基于泊松分布,它可以近似为高斯分布,因为光子的数量足够大。

7.支持原始数据输出仿真-Raw Data Output

摄像头原始数据输出呈现在AURLEION中彩色滤镜图像,此原始数据输出必须由去马赛克算法处理才能接收 RGB 颜色空间中的强度的颜色滤镜图案。

去马赛克算法的目标是从覆有滤色阵列(Color filter array,简称CFA)的感光元件所输出的不完全色彩取样中,重建出全彩影像,即重建出各像素完整的RGB三原色组合。该算法利用周围相同颜色的像素去估计一个特定像素的组成数值。

滤色图案配置可以指定图案的每个像素的强度,以指定Bayer图案或应用CYGM过滤器。

8. 支持Camera的深度、光流、边界框的仿真-the Depth, Optical Flow, and Bounding Boxes Output

速度(Optical flow-光流)是测量场景中物体相对于摄像机传感器运动的速度和运动方向。

AURELION-- Camera sensor configuration

1. Imager(ISO,cropFactor,colorFilterArray,noise);

2.lens(aperture光圈、shutterSpeed、focalLength、distortion、lensFlare);

3.Exposurecontrol(mode(auto/manual)、exposureCompensation);

4.output(model(sRGB/RAW)、Ground truth data、gammaEncoding、toneMappingEnabled );

5. Real-time postprocessing (camera、Radar、Lidar);

6. Graphics (renderTargetResolutionEstimation 、 supersamplingFactor);

7.Visualrepresentation in the 3‑D scene (frustum 、fovProjection);

AURELION - Lidar

Principles of Lidar Sensors and Measuring Sensor Data

1.可视范围:水平360度、垂直+/-40度、探测范围120m;

2.使用905nm和1550nm波长的红外光;发射光束是一种近红外光,属于电磁波普的可视范围;

3. 通过测量反射光,可以计算物体的反射率;

4. GPS/INS 定位数据可以与lidar数据融合;

Requirements and Features of the Lidar Sensor Model in AURELION (AURLEION提供的Lidar商业化,符合工厂生产标准)

1. Requirements : AURELION可以提供lidar可视范围内多个物体的速度、距离、角度和反射率;

2. Scene and traffic objects特征:射线追踪器可以识别周围的场景和交通物体生成3-D点云,从而获取到物体表面的三维网格包含纹理信息和材质ID;

3. Object materials-物体材质特征:Lidar传感器模型可以根据测量方式的设定和材质数据库中定义的BRDF公式,来获取相关数据信息。 BRDF理论依据光源照射到物体表面产生的以反射光线强度来设定,此外,BRDF也需要根据光波长特性来设定,即每一个BRDF公式只能针对一种波长(AURELION预设了905nm波长的BRDF)。镜面反射、漫反射(朗伯特)反射、逆反射;

4.Sensor range -传感范围:Lidar传感器3D点云创建的立体空间

5.Custom launch pattern-自定义扫描模式:Flash 和 Scanning (可设置可视角度、区间、时间偏移和射线的强度系数)

6. Launch time offset for moving objects-动态物体启用时间偏移:时间偏差设定针对高速移动物体,因为3D点云不可以直接显示完全相同时间点的场景。而Camera使用卷帘快门的方式来消弱该影响;

7.Ghost targets-鬼影点仿真:基于路测环境下Lidar射线产生镜面反射的误差检测,而该情况发生,是Lidar属于scanning扫描模式下。

8.Nonlinear reflectivity -非线性反射率:Lidar可以针对每个检测点,实现反射率的非线性方式输出;大部分的Lidar 反射率是线性输出函数(漫反射),而经过完美朗伯散射曲面过渡后,会产生镜面的对数关系的非线性反射

9. Weather conditions-天气条件设定:冰霜/污渍的堵塞设定,物体反射会跟随雨雪雾的动态变化而改变,大气环境设定比如雨量,背散射(更改接受光线的形状,通过增加距离噪声等)、吸收(降低光线的辐射度)

Lidar sensor configuration

传感范围;自定义发射模式;移动物体的发射时间偏差;鬼影点;非线性反射;天气条件;

835

835

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?