说明:这是一个机器学习实战项目(附带数据+代码+文档+视频讲解),如需数据+代码+文档+视频讲解可以直接到文章最后获取。

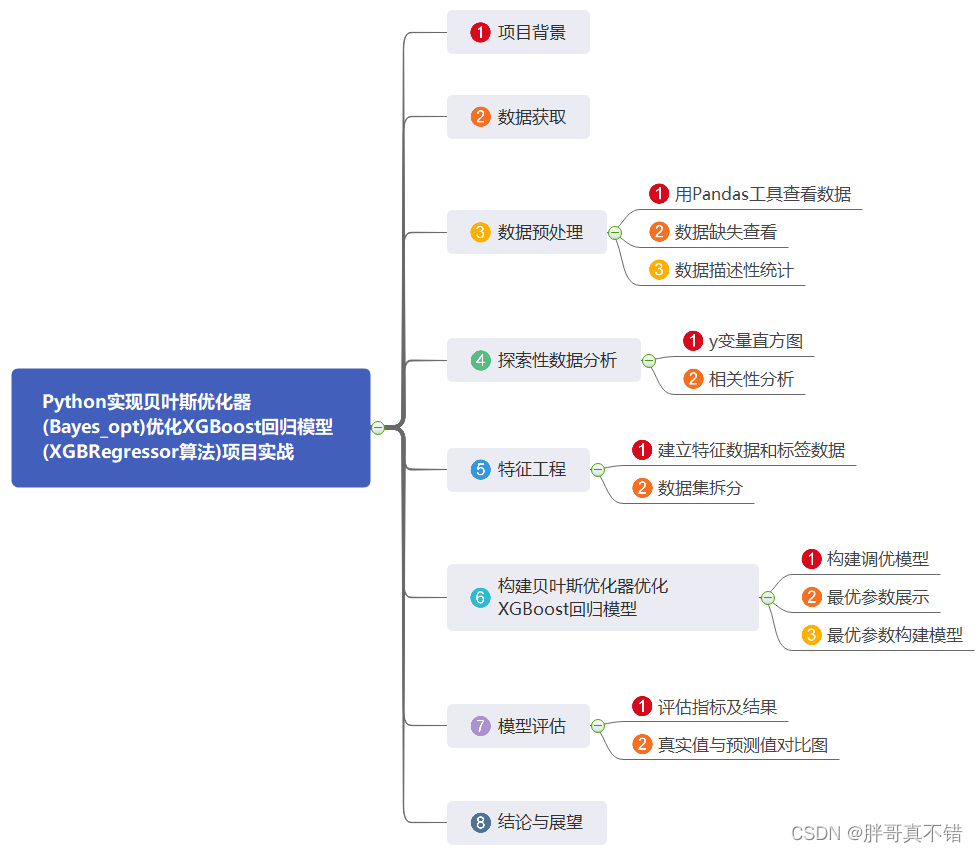

1.项目背景

贝叶斯优化器 (BayesianOptimization) 是一种黑盒子优化器,用来寻找最优参数。

贝叶斯优化器是基于高斯过程的贝叶斯优化,算法的参数空间中有大量连续型参数,运行时间相对较短。

贝叶斯优化器目标函数的输入必须是具体的超参数,而不能是整个超参数空间,更不能是数据、算法等超参数以外的元素。

本项目使用基于贝叶斯优化器(Bayes_opt)优化XGBoost回归算法来解决回归问题。

2.数据获取

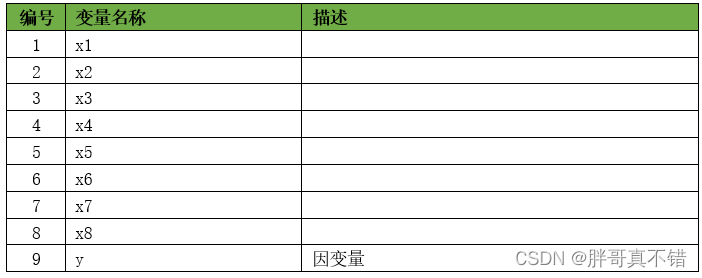

本次建模数据来源于网络(本项目撰写人整理而成),数据项统计如下:

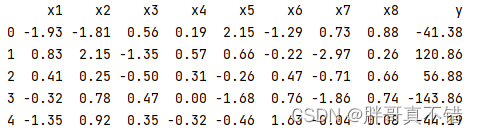

数据详情如下(部分展示):

3.数据预处理

3.1 用Pandas工具查看数据

使用Pandas工具的head()方法查看前五行数据:

关键代码:

![]()

3.2 数据缺失查看

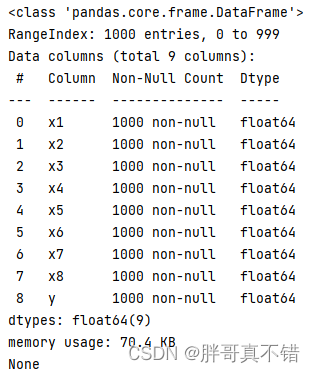

使用Pandas工具的info()方法查看数据信息:

从上图可以看到,总共有9个变量,数据中无缺失值,共1000条数据。

关键代码:

![]()

3.3 数据描述性统计

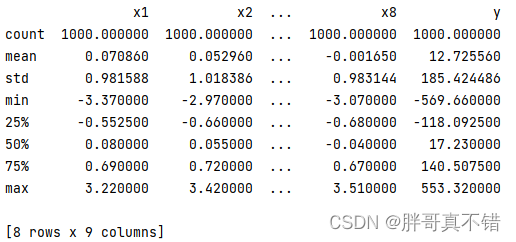

通过Pandas工具的describe()方法来查看数据的平均值、标准差、最小值、分位数、最大值。

关键代码如下:

![]()

4.探索性数据分析

4.1 y变量直方图

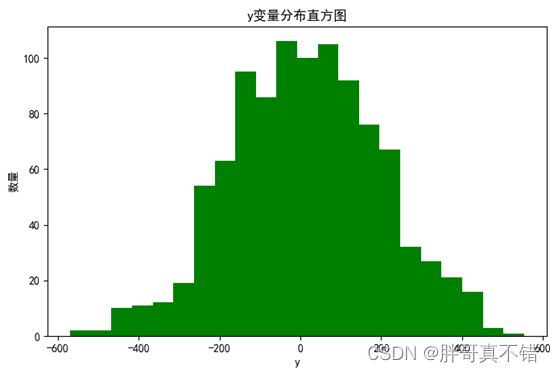

用Matplotlib工具的hist()方法绘制直方图:

从上图可以看到,y变量主要集中在-200~200之间。

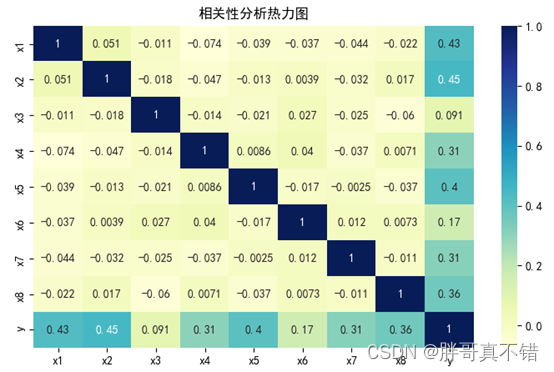

4.2 相关性分析

从上图中可以看到,数值越大相关性越强,正值是正相关、负值是负相关。

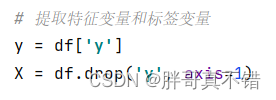

5.特征工程

5.1 建立特征数据和标签数据

关键代码如下:

5.2 数据集拆分

通过train_test_split()方法按照80%训练集、20%测试集进行划分,关键代码如下:

![]()

6.构建贝叶斯优化器优化XGBoost回归模型

主要使用基于贝叶斯优化器优化XGBoost回归算法,用于目标回归。

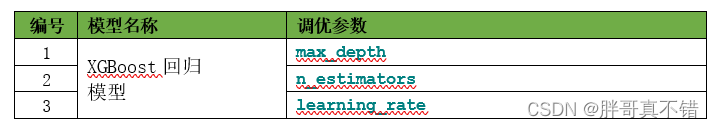

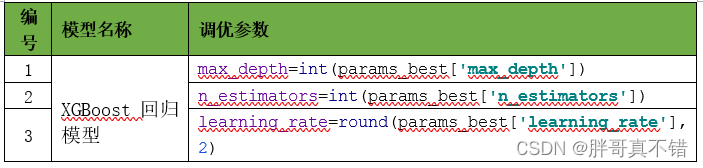

6.1 构建调优模型

6.2 最优参数展示

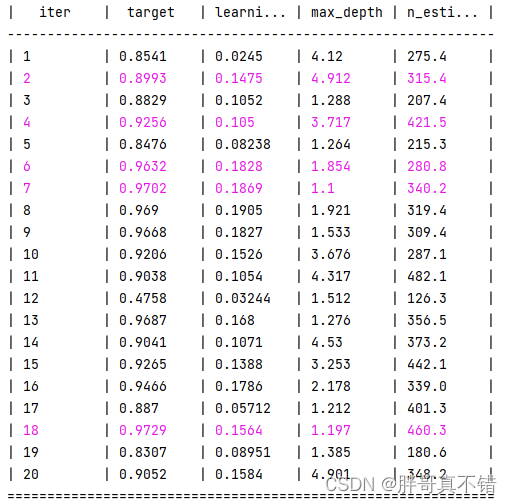

寻优的过程信息:

最优参数结果展示:

| 最优参数组合: max_depth的参数值为: 1 n_estimators的参数值为: 460 learning_rate的参数值为: 0.16 最优分数: 0.9728598192793905 验证集分数: 0.9235156211169319 |

6.3 最优参数构建模型

7.模型评估

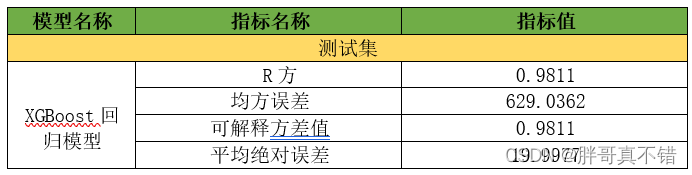

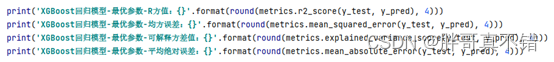

7.1 评估指标及结果

评估指标主要包括可解释方差值、平均绝对误差、均方误差、R方值等等。

从上表可以看出,R方0.9811,为模型效果较好。

关键代码如下

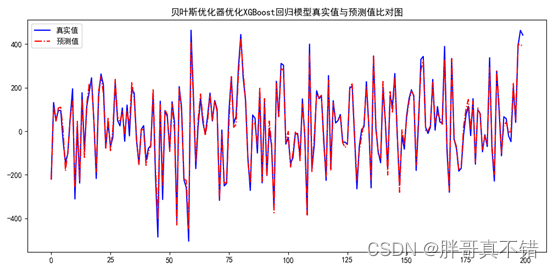

7.2 真实值与预测值对比图

从上图可以看出真实值和预测值波动基本一致,模型拟合效果良好。

8.结论与展望

综上所述,本文采用了贝叶斯优化器优化XGBoost回归模型算法寻找最优参数值来构建回归模型,最终证明了我们提出的模型效果良好。此模型可用于日常产品的预测。

# 本次机器学习项目实战所需的资料,项目资源如下:

# 项目说明:

# 链接:https://pan.baidu.com/s/1S89L0RSQ5_WeRnZ9CGHYNA

# 提取码:xhva

更多项目实战,详见机器学习项目实战合集列表:

机器学习项目实战合集列表_机器学习实战项目_胖哥真不错的博客-CSDN博客

859

859

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?