一、论文信息

1 标题

Continual Learning: Applications and the Road Forward

2 作者

Eli Verwimp, Shai Ben-David, Matthias Bethge, Andrea Cossu, Alexander Gepperth, Tyler L. Hayes, Eyke Hüllermeier, Christopher Kanan, Dhireesha Kudithipudi, Christoph H. Lampert, Martin Mundt, Razvan Pascanu, Adrian Popescu, Andreas S. Tolias, Joost van de Weijer, Bing Liu, Vincenzo Lomonaco, Tinne Tuytelaars, Gido M. van de Ven

3 研究机构

KU Leuven, University of Waterloo, Vector Institute, University of Tübingen, University of Pisa, University of Applied Sciences Fulda, NAVER LABS Europe, University of Munich (LMU), University of Rochester, Institute of Science and Technology Austria (ISTA), TU Darmstadt & hessian.AI, Google DeepMind, Université Paris-Saclay, CEA, LIST, Baylor College of Medicine, Computer Vision Center, UAB, University of Illinois at Chicago, University of Pisa, KU Leuven

二、主要内容

这篇论文探讨了持续学习(Continual Learning)的领域,这是一个机器学习子领域,旨在使机器学习模型能够通过积累知识而不遗忘过去所学来不断学习新数据。论文首先通过调查最近在三个主要机器学习会议上发表的持续学习论文,展示了记忆受限设置在该领域的主导地位。然后,讨论了五个机器学习中的开放问题,尽管它们乍看之下似乎与持续学习无关,但论文表明持续学习将是它们解决方案的一部分。这些问题包括模型编辑、个性化、设备上的学习、更快的(重新)训练和强化学习。最后,通过比较这些未解决问题的愿望和持续学习中的当前假设,论文突出并讨论了持续学习研究的四个未来方向。

三、相关研究

论文提到了与持续学习相关的多个研究领域,包括模型编辑、个性化、设备上的学习、更快的(重新)训练和强化学习。这些领域中的研究通常需要算法能够在有限的资源下学习新技能,同时最小化对之前学习内容的遗忘。

四、解决方案

论文提出了持续学习的目标是找到在性能和效率(例如计算和内存)之间有更好权衡的方法。在当代持续学习文献中,这种权衡通常通过限制内存容量并在这一约束下优化性能来体现。论文还讨论了一些新兴的工作,这些工作开始质疑持续学习中的常见假设,并探索在计算复杂性受限的情况下的学习方法。

五、实验环节

论文没有详细描述具体的实验环节,但提到了通过调查三个顶级机器学习会议(ECCV '22, NeurIPS '22, CVPR '23)接受的持续学习论文来理解当前的研究现状。调查了这些论文如何处理内存和计算成本的权衡。

六、进一步探索点:

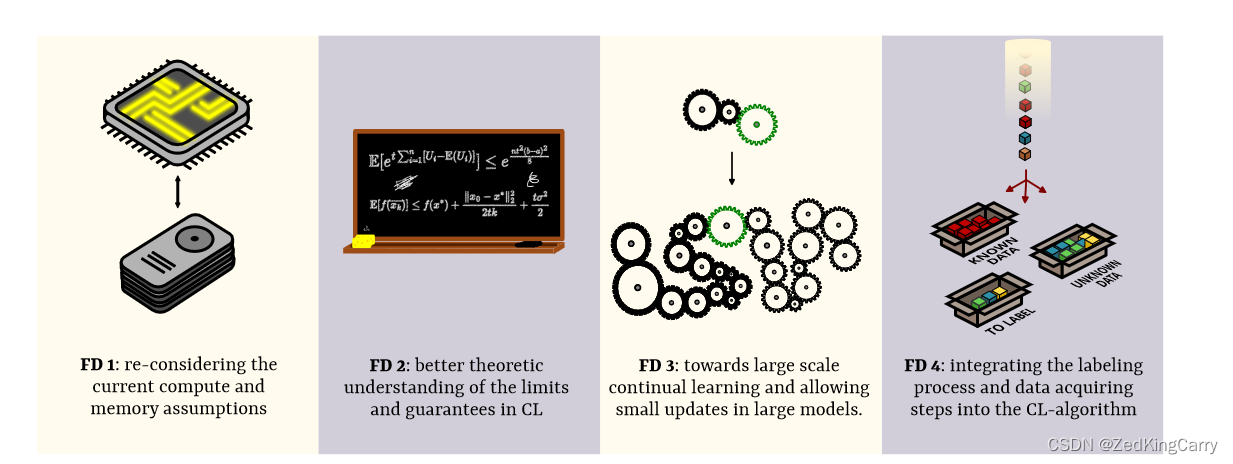

论文提出了四个主要的进一步探索点,这些探索点旨在推动持续学习领域的研究进展,并解决当前面临的挑战。以下是这些探索点的详细介绍:

-

重新考虑当前的计算和内存假设:

- 论文指出,许多现有的持续学习方法主要关注内存限制,而对计算成本的关注较少。然而,在实际应用中,计算成本往往同样重要,甚至在某些情况下更为关键。因此,需要重新评估这些假设,并根据实际问题来调整算法设计。

- 为了实现这一目标,研究者需要就如何衡量计算成本达成一致,以便在算法设计中对其进行限制。这可能涉及到对迭代次数、前向/后向传播次数、浮点运算次数(FLOPs)等指标的考量。

-

更好地理解持续学习的极限和保证:

- 持续学习的理论基础相对薄弱,缺乏对算法收敛性和泛化能力的深入理解。为了在理论上把握持续学习,需要开发新的概念和工具,以理解在何种条件下持续学习算法能够收敛到稳定解,以及我们可以期待的泛化性能。

- 这包括考虑数据的相似性、问题设置、以及如何将经典机器学习理论适应到持续学习的环境中。

-

在大规模持续学习和允许在大型模型中进行小更新:

- 当前的持续学习方法主要针对从随机初始化开始的小规模模型。然而,许多实际问题需要在已经预训练的大型模型基础上进行持续学习。这些模型通常在特定任务或环境中表现良好,但需要不断更新以适应环境变化。

- 研究者需要探索如何在大型模型中有效地应用小规模更新,以及如何利用模型的模块化结构来解决持续学习问题。

-

将标记过程和数据获取步骤整合到持续学习算法中:

- 在现实世界的应用中,数据的产生和获取是一个复杂的过程,涉及到变化检测、标签获取、以及如何处理未标记或部分标记的数据。持续学习算法需要能够在这个环境中自我更新,这可能涉及到半监督或自监督学习。

- 研究者需要开发能够处理开放世界学习(Open World Learning)的持续学习算法,这些算法能够在检测到数据分布变化时进行自我调整,并在必要时进行自我监督或半监督学习。

这些探索点为持续学习领域的研究提供了新的视角,并指出了实现更高效、更实用持续学习算法的潜在路径。通过在这些方向上的研究,可以期待持续学习在未来的机器学习应用中发挥更大的作用。

七、总结

论文首先调查了当前的持续学习领域,并展示了许多论文研究了内存受限的设置,对计算成本的关注较少。然后,介绍了所有需要某种形式的持续学习的问题,这些问题的解决方案本质上依赖于持续学习。最后,建立了四个持续学习研究的有前景的方向,特别是在我们描述的场景中。总的来说,许多这些应用在计算上的限制比内存上的限制更大,因此我们主张更多地探索这个设置。此外,我们认为更好的理论理解、更大的关注于预训练和相对较小的未来更新,以及更多地关注数据获取方式,将有助于我们解决这些问题,并使持续学习成为解决所描述的和其他机器学习问题的实用工具。

2815

2815

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?