语义分割论文

Semi-Supervised Segmentation of Radiation-Induced Pulmonary Fibrosis from Lung CT Scans with Multi-Scale Guided Dense Attention

目录

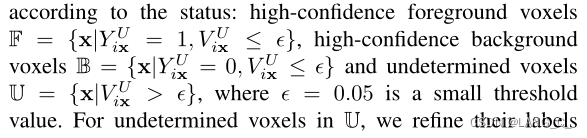

2.1 Inference for Unannotated Images with Uncertainty Estimation

2.2 Confidence-Aware Refinement (CAR) of Pseudo Labels

2.3 Confidence-based Image Weighting of Pseudo Labels

2.4 Model Update with Batch Training

一、摘要

计算机断层扫描(CT)在监测放射性肺纤维化(PF)中起着重要的作用,对PF病灶的准确分割对于诊断和治疗随访非常重要。然而,该任务面临着边界模糊、形状不规则、病灶位置和大小不一以及难以获取大量标注的体积图像进行训练的挑战。为了克服这些问题,我们提出了一种新的卷积神经网络PF-Net,并将其纳入一个基于迭代置信度的伪标签优化和加权(I-CRAWL)的半监督学习框架。我们的PF- net结合了二维和三维卷积来处理断层间距较大的CT体积,并使用多尺度引导密集关注分段复杂PF病变。对于半监督学习,我们的I-CRA WL采用基于像素级不确定性的置信度优化来提高未标注图像的伪标签的准确性,并在迭代训练过程中利用图像级不确定性进行基于置信度的图像加权来抑制低质量的伪标签。大量实验表明:1)PF- net比现有的2D、3D和2.5D神经网络具有更高的分割精度,2)I-CRA WL在PF病变分割任务中优于最先进的半监督学习方法。我们的方法有可能提高PF的诊断和肺癌放疗副作用的临床评估。

二、网络结构

1. PF-Net

这是一个多尺度密集指导注意力网络,利用不同的尺度信息来恢复最终要的分割结果,这里一共涉及到5个尺度,从图中可以看出,解码器中的每一个高层特征都通过卷积(红色方块)然后上采样(绿色箭头),再concat到所有的低层解码器上,这里的解码器和编码器都是采用前两层2D卷积,后三层3D卷积。

文中说2D卷积和3D卷积结合是使网络在每个轴上都有一个近似平衡的物理接收场

To deal with the anisotropic 3D resolution with high inter-slice spacing and low intra-slice

spacing, we combine 2D (i.e., intra-slice) and 3D convolutions so that the network has an approximately balanced physical receptive field along each axis.

2. I-CRAWL framework

这一部分详细介绍了半监督是如何作用在我们这个框架上的

2.1 Inference for Unannotated Images with Uncertainty Estimation

先用标签图片训练网络得到网络参数,对于

,采用MC dropout通过随机Dropout向网络输入R次图像

,得到R个预测,即R个前景概率映射。将这R张前景概率图的平均值作为临时概率图

,对

进行二值化,得到临时的伪分割标签

同时,将R张前景概率图的统计方差作为不确定性图,给出voxel-level的不确定性。由于不确定度信息可以指示可能错误的分割结果,我们将不确定度高(即置信度低)的伪标签作为

图像的不可靠标签,并提出了一种置信度感知的细化(CAR)方法来提高伪标签的质量。

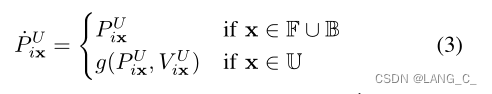

2.2 Confidence-Aware Refinement (CAR) of Pseudo Labels

根据的值将2.1中得到的每张伪标签图片分为三个set,分别是可靠的前景F、B可靠的背景、U不可靠的voxels.

CAR分为两个步骤:

- 减轻U中具有不确定性的voxels对网络预测的影响 g(p, u) = 0.5 + (p − 0.5) × (1 − u),p是前景的概率,u是不确定性值。可以看出不确定性越高,g的值越接近0.5,也就是下面(3)的概率值

- 采用上下文正则化的方法,即通过全连接条件随机场(CRF)来修正伪标签,如公式(4)

![]()

上式起到约束softed后的概率值和标签一致的作用

第一项作用为使得输出尽可能和softmax的概率图一致;第二项用来惩罚那些位置和强度值相近但是预测标签不同的那些分割点;

这里要补充一下CRF的能量函数这一知识点。

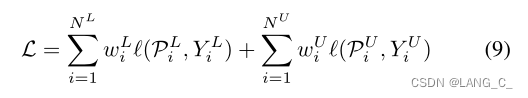

2.3 Confidence-based Image Weighting of Pseudo Labels

得到新的伪标签后,要根据置信度来更新图像级别的权值

,目的是抑制低质量的伪标签对分割的影响。注意这里是图像级别,给一张图像加权。

是图像级别的不确定性,分母可以理解为病灶的体积之和,2D的话就是面积之和,注意这里的x在2D图像中是代表一个像素点,分子是不确定性的区域之和,这里可以理解成归一化

上式表示不确定度越大,图像级的权重越小

2.4 Model Update with Batch Training

L损失函数是公式(1)中的损失函数

总结

- 涉及到3D卷积的部分我还没有完全看懂,因为一直做的都是2D的,看懂了再补充吧...

- 之前的多尺度方法一般都是将不同尺度的concat起来到一个特征空间上,本文的多尺度是逐级按照顺序利用的,也是比较容易想到的一点。而且在每层的特征图上都用ground truth去做监督,也属于深监督的一种吧。

- 半监督方向的创新是对于伪标签质量的把控,文中的方法采用不确定性估计来发现可能出现误分的不确定区域,而基于信心感知的精细化方法可以更有效地细化这些误分区域,从而提高伪标签的准确性。作者还从全局的角度去考虑了图像级的伪标签不确定信息,然后给图像一个权重。

参考文献

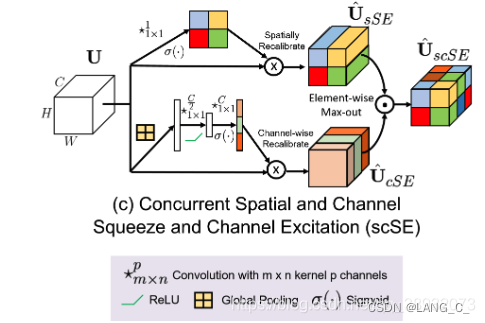

- Recalibrating fully convolutional networks with spatial and channel ’squeeze and excitation’blocks 论文链接 博客

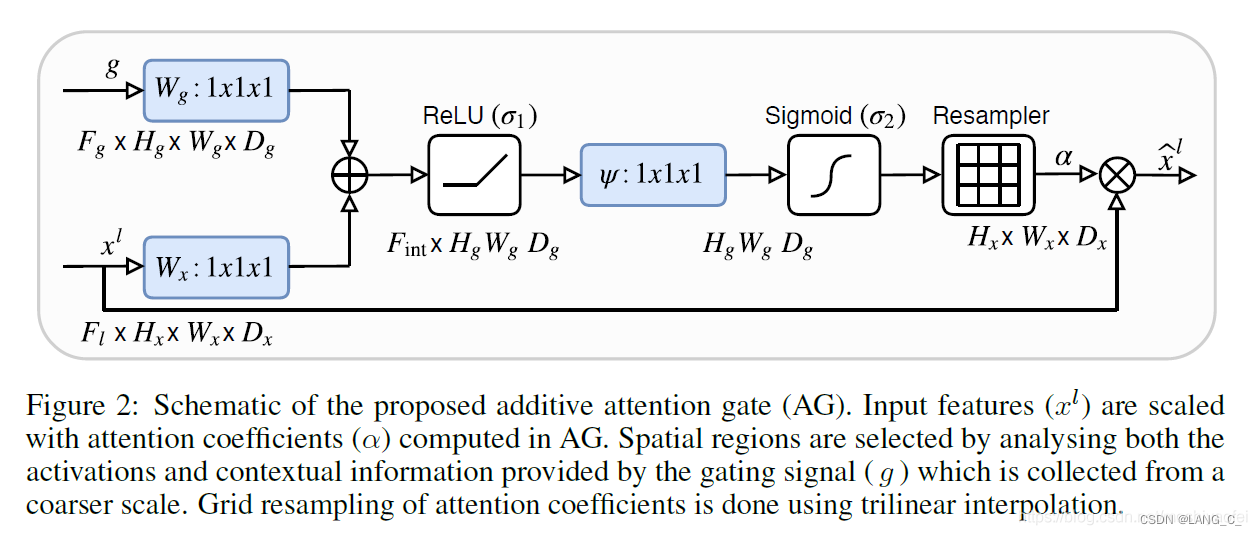

- Attention U-Net: Learning Where to Look for the Pancreas 博客

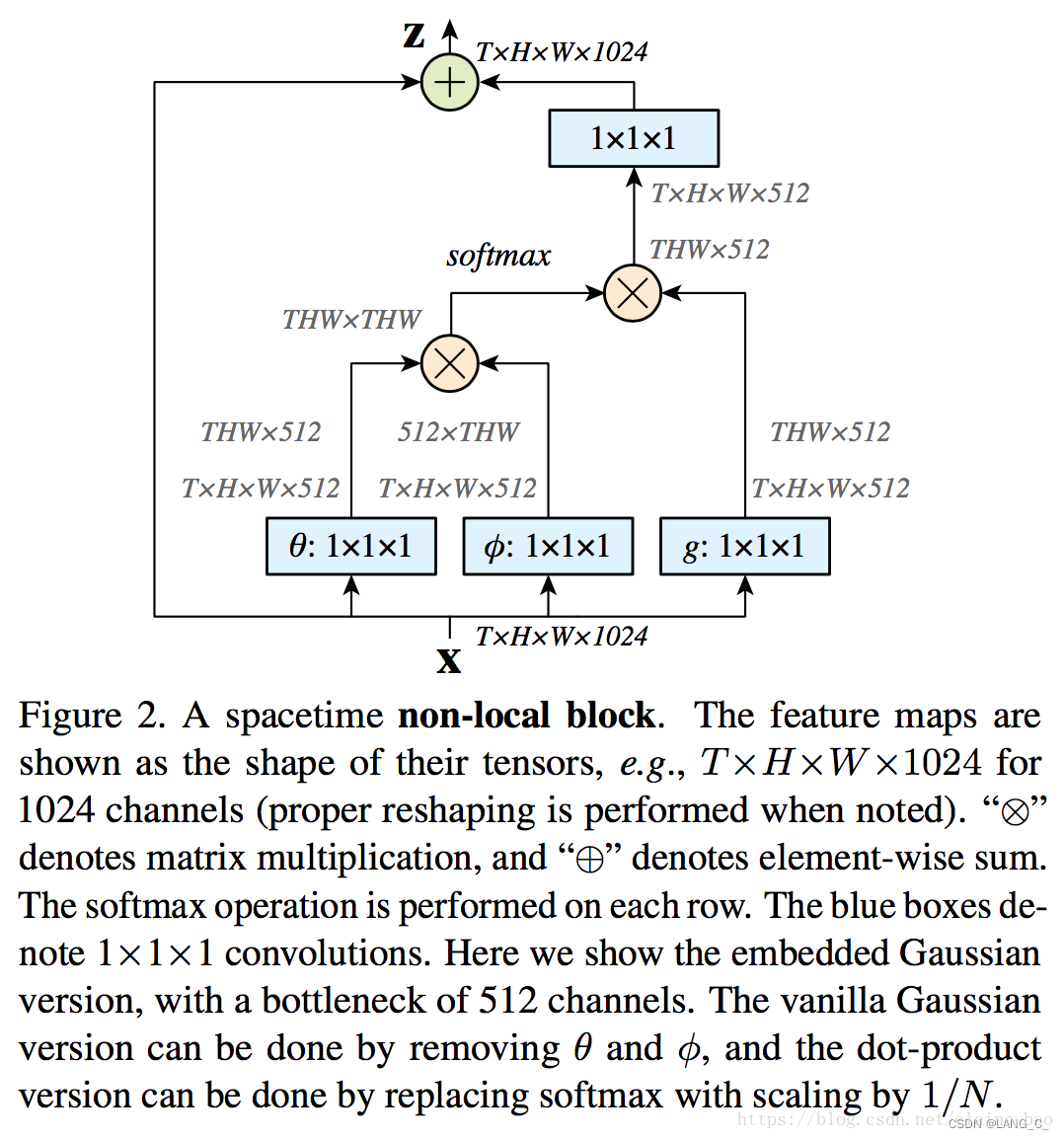

- Non-local Neural Networks

- SegNet: A Deep Convolutional Encoder-Decoder Architecture for Image Segmentation

661

661

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?