谷歌重磅发布!Gemini 1.5 模型震撼来袭

引言

“Gemini时代已经到来!” —— 谷歌

Google的Gemini模型在AI技术方面取得了重大进展。他们最初发布了三个版本:Ultra, Pro和Nano。现在,他们推出了改进版1.5 Pro,提供了更好的性能,可以一次处理多达100万个tokens。在本周最新的Google I/O活动中,他们还发布了一款更快更高效的模型——1.5 Flash。

目前,1.5 Pro和1.5 Flash均可进行公众预览,二者都能一次处理100万个tokens。此外,1.5 Pro还有一个可以处理200万个tokens的版本,可以通过API或供Google Cloud客户使用,目前有等待名单。

面对Google发布的众多模型和更新,了解最新进展非常重要。在本文中,我们将介绍每个Gemini模型的特征、最佳用途和可用性,帮助你清晰了解这些先进的AI工具在各个领域的应用。

为什么上下文长度至关重要?

在讨论不同的Gemini模型之前,让我们首先了解什么是上下文长度,以及为何更大的上下文长度如此重要。

在AI语言模型中,上下文长度指的是模型在生成响应或执行任务时可以同时考虑的tokens(单词、短语或字符)数量。更长的上下文长度允许模型从输入中理解和保留更多信息,从而带来若干关键好处:

-

增强连贯性和相关性:更长的上下文能让模型生成更连贯和上下文相关的响应。这在复杂对话或处理长文档时尤为重要,因为理解全局上下文至关重要。

-

改进摘要功能:更长的上下文长度能够更好地总结大量文本,捕捉更多细微之处和细节,从而生成更准确和全面的摘要。

-

更好地处理大篇幅文本:具备扩展上下文长度的模型可以一次处理更大篇幅的文本,使其在文档分析、代码生成和多轮对话系统等任务中更加高效。

-

减少碎片化:当上下文长度较短时,信息可能需要分成较小的部分,这会破坏流畅性,使模型难以保持连续性。更长的上下文长度可以减少这种问题。

在上图中,你可以看到不同模型的上下文长度,展示了Gemini 1.5 Pro的100万token上下文窗口相比GPT-4和Claude 3的显著优势。

谷歌Gemini模型的概览

| 模型 | 特性 | 理想使用场景 | 可用性 |

|---|---|---|---|

| Ultra | 最强大的能力,处理复杂任务 | 研究,大规模数据分析 | 有限访问 |

| Pro | 平衡的性能,多功能 | 通用AI应用 | 公开预览 |

| Flash | 轻量级,快速,高效 | 实时应用,低延迟任务 | 公开预览 |

| Nano | 紧凑,高效,设备上运行 | 移动设备,资源受限环境 | 即将在Pixel设备上推出 |

Gemini Ultra

Gemini Ultra是Gemini家族中最强大、最复杂的模型,基于transformer架构,参数量可能达到数万亿级。这使它能够捕捉数据中复杂的模式和关系,在复杂任务中表现卓越。

Key Features

- 高级推理:Gemini Ultra擅长处理复杂的逻辑推理、理解复杂概念并得出细致的推论。

- 多模态集成:它无缝整合文本、图像和音频处理,能够根据文本提示生成高质量图像和视频,进行音频转录,甚至进行音乐创作。

- 深入理解语言: 它能够理解人类语言的细微差别,包括成语、隐喻和文化引用,从而生成内容相关、连贯且吸引人的文本。

理想应用场景

- 前沿研究: Gemini Ultra 主要用于研发,推动人工智能能力的边界。

- 高性能应用: 它也适用于需要极高准确性和细致入微的要求的应用,例如医疗诊断、科学研究和复杂数据分析。

如何访问 Gemini Ultra?

由于其规模庞大和计算需求,Gemini Ultra 并未公开发布。通常只有参与最前沿 AI 项目的部分研究人员和开发人员,与 Google 合作才能访问。

Gemini Pro

Gemini Pro 是一个稳健且平衡的模型,在性能和计算效率之间达到了最佳平衡。它通常拥有数千亿个参数,使其能够以令人印象深刻的水平处理各种任务。

关键特性

- 多模态能力: Gemini Pro 在文本、图像和音频处理方面表现出色,使其在各种应用中具有通用性。

- 自然语言处理卓越: 它在聊天机器人、虚拟助手、内容生成、翻译和摘要等 NLP 任务中表现出色。

- 计算机视觉能力: 它在图像识别、目标检测和图像描述方面非常擅长。

理想应用场景

- 企业应用: Gemini Pro 非常适用于广泛的企业应用,包括客户服务自动化、内容创建和数据分析。

- 消费产品: 它可以为智能个人助手提供动力,增强搜索引擎功能,并在各种消费产品中创造引人入胜的用户体验。

如何访问 Gemini Pro?

Google 通过两个主要渠道提供 Gemini Pro:

- Google AI Studio: 一个协作开发环境,用户可以在其中根据自身需求实验并微调 Gemini Pro。

- Vertex AI: Google 云的机器学习平台,开发者和企业可以利用 Gemini Pro 实现生产规模的 AI 应用。

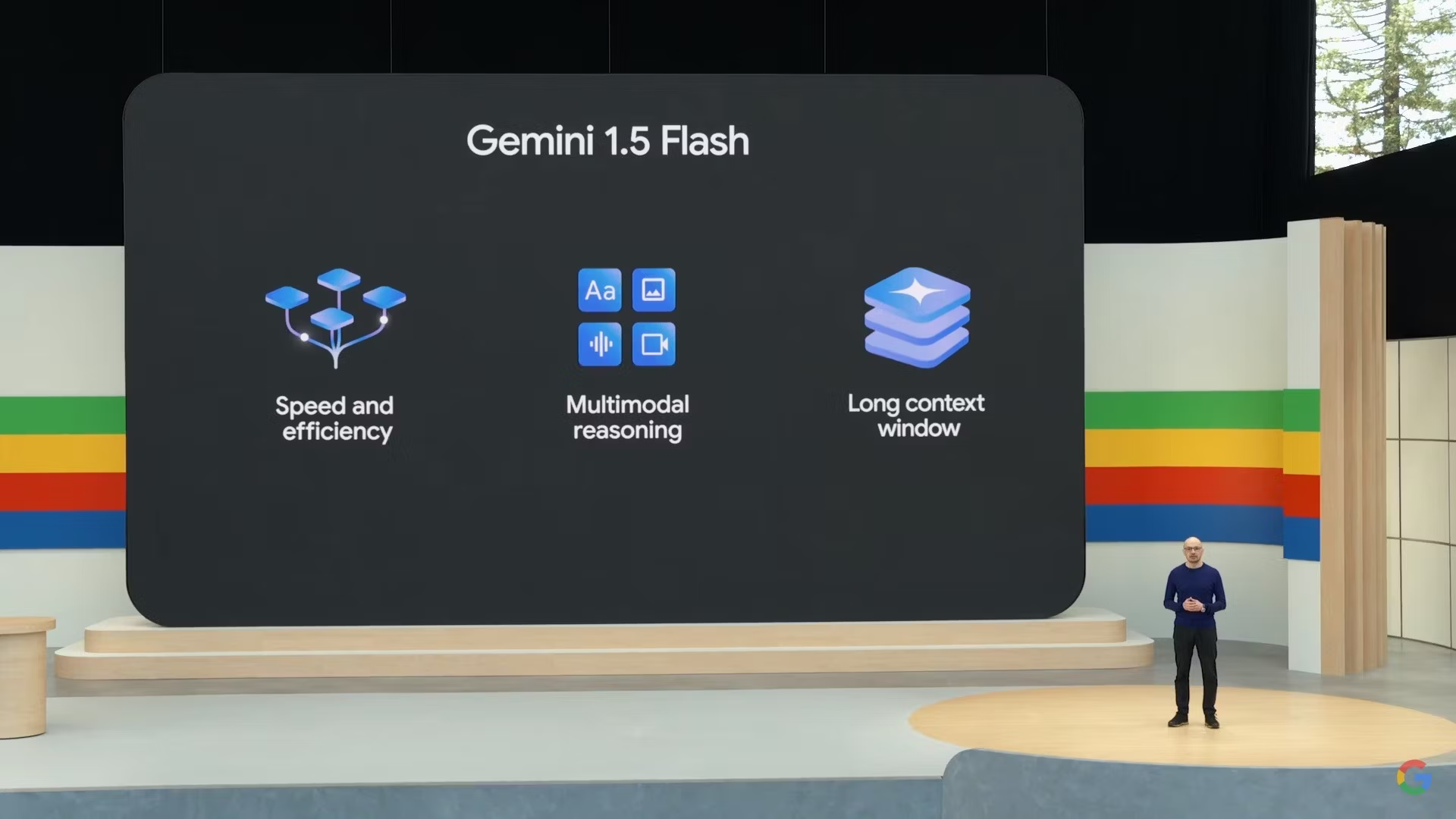

Gemini Flash

Gemini Flash 设计注重速度和效率,非常适合需要实时响应的应用。虽然它的参数比 Ultra 或 Pro 少,但却通过极快的推理能力和优化算法进行了补偿。

关键特性

- 实时交互: Gemini Flash 在实时交互方面表现出色,例如实时聊天机器人、互动游戏和即时内容生成。

- 低延迟任务: 它非常适合需要快速响应的任务,如语言翻译、图像描述和语音识别。

- 高效资源使用: 其较小的规模和较低的计算需求使其在资源受限的环境中更易部署。

理想应用场景

- 实时应用: Gemini Flash 非常适合需要即时响应的应用,例如实时聊天机器人、互动游戏和实时语言翻译。

- 边缘计算: 其高效使其适用于边缘设备,将 AI 功能带到物联网设备、可穿戴设备和移动应用中。

如何访问 Gemini Flash?

与 Gemini Pro 类似,可以通过 Google AI Studio 和 Vertex AI 来访问 Gemini Flash,让开发者能够利用其速度和效率为项目服务。

也可阅读: The Pre-AGI Era War: Google Astra vs GPT-4o

Gemini Nano

Gemini Nano 是 Gemini 家族中体积最小、重量最轻的模型,专门为设备上的应用而设计。它拥有最少的参数,优化用于最小资源消耗和在移动设备上高效执行。

关键特性

- 设备内智能: Gemini Nano 将 AI 能力直接带到移动设备上,实现无需云连接的语音助手、图像处理和实时语言翻译等功能。

- 隐私和安全: 设备内处理增强了隐私和安全,通过将敏感数据保存在本地。

- 能效:其小巧的尺寸和优化的设计有助于降低能源消耗,从而延长移动设备的电池寿命。

理想的使用场景

-

移动应用:Gemini Nano 非常适合为移动应用中的 AI 功能提供支持,例如语音助手、智能相机和个性化推荐。

-

可穿戴设备:它可以在智能手表和健身追踪器等可穿戴设备中实现 AI 功能。

如何获取 Gemini Nano?

Gemini Nano 尚未公开发布,但 Google 已宣布将在今年晚些时候登陆 Pixel 设备。这将赋予 Pixel 用户设备上的 AI 能力,增强语音助手、图像处理和实时语言翻译等功能。

结论

Google 的 Gemini 模型展示了 AI 技术能有多大提升。每个模型都针对不同的需求设计,从为先进研究提供支持的强大 Gemini Ultra,到用于实时任务的快速高效的 Gemini Flash。Gemini Pro 在多种用途中提供很好的平衡,而 Gemini Nano 则将 AI 功能带入移动和可穿戴设备。

我们探讨了每个 Gemini 模型的功能、最佳使用场景和可用性。这些 AI 工具可以在许多领域中产生重大影响,无论您是研究人员、开发者还是企业。

随着 Google 不断创新,Gemini 系列将持续带来新可能,并让先进的 AI 更加易于访问。

960

960

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?