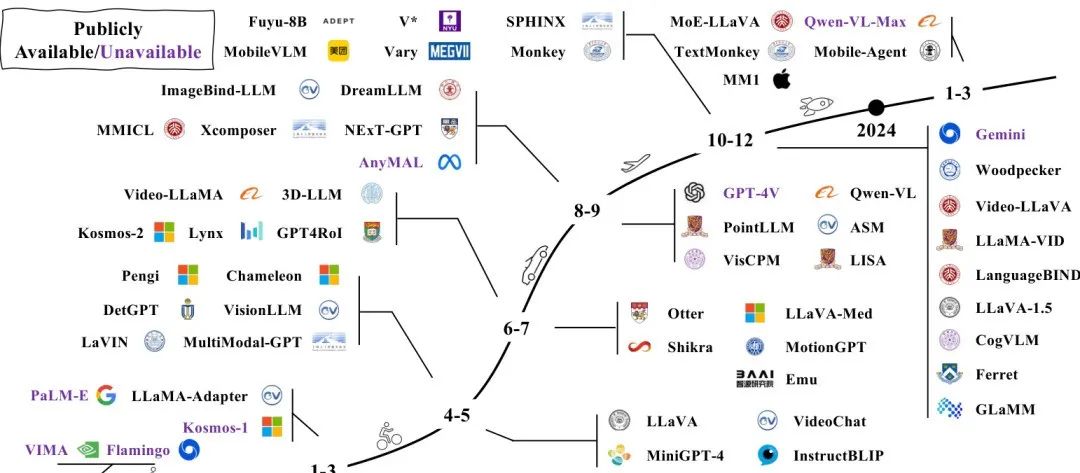

多模态大型语言模型(MLLM)的发展得益于大型语言模型(LLM)和大型视觉模型(LVM)领域的持续进步。随着LLM在语言理解与推理能力上的增强,其在处理语言任务上的表现日益突出。尽管如此,LLM在视觉信息的感知与理解上存在局限。与此同时,LVM在视觉任务上取得了显著进展,但推理能力尚需提升。

MLLM的基本结构

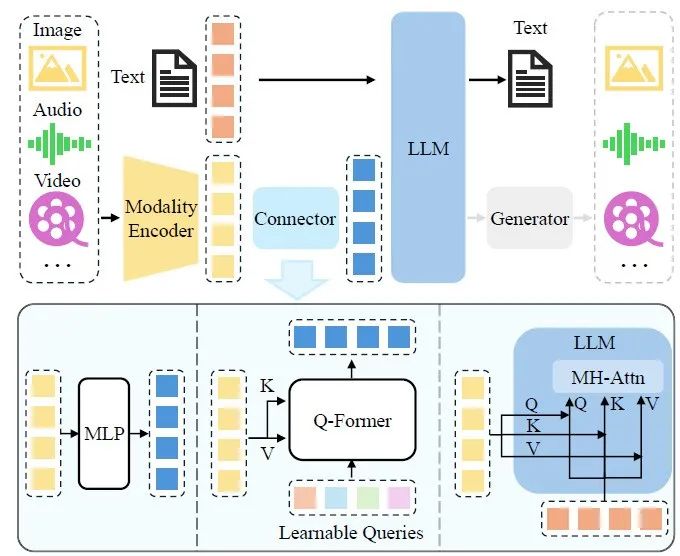

在MLLM中,模态编码器负责将原始的多模态信息,如图像或音频,转换为紧凑的表示形式。通常,这些编码器是基于大规模图像-文本对预训练的模型,如CLIP的视觉编码器,它能有效将图像信息转化为向量表示,并与文本信息对齐。不同的模型在编码器的选择和优化上有所侧重。

EVA-CLIP 编码器

MiniGPT-4采用了EVA-CLIP编码器,该编码器在性能上优于标准CLIP,同时训练成本更低。EVA-CLIP通过使用EVA模型的预训练权重初始化图像编码器,提高了起始性能。此外,LAMB优化器的使用,特别适合大批量训练,通过自适应元素级更新和层级学习率,提高了训练效率并加速了模型的收敛。FLIP技术的应用,通过在训练过程中随机遮蔽图像标记,减少了时间复杂度,使得批量大小可以增加一倍而无需额外的内存开销。

基于卷积的 ConvNext-L 编码器

Osprey选择了基于卷积的ConvNext-L编码器,该编码器利用高分辨率和多层次特征,尤其在开放词汇分割任务中表现出高效率。Osprey基于像素级别的任务,使用基于CNN的编码器可以在支持高分辨率的同时,保持训练效率和推理速度,而不牺牲性能。

无编码器的架构

Fuyu-8b采用了纯解码器转换器,图像块被线性投影到转换器的第一层,绕过了嵌入查找过程,将普通Transformer解码器视为图像转换器。这种设计增强了模型对灵活输入分辨率的适应性。

模态编码器的优化策略

在多模态编码器的选择上,研究人员会考虑分辨率、参数规模和预训练语料库等因素。研究表明,使用更高分辨率的图像输入能够提升模型表现。为此,不同的模型采用了多种策略来优化编码器。

直接缩放输入分辨率

Qwen-VL和LLaVA-1.5通过将图像分割成更小的图像块来提高模型的输入分辨率。LLaVA-1.5使用CLIPViT-L-336px编码器,并发现高分辨率能够提升模型性能。通过将图像分割成视觉编码器原本训练时分辨率的小图像块,并分别对其进行编码,然后将这些特征图组合成一个大特征图,最终输入到LLM中,这种方式保留了高分辨率的细节,并通过降采样图像的特征与合并后的特征图相结合,提供了全局上下文。

CogAgent采取了双编码器机制来处理高分辨率和低分辨率图像。高分辨率特征通过交叉注意力注入到低分辨率分支中,增强了模型对高分辨率输入的支持。CogAgent允许输入1120×1120分辨率的图像,而不需要对视觉语言模型的其他部分做出调整,只需对高分辨率交叉模块进行预训练即可。

分块法

Monkey和SPHINX将大图像分割成小块,再将这些子图像与降采样的高分辨率图像一起输入图像编码器。Monkey支持1344×896的分辨率输入,通过将大图像分为6个448×448的图片块,再输入到VIT模型中。SPHINX使用混合视觉编码器将高分辨率的图片分块,并与低分辨率全图一起进行编码,捕获图像的局部和全局特征。

预训练的LLM

在MLLMs中的语言模型部分通常采用Causal Decoder架构,遵循如GPT-3的设计模式。Flan-T5系列是较早应用于MLLM的LLMs之一,开源的LLaMA系列和Vicuna系列则是当前较为常用的LLMs。扩大LLMs的参数规模通常能够带来显著的性能提升,这种效果在LLaVa-1.5和LLava-Next的研究中得到了验证。

同时,一些研究致力于开发轻量化的LLMs,以便在移动设备上实现高效部署。例如,MobileVLM系列使用了缩小版的LLaMA,在移动处理器上实现了高效推理。混合专家(Mixture of Experts,MoE)架构的研究引起了越来越多的关注,与密集模型不同,稀疏架构通过选择性激活参数,能够在不增加计算成本的情况下扩大模型的总参数规模。

模态接口

由于多模态模型的端到端训练难度和成本较高,目前大多数模型都采用了基于模态对齐的两种常用方法:构造可学习的连接器和利用专家模型将图像信息转换为语言形式,再输入到LLM中。这两种方法都旨在缩小不同模态之间的差距,使得模型能够更好地理解和处理多模态输入。

模态对齐的方法有很多种,下面总结常见的3种:

Token级融合

通过将编码器输出的特征转换为token,并在发送给LLM之前与文本token连接在一起。例如,BLIP-2首次实现了这种基于查询的token提取方式,随后Video-llama、InstructBLIP和X-llm等模型继承了这一方法。这种Q-Former风格的方法将视觉token压缩成更少数量的表示向量,简化了信息的传递和处理过程。

特征级融合

特征级融合则在文本和视觉特征之间引入了更深度的交互。例如,Flamingo通过在LLM的Transformer层之间插入额外的交叉注意力层,从而用外部视觉线索增强语言特征。CogVLM通过在每个Transformer层中插入视觉专家模块,实现了视觉和语言特征的双向交互与融合。

使用专家模型融合

在多模态模型中,专家模型被广泛应用于模态对齐的任务中,特别是当需要将图像或其他非语言模态的输入转换为语言形式时。这类方法的核心思想是利用现有的强大模型进行模态转换,从而避免重新训练一个复杂的多模态对齐模块。

MLLM的训练策略和训练数据

在MLLMs的开发过程中,训练策略和数据处理方法对于模型的性能提升至关重要。通常,训练分为三个主要阶段:预训练,指令微调和对齐微调。

预训练

预训练的主要目标是对齐不同模态,同时让模型学习多模态世界中的丰富知识。这个阶段通常需要大规模的文本配对数据,这些数据能够为模型提供广泛的上下文和世界知识。在预训练过程中,常见的输入格式是将一段描述性文本与对应的图像、音频或视频配对,通过交叉熵损失函数进行训练。

指令微调

指令微调是训练MLLMs的另一关键阶段,其目的是让模型更好地理解和执行用户的指令。在这一阶段,模型通过学习如何泛化到未见过的任务,从而提升零样本的性能。

对齐微调

为了提高MLLMs在特定场景下的表现,对齐微调是一项不可忽视的关键步骤。对齐微调的目标是减少模型在生成过程中可能出现的“幻觉”现象,确保生成内容与输入信息保持一致。

MLLM的性能评估方法

在MLLMs的开发过程中,评估模型性能是确保其应用效果的重要步骤。评估方法包括封闭式问题和开放式问题的评估。

能力扩展

MLLMs正在被扩展以支持更多的模态输入和输出,例如,ImageBind-LLM支持编码多种数据,而Next-gpt和Emu等模型则可以生成多模态响应。

幻觉问题及其缓解方法

幻觉问题,即模型生成的内容与实际输入不符的现象,是MLLMs生成过程中的一个挑战。幻觉问题主要包括存在性幻觉、属性幻觉和关系幻觉。为了更准确地评估幻觉现象,新一类的评估指标应运而生,同时,研究者们提出了多种缓解幻觉的方法。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

1869

1869

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?