摘要:现有的视觉语言多模态预训练方法仅在图像和文本的全局语义上进行特征对齐,对模态间细粒度特征交互的探索不足。

针对这一问题,本文提出了一种基于跨模态引导和对齐的多模态预训练方法。该方法在模态特征提取阶段,采用基于视觉序列压缩的双流特征提取网络,在视觉编码器中联合图像和文本信息逐层引导视觉序列压缩,缓解与文本无关的冗余视觉信息对模态间细粒度交互的干扰;在模态特征对齐阶段,对图像和文本特征进行细粒度关系推理,实现视觉标记与文本标记的局部特征对齐,增强对模态间细粒度对齐关系的理解。

实验结果表明,本文方法能够更好地对齐视觉文本的细粒度特征,在图文检索任务中,微调后的图像检索和文本检索的平均召回率分别达到了86.4和94.88,且零样本图文检索的整体指标相较于经典图文检索算法CLIP(Contrastive Language-Image Pre-training)提升了5.36,在视觉问答等分类任务中,准确率也优于目前主流多模态预训练方法。

01.引言

视觉语言多模态学习属于计算机视觉与自然语言处理的交叉领域,旨在通过同时处理视觉和语言两种模态信息,实现跨模态的联合学习与理解。在视频理解[1]、生物医学[2,3]、自动驾驶[4]等领域应用广泛。与单一模态信息处理不同,图像数据和文本数据在表达方式和信息密度上都存在较大差异,这种不可忽视的模态异构性和语义鸿沟给多模态模型学习视觉语言对齐关系带来了极大的挑战。

现有的多模态预训练模型在处理视觉语言模态的对齐问题上,主要采取两种方法。一种方法是基于图像区域和文本单词的对齐[5~7],利用训练好的目标检测器识别图像中所有潜在对象,实现文本单词与具体视觉对象的细粒度特征对齐。

然而,这种方法对下游任务的迁移受到目标检测器的类别限制,且识别到的潜在对象也可能与文本描述毫无关联。另一种方法基于图文对比学习ITC(Image-Text Contrastive)对齐[8~10],专注于在图像和文本的全局语义上进行粗粒度对齐,克服了目标检测器的限制。但仅进行全局语义的跨模态特征对齐,容易导致多模态模型忽略视觉对象和文本单词之间的细粒度对齐关系,而这对于许多下游任务是至关重要的[11,12]。

为此,FILIP[13](Fine-grained Interactive Language-Image Pre-training)提出了更精细的标记级对比对齐,但没有做进一步的模态交互融合,在复杂的视觉语言理解任务上表现较差。ALBEF[14](ALign BEfore Fuse)提出先对齐再融合的多模态学习策略,在多模态融合编码器中学习模态间细粒度交互关系,在各类多模态下游任务中取得了不错的效果,但其将模态间的深层次交互完全依托于融合过程中的注意力机制实现,缺乏更为显式的细粒度对齐手段。

此外,由于在现有的多模态数据集中,图像通常包含比简短文本描述更丰富的信息,这种模态间的信息不对称性导致多模态模型在使用ViT[15](Vision Transformer)提取图像特征时,会不可避免地编码与文本内容无关的冗余背景信息,这不仅增加了网络模型的计算负担,同时也会阻碍文本和图像之间的细粒度交互[16]。

尽管在计算机视觉领域,研究者对于ViT中的长视觉序列问题,提出了许多序列修剪[17,18]、序列重组[19]以及序列压缩[20]等算法,以减少视觉序列长度,提升计算效率。但这些方法仅使用单一的视觉信息指导视觉序列修剪,忽略了文本信息,因此并不适合直接应用于需要同时处理两种模态信息的视觉语言多模态模型。

针对上述问题,本文遵循先对齐再融合的预训练策略,提出了一种基于跨模态引导和对齐的多模态预训练方法(MulGA),在视觉语言特征提取过程中,通过双模态信息的联合引导,逐步压缩视觉序列中与文本描述无关的冗余标记,缓解背景特征对模态交互的干扰;同时在模态对齐阶段进行细粒度关系推理,加强模型对视觉对象和文本单词之间深层关联的理解,实现更精准的特征对齐。

02.方法架构

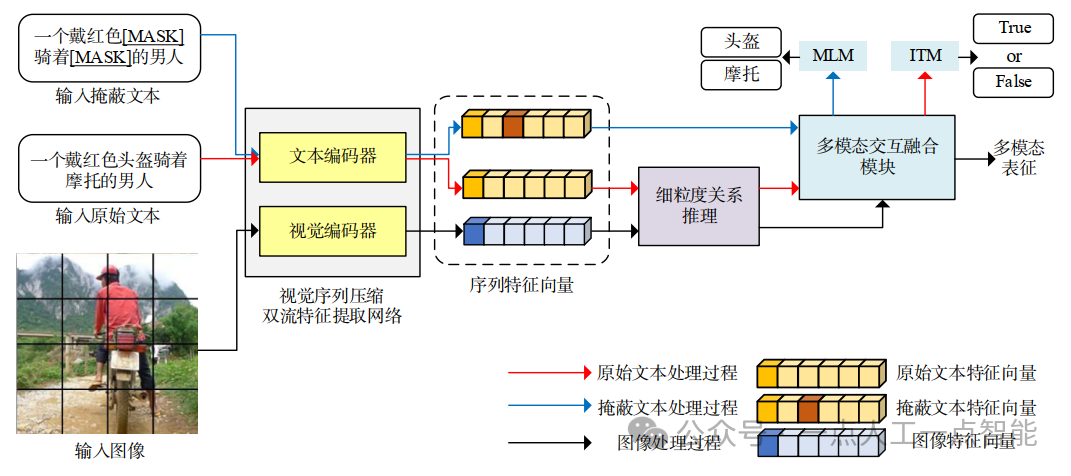

本文提出的视觉语言多模态预训练模型MulGA整体网络框架如图1所示。该框架由基于视觉序列压缩的双流特征提取网络、细粒度关系推理模块以及多模态交互融合模块三个核心组件构成。

图1 MulGA模型整体框架

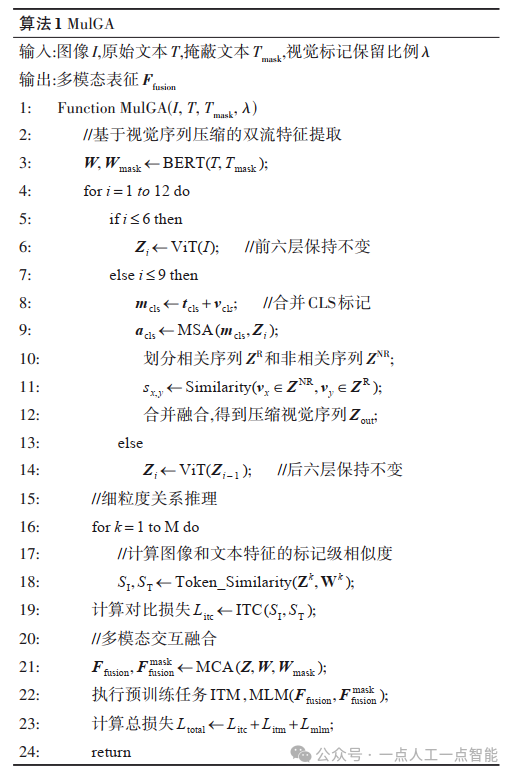

首先,输入的图像-文本对经过双流特征提取网络提取特征向量,并在细粒度关系推理模块中进行初步的特征细粒度对齐处理;随后,将初步对齐的图像特征和文本特征馈送到多模态交互融合模块,通过执行图像文本匹配(Image-Text Matching,ITM)和掩蔽语言建模(Masked Language Modeling,MLM)两个预训练任务,实现进一步的模态细粒度融合;最终输出深度融合后的多模态表征。具体流程如算法1所示。

2.1 基于视觉序列压缩的双流特征提取网络

本文采用双流特征提取架构,通过两个独立的单模态编码器分别提取输入的图像和文本特征,如图2所示。

图2 双流特征提取架构示意图

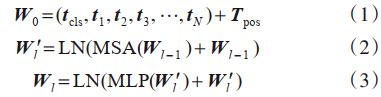

文本编码器由6层Transformer[21]块组成,每层包含一个多头自注意力(Multi-head Self-Attention,MSA)和一个前馈神经网络(Feedforward Neural Network,FNN),层归一化和残差连接用于防止梯度消失。接收原始文本和掩蔽文本输入,将输入的文本单词转换为词嵌入向量 ti,并与位置嵌入 Tpos求和构造输入表示。需要注意的是,掩蔽文本输入仅作为后续MLM预训练任务使用,不参与文本编码器的梯度更新。

文本编码器计算过程,见式(1)~(3)。

其中, Wl表示第 l层编码器中序列化的文本特征矩阵。

视觉编码器由12层的ViT块组成,将输入图像 I∈RH×W×C拆分成 N个 P×P大小的图像块,其中 N=H×W/P2。每个图像块被展平并通过一个可训练的线性投影映射成D维的图像块嵌入向量 vi,并与位置嵌入 Vpos求和构造序列化的视觉特征矩阵 Z0,如式(4)所示:

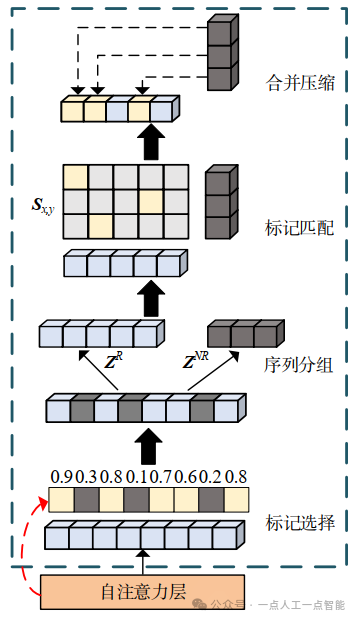

在输入数据中,并不是所有的图像内容都有与之相匹配的文本描述,有必要对视觉序列进行修剪操作,减少与文本无关的冗余视觉信息。但现有的主流视觉序列修剪方法只利用了单一的视觉信息,并不适合需要处理两种模态信息的多模态模型。为此,本文提出图像文本联合引导的视觉序列压缩(image-text coordinated Visual Sequence Compression,VSC)方法,如图3所示。

图3 图像文本联合引导视觉序列压缩示意图

保持视觉编码器中的前六层和后三层不变,仅在中间三层逐层选择并压缩与文本描述不相关的视觉标记,避免因压缩过多视觉标记导致图像结构信息丢失。

对于第 l层视觉序列矩阵 Zl∈R(n+1)×D,首先将序列中图像CLS特征向量 vcls和文本编码器输出的文本CLS特征向量 tcls合并,获得具有多模态语义的联合特征向量 mcls,如式(5)所示:

然后将联合标记与视觉序列级联送入多头自注意力层,计算联合标记对每个视觉标记的注意力得分 acls,作为视觉标记与文本描述相关程度的评估标准,如式(6)所示:

依据 acls=(a1,a2,⋯,an)和预先定义的视觉标记保留比例 λ对特征序列进行分组。将需要保留的高得分标记划分为相关序列 ZR,可以忽视的低得分标记划分为非相关序列 ΖNR。

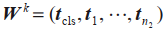

对于非相关序列中的视觉标记,直接删除会导致信息丢失,简单融合又会生成额外的标记,破坏视觉信息的整体性[20]。为了避免这些问题,本文采用一种序列压缩策略。首先,对非相关序列中的每一个视觉标记 vx=ΖNR[:,x],在相关标记 vy=ZR[:,y]中找到其最近邻的视觉标记 vnear。

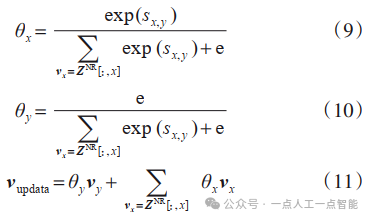

最近邻标记计算过程见式(7)、式(8)。

随后,计算非相关标记与最近邻相关标记的融合权值,将非相关标记加权合并到其最近邻标记中,获得更新后的令牌 vupdate。在不损失信息也不增加额外标记的情况下,实现视觉序列压缩,如式(9)~(11)所示:

其中, θx为每个非相关标记的融合权值, θy为相关标记本身的融合权值。

最后,将当前层的视觉序列重构为 Zl∈R(k+1)×D,并馈送到多层感知机模块进一步处理,其中 k=λn。

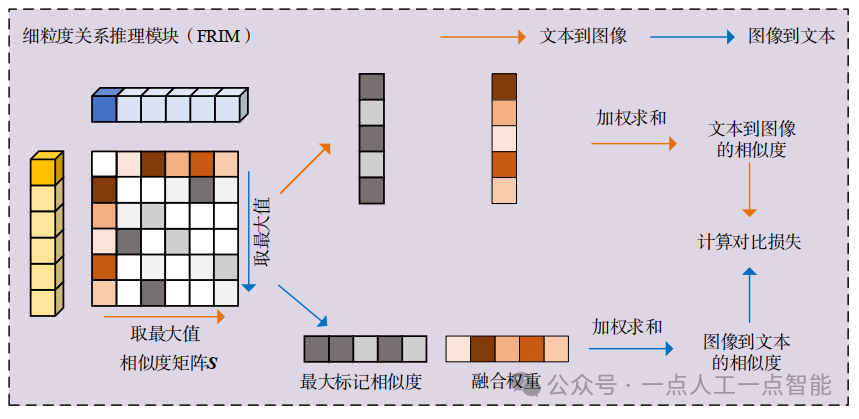

2.2 基于对比学习的细粒度关系推理

细粒度关系推理模块(Fine-grained Relationship Inference Module,FRIM)利用视觉和语言表征的标记级相似度综合表示图像与文本以及文本与图像的相似度,并使用对比损失最大化正样本对的相似度、最小化负样本对的相似度,实现更细粒度和更具可解释性的跨模态对齐,具体流程如图4所示。

图4 细粒度关系推理模块

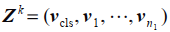

假设在一个训练批次中有M个图像-文本对 ,其中 {Ik,Tk}为正样本对,而 Ik与其他文本组合

,其中 {Ik,Tk}为正样本对,而 Ik与其他文本组合  为负样本对。对于该批次中的第k个图像文本对 {Ik,Tk},将其视觉特征

为负样本对。对于该批次中的第k个图像文本对 {Ik,Tk},将其视觉特征 和文本特征

和文本特征 经过单层感知机映射到公共嵌入空间,用

经过单层感知机映射到公共嵌入空间,用 和

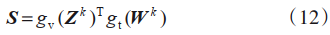

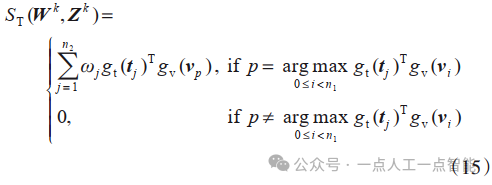

和 表示,其中 n1和 n2为图像和文本的非填充标记数量。为了实现图像与文本的细粒度对齐,细粒度关系推理模块需要对每个特征标记都计算相似度,最终获得一个 (n1+1)×(n2+1)的标记级相似性矩阵 S,如式(12)所示:

表示,其中 n1和 n2为图像和文本的非填充标记数量。为了实现图像与文本的细粒度对齐,细粒度关系推理模块需要对每个特征标记都计算相似度,最终获得一个 (n1+1)×(n2+1)的标记级相似性矩阵 S,如式(12)所示:

对于图像的第i个视觉标记 vi,取其中除全局语义表示外 n2个相似度中最大的一个作为该视觉标记与整段文本的相似度,如式(13)所示:

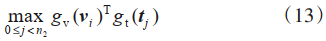

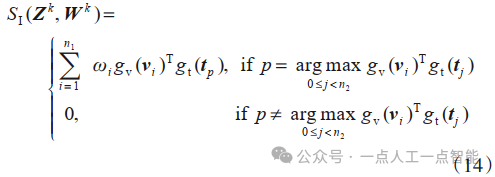

这样可以得到 n1个视觉标记与整段文本的相似度,同理也能获得 n2个文本标记与整幅图像的相似度。为了进一步量化 Ik和 Tk之间的匹配程度,通过对全局语义表示与各标记之间的相似性进行softmax归一化处理,评估各个标记在匹配过程中的贡献程度,获得对应的融合权重 ω,进而加权融合得到图像到文本的相似度 与文本到图像的相似度

与文本到图像的相似度 。

。

和

和  的计算过程见式(14)、式(15)。

的计算过程见式(14)、式(15)。

需要注意的是,与图文对比学习不同,此时的 不一定等于

不一定等于 。

。

最后计算图文对比损失,实现图像和文本的细粒度交互和对齐,如式(16)~(18)所示:

其中τ是可学习的温度参数, 为图像Ik到文本的对比损失,

为图像Ik到文本的对比损失, 为文本Tk到图像的对比损失,Litc为该训练批次的总对比损失。

为文本Tk到图像的对比损失,Litc为该训练批次的总对比损失。

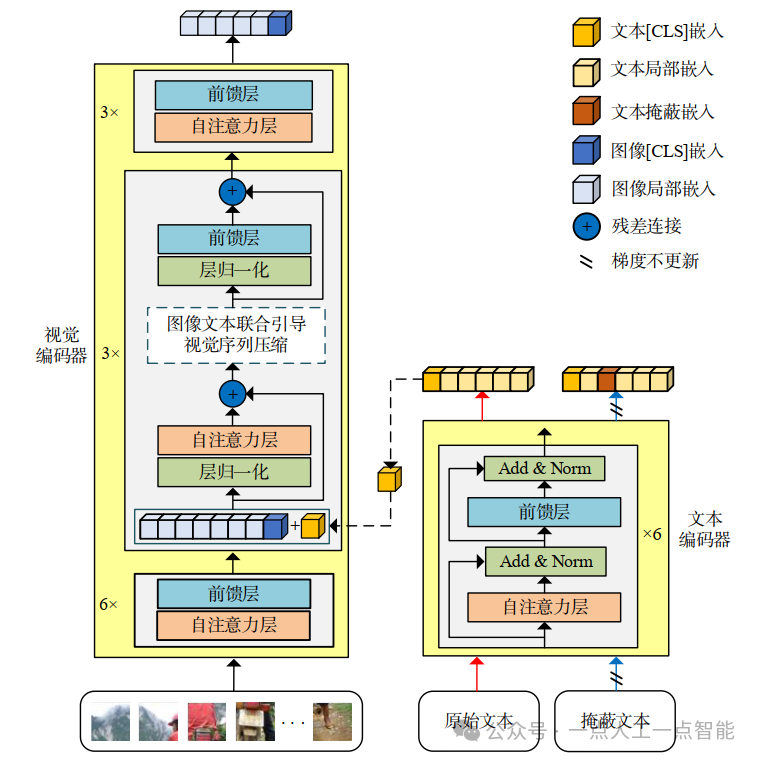

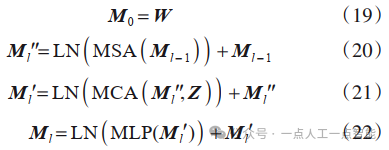

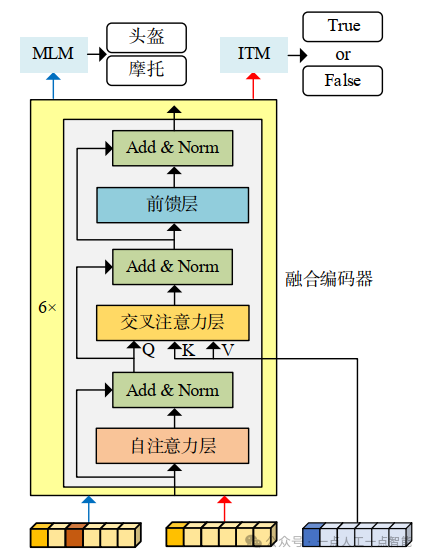

2.3 多模态交互融合模块

多模态交互融合模块如图5所示,输入对齐后图像特征、原始文本特征以及掩蔽文本特征,其中掩蔽文本特征和原始文本特征经过多头自注意力层作为查询向量,图像特征作为键向量和值向量,在多头交叉注意力层(Multi-Head Cross-Attention,MCA)进行融合。通过图像文本匹配(ITM)和掩蔽语言建模(MLM)两个预训练任务训练融合编码器隐式挖掘图像和文本的细粒度交互关系,如式(19)~(22)所示:

其中,W是文本编码器的输出,Z是视觉编码器的输出,Ml是第l层编码器中序列化的多模态特征矩阵。

图5 多模态交互融合模块

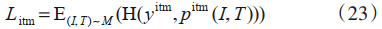

图像文本匹配(ITM)任务将融合编码器输出的文本CLS嵌入作为多模态全局语义表示,经过一个全连接层和Softmax来预测图像和文本是否匹配。ITM损失计算如式(23)所示:

其中, pitm为预测两类的概率, yitm表示真值标签, yitm当图像和文本相匹配时为1,不匹配时为0。

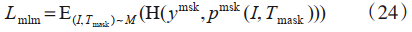

掩蔽语言建模(MLM)任务利用图像信息和文本上下文信息预测被随机掩蔽的文本标记。由于提高MLM任务中文本的掩蔽比例,能够帮助模型更有效地利用视觉特征[22,23]。因此本文以30的概率随机掩蔽原始文本。MLM损失计算如式(24)所示:

其中 Tmask表示一个被掩蔽的文本标记, pmsk(I,Tmask)表示模型对被掩蔽标记的预测概率, ymsk表示词汇概率分布。

MulGA的预训练总损失可以表示为

03.实验分析

本节详细介绍了MulGA在视觉语言检索和分类两种下游任务中的实验测试结果,并与主流的预训练方法进行了全面比较,展示了本文模型在各个任务上的良好表现。

3.1 实验细节

MulGA使用预训练的ViT-B/16作为视觉编码器,将BERT[24]的前六层作为文本编码器,后六层作为多模态融合编码器,视觉标记保留比例 λ设置为70.在4张NVIDIA Tesla V100 32 GB GPU上预训练了30个周期。为了公平比较,除了由于计算资源受限,降低了批次大小之外,其余实验设置基本与ALBEF保持一致。

3.2 预训练数据集

本文采用MSCOCO[25](Microsoft Common Objects in Context)、VG[26](Visual Genome)、SBU[27](SBU Captions)和CC3M[28](Conceptual Caption)4个可公开访问的数据集作为基础数据集。由于四个数据集中的部分图像数据在下载前已缺失,最终4 M大小的基础数据集中,图像总数约为400万张,图像-文本对的数量约为510万套。

此外,本文以随机采样的方式从CC12 M数据集中筛选数据,构造了一个包含6 M图像文本对的数据集,与采用大规模数据集预训练的模型进行对比实验。

3.3 视觉语言检索任务评估

视觉语言检索任务包括文本到图像检索(Image Retrieval,IR)和图像到文本检索(Text Retrieval,TR)。对于此项任务,本文使用召回率R@k(Recall@k)、平均精确率mAP(Average Precision)和F1分数对模型进行全面评估。

3.3.1 图文检索微调实验

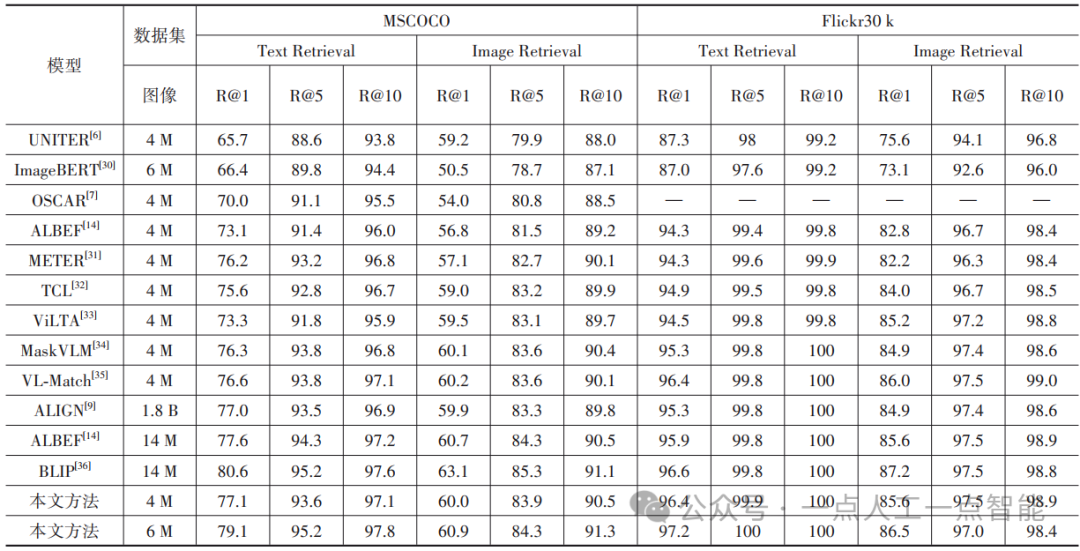

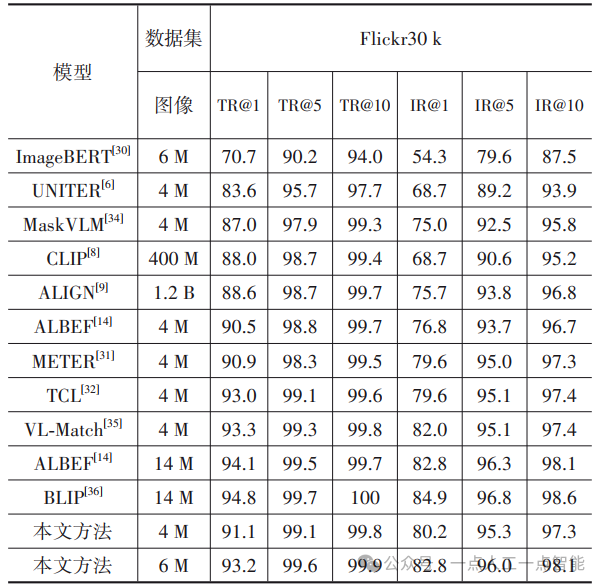

MulGA在MSCOCO和Flickr30k[29]上图文检索微调实验的R@k的评估结果如表1所示。其中第二列代表预训练数据集中的图像数目,“—”表示该模型结果未报告。

表1 图文检索微调实验-召回率

在使用4 M公共预训练数据集的条件下,与ALBEF模型相比,MulGA在MSCOCO和Flickr30 k上的平均召回率分别提升了2.9和1.2.并在Flickr30 k上的文本检索召回率达到了最优水平。当使用6 M预训练数据集时,MulGA展现了与BLIP(Bootstrapping Language-Image Pre-training)相当的性能,在Flickr30 k上的TR@5和TR@10达到100,相比于在更大数据集上预训练的ALBEF,在MSCOCO数据集的TR@1指标上实现了1.9的提升。

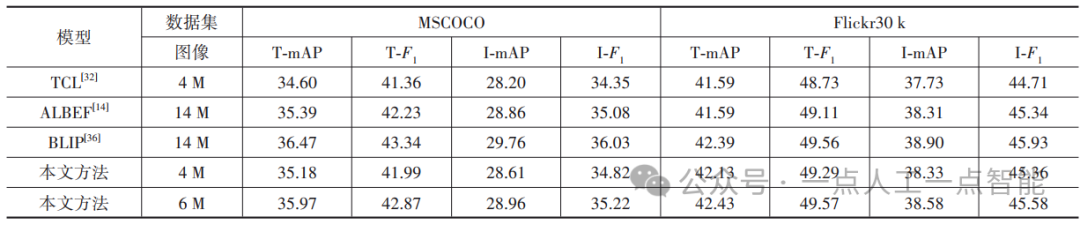

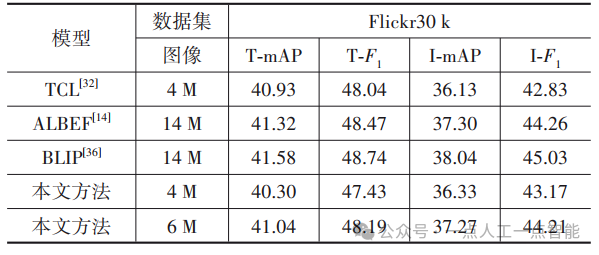

微调检索实验的mAP与F 1分数评估结果如表2所示,其中mAP为模型在1、5、10不同阈值下的精确率均值。在4 M数据条件下,MulGA在MSCOCO数据集上的mAP优于TCL(Triple Contrastive Learning),略低于使用14 M数据预训练的ALBEF和BLIP,在Flickr30 k上mAP和F 1分数仅次于BLIP;当预训练数据扩充到6 M时,mAP增长了1.14,模型性能超过ALBEF,与BLIP模型相近。

表2 图文检索微调实验-精确率、F1分数

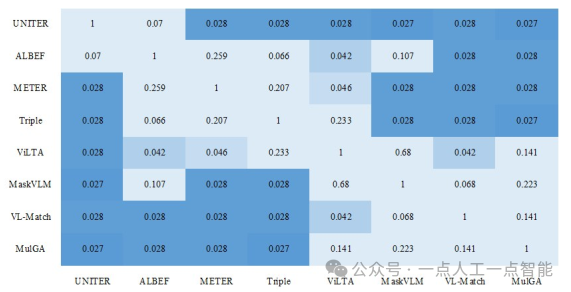

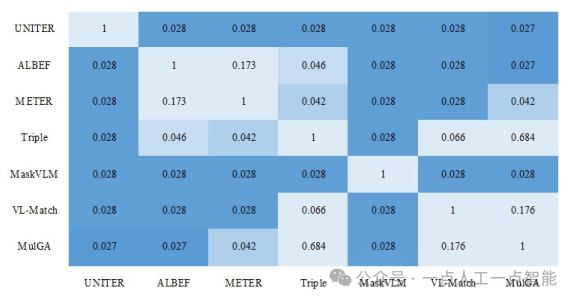

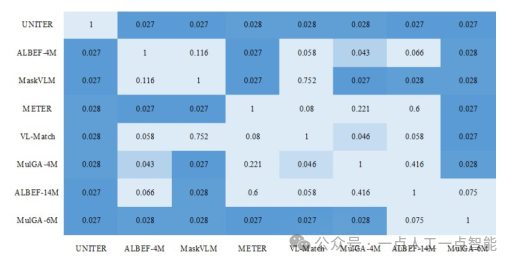

为了验证实验结果的可靠性,本文基于Wilcoxon符号秩检验法,以召回率作为各个模型的样本数据,分析MulGA在图文检索微调任务中相较于其他模型的提升是否显著,各个配对样本的P值以热力图的形式展现,如图6所示。

图6 微调检索实验统计显著性验证

分析结果表明,本文方法与UNITER(UNiversal Image-TExt Representation)、ALBEF、TCL等模型相比,图文检索具有显著性提升,在ViLTA(Vision-Language pretraining through Textual Augmentation)和MaskVLM(Masked Vision and Language Modeling)等模型上,提升并不明显。分析结果基本与R@k、mAP和F 1分数三个评估指标的评估结果一致,证明本文实验结果具有一定可靠性。

3.3.2 图文检索零样本实验

为了评估MulGA的零样本迁移能力,本文将在MSCOCO数据集上微调的模型直接迁移到Flickr30 k数据集上进行了图文检索零样本实验。表3展示了MulGA在Flickr30 k上零样本检索的评估结果。

表3 图文检索零样本实验-召回率

相较于ImageBERT、CLIP和ALIGN,MulGA用更少的训练数据获得了更好的性能。与同等训练数据的模型相比,零样本检索性能也优于ALBEF、METER(Multimodal End-to-end TransformER)等模型。但对比不同数据体量下的两种最优算法VL-Match和BLIP,MulGA在TR@1和IR@1上的表现仍有较大差距,推测可能是固定的视觉压缩比例导致在进行零样本迁移时无法准确压缩图像冗余信息,一定程度的主体结构信息被破坏,最终影响了模型性能。

零样本检索实验的mAP与F1分数评估结果在表4中显示。MulGA零样本迁移表现与TCL模型相当。将预训练数据集扩充到6 M大小时,模型的零样本检索性能会有显著提升。这一结果表明,通过扩大预训练数据集规模,可以有效增强模型在处理零样本迁移任务时的泛化能力。

表4 图文检索零样本实验-精确率、F1分数

为了验证零样本实验结果的可靠性,本文对实验数据进行了显著性分析,统计显著性验证结果如图7所示。

图7 零样本检索实验统计显著性验证

从图中结果可以得出结论,MulGA在零样本检索实验中与UNITER、ALBEF、MaskVLM相比,具有显著的性能提升,但与METER、VL-Match(enhancing Vision-Language with token-level Matching)模型相比提升不具备显著性,总体表现与TCL模型相近。

3.4 视觉语言分类任务评估

为了进一步验证MulGA的性能,本文在视觉问答、视觉推理和视觉蕴含三个视觉语言分类任务上进行了实验。

3.4.1 视觉问答实验

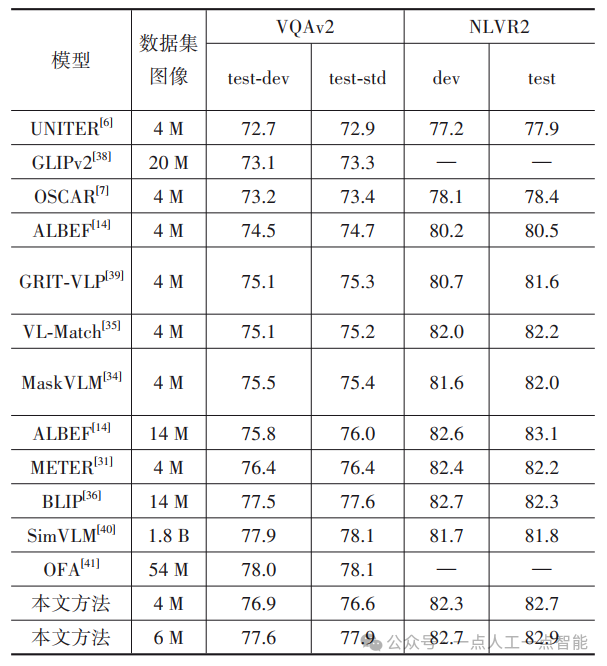

视觉问答(Viual Question Answering,VQA)任务要求模型根据给定的图像和问题,生成或从答案集合中选择出正确的答案。本文在VQAv2[37]数据集上微调和评估MulGA的视觉问答能力。评估结果在表5中展示。

表5 视觉问答和视觉推理实验结果

基于4 M数据集, MulGA在Test-Dev和Test-Std上的准确率优于所有同等训练体量的对比算法,甚至超越了使用更大数据集进行预训练的GLIPv2(Grounded Language-Image Pre-training v2),其中与基础的ALBEF模型相比,准确率分别提升了3.22和2.54.在6 M预训练数据的条件下,MulGA在视觉问答下游任务中的平均准确率达到了77.75。

3.4.2 视觉推理实验

视觉推理(Natural Language for Visual Reasoning,NLVR)任务侧重于预测文本标题是否与一对图像的内容相符。本文在NLVR2[42]数据集上进行微调实验,并使用准确率进行评估。

如表5所示,MulGA在视觉推理任务上的表现超越了所有对比算法。使用4 M数据预训练的MulGA,在NLVR2的test测试集上准确率达到了最佳水平。与大模型相比,使用6 M数据预训练的MulGA表现出了与ALBEF和BLIP相当的性能,在dev和test测试集上分别比SimVLM(Simple Visual Language Model)提升了1.22和1.36.

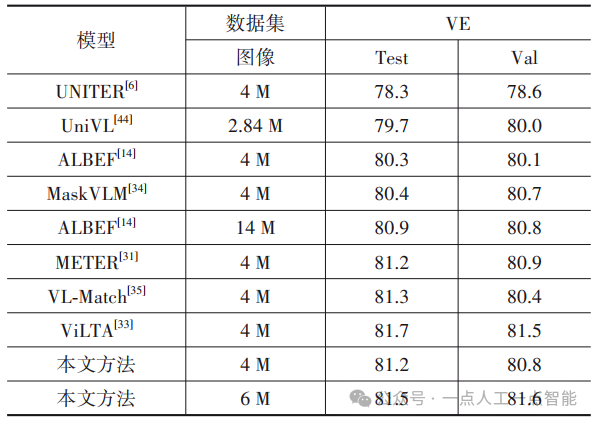

3.4.3 视觉蕴含实验

视觉蕴含(Visual Entailment,VE)任务是一个判断一幅图像和一段文本之间的关系是蕴含的、中性的还是矛盾的三分类问题。本文在SNLI-VE[43]数据集上微调模型,并评估分类的准确率,结果如表6所示。

表6 视觉蕴含实验结果

在4 M数据的条件下,MulGA在test和val上的平均准确率达到了81.0,相较于具有相似网络架构和训练范式的ALBEF模型,实现了0.99的性能提升。使用6 M数据训练的MulGA在val上取得81.6的最佳表现。

3.4.4 分类任务显著性分析

为了分析MulGA在视觉语言分类任务上是否具有显著性提升,本文将视觉问答、视觉推理和视觉蕴含三个下游任务的测试结果整合作为样本数据,对视觉语言分类任务的数据结果进行了统计显著性验证测试,检验结果如图8所示。

图8 视觉语言分类统计显著性验证

MulGA在4 M训练数据条件下,与其他同体量模型都满足显著性差异条件,当数据扩充到6 M大小时,MulGA相较于4 M的基础模型P值为0.028.证明适当扩充预训练数据集规模,能够显著提升模型在下游任务上的性能表现。

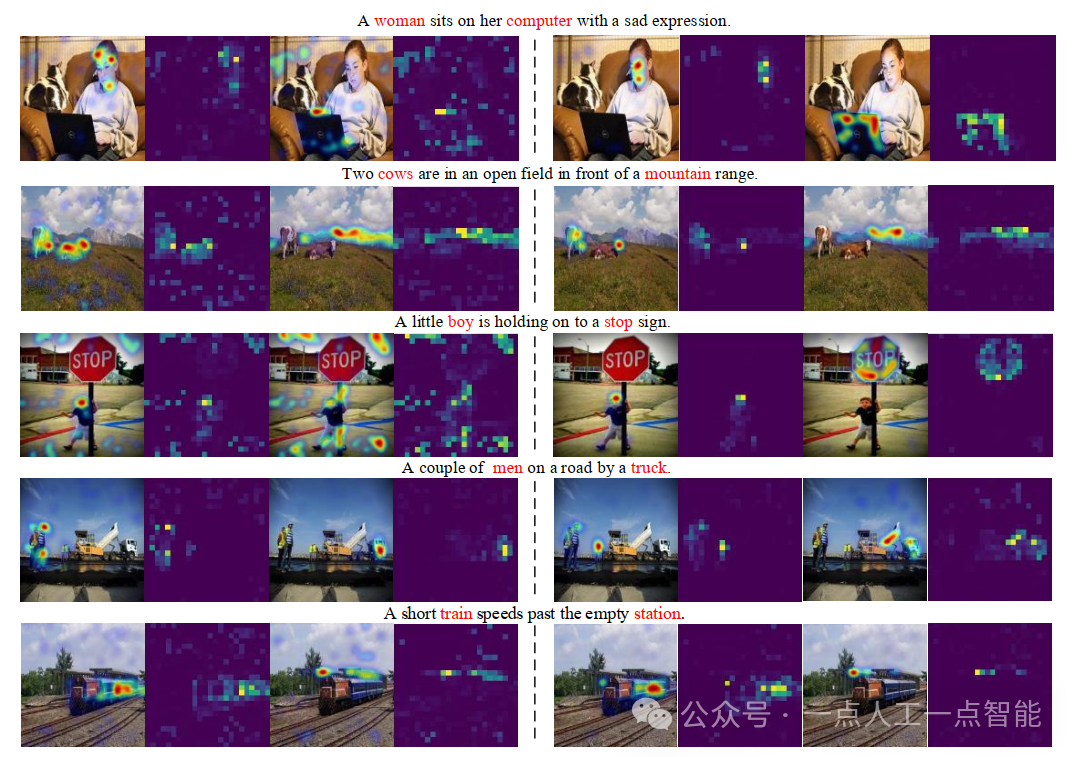

3.5 细粒度匹配分析

本文通过对融合编码器中交叉注意力层的注意力进行可视化,检验MulGA模型的细粒度匹配能力。图9展示了MulGA与ALBEF交叉注意力可视化的对比结果,其中左侧为ALBEF,右侧为MulGA。

图9 细粒度匹配对比结果

结果表明,ALBEF模型在进行微调后虽然能够正确匹配图像对象和对应的文本字词,但会受到图像背景信息的干扰,注意力权重较为分散。而MulGA经过视觉序列压缩和细粒度关系推理后,更好地学习了图像和文本细粒度对齐关系,对实义单词所指代的具体图像实例聚焦更为准确,在准确识别图像对象、属性、动作和数量等细粒度特征方面具有优越性。

3.6 消融实验

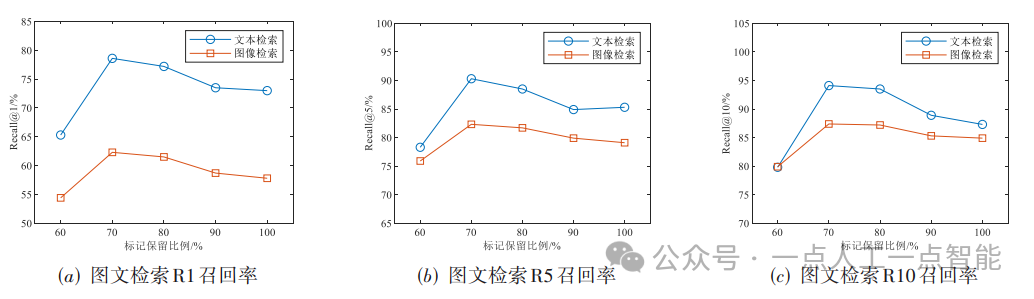

3.6.1 标记保留比例分析

在视觉序列压缩过程中,每层的视觉标记保留比例 λ是在训练前预设的超参数。为了研究不同标记保留比例对于视觉序列压缩的影响,本文使用不同的视觉标记保留 λ比例预训练5个周期,并在Flicker30 k上比较零样本图文检索的性能变化,如图10所示。

图10 不同保留比例的图文检索性能

随着视觉标记保留比例 λ的增加,模型在图文检索任务上的总体效果表现为先上升后下降的趋势,当 λ减小到60时,召回率大幅下降,推测是由于视觉标记保留比例过低,图像的大部分信息被压缩,破坏了图像主体信息的完整性,从而影响检索性能。将 λ增加到90时,视觉序列压缩对模型性能提升不大。而当 λ为70时,图文检索各指标均优于其他测试值,因此,本文设定每层视觉标记保留比例为70。

3.6.2 图像文本联合引导分析

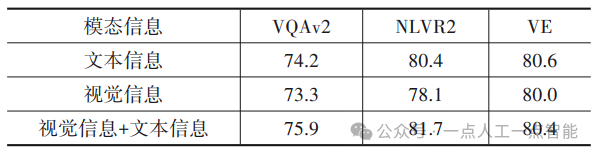

为了分析视觉序列压缩方法中,图像文本联合引导对模型有效性的影响,本文在视觉问答、视觉推理、视觉蕴含三个下游任务上,分别测试了仅使用视觉信息引导和仅文本信息引导的视觉序列压缩效果。实验结果在表7中展示。

表7 不同模态信息指导下的实验结果

与使用融合了两种模态的多模态信息引导视觉序列压缩相比,无论是视觉信息还是文本信息,仅依赖单一模态信息会产生较差的结果。因此,使用图像信息和文本信息来联合指导视觉编码器压缩视觉序列中的冗余信息,在视觉语言多模态学习中更具有效性。

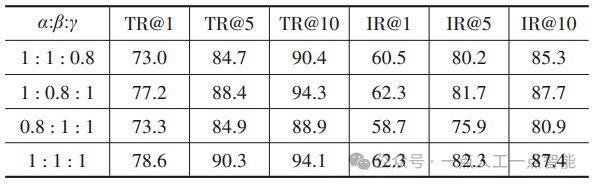

3.6.3 损失函数权重分析

为了研究ITC、ITM和MLM三个损失对模型的贡献程度,本文以1:1:0.8、1:0.8:1、0.8:1:1和1:1:1四种不同的损失函数权重,分别进行5个周期的预训练,并在Flicker30k数据集上做零样本图文检索实验,分析三种损失对模型的影响,实验结果如表8所示。

表8 损失函数不同权重占比下的实验结果

对比第一行、第三行和第四行数据,当降低ITC损失和MLM损失比重时,对模型零样本检索的性能的影响较大,图像检索和文本检索的召回率都有明显下降;对比第二行与第四行数据,当降低ITM损失比重时,TR@1和TR@5分别降低了1.78和2.1,IR@5降低了0.7.分析结果证明,三个损失都会对模型作出积极贡献。

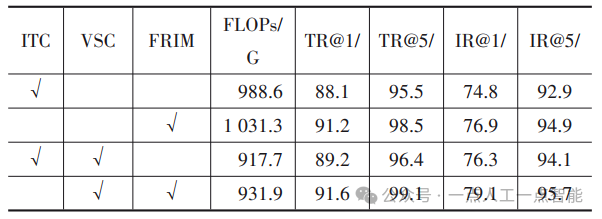

3.6.4 视觉序列压缩与细粒度关系推理消融

本文比较了不添加任何组件、单FRIM组件、单VSC组件和VSC+FRIM组合4种不同情况下模型的微调检索性能。同时,在单张GPU上计算一个训练批次数据前向传播的浮点运算次数(Floating Point Operations,FLOPs),实验结果在表9中展示。需要注意的是,为了保证先对齐再融合的统一训练范式,单VSC组件测试并没有直接删除FRIM,而是使用原始的ITC进行替换。

表9 在Flickr30 k上使用不同模块组合进行预训练的图文检索评估

第一行与第二行相比,将ITC更换为FRIM,虽然增加了少量计算量,但图文检索的召回率都获得了提升;第三行在第一行的基础上添加了VSC,显著降低了模型的计算复杂度,在提升模型效率的同时改善了检索性能;第四行组合了VSC与FRIM,与第三行相比,计算成本略微增加,在文本检索和图像检索的性能分别提升了2.81和2.6,实验结果表明,本文提出的VSC和FRIM两个关键组件能够有效提升多模态模型的性能和效率。

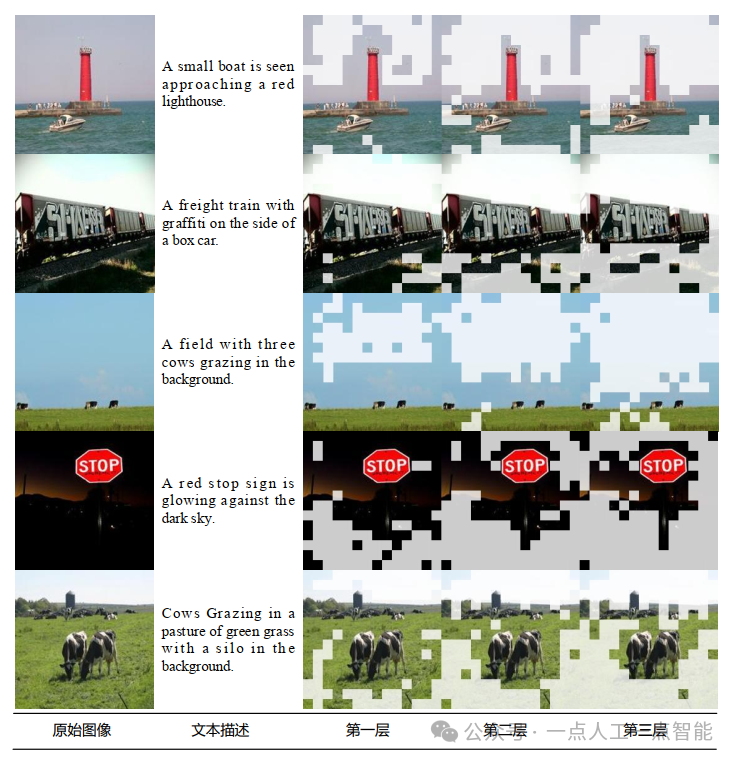

3.7 可视化

为了验证本文提出的图像文本联合引导的视觉序列压缩方法的有效性,从MSCOCO数据集中随机采样了部分数据作为样本输入,可视化视觉编码器中3个视觉序列压缩层所选择的相关视觉标记,如图11所示。

图11 相关视觉标记选择可视化

随着层数增加,视觉相关标记逐渐减少,图像中与文本描述不相关的背景信息被逐渐过滤,模型更加关注文本所描述的主题内容。证明本文的视觉序列压缩方法能够在图像信息和文本信息的联合指导下,有效地减少视觉序列中的冗余信息,保留与文本描述相关的主题内容。

结论

本文提出了一种基于跨模态引导和对齐的视觉语言多模态预训练方法,成功解决了现有模型在模态间缺乏显式细粒度对齐机制的问题。

通过引入视觉序列压缩模块和细粒度关系推理模块,显著提升了模型在多个视觉语言任务中的性能,尤其在图文检索和视觉问答任务中表现出色。该方法在增强模态间细粒度特征对齐方面展现出强大能力,为多模态预训练模型的发展提供了新的思路。

如何学习大模型 AI ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

- 硬件选型

- 带你了解全球大模型

- 使用国产大模型服务

- 搭建 OpenAI 代理

- 热身:基于阿里云 PAI 部署 Stable Diffusion

- 在本地计算机运行大模型

- 大模型的私有化部署

- 基于 vLLM 部署大模型

- 案例:如何优雅地在阿里云私有部署开源大模型

- 部署一套开源 LLM 项目

- 内容安全

- 互联网信息服务算法备案

- …

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名大模型 AI 的正确特征了。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

885

885

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?