Abstract

图是连接数据网络结构的一种常用表示形式。图数据的应用领域很广泛,如社会系统、生态系统、生物网络、知识图和信息系统。图学习(即基于图的机器学习)正受到研究者和实践者的关注。 图学习在很多任务上被证明是有效的,如分类,链接预测和匹配。图学习方法通常是利用机器学习算法提取图的相关特征。在这个调查中,我们对当前最先进的图学习提出了一个全面的概述,重点关注现有的四种图学习方法,包括图信号处理、矩阵分解、随机游走和深度学习。 并且回顾了这些方法各自的主要模型和算法。我们研究了诸如文本、图像、科学、知识图和组合优化等领域的图学习应用。此外,我们还讨论了该领域几个有前景的研究方向。

Introduction

Graphs,也被称为一种网络,他可以从真实世界下的丰富实体之间的关系中被提取。一些常见的图已经被广泛用于表达不同的关系,如社会网络、生物网络、专利网络、交通网络、引文网络和通信网络。图通常由两个集合定义,即点集和边集。点表示图形中的实体,而边表示这些实体之间的关系。由于图学习在数据挖掘、知识发现等领域的广泛应用,进而引起了人们的广泛关注。由于图利用了点之间的本质和相关关系,在捕获复杂关系方面,图学习方法受到了越来越多的关注。例如,在微博网络中,通过检测信息级联,可以跟踪谣言的传播轨迹。在生物网络中,通过推测蛋白质的相互作用可以发现治疗疑难疾病的新方法。在交通网络中,通过分析不同时间戳的共现现象,可以预测人类的移动模式。对这些网络的有效分析很大程度上取决于网络的表示方式。

A. What is Graph Learning?

一般来说,图学习是指对图进行机器学习。图学习方法将图的特征映射到嵌入空间中具有相同维数的特征向量。图学习模型或算法直接将图数据转换为图学习体系结构的输出,而不将图投影到低维空间。由于深度学习技术可以将图数据编码并表示为向量,所以大多数图学习方法都是基于或从深度学习技术推广而来的。图学习的输出向量在连续空间中。图学习的目标是提取图的期望特征。因此,图的表示可以很容易地用于下游任务,如节点分类和链接预测,而无需显式的嵌入过程。因此,图学习是一种更强大、更有意义的图分析技术。

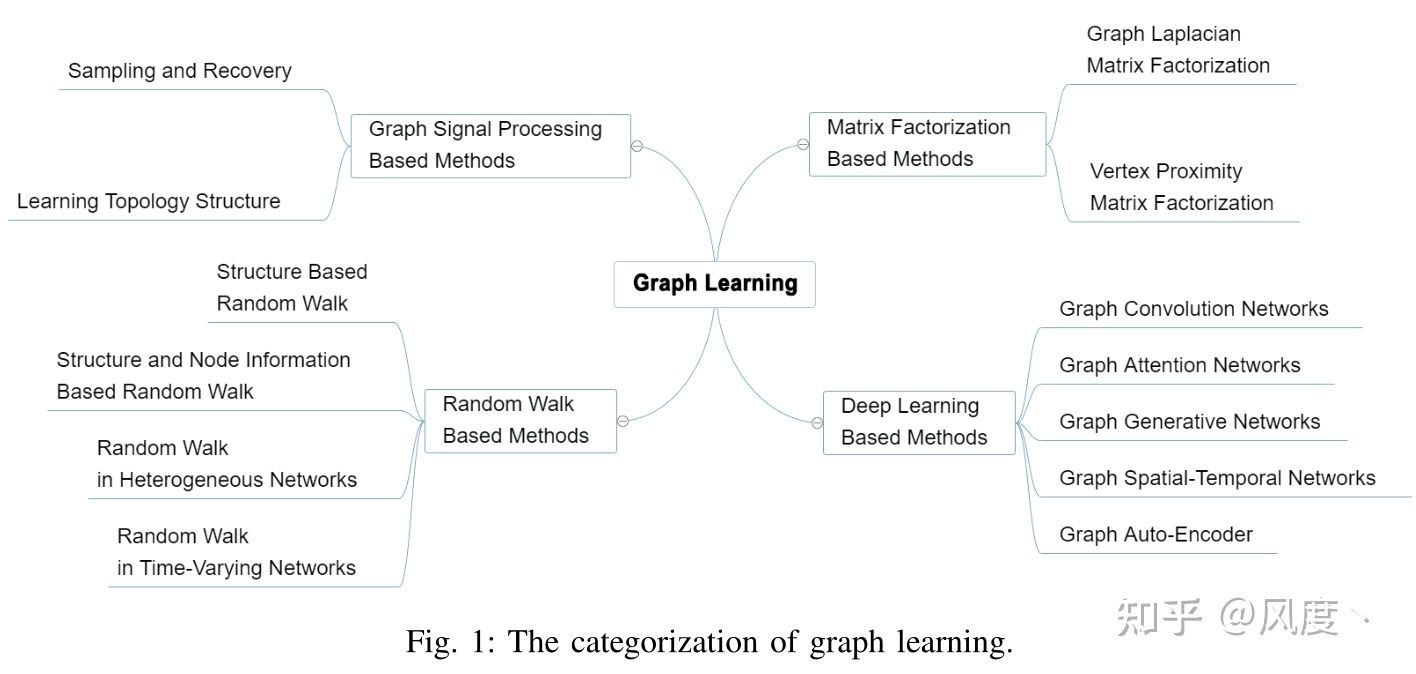

在这篇综述文章中,我们试图以一种综合的方式来检验机器学习方法。如图1所示,我们关注现有的方法,这些方法分为以下四类:基于图形信号处理(GSP)的方法、基于矩阵分解的方法、基于随机游走的方法和基于深度学习的方法。

粗略地说,GSP处理的是图的采样和恢复,以及从数据中学习拓扑结构。矩阵分解可以分为图拉普拉斯矩阵分解和节点邻接矩阵分解。基于随机游走的方法包括基于结构的随机游走、基于结构和节点信息的随机游走、异构网络中的随机游走以及 time-varying网络中的随机游走。基于深度学习的方法包括图卷积网络(GCN)、图注意网络(GAT)、图自编码器、图生成网络和图时空网络。基本上,这些方法/技术的模型架构是不同的。本文对目前最先进的图学习技术进行了广泛的回顾。

传统上,研究人员采用邻接矩阵来表示一个图,它只能捕捉相邻两个顶点之间的关系。然而,许多复杂和不规则的结构不能被这种简单的表示捕获。当我们分析大规模网络时,传统的方法在计算上是昂贵的,并且很难在现实应用中实现。因此,有效地表示这些网络是解决[4]的首要问题。近年来提出的网络表示学习(NRL)可以学习低维表示的网络顶点隐藏特征。当新的表示被学习后,可以使用以前的机器学习方法来分析图数据,并发现数据中隐藏的关系。

当复杂网络被嵌入到一个潜在的、低维的空间中时,结构信息和顶点属性可以被保留。因此,网络的顶点可以用低维向量表示。在以往的机器学习方法中,这些向量可以看作是输入的特征。图学习方法为新的表示空间中的图分析铺平了道路,许多图分析任务,如链接预测、推荐和分类,都可以被有效解决。网络的图形化表现方式揭示了社会生活的各个方面,如交流模式、社区结构和信息扩散。

根据顶点、边和子图的属性,可以将图学习任务分为基于顶点、基于边和基于子图三类。图中顶点之间的关系可以用于分类、风险识别、聚类和社区检测。通过判断图中两个顶点之间的边的存在,我们可以进行推荐和知识推理。基于子图的分类,该图可用于聚合物分类、三维可视化分类等。对于GSP,设计合适的图形采样方法以保持原始图形的特征,从而有效地恢复原始图形具有重要意义。在存在不完整数据的情况下,可以使用图恢复方法构造原始图。然后利用图学习方法从图数据中学习拓扑结构。综上所述,利用图学习可以解决传统图分析方法难以解决的以下问题。

- 不规则域:传统传感器采集的数据具有清晰的网格结构。然而,图位于不规则域(即非欧几里得空间)。与正则域(即欧几里得空间)相比,非欧几里得空间中的数据是没有规则排列的。因此,距离是很难定义的。因此,基于传统机器学习和信号处理的基本方法不能直接推广到图。

- 异构网络:在很多情况下,传统图分析算法所涉及的网络都是同构的。适当的建模方法只考虑网络的直接连接,剔除其他无关信息,大大简化了处理过程。但是,它容易造成信息的丢失。在现实世界中,顶点之间的边和顶点的类型通常是多样的,如图2所示的学术网络。因此,很难从具有丰富顶点和边缘的异构信息网络中发现潜在的价值。

- 分布式算法:在大型社交网络中,通常有数百万个顶点和边。集中式算法无法解决这一问题,因为随着顶点数的增加,集中式算法的计算复杂度会显著增加。设计分布式算法处理大型网络是一个亟待解决的关键问题。分布式算法的一个主要优点是,算法可以同时在多个cpu或gpu上执行,因此可以显著减少运行时间。

B. Related Surveys

。。。

C. Contributions and Organization

本文的贡献可归纳如下。

- 最先进的图学习方法的全面概述:我们将对图学习方法进行完整的介绍,包括技术梗概、应用场景和潜在的研究方向。

- 图学习的分类:我们从理论模型的角度对主流图学习方法进行了技术分类。在适当的地方提供技术描述,以提高对分类的理解。

- 对图学习未来发展方向的洞察:除了对现有方法进行定性分析外,我们还通过总结几个悬而未决的问题和相关挑战,阐明了图学习领域的潜在研究方向。

本文的其余部分组织如下。第二节概述了图学习方法,包括基于图信号处理的方法、基于矩阵分解的方法、基于随机游走的方法和基于深度学习的方法。第三节讨论了图学习的应用。第四部分讨论了未来的发展方向和挑战。第五部分总结了调查结果。

GRAPH LEARNING MODELS AND ALGORITHMS

A. Graph Signal Processing

信号处理是一门传统的学科,它处理规则数据域中定义的信号。近年来,研究人员将传统信号处理的概念扩展到图。经典的信号处理技术和工具,如傅里叶变换和滤波可以用来分析图形。一般来说,图形是一种难以直接处理的不规则数据。作为一种基于结构和模型的学习方法的补充,GSP为图的谱分析提供了一个新的视角。从信号处理的角度出发,GSP可以解释图的连通性、相似性等特性。图3给出了某一时间点的图信号的简单例子,这里被定义为观测值。在图中,上述观测值可视为图信号。然后将每个节点映射到GSP中的实数字段。GSP的主要任务是扩展信号处理方法,挖掘图中的隐含信息。

D. Deep Learning on Graphs

深度学习是过去几年里最热门的领域之一。然而,将现有的神经网络模型,如循环神经网络(RNNs)或卷积神经网络(CNNs)扩展到图形数据是一项具有吸引力和挑战性的任务。Gori等提出了一种基于递归神经网络的GNN模型。在该模型中,实现了一个传递函数,将图或其顶点映射到m维欧氏空间。近年来,人们提出了许多GNN模型。

1)图卷积网络:GCN基于网格结构域和图结构域[122]。

时域和谱方法。卷积是深度学习中常用的运算之一。然而,由于图形缺乏网格结构,对图像或文本的标准卷积不能直接应用于图形。Bruna等[122]利用图的拉普拉斯矩阵将CNN算法从图像处理扩展到图,称为光谱图CNN。其主要思想类似于信号处理的傅里叶基。在[122]的基础上,Henaff等[123]定义了kernel,通过类比cnn在图像上的局部连接来减少学习参数。Defferrard等人[124]提出了两种基于图论将cnn泛化到图结构数据的方法。一种方法是利用多项式核进行参数约简,该方法可以利用切比雪夫多项式近似来加速。另一种方法是特殊的池化方法,在顶点构造的二叉树上池化。Kipf和Welling[125]引入了改进版[124]。该方法是一种图的半监督学习方法。该算法采用一种优秀而直接的神经网络,并采用一种基于谱卷积在图上的一阶近似的逐层传播规则,可以直接作用于图上。

空域和空间方法。谱域图理论提供了图的卷积方法,但许多NRL方法直接在空间域对图进行卷积运算。Niepert等人[132]对图应用了图标记过程,如Weisfeiler-Lehman内核,以生成唯一的顶点顺序。生成的子图可以反馈给传统的空间域CNN操作。Duvenaud等人[133]设计了神经指纹(FP),这是一种使用一阶邻居的空间方法,类似于GCN算法。Atwood和Towsley [134]提出了另一种卷积方法,称为扩散-卷积神经网络,它结合了转移概率矩阵,用扩散基代替了卷积的特征基。Gilmer等人[135]将现有模型重构为单一的通用框架,并利用该框架发现新的变体。Allamanis等人[136]从句法和语义上表示代码的结构,并利用GNN方法来识别程序结构。

2)图注意力网络:

在基于序列的任务中,注意机制已被视为一种标准[142]。GNNs从注意力机制的扩展模型能力中获益良多。GAT是一种基于空间的GCN网络[143]。它在确定顶点邻居的权重时考虑了注意机制。同样,门控注意网络也引入了多头注意机制来更新一些顶点的隐藏状态[144]。与GAT不同,GANN采用一种自注意力机制,可以为不同的head计算不同的权重。为了解决不同的问题,还提出了其他一些模型,如图形注意模型[145]。以GAM为例,GAM的目的是处理图分类。因此,GAM被设置为通过自适应地访问一系列重要顶点来处理信息部分。GAM的模型包含LSTM网络,一些参数包含历史信息、策略以及通过图的探索生成的其他信息。注意力游走(AWs)是基于GNN和随机行走的另一种学习模型[146]。与DeepWalk相反,AWs在分解共现矩阵时使用可区分的注意力权重[88]。

339

339

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?