一文教你使用扩散模型生成音频

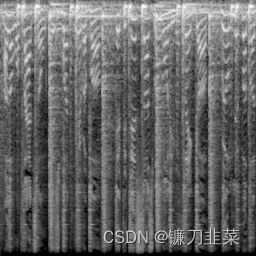

音频扩散是罗伯特·达加维尔·史密斯(Robert Dargavel Smith)的,它利用图像生成领域的最新进展,通过将音频样品转换为MEL频谱图。如下面所示。Mel.py中的类Mel可以将音频片段转换为x_res x y_res的Mel频谱图,反之亦然。分辨率越高,丢失的音频信息就越少。DDPM在从音频文件目录生成的一组mel声谱图上进行训练。然后,它被用来合成类似的mel频谱图,然后将其转换回音频。

本文介绍源音频数据与频谱之间的转换方法,以及如何将音频数据转换为频谱所使用的生成器,然后微调一个指定曲风的音频扩散模型,最后将自己的管线上传到Hugging Face Hub。

Audio Diffusion 代码仓库:https://github.com/teticio/audio-diffusion

使用扩散模型生成音频

首先导入相关依赖库

!pip install diffusers transformers git

本文详细介绍了如何使用音频扩散模型生成和转换音频,包括从预训练模型采样、音频到频谱的转换、微调模型以及在Hugging Face Hub上传模型。重点讨论了DiffWave、VoiceGrad和FastDiff等扩散模型在音频生成中的应用。

本文详细介绍了如何使用音频扩散模型生成和转换音频,包括从预训练模型采样、音频到频谱的转换、微调模型以及在Hugging Face Hub上传模型。重点讨论了DiffWave、VoiceGrad和FastDiff等扩散模型在音频生成中的应用。

订阅专栏 解锁全文

订阅专栏 解锁全文

109

109

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?