点击上方“3D视觉工坊”,选择“星标”

干货第一时间送达

作者丨paopaoslam

来源丨 泡泡机器人SLAM

标题:360VO: Visual Odometry Using a Single 360 Camera

作者:Huajian Huang and Sai-Kit Yeung

来源:2022 IEEE International Conference on Robotics and Automation (ICRA)

编译:邓怡琳

审核:Zoe,王靖淇

摘要

本文提出了一种新的直接视觉里程计算法,利用360度相机实现鲁棒的定位和建图。本系统使用球面相机模型来处理无需校正的等距柱状图像,扩展稀疏直接法视觉里程计(DSO,direct sparse odometry),从而实现全方位感知。将建图和优化算法应用用于新模型后,可以在局部窗口中对含内、外参在内的相机参数以及三维建图进行联合优化。此外,我们在真实世界和大规模模拟场景中对所提出的算法进行了定性和定量的评估。大量实验表明,我们的系统达到了SOTA的结果。

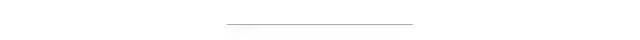

图1 左上方图中是仅由两个超宽视场镜头组成的典型全景相机。右上角是该360相机成像的例图。随着透镜制造行业的成熟,超宽视野透镜变得更便宜,成像质量也更高。下方的图是由本文中360VO系统重建的地图。

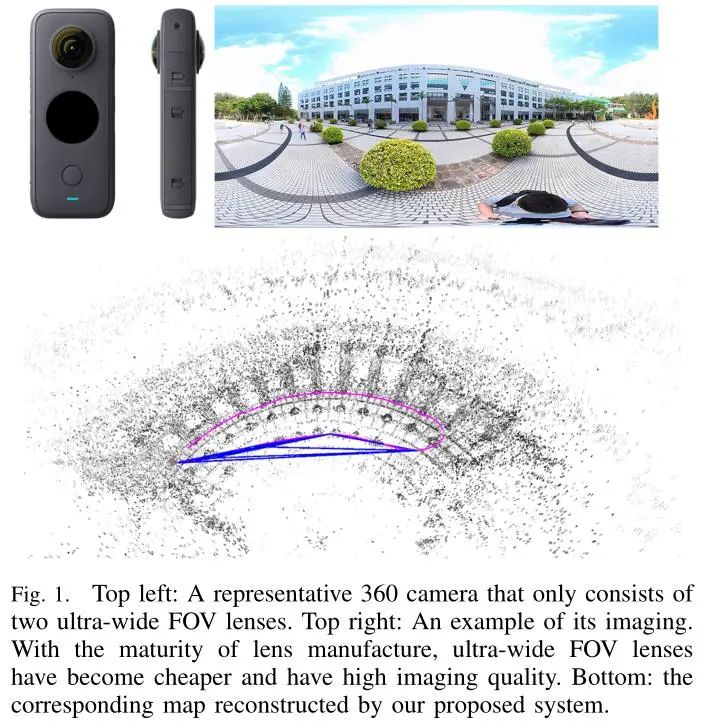

图2 360VO系统概览。该系统的输入是一串等距柱状的帧序列。初始化后,系统在局部窗口中跟踪并优化相关模型参数。

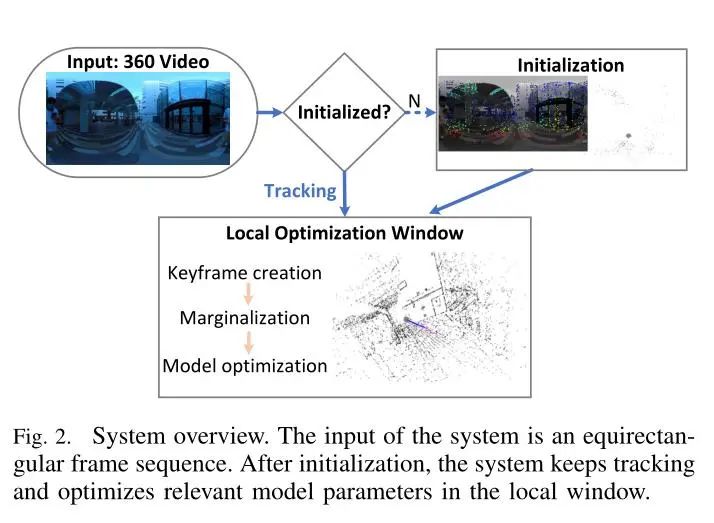

图3 上图显示的是360VO的坐标系,它利用了球面模型的优点来表示相机投影。此外,2D图像是等距柱状投影。

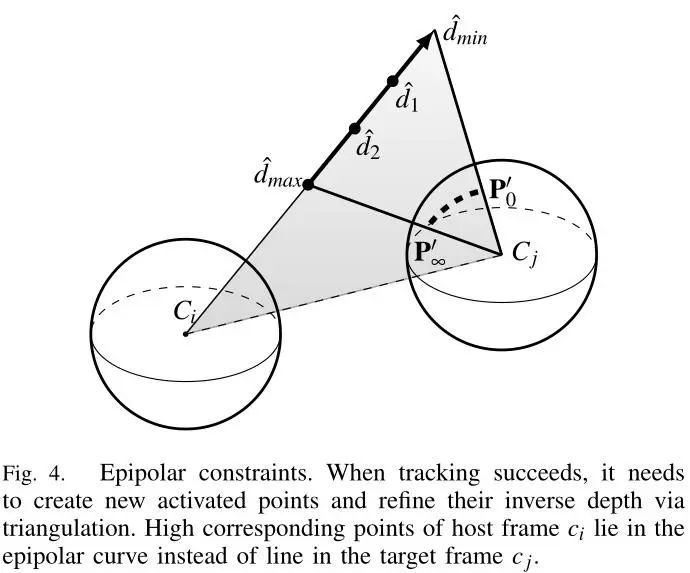

图4 极线约束。当成功追踪时需要创建新的激活点,并通过三角化来细化它们的逆深度。主帧Ci的高对应点位于极线曲线上,而非位于目标帧Cj中的直线上。

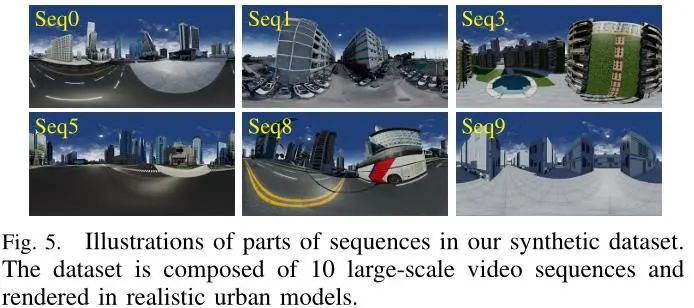

图5 合成数据集中部分序列的代表帧。该合成数据集是在真实的城市模型中渲染得到的,由10个大型视频序列组成。

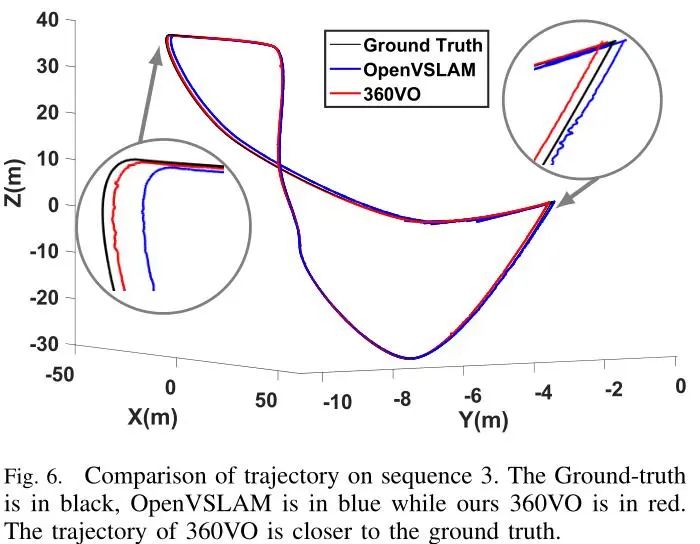

图6 基于序列3的轨迹比较。图中黑色曲线表示Ground-truth,蓝色曲线表示OpenVSLAM得到的轨迹,红色曲线表示本文提出的360VO得到的轨迹。结果显示360VO的轨迹更接近于真值。

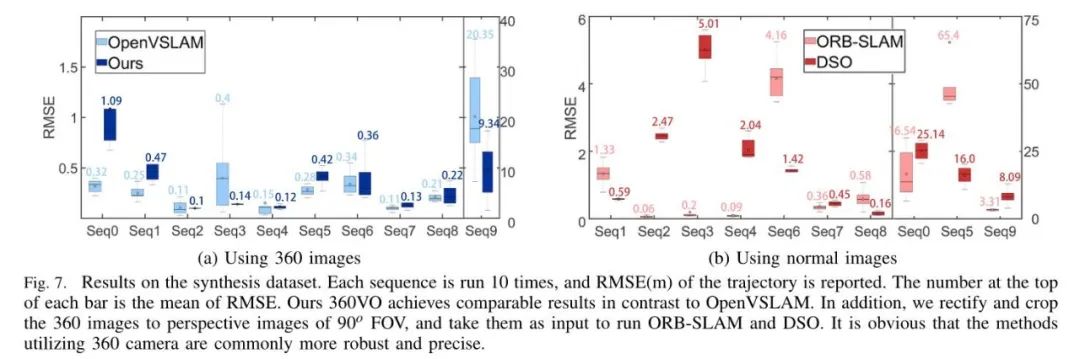

图7 上图是合成数据集得到的的结果。每个序列运行10次,得到轨迹的均方根误差(RMSE,Root Mean Square Error)。图中每个柱形顶部的数字是均方根误差的平均值。与OpenVSLAM相比,我们的360VO取得了可观的结果。此外,我们将360°的图像校正并裁剪为90°视场的透视图像,并将其作为运行ORB-SLAM和DSO的输入。显然,利用360相机的方法通常更鲁棒、精度更高。

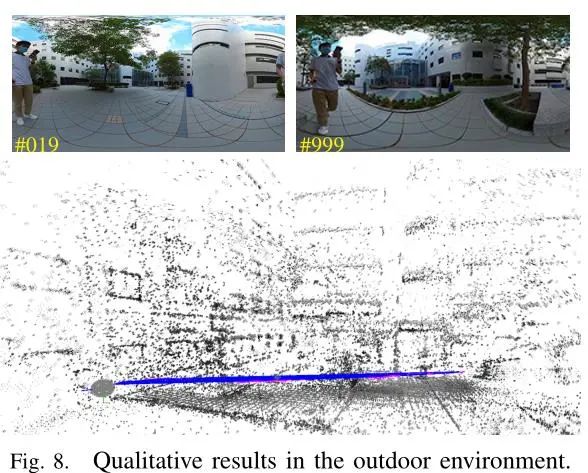

图8 360VO在室外环境中测试的定性结果

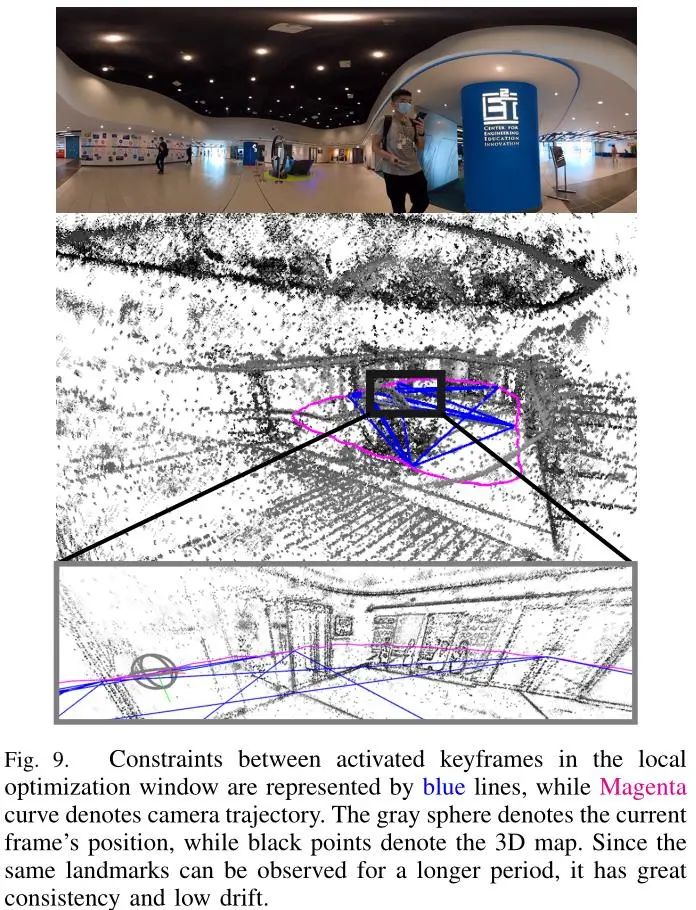

图9 图中蓝色线表示局部优化窗口中激活关键帧间的约束,品红色曲线表示相机轨迹。灰色的球体表示当前帧的位置,而黑色的点表示3D地图。由于同一个地标可以被长时间地观测到,本文中算法得到的结果具有较好的一致性和较低的漂移。

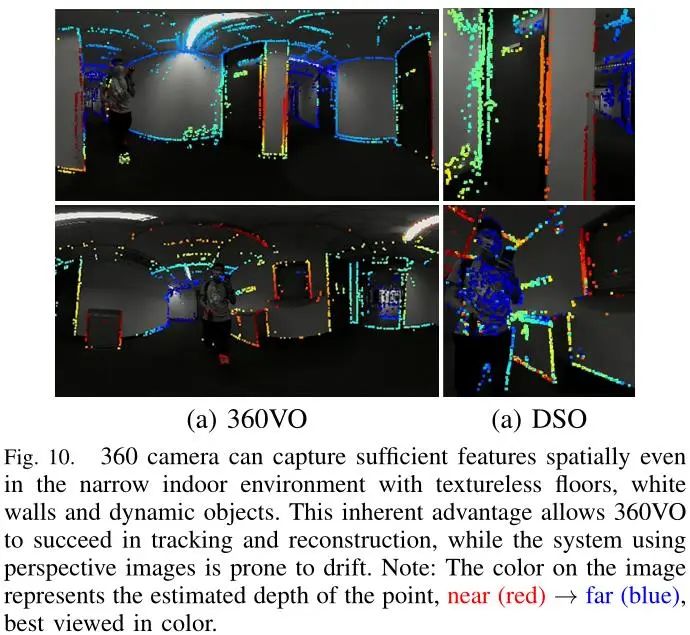

图10 即使在有着无纹理地板、白色墙壁和动态物体的狭窄的室内环境中,360相机也能在空间上捕捉到足够的特征。这种固有的优势使得360VO能够成功地跟踪和建图,而使用透视图像的系统则容易产生漂移。注:图像上的颜色表示点的估计深度,近(红色)→远(蓝色)

Abstract

In this paper, we propose a novel direct visual odometry algorithm to take the advantage of a 360-degree camera for robust localization and mapping. Our system extends direct sparse odometry by using a spherical camera model to process equirectangular images without rectification to attain omnidirectional perception. After adapting mapping and optimization algorithms to the new model, camera parameters, including intrinsic and extrinsic parameters, and 3D mapping can be jointly optimized within the local sliding window. In addition, we evaluate the proposed algorithm using both real world and large-scale simulated scenes for qualitative and quantitative validations. The extensive experiments indicate that our system achieves start of the art results.

如果你对本文感兴趣,请点击点击阅读原文下载完整文章

百度网盘提取码:iwet

本文仅做学术分享,如有侵权,请联系删文。

点击进入—>3D视觉工坊学习交流群

干货下载与学习

后台回复:巴塞罗那自治大学课件,即可下载国外大学沉淀数年3D Vison精品课件

后台回复:计算机视觉书籍,即可下载3D视觉领域经典书籍pdf

后台回复:3D视觉课程,即可学习3D视觉领域精品课程

3D视觉工坊精品课程官网:3dcver.com

1.面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码)

2.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进

3.国内首个面向工业级实战的点云处理课程

4.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解

5.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦

6.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化

7.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

16.透彻理解视觉ORB-SLAM3:理论基础+代码解析+算法改进

重磅!粉丝学习交流群已成立

交流群主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、ORB-SLAM系列源码交流、深度估计、TOF、求职交流等方向。

扫描以下二维码,添加小助理微信(dddvisiona),一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿,微信号:dddvisiona

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、源码分享、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答等进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,6000+星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看,3天内无条件退款

高质量教程资料、答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~

4053

4053

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?