mIoU(Mean Intersection over Union) 是图像分割任务中衡量模型性能的核心指标,尤其广泛应用于语义分割和实例分割。以下是关于mIoU的详细解析:

一、mIoU的定义

- IoU(交并比):预测区域与真实区域的交集面积除以并集面积,衡量两者重叠程度。

- mIoU(平均交并比):所有类别的IoU的均值,反映模型对多类别的综合分割能力。

- C:类别总数(包括背景类)。

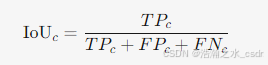

- IoUc:第c个类别的IoU值。

二、mIoU的计算步骤

-

逐类计算混淆矩阵:统计每个类别的TP(真正例)、FP(假正例)、FN(假反例)。

- TP:正确预测为该类的像素数。

- FP:错误预测为该类的像素数。

- FN:真实属于该类但被预测为其他类的像素数。

-

逐类计算IoU:

-

取平均:对所有类别的IoU求均值。

三、mIoU的优缺点

优点:

- 直观性:直接反映分割区域的重叠精度。

- 类别平衡性:平等对待所有类别,适合多类别任务。

- 抗噪声:对孤立错误预测相对鲁棒。

缺点:

- 忽略类别重要性差异:若某些类别需更高精度(如医学病灶),需加权处理。

- 对类别不平衡敏感:小类别IoU波动可能显著影响mIoU。

四、mIoU的应用场景

1. 语义分割

- 场景理解(如Cityscapes数据集):评估道路、车辆、行人等类别的分割精度。

- 医学影像(如肿瘤分割):要求高IoU以减少漏诊(如BraTS数据集mIoU≥80%)。

2. 实例分割

- 目标检测与分割结合:如COCO数据集的实例分割任务,mIoU结合AP指标使用。

3. 遥感图像分析

- 土地利用分类:区分森林、水域、建筑等,mIoU反映整体分割质量。

五、典型数据集的mIoU基准

| 数据集 | 任务类型 | SOTA模型 | mIoU |

|---|---|---|---|

| Cityscapes | 街景语义分割 | DeepLabV3+ | 82.1% |

| PASCAL VOC | 通用语义分割 | PSPNet | 85.4% |

| ADE20K | 场景解析 | SegFormer | 57.0% |

| BraTS | 脑肿瘤分割 | 3D U-Net | 89.0% |

六、mIoU与其他指标的对比

七、代码实现(Python)

import numpy as np

def compute_mIoU(confusion_matrix):

"""

通过混淆矩阵计算mIoU

:param confusion_matrix: 形状为[C, C]的矩阵,confusion_matrix[i][j]表示真实为i类但预测为j类的像素数

:return: mIoU (float)

"""

# 逐类计算IoU

iou_list = []

for c in range(confusion_matrix.shape[0]):

tp = confusion_matrix[c, c]

fp = confusion_matrix[:, c].sum() - tp

fn = confusion_matrix[c, :].sum() - tp

iou = tp / (tp + fp + fn + 1e-10) # 避免除以0

iou_list.append(iou)

# 计算均值

mIoU = np.nanmean(iou_list) # 忽略NaN(如某类别无样本)

return mIoU

# 示例:3个类别(0:背景,1:类A,2:类B)

confusion_matrix = np.array([

[500, 20, 30], # 真实类别0的预测分布

[10, 300, 5], # 真实类别1的预测分布

[15, 3, 250] # 真实类别2的预测分布

])

print(f"mIoU: {compute_mIoU(confusion_matrix):.2%}")

# 输出:mIoU: 85.15%八、优化mIoU的实用技巧

-

改进模型结构:

- 使用多尺度特征融合(如PSPNet的金字塔池化模块)。

- 引入注意力机制(如OCRNet的物体上下文表示)。

-

数据增强:

- 增加小目标样本(如随机裁剪、复制粘贴)。

- 模拟真实场景噪声(如雨雾、运动模糊)。

-

损失函数设计:

- 联合使用交叉熵损失和Dice损失(如Loss = CE + 1-Dice)。

- 针对小类别加权(如Focal Loss)。

-

后处理优化:

- 使用条件随机场(CRF)细化边缘。

- 多模型预测结果集成(如投票法)。

九、总结

- mIoU的核心价值:在多类别分割任务中提供全局性能评估,平衡各类别精度。

- 使用建议:

- 结合业务需求分析各类别IoU(如医学影像中肿瘤类的IoU需单独监控)。

- 类别高度不平衡时,补充加权mIoU或Dice系数。

- 实时性要求高时,权衡mIoU与推理速度(如选择轻量级模型DeepLabV3-MobileNet)。

2280

2280

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?