灾难性遗忘是大模型时代的下一个突破口。

来源:AI科技评论

作者:王悦

编辑:陈彩娴

在人们为 AI2.0 时代的技术进步惊呼和欣喜之时,人工智能和其背后深度学习、神经网络土壤的真实发展水平如何?

关于这一问题的答案或许可以在第六届国际分布式人工智能会议(Distributed Artificial Intelligence Conference,DAI 2024)上窥知一二。DAI 2024 已在新加坡管理大学成功举办,本届会议的亮点之一就是邀请到现代强化学习的奠基人 Richard S. Sutton 教授、昆仑万维荣誉顾问颜水成博士、UC Berkeley Sergey Levine 教授和 Google DeepMind 研究科学家 Georgios Piliouras 博士这四位重量级嘉宾,从多智能体系统、强化学习和具身智能等方面,提出了新的思路和解决方案,给人工智能领域的前沿研究以启发和全新视角。

DAI 2024 现场,现代强化学习的奠基人、阿尔伯塔大学教授 Richard S. Sutton 教授在开幕式上发表了题为《Decentralized Neural Networks》的主旨演讲。Sutton 教授指出,当前人工智能的发展尚未达到真正意义上的全面实现,其主要瓶颈在于深度学习的局限性。这些问题包括灾难性遗忘、可塑性丧失以及模型坍塌等现象,对人工智能的持续学习能力构成了重大挑战。

为应对这些问题,Sutton 教授提出了「去中心化神经网络」的全新概念。该方法的核心理念是赋予每个神经元独立的目标,例如向其他神经元传递有效信息、保持自身活跃等。这种设计旨在实现一种动态平衡:保持“骨干”神经元的稳定性,同时鼓励“边缘”神经元进行探索,从而增强网络的适应性和持续学习能力。

在演讲中,Sutton 教授还分享了他的创新算法——持续反向传播(Continual Backprop)。该算法通过在每轮反向传播中,根据神经元的活跃度选择性地重新初始化部分神经元,从而提升模型的灵活性和学习效果。实验表明,该算法在多个持续学习任务中表现优于传统反向传播方法,为持续学习领域提供了新的解决方案。

AI 科技评论在不改变原意的前提下进行整理:

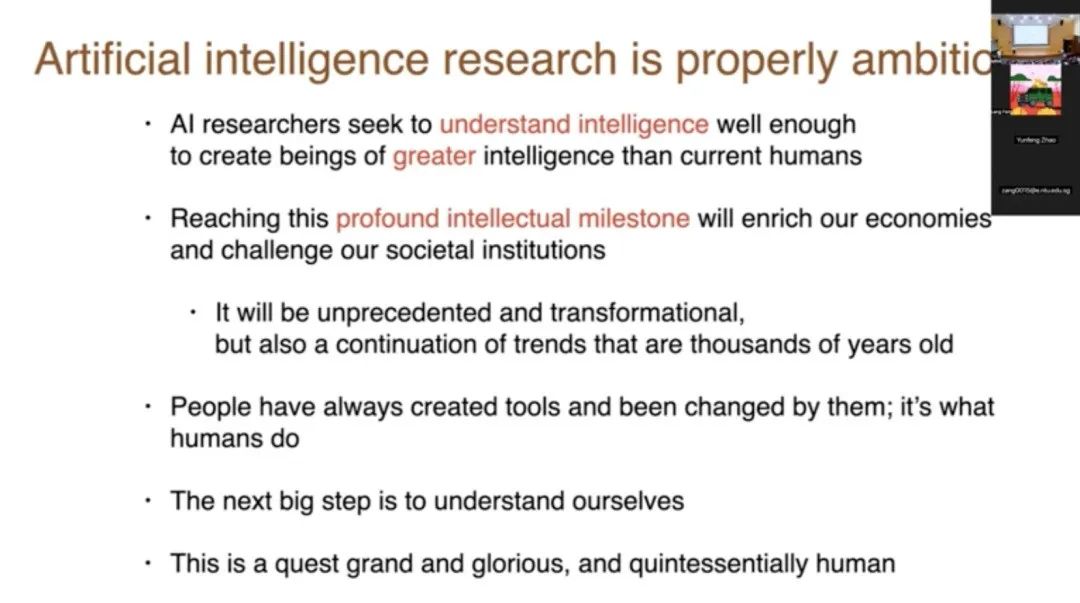

我想先从总体上谈谈人工智能以及我们应该如何抱有雄心壮志。当下,我们到底在尝试做什么?我们试图充分理解智能,以便创造出比当前人类更智能的生物。这是一个深刻的智力里程碑。我们将丰富我们的经济,改变我们的社会制度,这将是变革性的、全新的,但同时也是延续了古老趋势的。人们一直在创造工具,而这些工具也改变了他们。

那么,下一步重大的步骤将是理解我们自己,为此构建工具,这是一个宏伟而光荣的探索,是典型的人类行为。我认为,这是思考人工智能的适当背景。

再次强调,我们必须以谦逊的态度面对这个问题,这是一个如此巨大、重要的问题,而我们面对它时显得如此渺小。我们试图在这方面取得进展。这正在发生,而且将会发生。认识到它将会发生并尝试成为其中的一部分,并不是傲慢的。

这就是我的出发点,我的底牌已经摆在桌面上了。在科学中,方法和哲学的混合很重要,一方面是你想要绝对确立和改进的科学内容,但同时你也必须有策略和方法,这对于我今天想要谈论的内容非常相关。

我今天要谈论的,我称之为《去中心化的神经网络》,这只是一个我正在发展的想法。所以这不是一个我会向你们展示最终产品的东西。我会向你们展示一些想法,并且我会提出一些硬性的结果,这些结果至少为这些想法提供了动机。

我想从我的结论开始。过去,所谓的分布式人工智能或者说去中心化人工智能,我们更倾向于将其视作是一群像运行网络或为某种大型活动做出贡献的 Agents。我走的是另一条路,我会将其看作一个单一的心智、一个单一的大脑,将其视为分布式的,它由许多本身就是目标寻求系统的组件组成,它们本身就是有目标的 Agents。

我要说的是,这些 Agents 就是人工神经网络中的神经元。

1

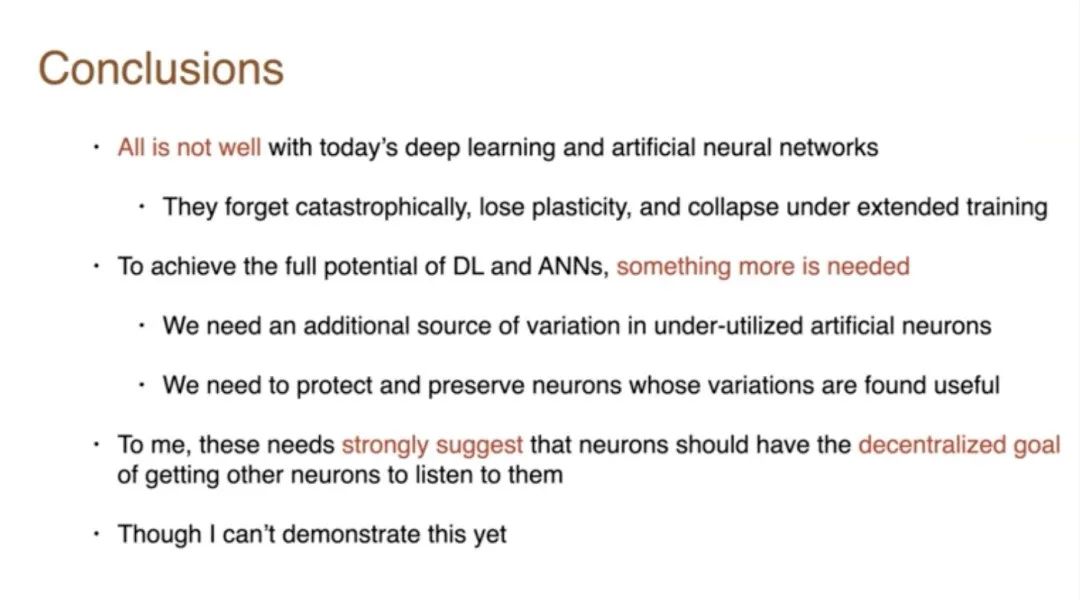

DL & ANNs——All is not well

所以我想从我的结论开始。今天的深度学习和人工神经网络并不是一切都很好。它们会灾难性地忘记,失去可塑性,实际上会在延长训练的条件下崩溃。

这些问题很多都与延长训练有关,而我们通常不会在深度学习中遇到这些问题,因为我们通常不会进行延长训练。我们只是训练一会儿然后就停止并冻结系统。

但如果真的想要制造一个能够度过一生的 Agent,它就必须持续学习。强化学习、Agent都想要持续学习。因此,它们能够应对持续的、延长的训练或学习是非常重要的。

为了实现全部潜力,需要更多的东西。我会为此提供证据,我们需要网络中未充分利用的人工神经元的额外变异源。所以网络必须尝试不同的事情。然后我们需要保护和保留那些变异有用的神经元。这是一种生成性测试。其核心目标就是你尝试各种事物,保留好的那些。

现在,对我来说,这些需求强烈表明神经元应该有让其他神经元倾听的去中心化目标。现在,这对我来说是一个强烈的建议,这是我正在思考的事情,我不能证明,我会尝试和你讨论这个想法,我会证明深度学习的局限性、弱点,并向你展示一些技术,让它们更好地工作。但这种去中心化的想法只是我将要向你提出的一个想法,我目前还无法真正证明它。

今天我将讨论网络中的神经元这个概念。这些神经元自身有目标,它们想要连接其他神经元,它们想要为整个网络做出贡献。我将展示一些关于传统深度学习的新的证据问题。这是我们几个月前在《Nature》杂志上发表的证据,我们展示了深度学习在持续监督学习中会失去可塑性。

其次,我们已经展示了深度学习在长时间的强化学习中可能会崩溃。这些问题已经得到了解决。我们通过引入变异和选择性生存来解决它们,也就是尝试一系列事物并保留好的那些。因此,我认为这是去中心化目标的基础,这些 Agent 将尝试为网络做出贡献。我认为用这些术语来思考将会是有用的。

我将展示的第二件事,是来自阿尔伯塔大学的一些新工作,他们开发了这些在线流算法用于强化学习,这一直是我们在深度学习中无法与之竞争的流算法。流算法意味着数据流经它们,它们不保存任何数据,每个数据有一个固定的计算量,你不需要保存任何东西,所以你可以在事情发生时完全处理它们,然后丢弃它们。这是自然的学习方式。

首先,我应该定义一下我所说的去中心化神经网络是什么意思。它是一个其神经元追求的目标与整个网络的目标不同的网络。去中心化意味着没有中央控制器。有多个 Agent 在执行任务,但作为一个整体,我们希望最终能形成一个强大的智能网络。

例如,整个网络可能寻求最大化其强化学习系统的奖励,或者它可能寻求按照训练集的指示对图像进行分类以监督学习系统。但单个神经元可能有其他目标,比如它们可能想要提供网络中其他神经元发现有用的信号。这是一个局部目标,或者是它们可能想要自我规范化,并且在一定时间分数内保持活跃。这是它们独立于网络整体目标的局部目标的衡量。所以,去中心化神经网络的说法是一个由追求目标的组成部分构成的目标寻求系统。

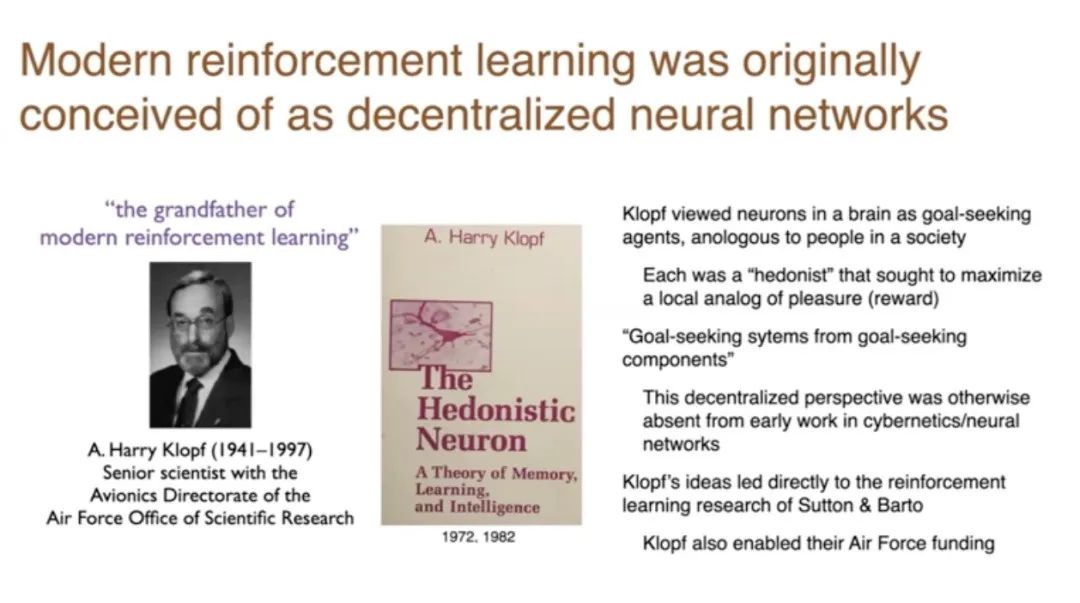

现代强化学习最初被构想为一个去中心化的神经网络。所以,如果 Andy Bartow 和我可能是现代强化学习之父,那么 A. Harry Klopf 就是祖父,因为他是让我们开始这一切工作的人。他写了《The Hedonistic Neuron》这本书,提出单个神经元。他将单个神经元视为寻求目标的实体,寻求事物和避免事物。大脑中的神经元类似于社会中的人。每个人都是享乐主义者。

他实际上认为新的通常的神经元试图获得兴奋并避免被抑制。他非常注重这个短语,即从寻求目标的组件中寻求目标的系统。而Andy Barton和我在1980年左右在马萨诸塞大学工作时研究了它。

Klopf 的科学贡献是认识到这种去中心化的观点,或者只是思考想要东西的代理,这对我们今天来说并不明显。当时,它在所有工程学、所有控制论、所有神经网络中都是不存在的。没有代理想要某物的概念。它已经变成了监督学习,即他们不想要某物,他们只是做他们被告知的事情。他们不试图改变世界,他们试图匹配世界正在做的事情。而 Klopf 认识到了这一点,并在资助了 Andy Barton 和我在马萨诸塞大学的工作。所以他真的是现代强化学习的祖父。

实际上强化学习像山一样古老。Marvin Minsky 在他的博士论文中做了关于强化学习的研究,但他后来它变得不流行了,因为他们并不真正接受代理寻求事物的想法。他们认为它变成了监督学习。

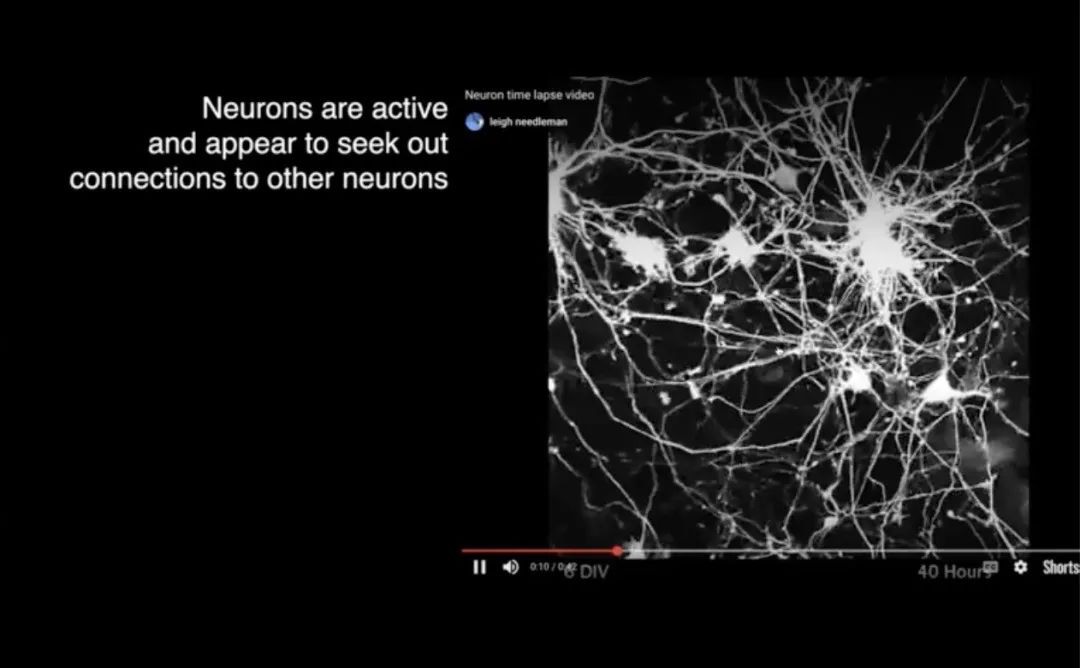

这些是一些真实神经元的时间延迟摄影,它们在培养中,但重点是这些神经元正在伸出纤维。它们的树突和轴突末端有生长锥,不这样想是很难的:这些神经元试图做一些事情。

它们试图找到其他单元连接,其他神经元连接,并参与网络。所以,这是鼓舞人心的,但我们可能会想象我们的神经元以这种方式工作,就像 Harry Klopf 所做的那样。

所以,我认为一个去中心化的神经网络应该在三个层面上进行适应。它应该适应连接线,正如我们刚刚看到的,神经元伸出连接线与其他神经元形成连接;然后我们还要适应权重;第三,虽然不那么明显,我们要适应步长参数,这些参数决定了学习的速度,有时它们被称为学习率参数,但最好称之为步长参数。我相信,这对于神经网络的未来来说是一个非常重要的理念,所以我们将会讨论它。

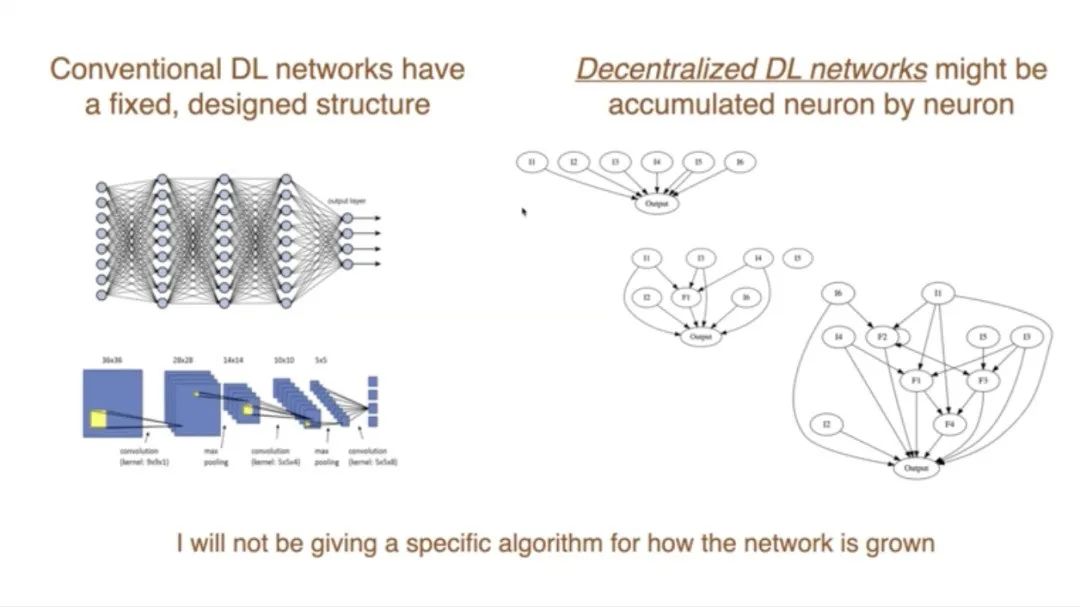

现在,如果我们想改变结构,首先就注意到传统的深度学习,它们有一个非常固定的预设计结构,通常是分层的,并且这些层有特殊的功能。另一种做法是让网络自然生长,所以你可能会从一个输出单元和几个传感器、输入开始,然后随着你添加新的特征,你会得到一个更复杂的网络。在这个过程中,你会一点一点地积累神经元,变得更加复杂、更有能力。

所以我认为,如果这是一个去中心化的网络,并且试图为网络做出贡献,这将是一种更自然的方式。一旦为网络做出了贡献,你就成为了网络的一部分。在那之前,你只是在探索并尝试做一些有助于贡献的事情。

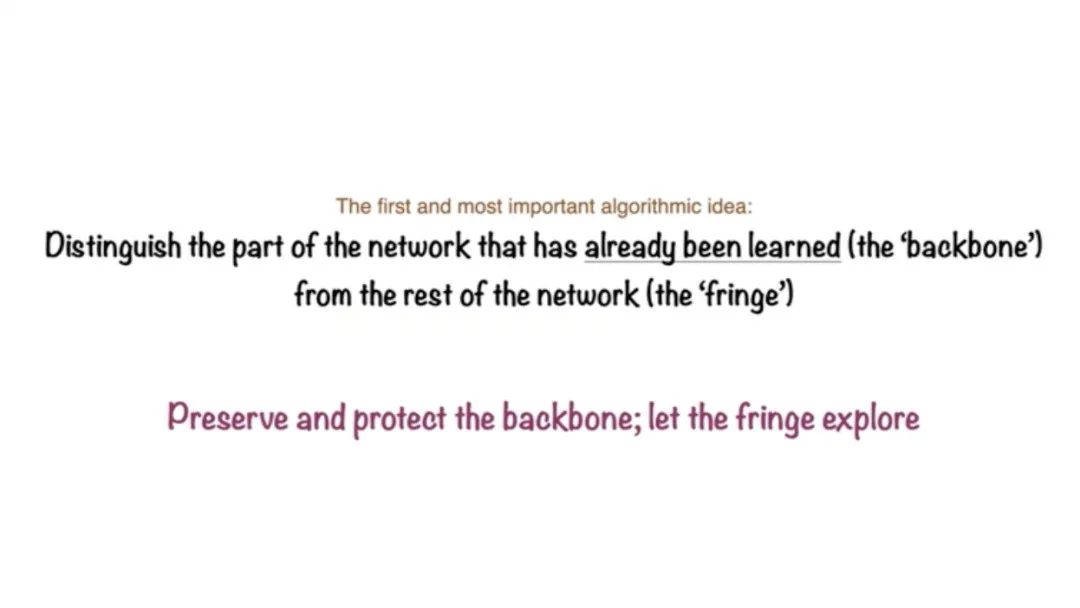

第一个观点是我们区分网络中已经学习过的部分,我将这部分称为骨干网络。你确定了权重是非零的,特别是它们通过网络连接并影响网络的输出。现在确实在现代神经网络中,许多神经元根本不是这样的,它们对网络的输出没有贡献。所以,我们中的一些人会称它们为死亡的,我不想让你认为它们是死亡的,所以我将给它们一个不同的名字,将称它们为边缘部分。

骨干网络是我们目前正在使用的,我们学到的知识,而边缘部分是我认为它们在边缘嗡嗡作响并试图形成一些对网络有用的功能,一些信号,然后网络将选择性地倾听。所以本质是我们要保护和维护骨干网络。在边缘部分,我们希望它更具探索性。这实际上几乎与常规反向传播所做的相反。如果你想反向传播,如果你影响了输出,那些线性概率反向传播会改变。通过梯度下降,你将改变那些已经影响输出的,而那就是误差。而那些不影响任何东西的,你根本不会改变它们,因为它们的梯度将为零。

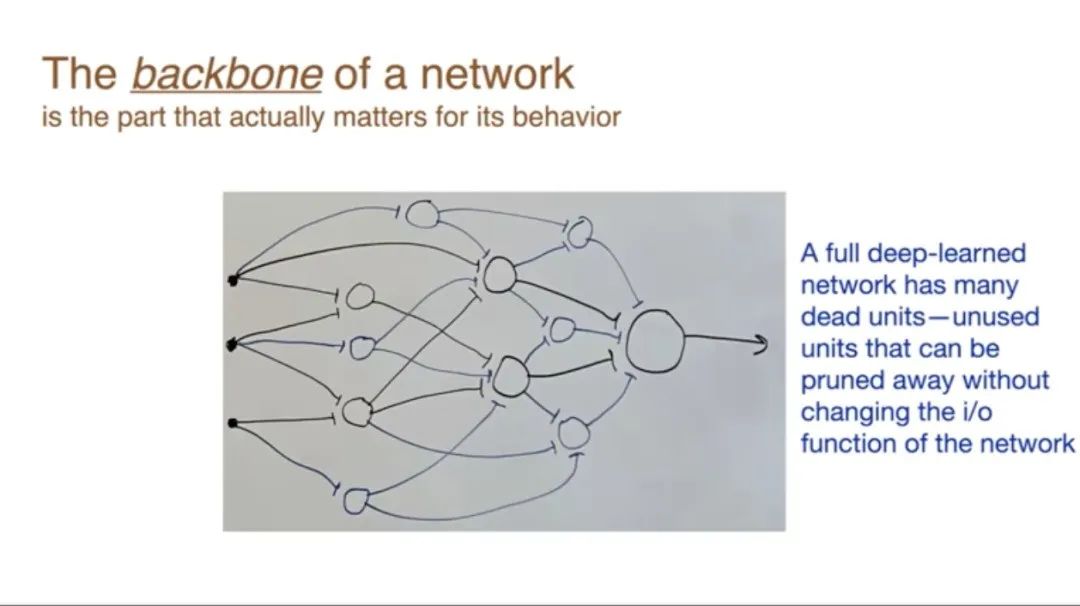

为了更直观地说明这一点,我做了这张图。这里有一个神经网络,经过完全学习后,它们都有很多死亡单元。所以这里的黑色代表骨干网络,蓝色代表边缘部分。我们可以简单地修剪掉边缘部分,只保留骨干网络。这就是骨干网络和边缘部分的概念。

现在,我们需要新的算法,我们需要学习骨干网络,我们需要在边缘部分进行学习。在骨干网络内部学习,或许我们可以直接使用反向传播、梯度下降。在边缘部分学习,我们需要一些新的想法,让这些单元试图被倾听。以及需要注意一个问题,即如何找到骨干网络?

有个基本的理念是,一个单元控制其传入权重,不控制其传出权重。每个神经元都有传入权重和传出权重,每个传出权重都是另一个神经元的传入权重。对这些分布式 Agent 分配责任,我们分配每个 Agent 控制其传入权重。

这是梯度,这个关于权重值的平方误差的小偏导数,从神经元i到神经元j的权重,我以前称它们为单元。今天我决定称它们为神经元,无论我们谈论的是人工神经元还是真实神经元,从现在开始都是人工的。

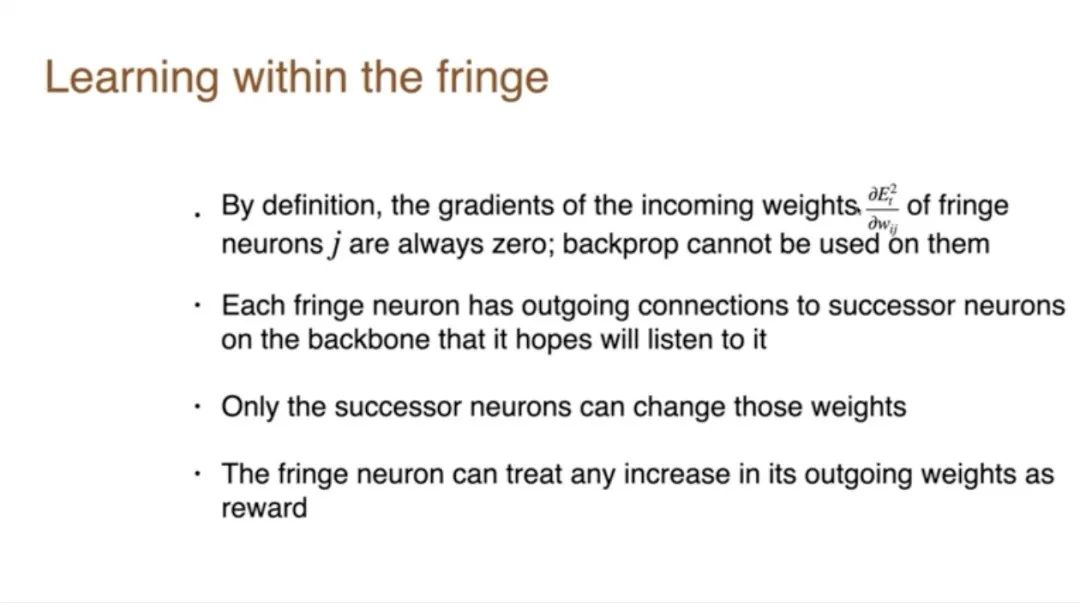

所以,如果你是在边缘部分,根据定义就不会影响误差,所以这个梯度总是零。在反向传播中,根据这个梯度,偏导数来改变权重。因此,反向传播不能用来学习这些权重,因为根据定义,导数总是零,你永远不会改变那些权重。所以这就像是一个陷阱。如果你陷入一个陷阱,如果你最终处于边缘部分,梯度下降将永远不会再改变你的权重。所以这就是为什么,我们要求它们继续学习。我的观点是,边缘部分必须是更具探索性的、更活跃的、更自由地改变自己。

是的,我们可以为边缘单元、边缘神经元改变其传入连接,希望下游的某个神经元选择听取我们提供的信息,因此,如果一个下游神经元在骨干网络之外听取意见,这对我们没有好处,仍然是无用的、不影响骨干网络。所以我们对连接到骨干网络感兴趣,我们想提供一些东西,那些骨干网络会决定我们不能直接控制那些。

现在我们想使用社会隐喻,就像我们都是人,我们都会对人们是否忽视我们或对他们是否对我们所说的感兴趣非常敏感。

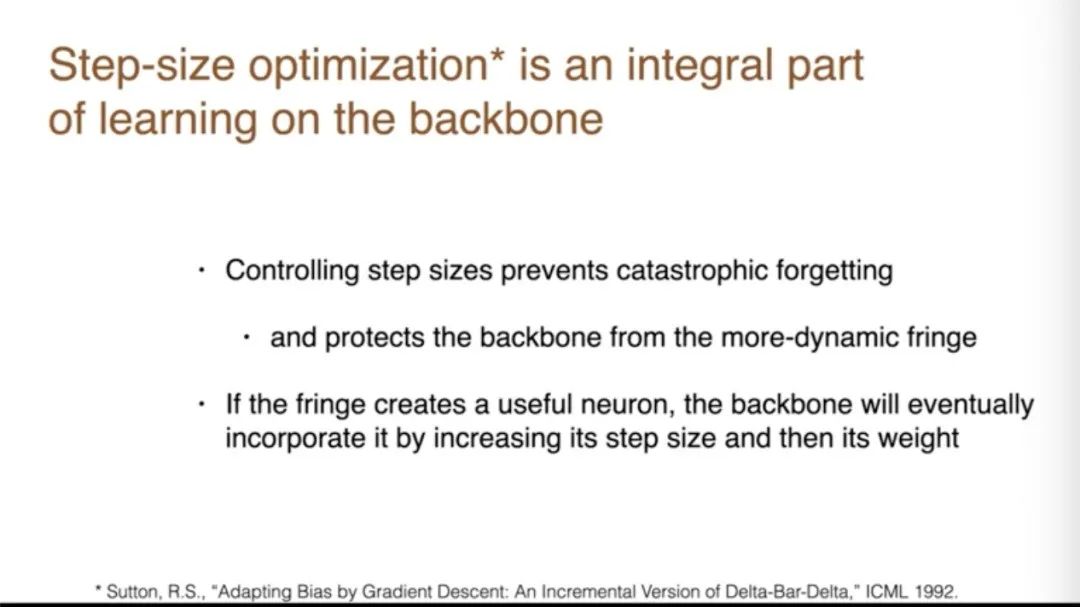

让我们对这个总体概念再做一些补充。我们已经提到了步长优化,设置步长。这是在骨干网络上学习的一个不可或缺的部分,因为我们想要保护骨干网络,这意味着如果骨干网络正在做一些有用的事情,我们必须使其步长变小,以便它们不会被改变。我们不希望骨干网络快速变化,而反向传播通常会倾向于改变骨干网络。我们必须抵消这一点。

所以如果一个边缘单元确实创造了一个有用的东西,它与骨干网络的连接通常需要两个步骤。首先,骨干网络对这个新神经元相当怀疑,先给它一个较小的步长,所以即使它在做好事,权重也会保持很小。但如果发现它真的在做好事,它的步长最终会增加,然后权重会增加。就是这样才能与骨干网络连接。

以上所有这些都是我的第一个观点。

2

在未充分利用的人工神经元中增加额外变化源

为了实现深度学习(DL)和人工神经网络(ANNs)的全部潜力,需要更多的东西。我们需要在未充分利用的人工神经元中增加额外的变化源。我们需要保护和保留那些被认为有用的、变化的神经元。

第二部分,我想谈谈传统深度学习存在问题的证据,因为这正是推动新事物需求的动力。

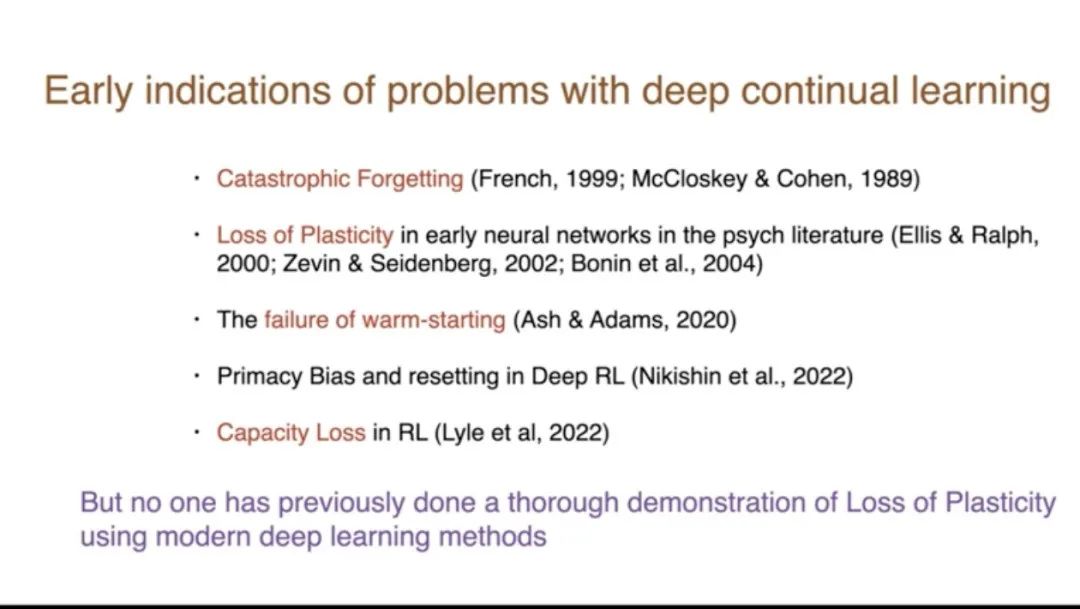

这个新证据是什么?这是我提到的《Nature》杂志上的文章。而且,我们并不是第一个发现深度持续学习问题的人,上个世纪 90 年代就有灾难性遗忘的问题,早期的研究也显示了容量丢失。Ashton Adams 展示了部分学习然后学习更多的失败。还有其他一些研究很多都在强化学习领域,但没有人真正使用现代方法系统地、彻底地展示持续学习中可塑性丧失的问题。所以我们在这篇《Nature》杂志的文章中做了这样的研究。

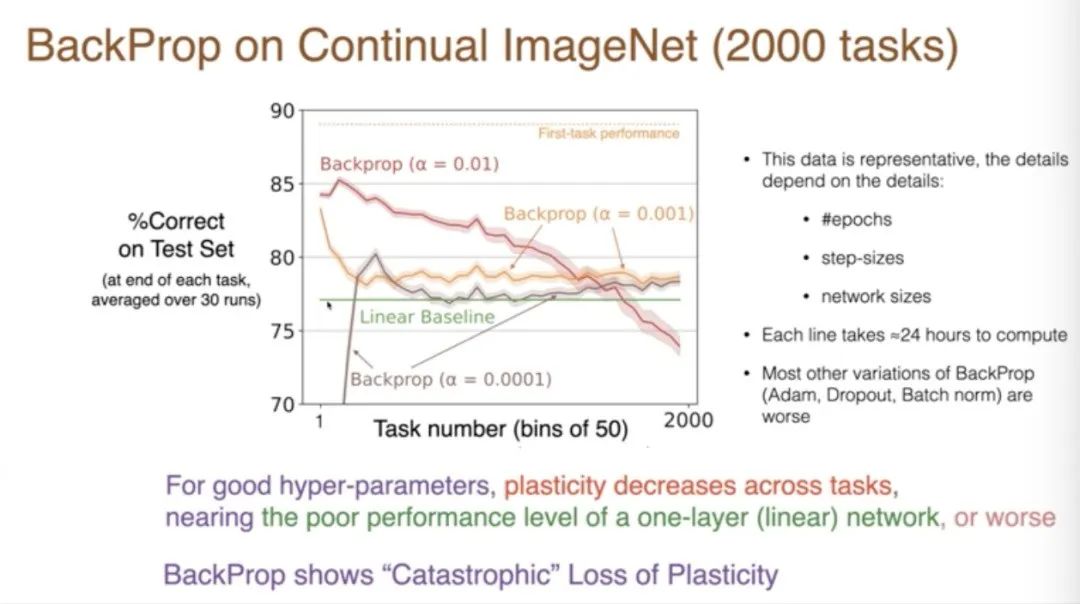

第一点是深度学习在持续的监督学习中失去了可塑性。我们首先在 ImageNet 上展示了这一点,这是一个经典的监督学习问题,这个数据库包含了数百万张名词类别的图片,有一千个类别,每个类别有700张或更多的图片,它被广泛使用。

深度学习至今仍在使用,我们必须适应它,使其能够持续学习。我想做的是持续学习,这将在强化学习和人工智能中非常有用,是基于人工智能的强化学习。

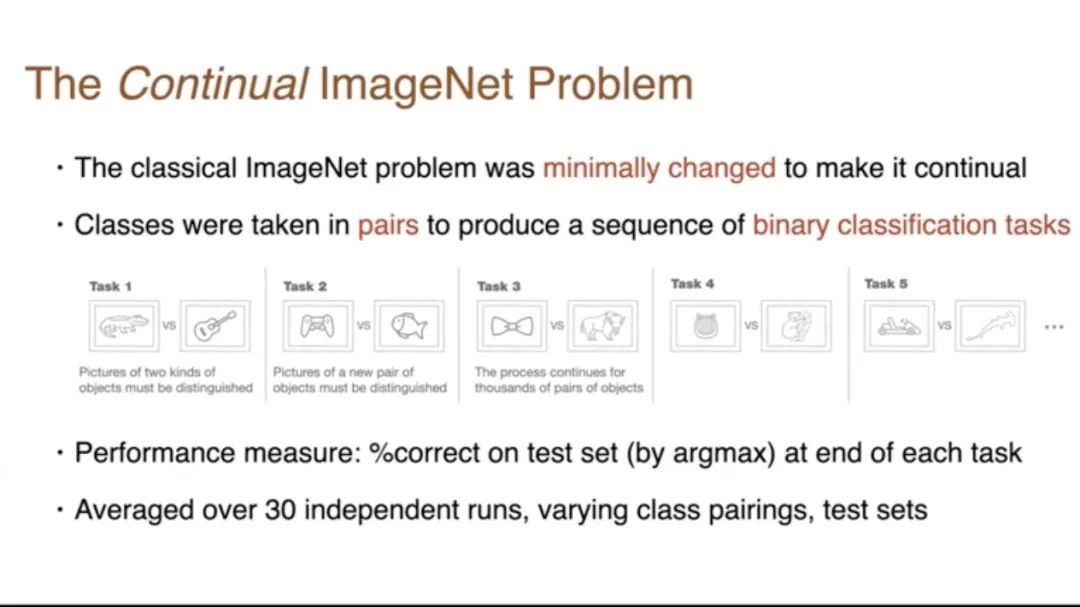

所以我们不得不改变它,我们试图尽可能少地改变它,使其成为一个持续学习的问题。所以我们做的,实际上是这些图片中展示的,这里我们拿了两个类别,我们要求网络区分鳄鱼和吉他,然后当区分差不多完成时,我们继续说「现在忘记它,想要你区分另外两个东西」。

这个过程会一直持续,有一千个类别,你可能会想你可以做500对,但实际上你可以做更多,因为你可以在不同的对中重用单个类别。所以你可以得到任意数量的二元分类任务,你可以看到你在第一个任务上做得有多好?

如何衡量你做得有多好?我们将通过测试集和训练集来衡量,测量测试集中正确百分比,然后将其在多次运行中平均,改变测试集中的配对,以获得系统的结果。在提出问题之前,我必须谈一个实验。

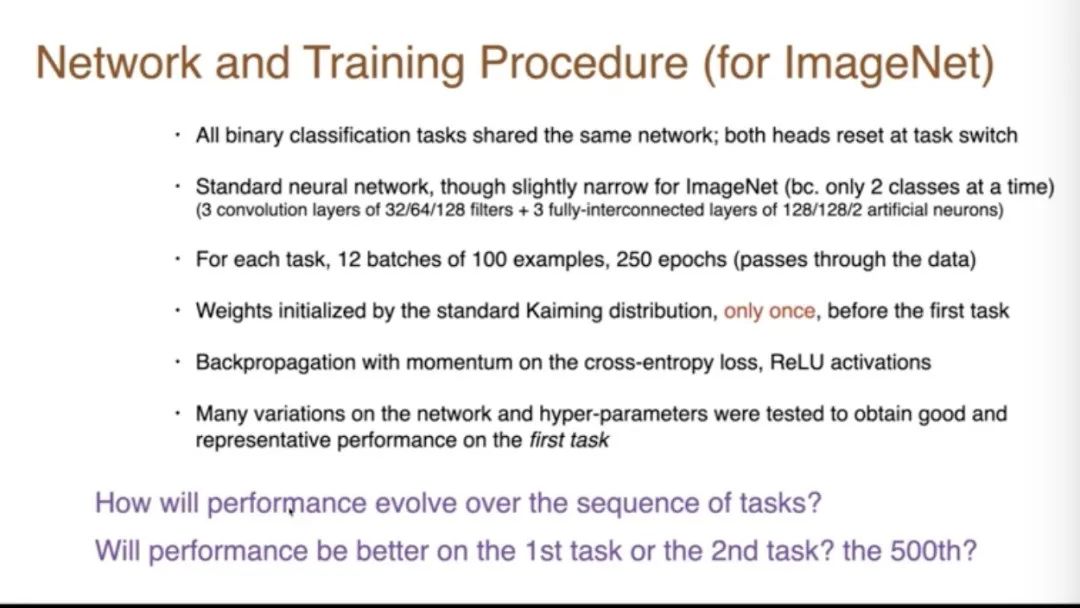

这些是重要的是细节。我们在任何给定时间点,只会要求它对一对名词进行分类。我们只在开始时用第一对名词初始化网络一次。然后我们使用的是我们能想到的最标准的方法,实际上我们尝试了大量的不同方法,我会向你们展示代表性的结果。

问题是,性能将如何随着任务序列演变?它会在第一个任务上更好还是在第二个任务上更好?你在分类第一对名词时会得到更高的百分比,还是当你继续到第二对时,你会做得更好或更差。你可能会做得更好的原因是什么?

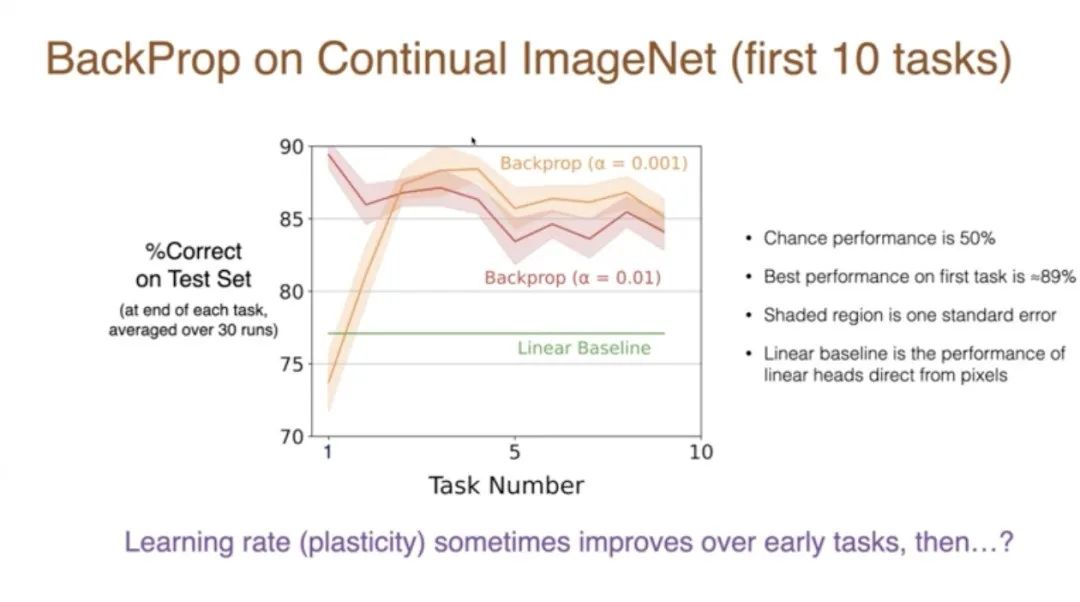

一旦你到了第500对,第500对应该和第499对非常相似。但由于你知道这部分讨论的是可塑性的丧失,也许你预计实际上事情会随着时间的推移变得更糟。所以这是在前10个任务中发生的情况,当然,结果取决于参数。

让我们看看这些结果。在测试集上,如果步长是100,我们得到了大约89%的正确率。如果步长更小,我们会慢一些。我们最初做得没那么好,但实际上对于较小的步长,有更多的节省,我们确实在第二个任务、第三个任务、第四个任务上显示了改进。那么未来会发生什么?我们得出什么结论?学习率、可塑性在早期任务中有时是在提高的,但在长期内不清楚会发生什么变化。

这些红线和橙线之间只是数字略有不同,因为我们是在整个50个任务上进行分组。第一个数据点是前50个任务的平均值,但是有一个明显的趋势。首先,更好的步长是它一直在下降,到了第2000个任务时表现相当差,而且这种差的程度,与绿线相比,绿线是一个线性基线,基本上没有任何深度学习,它直接从像素到类别。这就是我们在常规背景下看到的。

在某些情况下,会退化得比线性还差,在其他情况下,与线性相似。所以这基本上是随着时间的推移,学习能力的可怕丧失。给你一个新的任务,你根本无法处理任何任务,甚至无法比线性网络处理得更好。这项研究投入了大量的计算,大多数变体都更糟,我们做了所有变体,是一个庞大的数量。

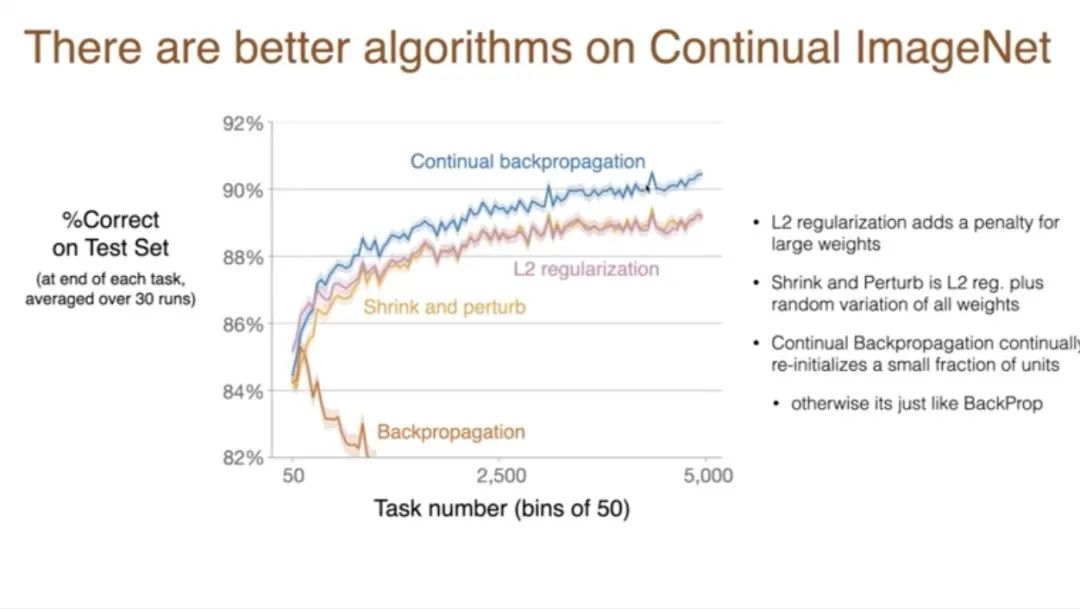

现在你可以有更好的算法。所以这条线和之前一样,只是比例尺有点不同。之前我们第一个类别的准确率能达到89%,现在有了这些其他的改进,我们在任务上取得了进步,不是可塑性的丧失,而是随着时间的推移学习能力的提高。然后这种改进在很多任务中持续进行,超过5000个任务。所以这些算法中,L2是一种简单的正则化,而在简单的情况下,这实际上可以是一个显著的改进。

L2正则化意味着我们对大权重进行惩罚。Shrink 和 Perturb 涉及到 L2 正则化,但也在权重中加入了随机变化。我们发现在某些情况下,这可以有积极的效果,尽管在这个案例中不是很多,但在其他案例中是这样的。

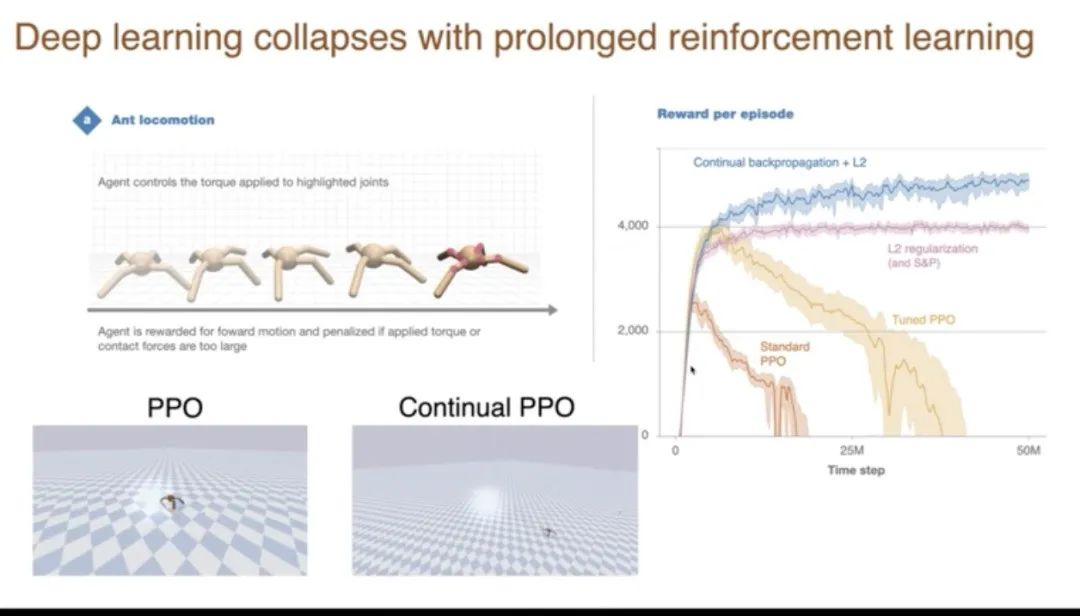

我想展示另一个结果,这是长期强化学习中深度学习的崩溃。这里的任务是这只蚂蚁,尽管它只有四条腿,我们控制八个关节。我们试图让它行走时看起来像这样。看到底部的蚂蚁正以相当快的速度向前移动。它因为向前移动而得到奖励,因为向后滑动而受到惩罚。

这是在数百万个时间步长中的表现结果。在y轴上展示的是在一个情节中获得的总奖励,情节是它向前跑动的一段时间。然后在情节结束时重置。所以基本上,当我们有相当快的前进速度时,这个数字就会上升。一个标准的算法,PPO是一个强化学习算法。如果我们直接使用它,我们得到的是这样的行为、它学得非常好,变化很高。但是,如果我们继续训练,它就完全停止快速行走了,它只是笨拙地移动。同一个网络曾经能够做得非常好,但现在它不能持续做好。实际上,它退化了,甚至跌到零以下,因为某些类型的跌倒会有惩罚。

如果调整权重,我们可以得到更长时间的更好表现。但如果我们继续进行更长时间的训练,同样的事情也会发生。你可能会问,这不是一个大问题吗?为什么人们以前不知道呢?答案是,人们有时确实看到了,但他们通常不会运行那么久。他们运行直到它运行得相当好,然后他们就停止了。如果你在这里结束这个实验,它看起来就像它运行得非常好。只有当你坚持,我写了没有数百万的更多时间步长,但你会看到它退化了。

注意其他线条,LT正则化没有退化,它是平线,而持续反向传播可能随着时间的推移做得稍微好一点。那么持续反向传播是什么?这个短语是随机梯度下降,反向传播,但有选择性地重新初始化。反向传播涉及在时间开始时的初始化,在所有单元中制作小的随机权重,在持续反向传播中,我们将继续在单元中设置小的随机权重、重新初始化。

实际上,重新初始化和初始化算法是一样的。但重新初始化将是选择性的。我们不会对骨干网络上的单元进行重新初始化。我们将对未使用的单元进行重新初始化。因此,我们将根据它们的效用对神经元进行排名,然后只重新初始化那些最不有用的几个。

3

赋予每个神经元独立目标

这是效用更新的方程。所以这是单元、神经元i的效用,新的一个是Eta,Eta是一个像0.9这样的参数。所以我们淡化旧的效用,加入这个数量。基本上效用变成了这个数量的平均值或平均值。这个数量是神经元活动的绝对值。所以你只有活动才有高效用,而且你的传出权重必须在绝对值上很大。那是从你的单元i到单元K的所有K的权重,你拥有权重的,如果我们有大的传出权重,所以这些是传出权重,绝对值大的传出权重在某些时候你的活动是衡量你对网络影响程度的一个指标。当然,这没有考虑到接收神经元的效用。也许这不是效用完美的概念,但这是我们使用的,这足以获得那些好的结果,这是一个需要进一步实验的领域。

所以一种方式是,神经元重新初始化,直到其他神经元从它们那里觉醒。它们寻求关注,它们寻求贡献,它们寻求让别人听它们的,发现它们有用。

为什么这种失败会发生?很大程度上是我多次提到的,神经元变得死亡,它们退出了骨干网络,然后它们被困在骨干网络之外,无法贡献。

所以这个图表显示的是——这是在蚂蚁运动的强化学习任务上。随着时间的推移,我们测量活跃时间少于1%的单元数量。所以这些是应该活跃的休眠单元,但它们只是普通的反向传播中的休眠单元。值得注意的是,在持续反向传播中,它们再次变得活跃。那些休眠的单元被选中进行重新初始化。所以它们再次获得了变化。

但在反向传播中,有这些休眠单元是不好的,因为它们没有贡献。所以在这里,超过一半的单元最终变得休眠,而持续反向传播和正则化,这两种方法阻止了大量单元变得休眠。当神经元要为自己的运作负责时,它们自然会注意到自己已经休眠,然后在某种意义上重新唤醒自己。所以采取这种去中心化的视角将解决这个问题,就像持续反向传播至少部分解决了这个问题一样。

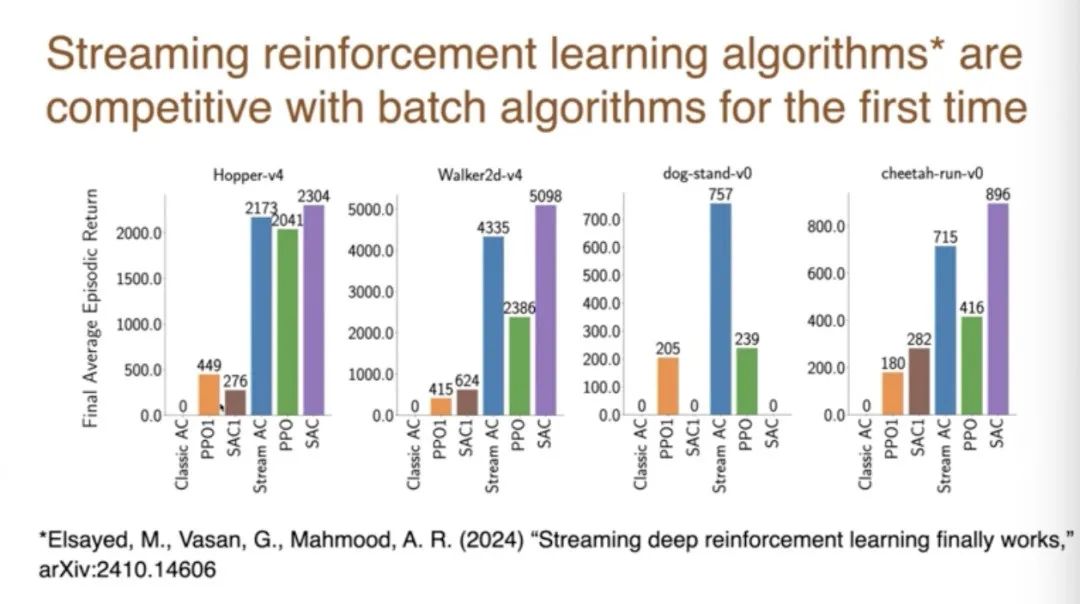

以上我的主要观点。另外,我的同事们在阿尔伯塔大学进行的另一项新工作,是关于流算法的研究。图片中的蓝线,这是在各种标准深度强化学习任务上的性能数字,Mujoko和其他一些东西。所以每一个蓝线代表一个问题,性能通过条形图显示,蓝线是新算法的性能。蓝线左边的这些东西,这些是经典的强化学习算法,非深度算法,你会在强化学习的教科书中找到的流算法。

与这个流设置中的其他算法相比,这些算法表现得不太好,所以这被称为流障碍。问题在于,如果我们采用自然的强化算法,它们在流式在线设置中表现得不太好。新的结果是,蓝线与右边的算法竞争,这些是基于回放的深度学习方法,保存了很多东西。所以现在我们可以进行流式深度强化学习,它奏效了。我认为这是一个非常重要的结果。并不是说它总是比一切都好,或者完全竞争,这取决于细节。但这是流方法性能的显著提升,由 Muhammad 和他的一些同事完成的。

我之所以会提到这项工作,是因为我认为它和刚才讲的内容特别相关,它也采取了一种去中心化的视角。所以我也将它视为支持去中心化神经网络论点的一部分。

以上大致是我想讲的内容。我的结论是,今天的深度学习方法并不完善,我们需要更多的东西。它们在所有这些方面都失败了,我们今天已经展示了其中的一些,所以为了实现全部潜力,我们需要更多的东西。基于持续的背景,需要尝试各种方法,然后我们需要保留好的那些,就是拥有一个去中心化网络的想法。虽然这个联系还有点弱,但它强烈建议我们应该看看这些基于去中心化的算法,以及神经元的目标是让其他神经元听它们的,尽管我还不能证明这一点。

DAI2024 共分为五大主题、七个session,内容涉及多智能体系统、强化学习、深度学习、博弈论、AI Agents 和 LLM 推理等多个领域,展示了来自 NeurIPS、ICLR、ICML、AAAI、AAMAS、CoRL 等顶级会议期刊的高质量学术成果。此外,大会还组织了多个学术沙龙,深入探讨具身智能、博弈论、开放环境中的多智能体强化学习以及大语言模型驱动的代码智能体等前沿热点话题。AI 科技评论将持续关注。

阅读报告全文,请访问欧米伽研究所的“未来知识库”

https://wx.zsxq.com/group/454854145828

未来知识库是“欧米伽未来研究所”建立的在线知识库平台,收藏的资料范围包括人工智能、脑科学、互联网、超级智能,数智大脑、能源、军事、经济、人类风险等等领域的前沿进展与未来趋势。目前拥有超过8000篇重要资料。每周更新不少于100篇世界范围最新研究资料。欢迎扫描二维码或访问https://wx.zsxq.com/group/454854145828 进入。

截止到12月25日 ”未来知识库”精选的100部前沿科技趋势报告

2024 美国众议院人工智能报告:指导原则、前瞻性建议和政策提案

未来今日研究所:2024 技术趋势报告 - 移动性,机器人与无人机篇

Deepmind:AI 加速科学创新发现的黄金时代报告

Continental 大陆集团:2024 未来出行趋势调研报告

埃森哲:未来生活趋势 2025

国际原子能机构 2024 聚变关键要素报告 - 聚变能发展的共同愿景

哈尔滨工业大学:2024 具身大模型关键技术与应用报告

爱思唯尔(Elsevier):洞察 2024:科研人员对人工智能的态度报告

李飞飞、谢赛宁新作「空间智能」 等探索多模态大模型性能

欧洲议会:2024 欧盟人工智能伦理指南:背景和实施

通往人工超智能的道路:超级对齐的全面综述

清华大学:理解世界还是预测未来?世界模型综合综述

Transformer 发明人最新论文:利用基础模型自动搜索人工生命

兰德公司:新兴技术监督框架发展的现状和未来趋势的技术监督报告

麦肯锡全球研究院:2024 年全球前沿动态(数据)图表呈现

兰德公司:新兴技术领域的全球态势综述

前瞻:2025 年人形机器人产业发展蓝皮书 - 人形机器人量产及商业化关键挑战

美国国家标准技术研究院(NIST):2024 年度美国制造业统计数据报告(英文版)

罗戈研究:2024 决策智能:值得关注的决策革命研究报告

美国航空航天专家委员会:2024 十字路口的 NASA 研究报告

中国电子技术标准化研究院 2024 扩展现实 XR 产业和标准化研究报告

GenAI 引领全球科技变革关注 AI 应用的持续探索

国家低空经济融创中心中国上市及新三板挂牌公司低空经济发展报告

2025 年计算机行业年度策略从 Infra 到 AgentAI 创新的无尽前沿

多模态可解释人工智能综述:过去、现在与未来

【斯坦福博士论文】探索自监督学习中对比学习的理论基础

《机器智能体的混合认知模型》最新 128 页

Open AI 管理 AI 智能体的实践

未来生命研究院 FLI2024 年 AI 安全指数报告 英文版

兰德公司 2024 人工智能项目失败的五大根本原因及其成功之道 - 避免 AI 的反模式 英文版

Linux 基金会 2024 去中心化与人工智能报告 英文版

脑机接口报告脑机接口机器人中的人机交换

联合国贸发会议 2024 年全球科技创新合作促发展研究报告 英文版

Linux 基金会 2024 年世界开源大会报告塑造人工智能安全和数字公共产品合作的未来 英文版

Gartner2025 年重要战略技术趋势报告 英文版

Fastdata 极数 2024 全球人工智能简史

中电科:低空航行系统白皮书,拥抱低空经济

迈向科学发现的生成式人工智能研究报告:进展、机遇与挑战

哈佛博士论文:构建深度学习的理论基础:实证研究方法

Science 论文:面对 “镜像生物” 的风险

镜面细菌技术报告:可行性和风险

Neurocomputing 不受限制地超越人类智能的人工智能可能性

166 页 - 麦肯锡:中国与世界 - 理解变化中的经济联系(完整版)

未来生命研究所:《2024 人工智能安全指数报告》

德勤:2025 技术趋势报告 空间计算、人工智能、IT 升级。

2024 世界智能产业大脑演化趋势报告(12 月上)公开版

联邦学习中的成员推断攻击与防御:综述

兰德公司 2024 人工智能和机器学习在太空领域感知中的应用 - 基于两项人工智能案例英文版

Wavestone2024 年法国工业 4.0 晴雨表市场趋势与经验反馈 英文版

Salesforce2024 年制造业趋势报告 - 来自全球 800 多位行业决策者对运营和数字化转型的洞察 英文版

MicrosoftAzure2024 推动应用创新的九大 AI 趋势报告

DeepMind:Gemini,一个高性能多模态模型家族分析报告

模仿、探索和自我提升:慢思维推理系统的复现报告

自我发现:大型语言模型自我组成推理结构

2025 年 101 项将 (或不会) 塑造未来的技术趋势白皮书

《自然杂志》2024 年 10 大科学人物推荐报告

量子位智库:2024 年度 AI 十大趋势报告

华为:鸿蒙 2030 愿景白皮书(更新版)

电子行业专题报告:2025 年万物 AI 面临的十大待解难题 - 241209

中国信通院《人工智能发展报告(2024 年)》

美国安全与新兴技术中心:《追踪美国人工智能并购案》报告

Nature 研究报告:AI 革命的数据正在枯竭,研究人员该怎么办?

NeurIPS 2024 论文:智能体不够聪明怎么办?让它像学徒一样持续学习

LangChain 人工智能代理(AI agent)现状报告

普华永道:2024 半导体行业状况报告发展趋势与驱动因素

觅途咨询:2024 全球人形机器人企业画像与能力评估报告

美国化学会 (ACS):2024 年纳米材料领域新兴趋势与研发进展报告

GWEC:2024 年全球风能报告英文版

Chainalysis:2024 年加密货币地理报告加密货币采用的区域趋势分析

2024 光刻机产业竞争格局国产替代空间及产业链相关公司分析报告

世界经济论坛:智能时代,各国对未来制造业和供应链的准备程度

兰德:《保护人工智能模型权重:防止盗窃和滥用前沿模型》-128 页报告

经合组织 成年人是否具备在不断变化的世界中生存所需的技能 199 页报告

医学应用中的可解释人工智能:综述

复旦最新《智能体模拟社会》综述

《全球导航卫星系统(GNSS)软件定义无线电:历史、当前发展和标准化工作》最新综述

《基础研究,致命影响:军事人工智能研究资助》报告

欧洲科学的未来 - 100 亿地平线研究计划

Nature:欧盟正在形成一项科学大型计划

Nature 欧洲科学的未来

欧盟科学 —— 下一个 1000 亿欧元

欧盟向世界呼吁 加入我们价值 1000 亿欧元的研究计划

DARPA 主动社会工程防御计划(ASED)《防止删除信息和捕捉有害行为者(PIRANHA)》技术报告

兰德《人工智能和机器学习用于太空域感知》72 页报告

构建通用机器人生成范式:基础设施、扩展性与策略学习(CMU 博士论文)

世界贸易组织 2024 智能贸易报告 AI 和贸易活动如何双向塑造 英文版

人工智能行业应用建设发展参考架构

波士顿咨询 2024 年欧洲天使投资状况报告 英文版

2024 美国制造业计划战略规划

【新书】大规模语言模型的隐私与安全

人工智能行业海外市场寻找 2025 爆款 AI 应用 - 241204

美国环保署 EPA2024 年版汽车趋势报告英文版

经济学人智库 EIU2025 年行业展望报告 6 大行业的挑战机遇与发展趋势 英文版

华为 2024 迈向智能世界系列工业网络全连接研究报告

华为迈向智能世界白皮书 2024 - 计算

华为迈向智能世界白皮书 2024 - 全光网络

华为迈向智能世界白皮书 2024 - 数据通信

华为迈向智能世界白皮书 2024 - 无线网络

安全牛 AI 时代深度伪造和合成媒体的安全威胁与对策 2024 版

2024 人形机器人在工业领域发展机遇行业壁垒及国产替代空间分析报告

《2024 年 AI 现状分析报告》2-1-3 页.zip

万物智能演化理论,智能科学基础理论的新探索 - newv2

世界经济论坛 智能时代的食物和水系统研究报告

生成式 AI 时代的深伪媒体生成与检测:综述与展望

科尔尼 2024 年全球人工智能评估 AIA 报告追求更高层次的成熟度规模化和影响力英文版

计算机行业专题报告 AI 操作系统时代已至 - 241201

Nature 人工智能距离人类水平智能有多近?

Nature 开放的人工智能系统实际上是封闭的

斯坦福《统计学与信息论》讲义,668 页 pdf

国家信息中心华为城市一张网 2.0 研究报告 2024 年

国际清算银行 2024 生成式 AI 的崛起对美国劳动力市场的影响分析报告 渗透度替代效应及对不平等状况英文版

大模型如何判决?从生成到判决:大型语言模型作为裁判的机遇与挑战

毕马威 2024 年全球半导体行业展望报告

MR 行业专题报告 AIMR 空间计算定义新一代超级个人终端 - 241119

DeepMind 36 页 AI4Science 报告:全球实验室被「AI 科学家」指数级接管

《人工智能和机器学习对网络安全的影响》最新 273 页

2024 量子计算与人工智能无声的革命报告

未来今日研究所:2024 技术趋势报告 - 广义计算篇

科睿唯安中国科学院 2024 研究前沿热度指数报告

文本到图像合成:十年回顾

《以人为中心的大型语言模型(LLM)研究综述》

经合组织 2024 年数字经济展望报告加强连通性创新与信任第二版

波士顿咨询 2024 全球经济体 AI 成熟度矩阵报告 英文版

理解世界还是预测未来?世界模型的综合综述

GoogleCloudCSA2024AI 与安全状况调研报告 英文版

英国制造商组织 MakeUK2024 英国工业战略愿景报告从概念到实施

花旗银行 CitiGPS2024 自然环境可持续发展新前沿研究报告

国际可再生能源署 IRENA2024 年全球气候行动报告

Cell: 物理学和化学 、人工智能知识领域的融合

智次方 2025 中国 5G 产业全景图谱报告

上下滑动查看更多

5146

5146

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?