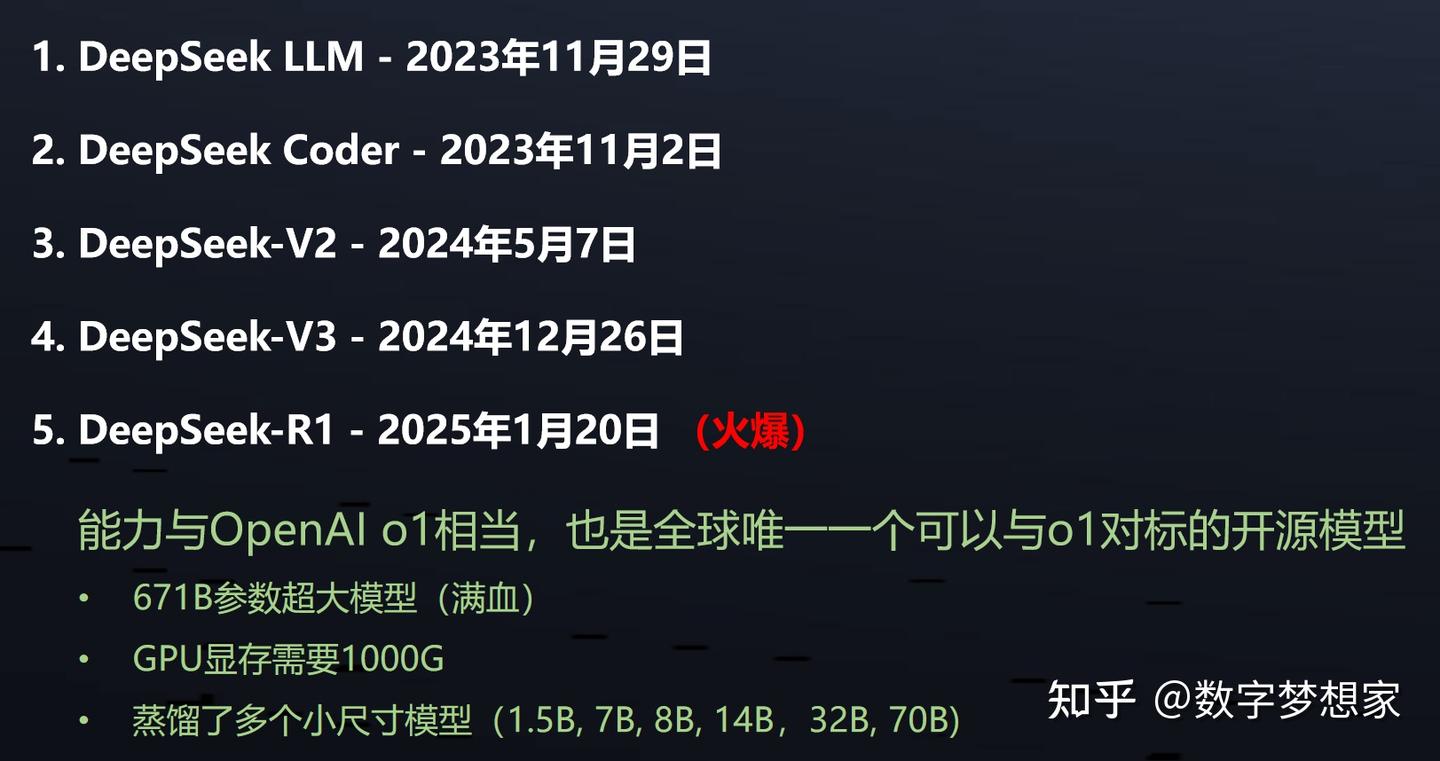

1、DeepSeek简介

最近火出圈的AI科技公司,不用多介绍了。

2、本地化部署步骤

网上已经有很多视频教程告诉大家如何部署了,过程其实非常简单,此处不再赘述了,只略作总结。另外,部署过程中最耗时的是资源和工具的下载。

总的来说,本地化部署DeepSeek R1,我总结了以下三个步骤,完成之后,你就可以愉快地与大模型聊天了,本地化部署之后的使用不依赖任何网络,零成本,用了都说好!

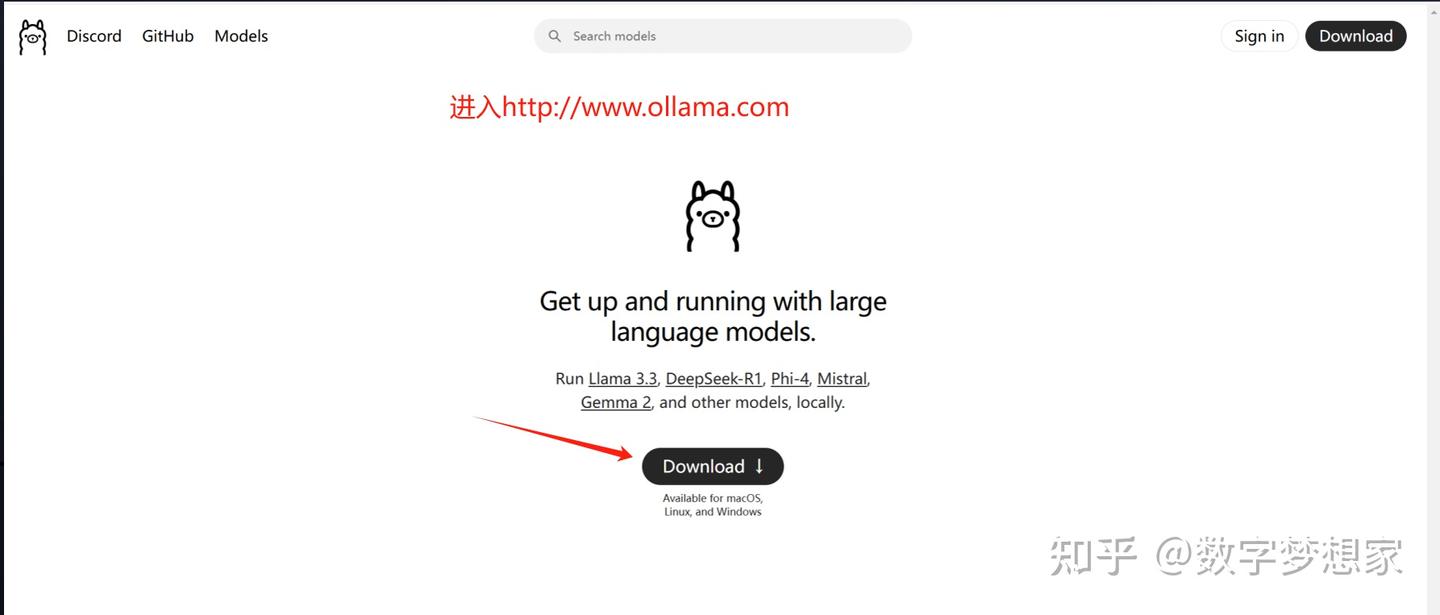

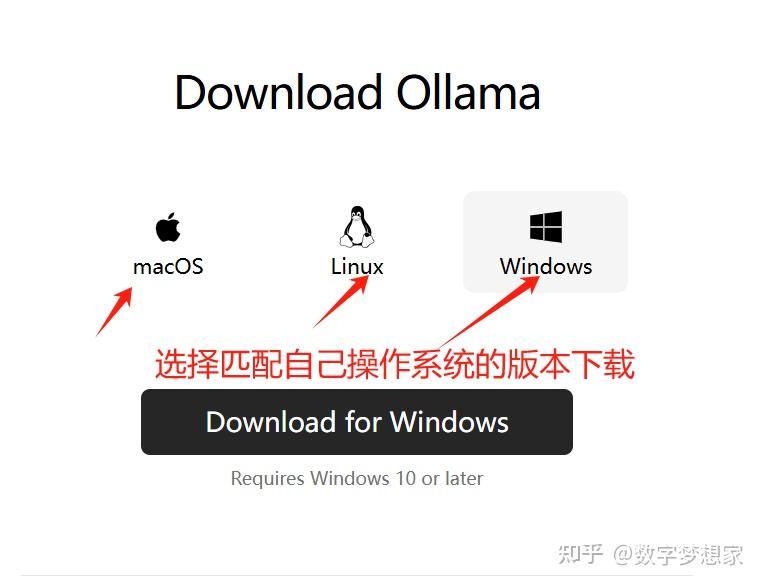

第一步:下载Ollama

进入Ollama网站,直接点击download即可(注意自己是windows还是mac还是Linux), 本教程以Windows为例,其余操作系统大同小异。

第二步:通过命令行下载R1模型

这一步也很简单,直接进入DeepSeek R1模型下载页面:deepseek-r1

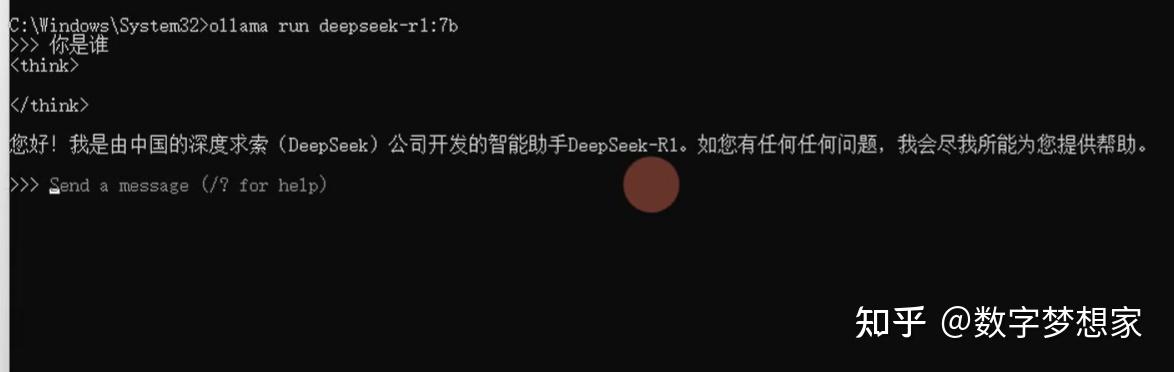

将复制的命令行,直接黏贴到命令行窗口按回车执行即可:

接下去就是一个较长时间的等待,等安装完毕就可以直接通过命令行与大模型交互了:

当然,这种交互方式还是不够人性化,所以接下去我们就需要安装一个客户端来连接本地大模型,并提供一个美观的交互UI,这样使用起来就方便多了。所以,我们接着做第三步:

第三步:安装可视化交互工具

现在比较流行的客户端有chatBox和Cherry Studio,此处推荐后者:

这个工具的安装没啥好说的,直接下一步点到底完成安装。

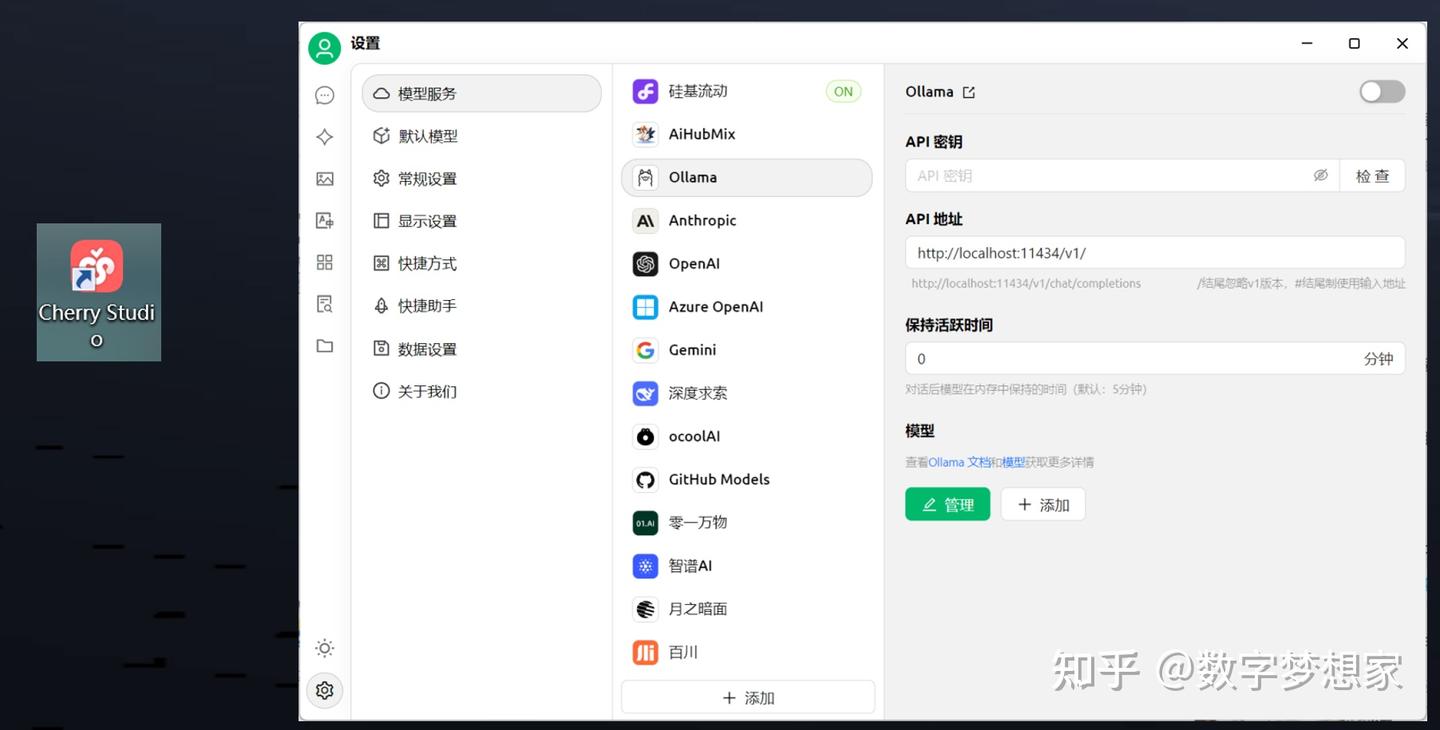

安装好之后,直接运行即可:

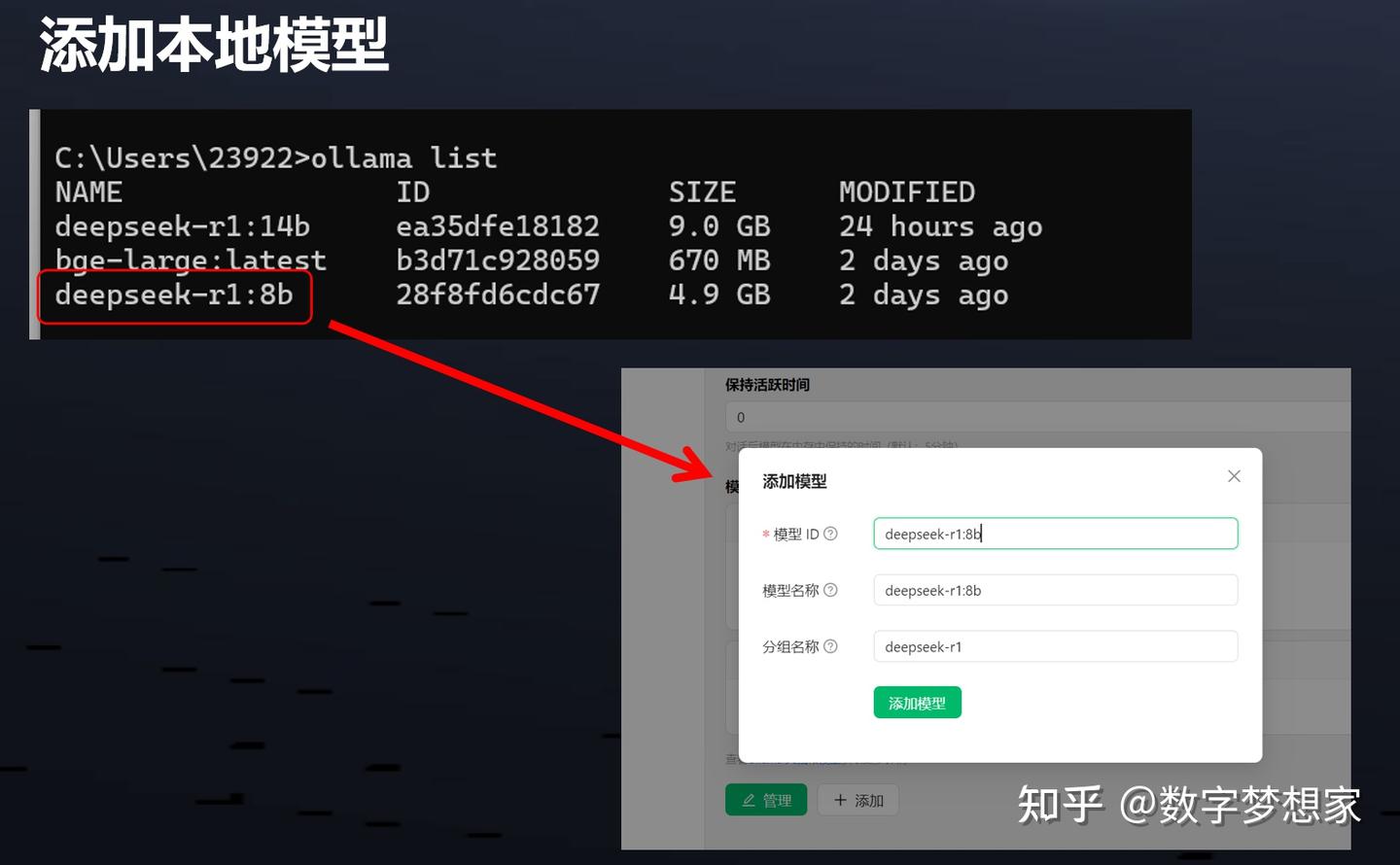

在上述界面中,点击左下角的小齿轮,进入ollama的配置界面,点击添加,把本地部署的模型添加进来:

通过ollama list查找本地部署的模型,直接拷贝模型name即可

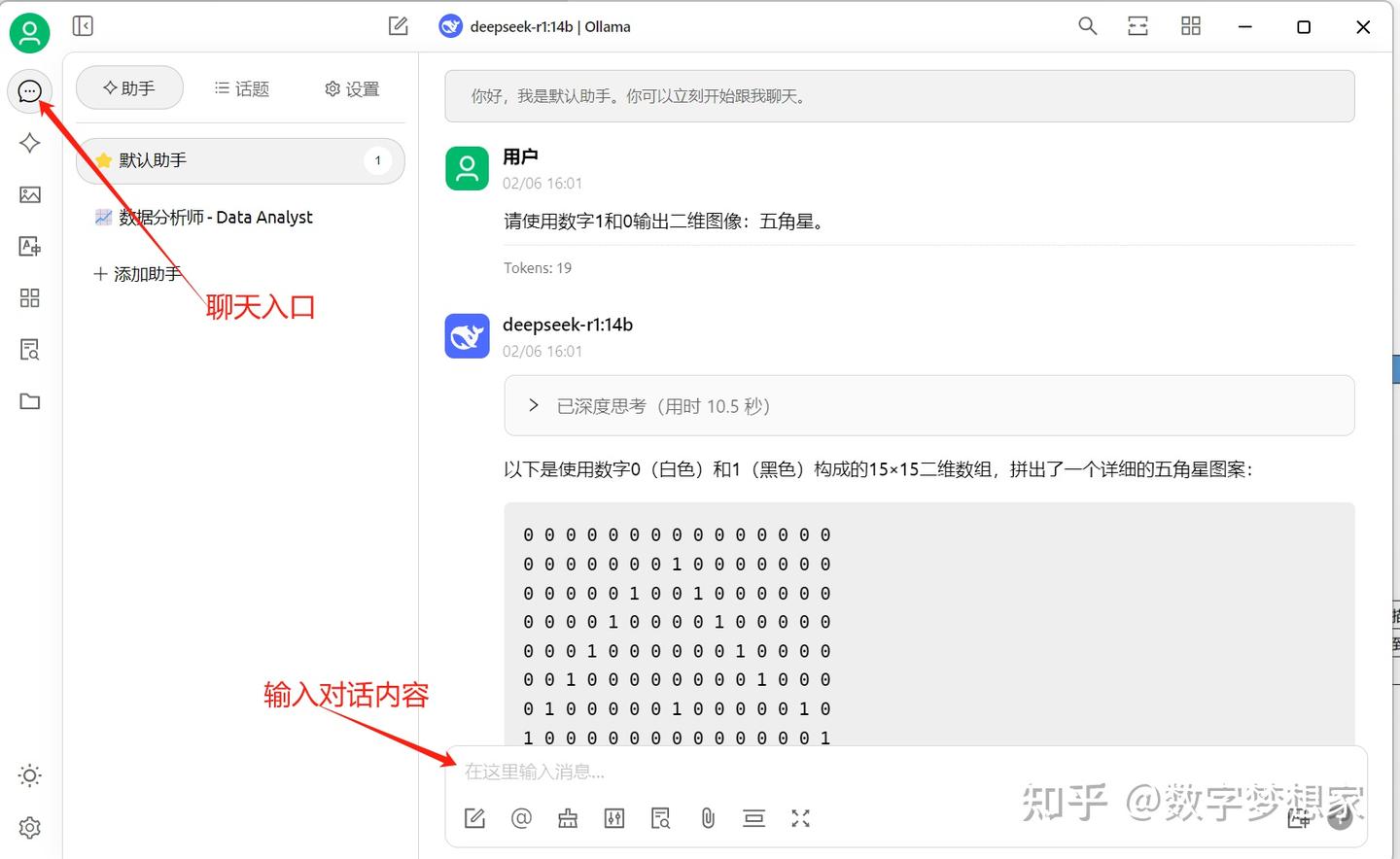

当在CherryStudio中添加了本地部署的deepSeek模型之后,就可以通过聊天入口进行聊天了:

3、通过API调用本地大模型

对于有开发需求的小伙伴来说,仅仅用一个客户端怎么能满足需求呢? 当然是要开启API模式,可以无拘无束地通过API集成的方式,集成到各种第三方系统和应用当中。

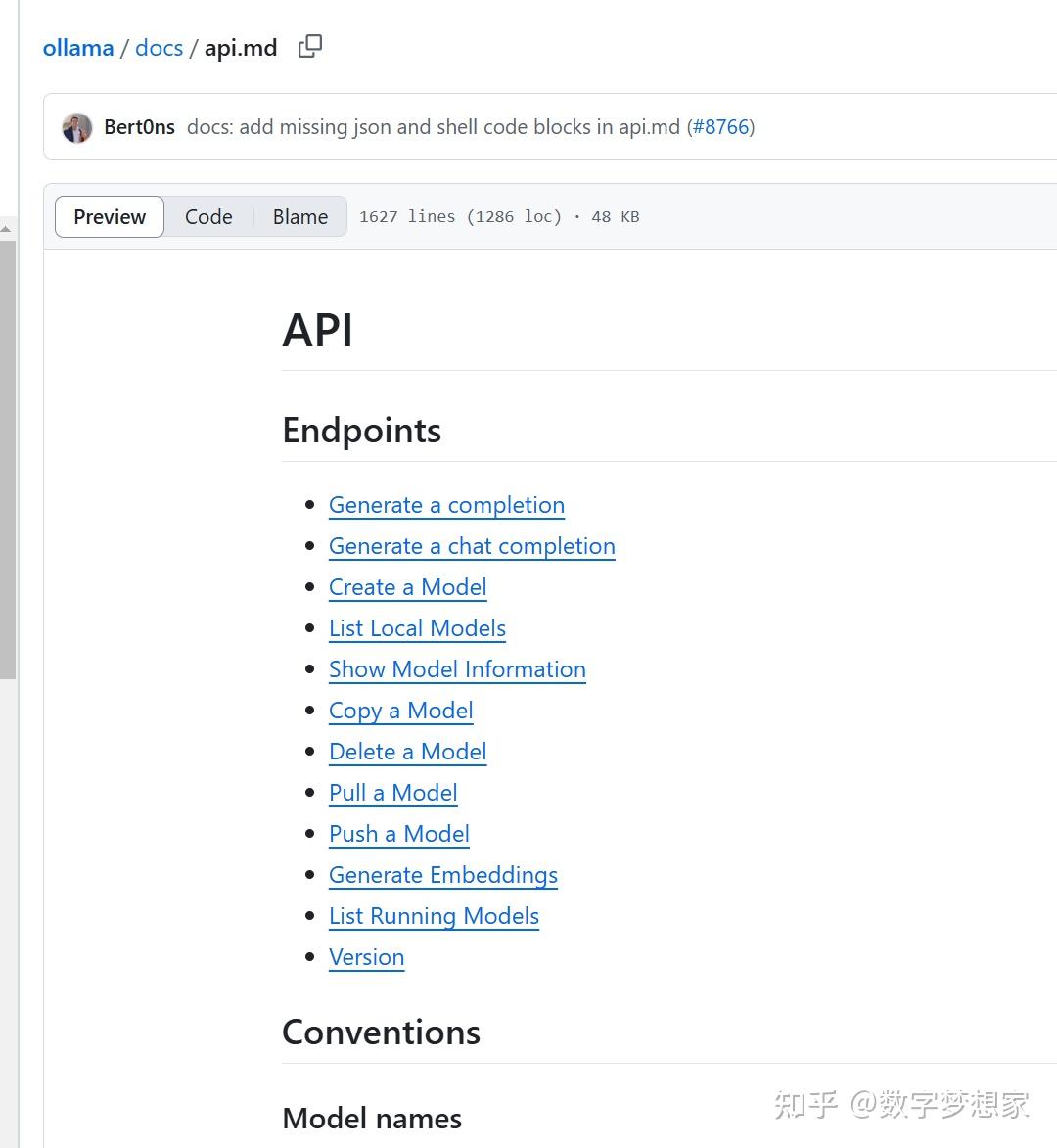

在本实例中,因为我们是基于Ollama框架运行了deepSeek R1模型,ollama相当于一个代理,我们直接调用ollama的API即可实现大模型接口的调用。

Ollama包装了完善的接口与大模型进行交互,详情可以自行查阅,在本例中,我们仅测试对话接口(chat)。

3.1 代码示例1:兼容OpenAI的接口调用:

import base64

from pathlib import Path

from openai import OpenAI

client = OpenAI(

base_url='http://localhost:11434/v1/',

# required but ignored

api_key='ollama',

)

chat_completion = client.chat.completions.create(

messages=[

{

'role': 'user',

'content': '9.9和9.11哪个更大?',

}

],

model='deepseek-r1:8b',

# stream=True,

temperature=0.0, # 可以根据需要调整温度值,决定生成的随机性程度

)

# 打印结果

print("模型返回的内容:")

print(chat_completion.choices[0].message.content)

# outputStr = ""

# for chunk in response_stream:

# outputStr += chunk.choices[0].delta.content

# print(chunk.choices[0].delta.content)3.2 代码示例2:使用ollama简易API:

可以发现,使用Ollama封装的api明显简洁了很多:

from ollama import chat

from ollama import ChatResponse

response: ChatResponse = chat(model='deepseek-r1:8b', messages=[

{

'role': 'user',

'content': '请用python写一段代码,可获取A股所有的股票代码。',

},

])

print(response['message']['content'])

# or access fields directly from the response object

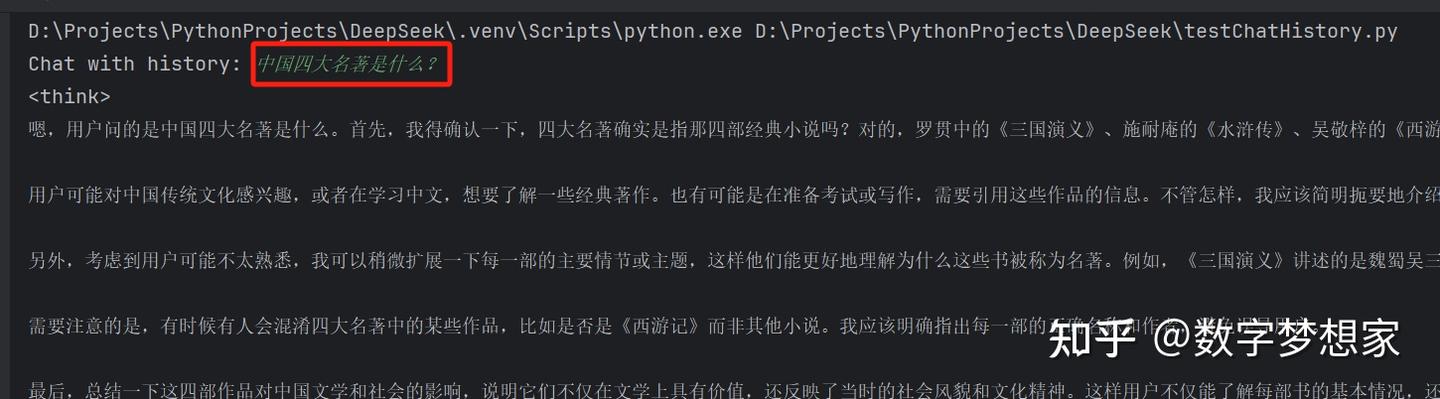

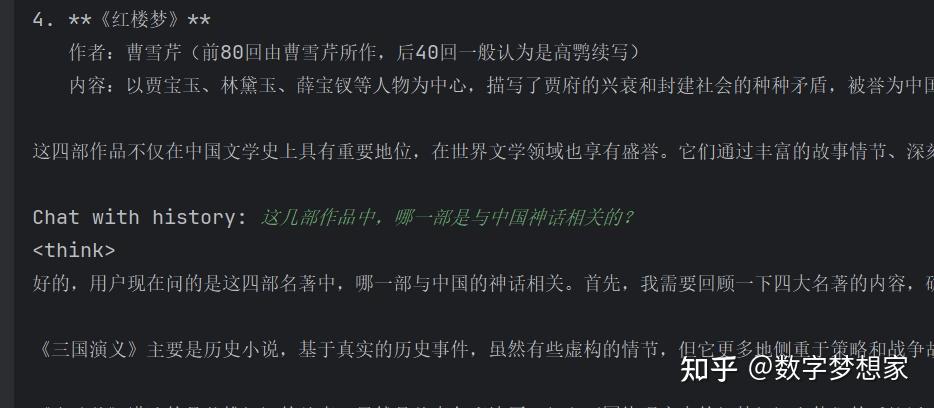

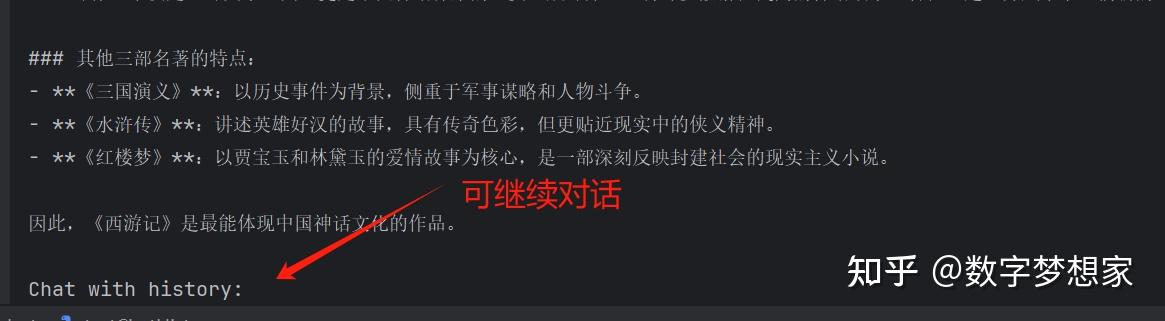

print(response.message.content)3.3 代码示例3:基于历史消息的多轮问答:

from ollama import chat

messages = [

]

while True:

user_input = input('Chat with history: ')

response = chat(

'deepseek-r1:14b',

messages=messages

+ [

{'role': 'user', 'content': user_input},

],

)

# Add the response to the messages to maintain the history

messages += [

{'role': 'user', 'content': user_input},

{'role': 'assistant', 'content': response.message.content},

]

print(response.message.content + '\n')运行此代码,可以在控制台进行多轮交互问答,大模型每次都会基于既往已经回答的内容进行反馈,避免存在“失忆”的情况:

4、总结

总的来说,DeepSeek真的是普惠大众,国货之光!开源了这么优秀的大模型,为加速推进AI行业的发展做足了贡献。由于个人电脑配置(物理内存32G,显卡4060/8G)有限,只测试了8b, 14b两个模型,8b的版本理解力明显低于14b版本,一些初代模型都能很好回答的问题,8b版本竟不之所云。所以如果要对使用场景有一定要求的话,还是要使用更大参数量的版本。

如何系统的去学习大模型LLM ?

大模型时代,火爆出圈的LLM大模型让程序员们开始重新评估自己的本领。 “AI会取代那些行业?”“谁的饭碗又将不保了?”等问题热议不断。

事实上,抢你饭碗的不是AI,而是会利用AI的人。

继科大讯飞、阿里、华为等巨头公司发布AI产品后,很多中小企业也陆续进场!超高年薪,挖掘AI大模型人才! 如今大厂老板们,也更倾向于会AI的人,普通程序员,还有应对的机会吗?

与其焦虑……

不如成为「掌握AI工具的技术人」,毕竟AI时代,谁先尝试,谁就能占得先机!

但是LLM相关的内容很多,现在网上的老课程老教材关于LLM又太少。所以现在小白入门就只能靠自学,学习成本和门槛很高。

基于此,我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近70次后,终于把整个AI大模型的学习门槛,降到了最低!

在这个版本当中:

第一您不需要具备任何算法和数学的基础

第二不要求准备高配置的电脑

第三不必懂Python等任何编程语言

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型教程已经给大家整理并打包,现在将这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、LLM大模型经典书籍

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套LLM大模型报告合集

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、LLM大模型系列视频教程

四、LLM大模型开源教程(LLaLA/Meta/chatglm/chatgpt)

五、AI产品经理大模型教程

LLM大模型学习路线 ↓

阶段1:AI大模型时代的基础理解

-

目标:了解AI大模型的基本概念、发展历程和核心原理。

-

内容:

- L1.1 人工智能简述与大模型起源

- L1.2 大模型与通用人工智能

- L1.3 GPT模型的发展历程

- L1.4 模型工程

- L1.4.1 知识大模型

- L1.4.2 生产大模型

- L1.4.3 模型工程方法论

- L1.4.4 模型工程实践

- L1.5 GPT应用案例

阶段2:AI大模型API应用开发工程

-

目标:掌握AI大模型API的使用和开发,以及相关的编程技能。

-

内容:

- L2.1 API接口

- L2.1.1 OpenAI API接口

- L2.1.2 Python接口接入

- L2.1.3 BOT工具类框架

- L2.1.4 代码示例

- L2.2 Prompt框架

- L2.3 流水线工程

- L2.4 总结与展望

阶段3:AI大模型应用架构实践

-

目标:深入理解AI大模型的应用架构,并能够进行私有化部署。

-

内容:

- L3.1 Agent模型框架

- L3.2 MetaGPT

- L3.3 ChatGLM

- L3.4 LLAMA

- L3.5 其他大模型介绍

阶段4:AI大模型私有化部署

-

目标:掌握多种AI大模型的私有化部署,包括多模态和特定领域模型。

-

内容:

- L4.1 模型私有化部署概述

- L4.2 模型私有化部署的关键技术

- L4.3 模型私有化部署的实施步骤

- L4.4 模型私有化部署的应用场景

这份 LLM大模型资料 包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

375

375

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?