智能车贾维斯诞生Hint-AD:使用人类语言的整体一致的可解释性端到端自动驾驶

Abstract

自动驾驶 (AD) 中的端到端架构面临着解释性问题,阻碍了人类对AI的信任。人性化的自然语言已被用于驾驶解释和三维场景描述等任务。然而,之前的工作主要集中在声明性可解释性的范式上,自然语言解释并未基于AD系统的中间输出,这使得解释仅仅是声明性的。相比之下,对齐式可解释性则在语言和AD系统的中间输出之间建立了联系。本文提出了Hint-AD,这是一种整合了AD和语言系统的架构,它生成的语言与AD模型的整体感知-预测-规划输出相一致。通过结合中间输出和有效特征适配的整体token混合子网络,Hint-AD在驾驶语言任务(如驾驶解释、三维密集描述和命令预测)中实现了令人满意的准确性,达到了最新的结果。为了促进在nuScenes上的驾驶解释任务研究,我们还引入了一个人工标注的数据集Nu-X。

代码及数据获取:https://air-discover.github.io/Hint-AD/

欢迎加入自动驾驶实战群

Introduction

端到端的感知-规划架构在自动驾驶(AD)和通用具身智能领域中至关重要,因为它具有使用大量数据进行自监督训练的潜力。然而,这些系统面临着重大的可解释性挑战。具身智能问题(如AD)中的可解释性问题尤为明显。当AD系统直接输出控制信号时,人类乘客很难信任这些决策。为了解决这一问题,自然语言作为一种高度用户友好的沟通媒介,被用于通过驾驶解释、三维密集描述和视觉问答(VQA)等任务来增强可解释性。虽然人类司机能够通过鸟瞰视角(BEV)轨迹来解释“发生了什么”,但语言为“为什么会这样”提供了补充的视角。

现有的研究忽略了语言解码器与AD流水线中的感知-预测-规划输出之间的对应关系,导致语言任务与AD任务之间出现差异。通过AD流水线的中间输出提高驾驶场景下语言任务的准确性这一潜力尚未得到充分挖掘。为此,我们提出了Hint-AD,这是一种与AD模型的感知-预测-规划过程进行整体对齐的框架,旨在提高语言生成的准确性并促进自动驾驶的可解释性。

我们开发了两种方法来实现语言与AD模型的整体对齐和语言输出的准确性:(a) 我们开发了一种整体token混合模块,适配AD模型的中间输出token,为语言解码器提供输入,专注于稳健的特征提取和融合;(b) 我们引入了一项对齐任务作为在线数据集,使语言解码器在训练过程中解释AD模型推理过程中的中间token。

我们将Hint-AD实现于使用栅格化和矢量化表示的两个最新AD模型(UniAD和VAD)上,以展示其通用性。实验结果表明,Hint-AD在各种语言任务(如驾驶解释、三维密集描述、视觉问答和驾驶命令预测)中实现了最新的性能。此外,我们还贡献了一个人工标注的驾驶解释数据集Nu-X,以弥补在广泛使用的nuScenes AD数据集上缺乏驾驶解释数据的不足。

3.Method

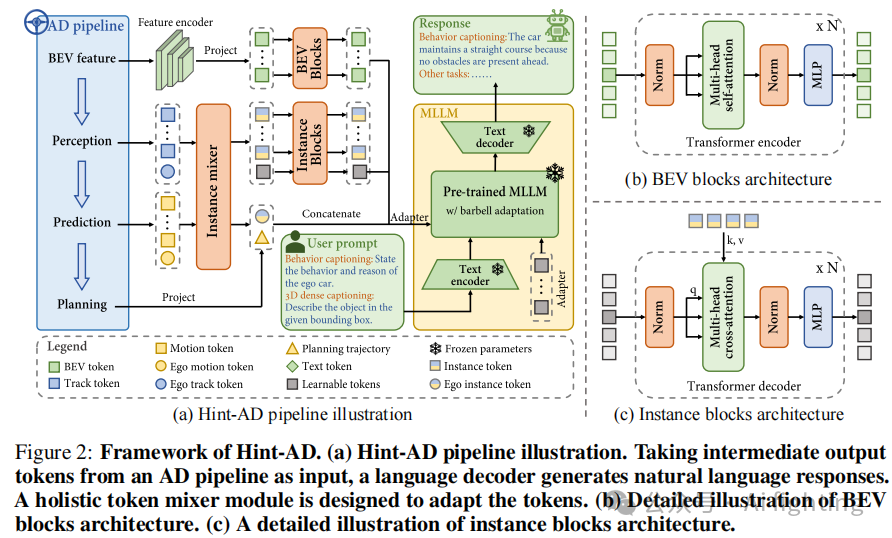

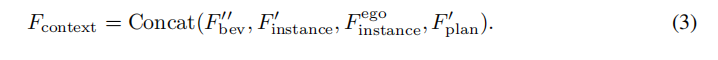

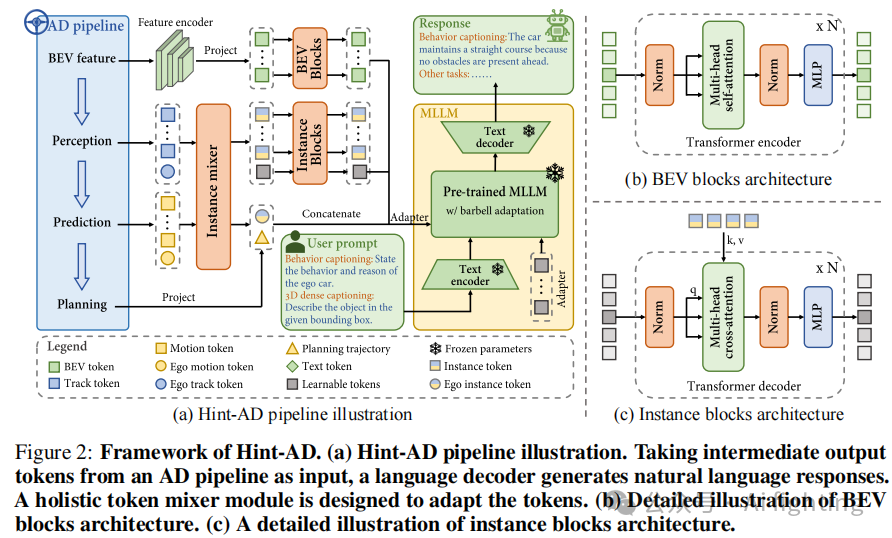

为了探索端到端AD框架中自然语言与中间结果的整体对齐,我们提出了一种名为Hint-AD的新框架,该框架包括三个模块:整体token混合器、语言解码器和传统的AD框架。Hint-AD的概述如图2所示。图2中的现有AD流水线可以是任何将AD分解为感知、预测和规划的端到端AD系统。在不损失通用性的前提下,我们在UniAD和VAD之上实现了我们的方法。

3.1 Hint-AD的整体框架

首先,我们从现有的AD模型的感知-预测-规划架构中提取中间查询token,得到track token、motion token和planning token。其次,整体token混合器模块将这些token适配为语言解码器的输入,其中我们设计了一个实例混合器,用于融合每个检测到的实例的实例级轨迹和运动信息。我们还引入了BEV块和实例块,用于进一步特征提取并将可变长度的实例token转换为固定长度。所有处理后的token被连接为文本生成的上下文token。

3.2 整体Token混合器

从AD流水线中提取的查询token无法直接被语言解码器理解。为了解决这个问题,我们提出了一个整体token混合器架构。Hint-UniAD和Hint-VAD的具体实现略有不同。我们主要遵循Hint-UniAD的设计。

首先,我们为从AD流水线中提取的查询token提供符号表示。对于一个典型的感知-预测-规划AD流水线,可以提取以下组件:BEV token

![]()

,其中

![]()

和 分别是BEV场的高度、宽度和通道数。轨迹token

![]()

包含每个检测到的物体的位置和过去的轨迹信息,其中

![]()

是检测到的物体数量,𝐷是token向量的维度。运动token

![]()

包含每个检测到的物体的未来轨迹预测。规划步骤

![]()

是模型预测的未来轨迹。为了有效地将token合并到实例级别,我们设计了一个新的实例混合器,它将每个检测到的实例的轨迹token

![]()

和运动token

![]()

整合为一个实例token

![]()

.这通过张量拼接后跟随一个多层感知机(MLP)投影器

![]()

来完成,将

![]()

个检测到的实例的token投影为维度为

![]()

:

![]()

特征编码器 𝐸实现为多层卷积网络,提取特征并将BEV缩放至 3×3。随后,使用MLP投影器

![]()

将BEV通道维度𝐶转换为嵌入维度

![]()

,得到

![]()

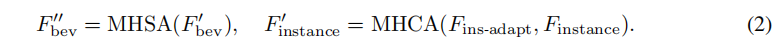

BEV块和实例块使用多头自注意力层来适应BEV和实例特征。对于BEV token,使用多头自注意力(MHSA)进行操作。由于每帧检测到的实例数量可变,引入了

![]()

个可学习的token

![]()

作为查询。然后在这些可学习的token和实例token之间执行多头交叉注意力(MHCA)。BEV块和实例块通过改进BEV和实例token的特征提取和融合,提升了适应性,如第4.4节所示。

规划步骤

![]()

将通过正弦位置编码PE和MLP投影器

![]()

被编码为嵌入维度

![]()

在所有实例token中,有一个自车实例token

![]()

代表自车。处理后的BEV、实例、自车实例和规划token将被连接为上下文token,用于后续的语言生成任务:

3.3 带杠铃适应的语言解码器

为了在与自动驾驶(AD)相关的语言任务中引入多模态大型语言模型(MLLMs)的高级推理和上下文理解能力,我们使用了一个基于预训练的LLaMA-2-7B的LLaMa-Adapter-V2作为语言生成器。在语言微调过程中,使用了可学习的适配器

![]()

,它们作为额外的键和值插入到零初始化注意力机制的层中,其中

![]()

是插入层的数量,

![]()

是语言解码器中token的维度。

在原始的LLaMa-Adapter-V2策略中,上下文token

![]()

会插入到第一层,可学习的适配器会插入到其余的 N−1 层中,其中𝑁是LLaMA-2-7B的总层数。我们观察到用于语言微调的适配器往往主导了适应过程,减少了上下文与语言的对齐。这对于需要高级上下文理解能力的AD任务至关重要。因此,我们提出了一个杠铃适应范式(见图2),其中可学习的适配器仅插入

![]()

层(作为前置适配器

![]()

和

![]()

层(作为后置适配器

![]()

。上下文token插入到第一层。

前后都放置适配器的原理是,前置适配器有助于理解上下文信息,而后置适配器则增强语言微调。该设计平衡了对高级上下文理解和精确语言适应的需求。第4.4节证明了这一杠铃适应方法的有效性。在训练过程中,我们采用交叉熵损失作为字幕损失,监督仅应用于答案token上。

3.4 对齐语言和中间输出

为了将语言与AD模型的中间输出对齐,语言解码器需要对每个token(即轨迹token中物体的位置)所包含的信息进行上下文理解,这些token是在AD模型推理步骤中生成的。我们通过在训练过程中添加在线对齐任务数据集来实现这一点。

在对齐任务中,给定AD模型的中间输入,生成一组提示-答案对(见图3)。该任务包括四种对齐类型:(a) 计数对齐,要求语言解码器根据轨迹token解释帧中检测到的每种类型的实例数量;(b) 位置对齐,要求模型根据特定实例token提供被跟踪实例的位置;© 运动对齐,涉及解码实例token中包含的速度信息;(d) 规划对齐,要求语言解码器输出规划token中包含的未来轨迹点。

所有对齐任务的问答对均在训练期间在线生成。对齐任务大大提高了语言解码器对中间token的上下文理解,从而显著提高了AD字幕生成的准确性。

3.5 训练流程

Hint-AD的整个训练流程包括两个阶段。第一阶段,端到端AD模型独立训练。第二阶段,我们冻结AD模型和MLLM的所有参数,只更新整体token混合器和适配器的参数。第二阶段的可训练参数总数为87M,更多的训练细节见附录A。

Experiment

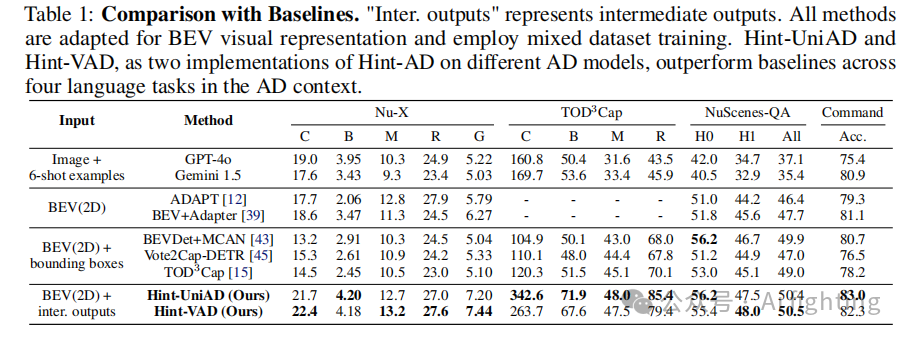

定量结果。我们在四个数据集上分别针对不同的输入类型和主干模块呈现结果。从表1可以得出以下结论。Hint-UniAD和Hint-VAD在多任务测试中表现出较高的性能。两种系统在Nu-X数据集上均实现了SOTA(最新技术)结果,CIDEr得分比最佳基线(BEV+Adapter)高出3.8分(20.4%)。值得注意的是,Hint-UniAD在TOD3Cap任务中表现显著优越,CIDEr得分提高了222.3分(185%)。虽然Hint-VAD在该任务中的表现略低,但相关的潜在解释在附录C.3中讨论。此外,在NuScenes-QA和指令数据集中,Hint-VAD的总体准确率分别比最佳基线提高了0.6和1.2分。这些结果突显了所提出的Hint-AD架构的有效性。

定性结果。图3展示了一些定性结果。Hint-AD生成的文本展示了对场景的深刻理解,并与AD模型的中间结果恰当地对齐。

消融研究

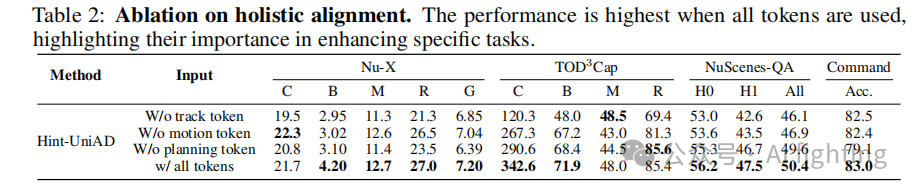

整体对齐的有效性。为了评估整体语言与AD对齐对语言任务准确性的影响,我们通过从语言解码器的输入中移除跟踪、运动和规划tokens进行了消融研究。表2的结果表明,使用所有tokens的性能最高。跟踪tokens通过提供位置信息增强了3D密集字幕,而规划tokens通过提供未来的轨迹数据改善了指令预测。

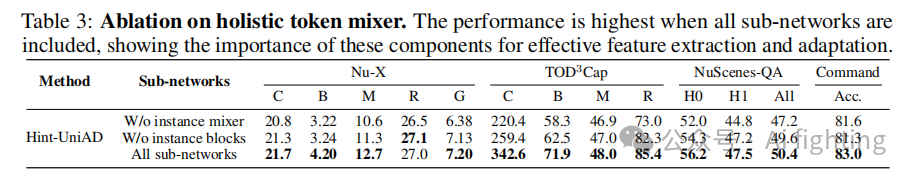

整体token混合器设计的消融。实例混合器和实例块增强了中间tokens的特征提取和适应性。表3的结果表明,移除实例块和实例混合器会显著降低TOD3Cap和NuScenes-QA的性能,因为物体的位置和运动信息没有得到充分融合。

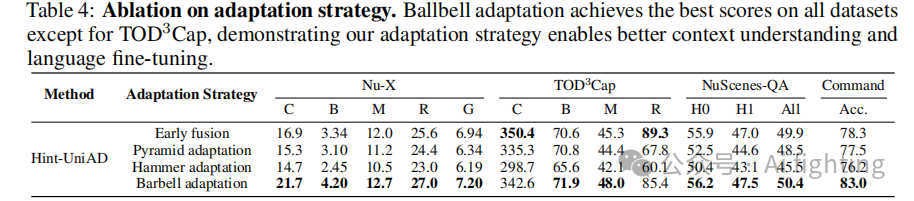

杠铃适配的有效性。我们探索了三种替代方案:(a)早期融合,LLaMA-Adapter-V2的原始设计,适配器在每一层中;(b)金字塔适配,适配器在前Nfront层中;(c)锤式适配,适配器仅在最后的Nend层中。杠铃适配在三个数据集上的表现最好(表4)。

结论

本文贡献如下:

1.提出了Hint-AD是一个框架,它通过与自动驾驶(AD)模型的感知-预测-规划过程整体对齐,提高了驾驶场景下语言任务的准确性,并增强了自动驾驶的可解释性。

2.该框架包括两种方法:(a) 整体token混合模块,用于适配AD模型的中间输出token并提供给语言解码器,以稳健地提取和融合特征;(b) 引入对齐任务作为在线数据集,使语言解码器在训练中能够解释AD模型推理过程中的中间token。

3.Hint-AD已经在两个使用栅格化和矢量化表示的AD模型(UniAD和VAD)上实现,并在多个语言任务中取得了最新性能。此外,为了支持在nuScenes数据集上进行驾驶解释任务的研究,还贡献了一个新的人工标注数据集Nu-X。

文章引用:Hint-AD: Holistically Aligned Interpretability in End-to-End Autonomous Driving

最后别忘了,帮忙点“在看”。

您的点赞,在看,是我创作的动力。

关注我的公众号auto_driver_ai(Ai fighting), 第一时间获取更新内容。

AiFighing是全网第一且唯一以代码、项目的形式讲解自动驾驶感知方向的关键技术。

扫码加入自动驾驶实战知识星球,即可学习自动驾驶感知的最新技术:环境配置,算法原理,算法训练,代码理解等。

1448

1448

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?