作者: bhn

论文:https://arxiv.org/abs/2405.14768

代码:https://github.com/zjunlp/EasyEdit

人类的学习能力是独特而强大的。我们不仅能够在成长过程中不断积累知识,还能够在面对新情况时灵活应用和更新已有的认知。这种终生学习的能力让我们能够适应不断变化的环境,解决新出现的问题。那么,我们如何才能将这种宝贵的能力赋予人工智能系统呢?这篇文章给出了一个答案。

背景

大语言模型虽然取得了成功,但是由于人类不断的产生新的知识,知识也在不断的更新,这要求大模型也需要不断地以一种高效的方式进行更新。然而目前以微调的方式对模型进行更新要求大量的计算资源,这是十分昂贵的。而基于编辑的方式进行的模型更新也具有各种各样的副作用。

这篇文章参考人类学习的方式—即人类不断的渐进的获取新的知识,然后遗忘旧的知识—设计了一种终身学习的模型编辑方法,既有可以实现模型高效的更新,又能避免灾难性遗忘等知识变价的副作用。

相关工作

记忆和知识注入:在一些文献中,基于人类认知理论为,将模型的记忆分为长期记忆和工作记忆。长期记忆指的是存储在模型中的参数,可以通过预训练,在训练,微调和模型编辑进行更新。工作记忆通过检索实现的神经网络激活的非参数化知识。如GRACE为为模型添加了一个适配器,每一次的编辑都写入适配器层,推理是对适配器进行检索,以实现更新知识的检索。

模型合并:模型融合目的是将不同模型的知识合并到一个模型中去。但是发现即使对于采用相同数据集,相同初始化训练的模型也很难实现融合。一些文献归结于深度神经网络具有排列不变性。

本文的工作

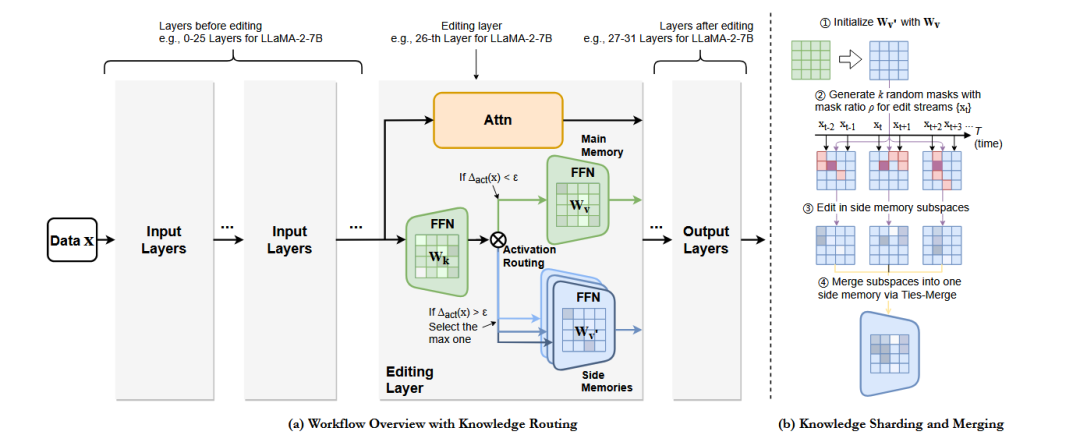

方法概述:终生编辑学习目的是确保大模型经历数百上千次编辑之后,能够对齐人类的期望并且维持以前的知识和能力。为了达到这个目的,该论文引入了两个组件辅助记忆模块和知识分片和合并机制。

辅助记忆设计

目前知识编辑的工作,对模型中的FFN层的 值矩阵进行编辑,但是会引起遗忘和其他的副作用。

该工作将模型中的值矩阵复制一份作为辅助记忆,进而在辅助记忆上进行编辑,从而绕过了这些缺陷。辅助记忆的输出为:。

而在推理过程中,通过一个路由机制判断,是否使用辅助记忆。如果给定查询在之前的编辑范围内,辅助记忆会被使用;否则,使用主要记忆。

知识分片与合并

为了实现终生编辑学习,需要在参数空间进行数百甚至上千次编辑,最终一定会引起编辑知识冲突,最终造成灾难性遗忘。为了避免在一个参数空间中进行多次编辑,该论文提出将将辅助记忆复制k次,然后将n次编辑应用到k个分片中,从而实现持续的编辑。

对于多个辅助记忆分片,存在着重叠的元素和不相交的元素。该论文采用Ties-Merge的合并方法,把重叠的部分当作锚点,最终将多个记忆分片合并为一个记忆。

实验分析

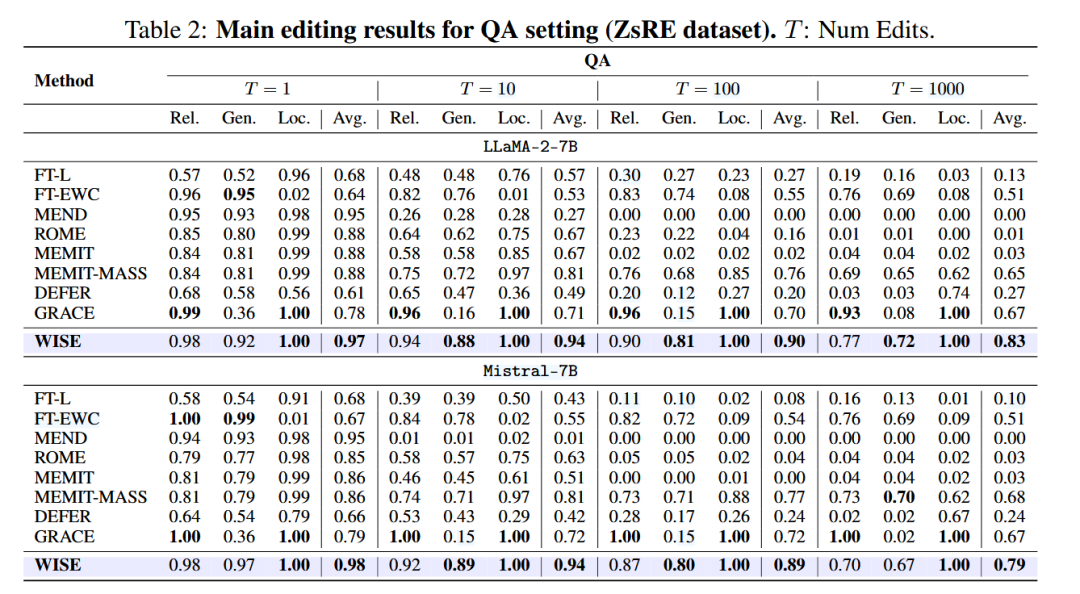

在ZsRE数据集上进行QA问答评估的试验结果表明,当编辑次数达到1000时,WISE方法的平均性能比其他方法高10%以上。像MEND和ROME方法在前期具有很强的竞争力,但是随着编辑次数的提高,这些方法的Loc指标明显下降。GRACE方法虽然在Rel和Loc指标上表现优秀,但是在Gen泛化能力上表现差劲,一种可能的原因是GRACE的编辑方法,只是记住了知识,并不是理解了这些知识。

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦

1568

1568

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?