YOLOV8 目标检测注意力机制改进实例与创新改进专栏

目录

1.CBAM注意力机制介绍

CBAM(Convolutional Block Attention Module)注意力机制的详细信息:

CBAM 按照顺序依次推断出通道和空间两个维度的注意力权重,然后与原特征图相乘来对特征进行自适应调整。具体过程为,先将输入特征图输入到通道注意力模块,得到通道注意力权重后与原特征图相乘,对特征图的通道维度进行重新标定,突出重要的通道信息;然后将经过通道注意力调整后的特征图输入到空间注意力模块,得到空间注意力权重后再与之前的特征图相乘,对特征图的空间维度进行重新标定,突出重要的空间区域。这样可以让模型更加关注输入数据中具有重要语义信息的通道和空间位置,从而提高模型的性能。

2. CBAM 具有优势:

- 综合考虑多维度信息:

- 通道和空间双重视角:许多注意力机制只关注单一维度,如 SENet 主要聚焦于通道维度的注意力。而 CBAM 同时考虑了通道和空间两个维度。在通道维度上,它能够确定哪些特征通道对当前任务更重要,帮助模型关注到更关键的语义信息;在空间维度上,可以识别出特征图中哪些区域需要重点关注,比如图像中的目标物体所在区域等。这种多维度的关注使得模型能够更全面地理解输入数据,提取到更有效的特征,从而提高模型的性能和准确性。

- 轻量级且计算高效:

- 模块结构简单:CBAM 的结构相对简单,由通道注意力模块和空间注意力模块组成,每个模块的计算复杂度并不高。在通道注意力模块中,使用了全局平均池化和全局最大池化操作来聚合特征信息,然后通过一个共享的多层感知机(MLP)来生成通道注意力权重。空间注意力模块则通过对通道维度的平均池化和最大池化操作,以及一个卷积层来生成空间注意力权重。这种简单的结构使得 CBAM 在增加少量计算开销的情况下,能够显著提升模型的性能。

- 易于集成到现有模型:由于其轻量级的特点,CBAM 可以很容易地集成到各种卷积神经网络架构中,无需对原模型进行大规模的修改。这使得研究人员和开发者可以在不增加过多计算资源和训练时间的前提下,快速提升模型的性能,具有很强的实用性和可扩展性。

- 灵活的顺序组合:

- 顺序可调整性:CBAM 中通道注意力和空间注意力模块的处理顺序是可以灵活调整的。实验表明,先进行通道注意力的计算,再进行空间注意力的计算这种顺序通常能够取得更好的效果,但在某些特定的任务或模型架构下,也可以尝试其他的顺序组合,以满足不同的需求。这种灵活性使得 CBAM 能够更好地适应不同的应用场景和模型结构。

- 注意力可视化效果好:

- 特征提取的可解释性强:通过使用 CBAM,可以对模型所关注的特征区域进行可视化分析。这有助于研究人员更好地理解模型的决策过程,分析模型是如何关注到输入数据中的重要信息的。与一些其他的注意力机制相比,CBAM 的可视化结果更加清晰明了,能够更直观地展示模型对通道和空间信息的关注程度,从而为模型的优化和改进提供有力的依据。

- 性能提升显著:

- 广泛的适用性和有效性:在多个图像分类和目标检测任务的实验中,CBAM 都表现出了显著的性能提升。无论是在大型数据集还是小型数据集上,无论是在复杂的模型架构还是简单的模型架构中,CBAM 都能够有效地增强模型的表示能力,提高模型的准确率和鲁棒性。与其他一些注意力机制相比,CBAM 在不同的任务和数据集上具有更稳定的性能表现。

3. CBAM网络结构图

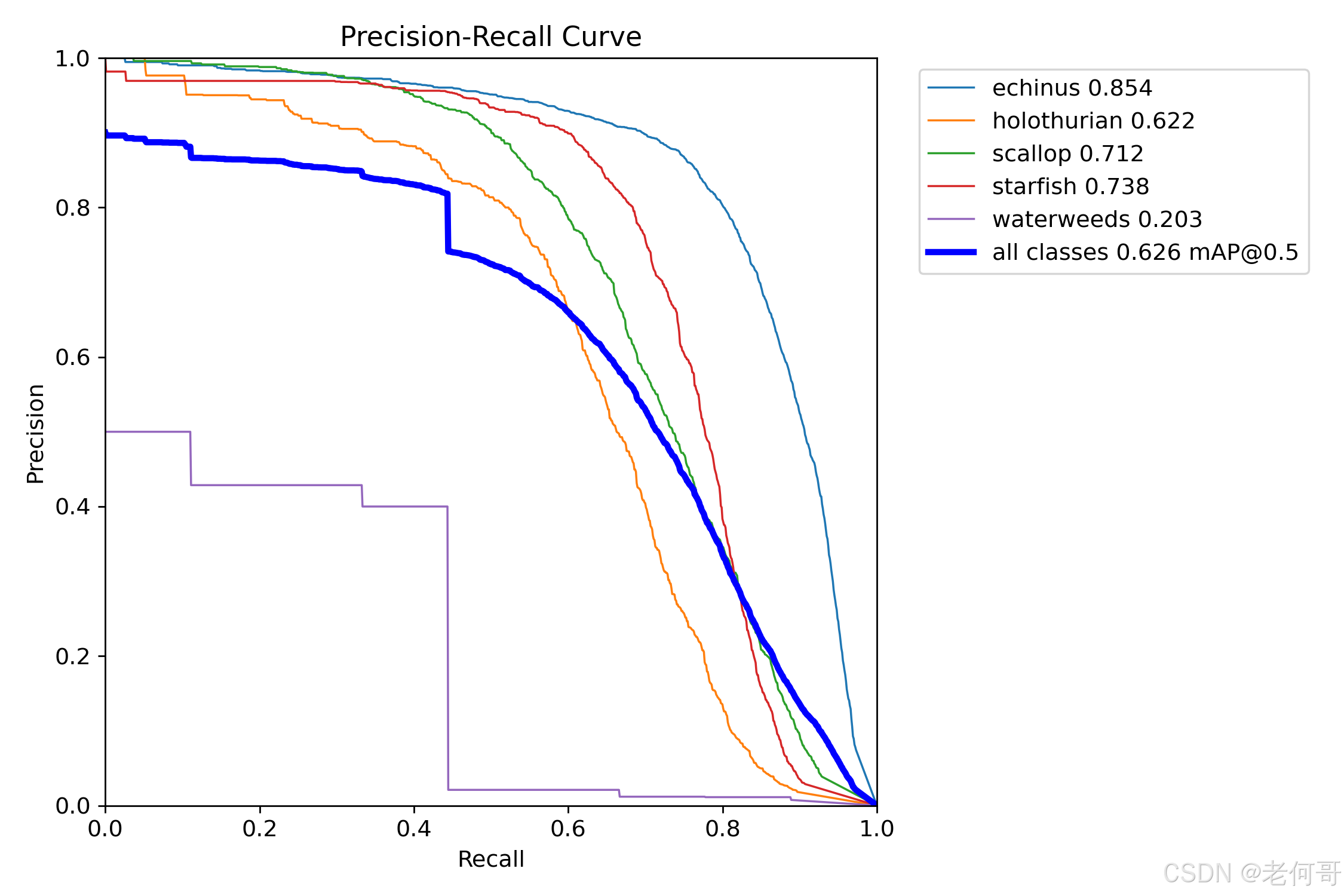

4. CBAM 训练效果

此结果为在水下目标数据集训练结果;

此图为yolov8原始训练结果;

5.部分代码实现

class CBAM(nn.Module):

"""Convolutional Block Attention Module."""

def __init__(self, c1, kernel_size=7):

"""Initialize CBAM with given input channel (c1) and kernel size."""

super().__init__()

self.channel_attention = ChannelAttention(c1)

self.spatial_attention = SpatialAttention(kernel_size)

def forward(self, x):

"""Applies the forward pass through C1 module."""

return self.spatial_attention(self.channel_attention(x))6.完整代码地址

我们提供完整的项目文件,你也可以直接下载到本地,然后打开项目,修改数据集配置文件【water.yaml】的数据集路径即可训练模型。完整项目代码订阅专栏即可获取!

5639

5639

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?