目录

文章section3. data-driven solutions of partial differential equations

前言

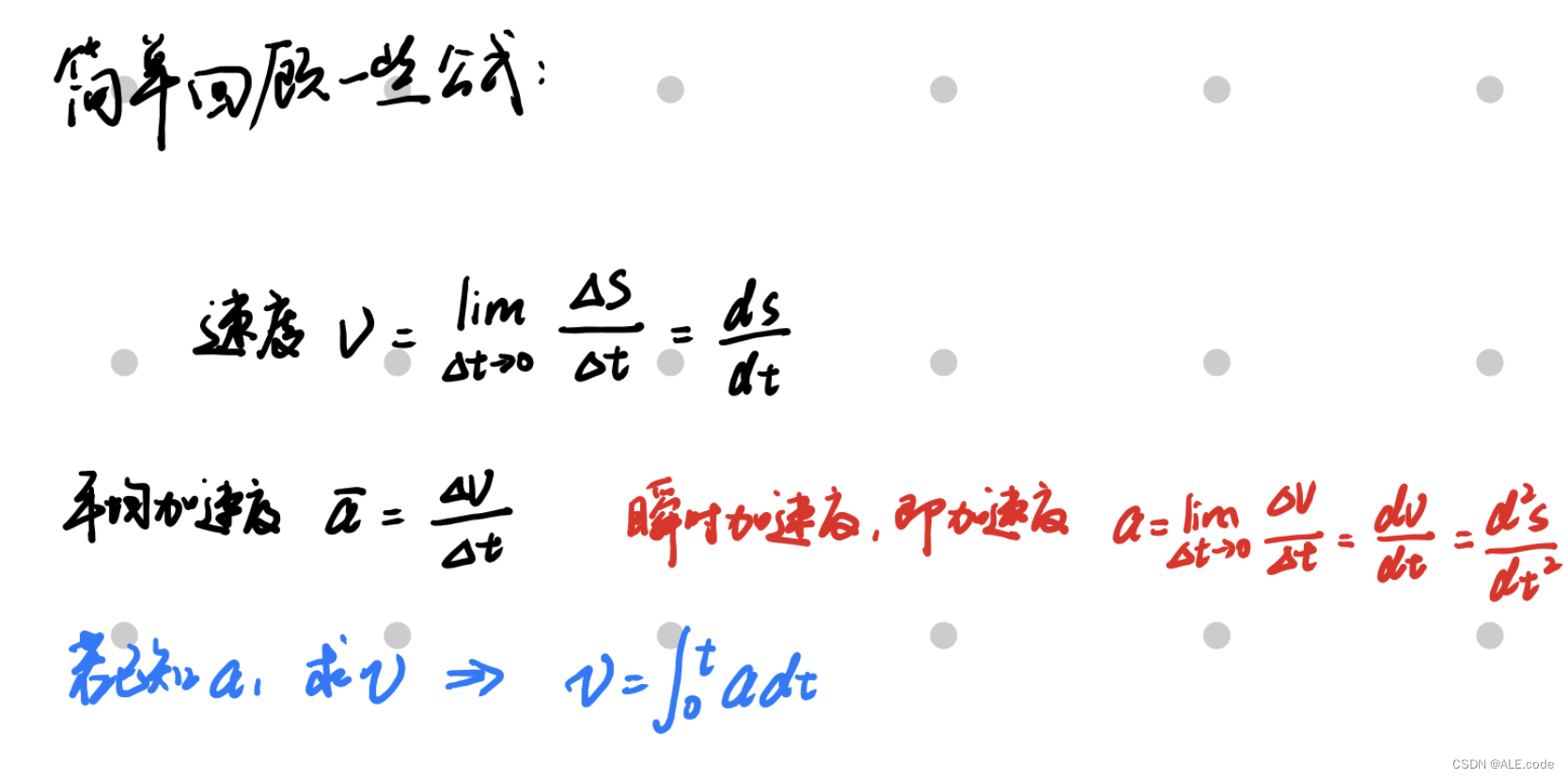

物理模拟简单公式说明

- 物理模拟可以简单看做不停在解

这个方程(称之为Governing Equations)-->求a

(其中F(force):某一个粒子的受力(假设已知—— 一般通过deformation得到);m(mass):某一个particle的质量(假设已知—— 一般通过m=ρV(ρ:density;V:volume));a(acceleration):表示某一个particle的加速度(未知数))

- 对于每一个particle会去track其state

这里简单用position以及velocity来描述state,即: (x: 三维坐标,v: velocity)

- position——x:当前时刻和上一时刻的坐标关系可以看做:

- velocity——v:如下图的蓝色公式:

所以v是关于t的一阶导数,a是关于t的二阶导数

Steps: 知道这个时刻的加速度a-->能得到这个时刻的速度v-->知道这个时刻的速度,即能算出下个时刻的位移。

Recap一些公式补充:

(匀速运动)

匀速直线运动的质点坐标:

(变速运动)

1. 变速运动速度:

2. 变速运动质点坐标:

3. 速度随坐标变化公式:

PINN

PINN的seminal paper来自于2019年的这篇文章👇🏻

文章Link: https://www.sciencedirect.com/science/article/abs/pii/S0021999118307125

简单理解

根据上面简单的一些公式说明,我们意识到是在不停地解F=ma这个方程,那么可以变成一个解 这个公式,即做minimization下面:

不断缩小F-ma,逼近求得一个a满足F-ma=0

这个就可以用neural network来模拟,即loss function。

具体公式理解

(解读PINN文章的一些重点内容)

根据前言的小知识,我们可以明白在文章2. Problem setup 公式(1):

从high-level来看即F=ma(F-ma=0),这里整理成的形式是一个关于时间的偏微分方程 partial differential equations(PDE)

文章section3. data-driven solutions of partial differential equations

从文章3开始,上面的(1)公式可以写成更简单的形式如下图:

Continuous time models

3.1对上面的图片中红框标出的公式(2)进行了简化。

- 物理模拟的loss regulate: f为F-ma,其中MSEf即对应:

- 数据分布loss regulate这一项是:假设有一些supervision的data,即一些真实的观测数据

,与neural network approximate出的

的数据,进行mse

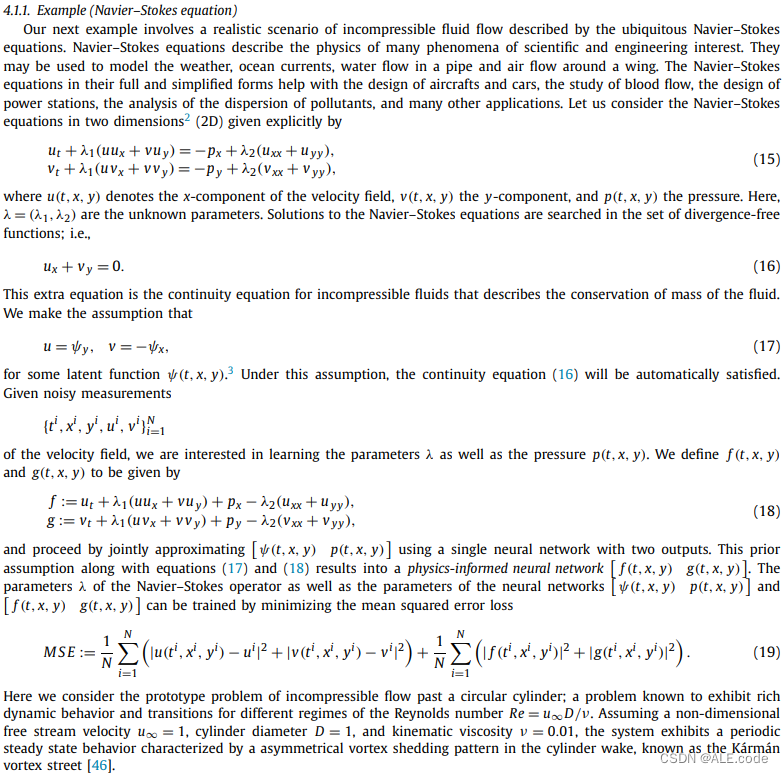

Specific Example-流体模拟

在文章的4.1.1节给了流体模拟的example来进一步说明PINN,本质上还是F=ma

- 流体模拟中,有两个量需要track,即pressure & velocity -->所以公式(15)是两个公式。

- 公式(18)把公式(15)整理了一下,变成了右端项为0的方程组形式(解方程组--neural network来帮忙-->公式(19)Loss)

可以注意到公式(19)的MSE loss中的"+号"右边部分,同样是F-ma L2 norm的形式(物理模拟);"+号"左边的部分,同样是有些观测数据然后数据上的regulate loss。

Other Info

如何将显示方程整理成PDE,以F=ma为例,可以考虑如下Steps:

Reference

安利一些写得超级不错的相关文章:

PINN——加入物理约束的神经网络 - 知乎【摘要】 基于物理信息的神经网络(Physics-informed Neural Network, 简称PINN),是一类用于解决有监督学习任务的神经网络,它不仅能够像传统神经网络一样学习到训练数据样本的分布规律,而且能够学习到数学方…![]() https://zhuanlan.zhihu.com/p/544561165深度学习求解偏微分方程(4)PINN局限与拓展 - 知乎创作不易,每篇文章基本都要写一整天,希望给个小小的三连支持一下! 最近一周(11.11-11.17)出一个深度学习求解偏微分方程系列,流程大概是 传统方法不足-->PINN-->PINN实战-->PINN不足-->算子学习-…

https://zhuanlan.zhihu.com/p/544561165深度学习求解偏微分方程(4)PINN局限与拓展 - 知乎创作不易,每篇文章基本都要写一整天,希望给个小小的三连支持一下! 最近一周(11.11-11.17)出一个深度学习求解偏微分方程系列,流程大概是 传统方法不足-->PINN-->PINN实战-->PINN不足-->算子学习-…![]() https://zhuanlan.zhihu.com/p/666566853PINN物理信息神经网络入门及相关论文 - 知乎物理信息驱动深度学习方法 基于神经网络的微分方程求解器论文总结 物理信息驱动深度学习方法入门详解 物理信息驱动的深度学习方向重要进展与趋势 基于物理信息驱动深度学习的不确定性量化方法 本栏主要介绍物理信…

https://zhuanlan.zhihu.com/p/666566853PINN物理信息神经网络入门及相关论文 - 知乎物理信息驱动深度学习方法 基于神经网络的微分方程求解器论文总结 物理信息驱动深度学习方法入门详解 物理信息驱动的深度学习方向重要进展与趋势 基于物理信息驱动深度学习的不确定性量化方法 本栏主要介绍物理信…![]() https://zhuanlan.zhihu.com/p/517450449?utm_id=0

https://zhuanlan.zhihu.com/p/517450449?utm_id=0

1113

1113

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?