基于中心的三维目标检测与跟踪——译文

前言

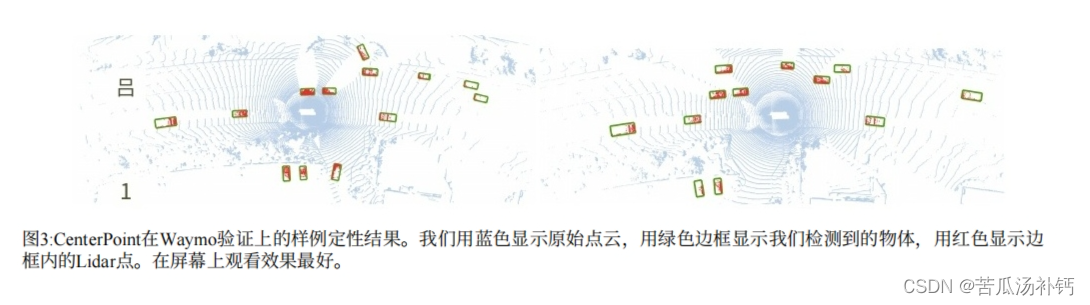

在本文中将展示如何将兴趣目标表示点,大大简化了3D识别。代码和预训练模型可在https://github.com/tianweiy/CenterPoint获得。

三维物体通常表示为点云中的三维检测框。这种表示模仿了经过充分研究的基于图像的2D边界检测框,但存在额外的挑战。3D世界中的对象不遵循任何特定方向,基于检测框的检测器难以枚举所有方向或将轴对齐的边界盒拟合到旋转的对象。 该论文中,用点来表示、检测和跟踪3D物体。

一、CenterPoint是什么?

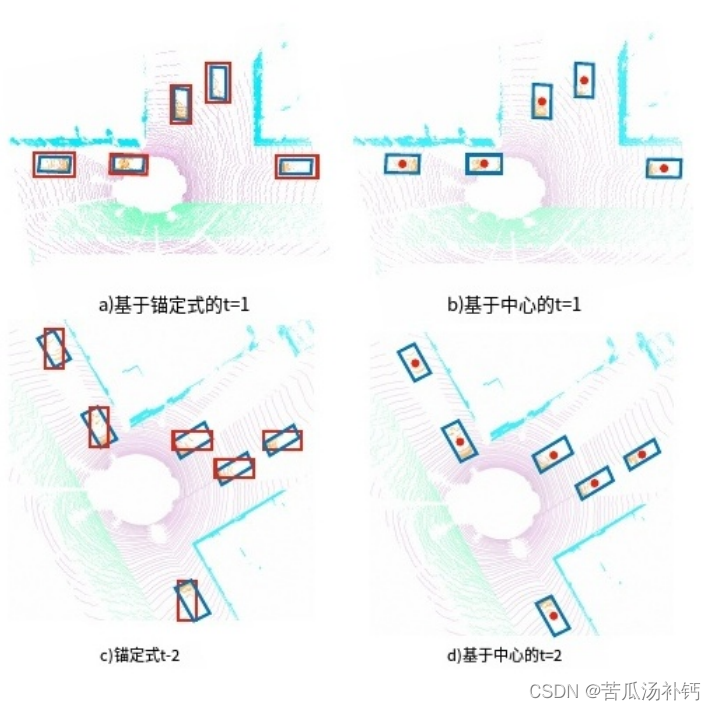

以前基于锚点的方法使用相对于自我-车辆坐标的轴对齐锚点当车辆在直线道路上行驶时,基于锚点(红框)和基于中心(红点)的方法都可以准确地检测到物体(上图)。然而,在安全关键的左转期间(下图),基于锚点的方法难以将轴对齐的边界框拟合到旋转的物体上。基于中心的模型通过旋转不变量点精确地检测物体。

两阶段3D检测器,CenterPoint,使用关键点探测器(keypoint detector)寻找物体及其属性,第二阶段改进所有估计。 具体而言,CenterPoint使用一个标准的基于激光雷达的骨干网络,即Voxel-net或PointPillars,以构建输入点云的表示。然后,它将这种表示扁平化为一个架空地图视图,并使用标准的基于图像的键点检测器来查找对象中心。对于每个被检测到的中心,它会从中心位置的点特征回归到所有其他对象属性,如3D大小、方向和速度。此外,使用轻量级的第二阶段来细化对象位置。这第二阶段在估计的物体3D边界框的每个面的3D中心提取点特征。它恢复了由于步幅和有限的接受野而丢失的局部几何信息,并以较小的代价带来了不错的性能提升。

优点:

基于中心的表示有几个关键的优点:

- 首先,与边界框不同,点没有内在的方向。这大大减少了对象检测器的搜索空间,并允许骨干学习对象的旋转不变性和等效性。

- 其次,基于中心的表示简化了跟踪等下游任务。如果对象是点,轨迹就是空间和时间上的路径。CenterPoint预测对象在连续帧之间的相对偏移量(速度),并贪婪地链接对象。

- 第三,基于点的特征提取使我们能够设计一个有效的两阶段细化模块,其速度比之前的方法快得多。

CenterPoint在nuScenes的3D检测和跟踪基准测试中取得了最先进的性能,单个模型的NDS为65.5,AMOTA为63.8。在Waymo开放数据集上,CenterPoint的性能大大优于之前所有的单一模型方法,在所有仅使用激光雷达的提交中排名第一。对车辆和行人的跟踪分别达到了59.4和56.6级2 MOTA,比以前的方法提高了50%。端到端3D检测和跟踪系统几乎实时运行,Waymo上的FPS为11 FPS,nuScenes上为16 FPS。

二、相关工作

2D目标检测从图像输入中预测轴边化的边界框。RCNN家族找到一个与类别无关的边界框候选,然后对其进行分类和细化。YOLO、SSD和RetinaNet直接找到一个特定类别的候选框,回避了后期的分类和细化。基于中心的检测器,如CenterNet或CenterTrack,直接检测隐式对象中心点,而不需要候选框。许多3D检测器就是从这些2D检测器进化而来的。CenterPoint证明了基于中心的表示是3D应用的理想选择。

3D对象检测旨在预测三维旋转的边界。它们不同于输入编码器上的2D检测器。Vote3Deep利用以特征为中心的投票在等间隔的3D体素上有效地处理稀疏的3D点云。Vox-elNet使用每个体素内的PointNet来生成统一的特征表示,具有3D稀疏卷积和2D卷积的头部从中产生检测。SECOND简化了VoxelNet并加速了稀疏的3D卷积。PIXOR将所有点投影到具有3D占用率和点强度信息的2D特征地图上,以去除昂贵的3D卷积。PointPillars用柱子表示取代了所有体素计算,每个地图位置有一个高的细长体素,提高了主干效率。MVF和pillar -od结合多个视图特征来学习更有效的支柱表示。CenterPoint的贡献集中在输出表示上,并且与任何3D编码器兼容,并且可以对它们全部进行改进。

VoteNet通过投票聚类-使用点特征采样和分组来检测对象。相比之下,我们直接通过中心点的特征回归到3D边界框,而不需要投票。Wong等人和Chen等人在物体中心区域(即点锚点)使用了类似的多点表示,并回归到其他属性。我们对每个对象使用单个正单元格,并使用关键点估计损失。

两阶段3D物体检测。最近的工作考虑直接将RCNN风格的2D检测器应用于3D do-main。其中大多数使用基于pointnet的点或体素特征提取器,应用RoIPool或RoIAlign来聚合3D空间中特定于roi的特征。这些方法从3D Lidar测量(点和体素)中提取区域特征,由于大量点导致运行时间过高。相反,我们从中间特征图中提取5个表面中心点的稀疏特征。这使得我们的第二阶段非常高效,并且保持了有效性。

3D对象跟踪。许多2D跟踪算法很容易跟踪开箱即用的3D物体。然而,基于3D卡尔曼滤波器的专用3D跟踪器仍然具有优势,因为它们更好地利用了场景中的三维运动。在这里,我们采用了一种遵循CenterTrack的简单得多的方法。我们使用速度估计和基于点的检测来通过多帧跟踪物体的中心。这个跟踪器更快,而且 三维对象跟踪许多2D跟踪算法很容易跟踪开箱即用的3D物体。然而,基于3D卡尔曼滤波器的专用3D跟踪器仍然具有优势,因为它们更好地利用了场景中的三维运动。在这里,我们采用了一种遵循CenterTrack的简单得多的方法.我们使用速度估计和基于点的检测来通过多帧跟踪物体的中心。这个跟踪器更快,而且比专用3D跟踪器更准确。

三、Preliminaries

2D CenterNet将目标检测重新表述为关键点估计。它接受一个输入图像,并为K类中的每个类预测一个w ×h热图。输出热图中的每个局部最大值(即值大于其8个邻居的像素)对应于被检测对象的中心。为了检索一个2D检测框,CenterNet回归到所有类别之间共享的尺寸图 size-map。对于每个检测对象, size-map将其宽度和高度存储在中心位置。CenterNet架构使用标准的全卷积图像主干,并在顶部添加密集的预测头部。在训练期间,CenterNet学习在每个带注释的对象中心qi为每个类ci∈{1…K},并回归到标注的边界框中心的对象大小S。为了弥补骨干架构跨步引入的量化误差,CenterNet还回归到局部偏移量。

在测试时,检测器生成K热图和密集的类不可知回归图。热图中的每个局部最大值(峰值)对应一个对象,置信度与峰值处的热图值成正比。对于每一个检测到的物体,探测器在相应的峰值位置从回归图中检索所有回归值。根据应用领域的不同,可能需要非极大值抑制(Non-Maxima suppression,NMS)。

3D检测设P=(x,y,z,r)i})是三维位置(x,y,z)和反射率r测量值的无序点云。3D目标检测旨在从该点云的鸟瞰图中预测一组3D目标边界框B={(DK)。每个边界框b=(u,v,d,w,l,h,a)由一个相对于物体地平面的中心位置(u,v,d)和3D尺寸(w,l,h)以及用偏航角α表示的旋转组成。在不损失一般性的情况下,我们使用一个以自我为中心的坐标系,传感器位于(0,0,0),偏航角=0。

现代3D物体探测器使用3D编码器将点云量化为规则的框。然后,一个基于点的网络为一个框内的所有点提取特征。然后3D编码器将这些特征汇集到其主要特征表示中。大部分计算发生在骨干网络中,骨干网络仅对这些量化和池化的特征表示进行操作。骨干网的输出是一个宽度为W,长度为L的map-viewfeature-map MCR WXL×F,在一个map-view参考框架中有F个通道。宽度和高度都直接关系到单个体素箱的分辨率和骨干网的跨步。常见的骨干网包括VoxelNet和PointPillars。

使用地图-视图特征图M,检测头,最常见的是一或两阶段边界盒检测器,然后从锚定在此开销特征图上的一些预定义边界盒中产生目标检测。由于3D边界盒具有各种尺寸和方向,基于锚点的3D检测器难以将轴对齐的2D盒拟合到3D对象上。此外,在训练过程中,以前基于锚点的3D检测器依赖于2D Box loU进行目标分配,这为不同类别或不同数据集选择正/负阈值带来了不必要的负担。在下一节中,我们将展示如何基于点表示构建原则;性的3D物体检测和跟踪模型。我们引入了一种新颖的基于中心的检测头,但依赖于现有的3D骨干(VoxelNet或PointPillars)。

四、 CenterPoint

下图展示了CenterPoint模型的整体框架。设M∈RW×HXF为3D骨架的输出。CenterPoint的第一阶段预测类特定的热图、对象大小、子体素位置细化、旋转和速度。所有的输出都是密集的预测。

我们的CenterPoint框架概述。我们依赖于一个标准的3D主干,它从激光雷达点云中提取地图视图特征表示。然后,一个2DCNN架构检测头找到物体中心,并使用中心特征回归到完整的3D边界盒。从这个框预测中,我们在估计的3D边界框的每个面的3D中心提取点特征,并将它们传递到MLP中,以预测iou引导的置信度评分和框回归细化。以彩色观看效果最佳。

Center heatmap head.其目标是在任何被检测物体的中心位置产生一个热图峰值。这个头产生一个K通道热图Y',K个类各一个通道。在训练过程中,它的目标是一个2D高斯图,它是由标注的绑定框的3D中心投影到地图视图中产生的。我们使用焦点损失。自上而下的地图视图中的对象比图像中的对象更稀疏。在地图视图中,距离是绝对的,而图像视图通过透视来扭曲它们。考虑一个道路场景,在地图视图中,车辆占用的区域很小,但在图像视图中,几个大物体可能占据了大部分屏幕。此外,透视投影中深度维度的压缩自然会使图像视图中的物体中心彼此离得更近。遵循CenterNet的标准监督会产生非常稀疏的监督信号,其中大多数位置被认为是背景。为了抵消这种影响,我们通过扩大在每个地面真值对象中心呈现的高斯峰值来增加对目标热图Y的正监督。具体来说,我们将高斯半径设置为o= max(f(wl),T),其中t=2是允许的最小高斯半径,f是在CornerNet中定义的半径函数。这样,CenterPoint保持了基于中心的目标分配的简洁性;模型从附近的像素获得更密集的监督。

Regression heads.我们在对象的中心特征处存储了几个对象属性:子体素位置细化o∈R,地面高度h,∈R, 3D尺寸s∈R3,以及一个偏摆旋转角度(sin(a),,cos(a))E[-1,1]-2子体素位置细化o减少了骨干网体素化和跨行化带来的量化误差。地面上的高度h,有助于在3D中定位物体,并添加地图视图投影去除的缺失高程信息。方向预测使用横摆角的正弦和余弦作为连续回归目标。结合盒大小,这些回归头提供了3D包围框的完整状态信息。每个输出都使用自己的头部。我们在地面真相中心位置使用L1损失来训练所有输出。我们回归到对数大小,以更好地处理各种形状的框。在推理时,我们通过索引到每个对象峰值位置的密集回归头输出来提取所有属性。

速度头和跟踪。为了通过时间跟踪物体,我们学习预测每个检测到的物体的二维速度估计v∈R3作为额外的回归输出。速度估计需要时序点云序列。在我们的实现中,我们将前一帧中的点转换并合并到当前参考帧中,并通过时间差(速度)归一化来预测当前帧与过去帧之间物体位置的差异。与其他回归目标一样,速度估计也使用当前时间步长地面真实物体位置的L1损失进行监督。

在推理时,我们使用这个偏移量以贪婪匹配的方式将当前检测与过去的检测相关联。具体来说,我们通过应用负速度估计将当前帧中的物体中心投影回前一帧,然后通过最接近距离匹配将它们与跟踪的物体进行匹配。按照SORT,我们将未匹配的轨迹保留到T=3帧,然后再删除它们。我们用其最后已知的速度估计更新每个不匹配的轨道。详细的跟踪算法图见补编。

CenterPoint将所有热图和回归损失合并到一个共同目标中,并对其进行联合优化。它简化和改进了以前基于锚点的3D探测器。然而,所有的物体属性目前都是从物体的中心特征中推断出来的,这可能不包含足够的信息来进行精确的物体定位。例如,在自动驾驶中,传感器通常只看到物体的侧面,而看不到物体的中心。接下来,我们通过使用轻量级点特征提取器的第二个细化阶段来改进CenterPoint。

4.1. Two-Stage CenterPoint

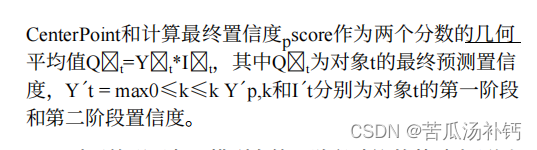

我们使用未修改的CenterPoint作为第一阶段。第二阶段从主干的输出中提取额外的点特征。我们从预测的边界框的每个面的3D中心提取一个点特征。注意,在地图视图中,边界框中心、顶部和底部的面中心都投射到同一个点上。因此,我们只考虑四个向外的盒面和预测的对象中心。对于每个点,我们使用双线性插值从主干地图视图输出m中提取一个特征。接下来,我们将提取的点特征连接起来,并通过MLP传递它们。第二阶段在单阶段CenterPoint的预测结果之上预测一个类别不可知论的置信度得分和盒细化。

对于类不可知论置信度分数预测,我们遵循,并使用由盒子的3D IoU和相应的地面真值边界框引导的分数目标I:

![]()

其中IoUt为第t个建议框与基础真值之间的IoU。我们使用二值交叉嫡损失进行训练:

其中It为预测置信度得分。在推理过程中,我们直接便用单阶段的类预测。

对于箱形回归,模型在第一阶段建议的基础上预测一个细化,我们用L1损失训练模型。我们的两阶段CenterPoint简化并加速了之前使用昂贵的基于pointnet的特征提取器和RoIAlign操作的两阶段3D检测器。

4.2. Architecture

所有第一阶段输出共享前3个×3卷积层、BatchNormalization和ReLU。然后,每个输出使用由批范数和ReLU分隔的两个3×3卷积的自己的分支。我们的第二阶段使用共享的两层MLP,其中有批范数、ReLU和Dropout,下降率为0.3,然后使用单独的三层MLP进行置信度预测和箱回归。

五、实验

我们在Waymo开放数据集和nuScenes数据集上评估CenterPoint。我们使用两个3D编码器实现CenterPoint:VoxelNet和 PointPillars,分别称为CenterPoint- voxel和CenterPoint- pillar。

Waymo开放数据集。Waymo开放数据集包含798个车辆和行人的训练序列和202个验证序列。点云包含64车道的激光雷达,每0.1s对应180k个点。官方的3D探测评估指标包括3D边界盒平均精度(mAP)和头部精度加权的mAP(mAPH)。mAP和mAPH基于IoU阈值,车辆为0.7,行人为0.5。对于3D跟踪,官方的指标是多目标跟踪精度(MOTA)和多目标跟踪精度(MOTP)。官方评估工具包还提供了两个难度级别的性能细分:1级用于超过5个激光雷达点的盒子,2级用于至少有一个激光雷达点的盒子。

我们的Waymo模型对X轴和Y轴使用的检测距离为[-75.2,75.2],对Z轴使用的检测距离为[-2m, 4m]oCenterPoint-Voxel使用(0.1m, 0.1m, 0.15m)体素大小遵循PV-RCNN,而CenterPoint-Pillar使用(0.32m, 0.32m)的网格大小。

- PV-RCNN: 一种高性能3D对象检测框架,名为PointVoxel-RCNN(PV-RCNN),用于从点云中进行精确的3D对象检测。

nuScenes数据集。nuScenes包含1000个驾驶序列,分别有700、150、150个序列用于训练、验证和测试。每个序列大约有20秒长,激光雷达频率为20 FPS。该数据集为每个Lidar帧提供校准过的车辆姿态信息,但每10帧(0.5s)才提供框注释。nuScenes使用32车道激光雷达,每帧产生大约30k个点。总共有28k、6k、6k的标注帧,分别用于训练、验证和测试。注释包括10个具有长尾分布的类。官方的评价指标是各类之间的平均值。对于3D检测,主要指标是mean Average Precision (mAP)和nuScenesdetection score (NDS)。mAP使用鸟瞰中心距离<0.5m, 1m,2m, 4m代替标准的盒重叠。NDS是mAP和其他属性度量的加权平均值,包括平移、比例、方向、速度和其他框属性。在我们的测试集提交后,nuScenes团队增加了一个新的神经规划度量(PKL)。PKL度量基于规划者路线(使用3D检测)的KL散度和地面真相轨迹来衡量3D物体检测对下行自主驾驶任务的影响。因此,我们还报告了在测试集上评估的所有方法的PKL度量。

对于3D跟踪,nuScenes使用AMOTA,它会惩罚ID切换、假阳性和假阴性在各种召回阈值上的平均值。

对于nuScenes的实验,我们将X轴和Y轴的检测范围设置为[- 51.2m, 51.2m],Z轴的检测范围设置为[- 5m,3m]。CenterPoint-Voxel使用(0.1m, 0.1m, 0.2m)体素大小,CenterPoint-Pillars使用(0.2m, 0.2m)网格。

Training and Inference。我们使用与之前作品相同的网络设计和训练时间表。详细的超参数参见补编。在两阶段CenterPoint的训练过程中,我们从第一阶段预测中随机抽取了128个正负比为1:1的盒子。如果提案与至少0.55 IoU的基础真值注释重叠,则提案是正的。在推理过程中,我们在Non-Maxima Suppression (NMS)之后的前500个预测上运行第二阶段。推理时间是在Intel酷睿i7CPU和Titan RTX GPU上测量的。

5.1主要结果

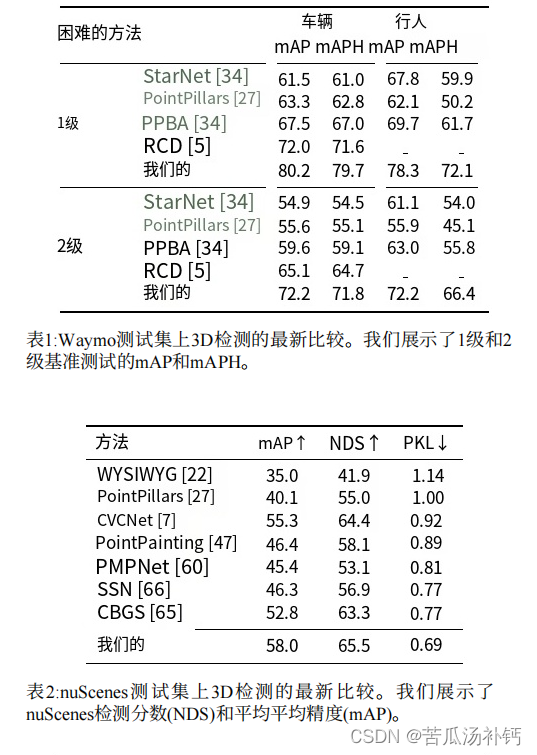

我们首先在Waymo和nuScenes的测试集上展示我们的3D检测结果。这两个结果都使用了单个CenterPoint-Voxel模型。表1和表2总结了我们的结果。在Waymo测试集上,我们的模型在车辆检测方面达到了71.8级2 mAPH,在行人检测方面达到了66.4级2 mAPH,比以前的方法高出了7.1%的车辆mAPH和10.6%的行人mAPH。在nuScenes(表2)上,我们的模型在多尺度输入和多模型集成的情况下,以5.2%的mAP和2.2%的NDS优于去年挑战赛冠军CBGS。我们的模型也快得多,如后面所示。补充材料按类别进行了分类。我们的模型在所有类别中表现出一致的性能改进,并在小类别(交通锥为+5.6 mAP)和极端纵横比类别(自行车为+6.4 mAP,建筑车辆为+7.0 mAP)中表现出更显著的改进。更重要的是,我们的模型在神经平面度量(PKL)(组织者在提交排行榜后评估的隐藏度量)下显著优于所有其他提交的模型。这突出了我们框架的泛化能力。

3D跟踪 表3显示了CenterPoint在Waymo测试集上的跟踪性能。第4节中描述的基于速度的最近距离匹配显著优于Waymo论文中的官方跟踪基线,该论文使用基于卡尔曼滤波器的跟踪器。我们观察到车辆和行人跟踪的MOTA分别提高了19.4和18.9。在nuScene(表4)上,我们的框架比上一个挑战获胜者Chiu等人[10]的表现要好8.8 AMOTA。值得注意的是,我们的跟踪不需要单独的运动模型,并且在可忽略的时间内运行,即在检测之上1毫秒。4

5.2 消融研究

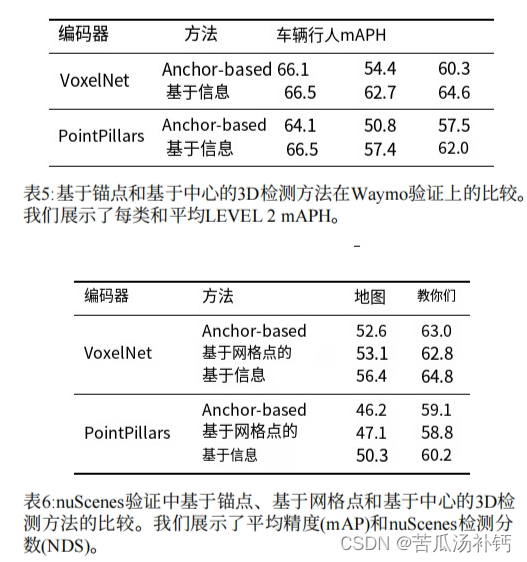

Center-based vs Anchor-based。我们首先将我们的基于中心的单阶段检测器与其基于锚的对应检测器进行比较。在Waymo上,我们遵循最先进的PV-RCNN设置锚超参数:我们在每个位置使用两个锚,分别为0°和90°;车辆的正/负IoU阈值设置为0.55/0.4,行人为0.5/0.35。在nuScenes上,我们遵循上一个挑战获胜者CBGS的锚点分配策略。所有其他参数与我们的CenterPoint模型相同。

如表5所示,在Waymo数据集上,只需从锚点切换到我们的中心,VoxelNet和PointPillars编码器的性能分别提高了4.3mAPH和4.5mAPH。在nuScenes(表6)上,CenterPoint在不同主干上提高了基于锚的对应物3.8-4.1mAP和1.1-1.8 NDS。为了了解改进的来源,我们进一步显示了Waymo验证集上基于目标大小和方向角度的不同子集的性能细分。

我们首先根据航向角将真值情况分为三个仓:0°至15°、15°至30°和30°至45°。该分配测试探测器检测旋转严重的框的性能,这对自动驾驶的安全部署至关重要。我们还将数据集分为三个部分:小、中、大,每个部分包含1/3的总体真值框。

表7和表8总结了结果。当长方体旋转或偏离平均长方体大小时,我们的基于中心的检测器比基于锚的基线性能要好得多,这证明了模型在检测目标时捕捉旋转和大小不变性的能力。这些结果令人信服地突出了使用基于点的3D目标表示的优势。

一阶段vs两阶段。在表9中,我们展示了在Waymo验证集中使用2D CNN特征的单阶段和两阶段CenterPoint模型之间的比较。具有多个中心特征的两阶段优化以较小的开销(6ms-7ms)大大提高了两个3D编码器的精度。我们还与RoIAlign(其在RoI中密集地采样6×6个点)进行了比较,我们基于中心的特征聚合实现了类似的性能,但更快更简单。

体素量化限制了两阶段CenterPoint对使用PointPillar进行行人检测的改进,因为行人通常只停留在模型输入中的1个像素中。

在我们的实验中,两阶段细化并没有带来对nuScene上的单阶段CenterPoint模型的改进。我们认为,原因是nuScenes数据集使用32线激光雷达,每帧产生约30k个激光雷达点,约为Waymo数据集中点数量的1/6,这限制了两阶段细化的潜在改进。在之前的两阶段方法中,如PointRCNN和PV-RCNN,也观察到了类似的结果。

不同特征组件的效果。在我们的两阶段CenterPoint模型中,我们只使用2D CNN特征地图中的特征。然而,先前的方法建议也利用体素特征进行第二阶段细化。这里,我们比较了两个体素特征提取基线:

径向基函数(RBF)插值。PointNet++和SA-SSD使用径向基函数来聚合三个最近的非空3D特征体积的网格点特征。

对于这两个基线,我们使用其官方实现将鸟瞰图特征与体素特征相结合。表10总结了结果。它表明,与文献中使用的体素特征相比,鸟瞰图特征足以获得良好的性能,同时效率更高。

为了与未对Waymo测试集进行评估的先前工作进行比较,我们还在表11中报告了Waymo验证集划分的结果。我们的模型在很大程度上优于所有已发布的方法,特别是对于level 2数据集的具有挑战性的行人类(+18.6 mAPH),其中框只包含一个激光雷达点。

3D跟踪。表12显示了nuScenes验证集的3D跟踪消融实验。我们与去年的挑战获胜者Chiu等人进行了比较,其使用基于mahalanobis距离的卡尔曼滤波器来关联CBGS的检测结果。我们将评估分解为检测器和跟踪器,以使比较严格。给定相同的检测目标,使用我们的基于简单速度的最近点距离匹配比基于卡尔曼滤波器的Mahalanobis距离匹配[10]的性能要好3.7 AMOTA(第1行对第3行,第2行对第4行)。

有两个改进的来源:

- 我们用学习点速度来建模物体运动,而不是用卡尔曼滤波器来建模三维边界框动态;

- 我们通过中心点距离来匹配目标,而不是通过框状态的Mahalanobis距离或3D边界框IoU。

更重要的是,我们的跟踪是一个简单的最近邻匹配,没有任何隐藏状态计算。这节省了3D卡尔曼滤波器的计算开销(73ms vs.1ms)。

六、总结

我们提出了一种基于中心的框架,用于从激光雷达点云进行同步3D目标检测和跟踪。我们的方法使用标准的3D点云编码器,头部有几个卷积层,产生鸟瞰热图和其他密集回归输出。检测是一种简单的带有细化的局部峰值提取,跟踪是一种最接近距离的匹配。CenterPoint很简单,接近实时,在Waymo和nuScenes的基准测试中达到了最先进的性能。

总结

本文仅仅简单翻译了CenterPoint这篇论文,而CenterPoint的实际使用还有待探索。

2556

2556

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?