来源:投稿 作者:gick

编辑:学姐

1.前言

最近,各大领域不断在自监督方向推出各种各样新的框架和范式,自监督方向俨然已经成为了学术界新的香饽饽。其中,对比学习不仅在CV取得了很多成果,也在NLP、推荐等领域大放异彩。在前不久结束的Recsys Challenge2022竞赛中,由用户交互序列为基础的图对比学习在召回方面取得了一定的效果,证明了图对比学习的有效性。

在图表示学习领域,对比学习一般只能用于结点级别或者图级别的的学习,本次我为大家介绍一篇统一了结点级别或者图级别对比学习、既可以结点的属性进行预测、又可以对图的结构进行预测的论文,2020年发表在ICML上的Contrastive Multi-View Representation Learning on Graphs 。

本文将图扩散与对比学习结合,提出了一种新的自学习架构,在线性分类规则下,在8个数据集上的下游任务达到了SOTA效果。即使你可能并不研究图领域方面的问题,但作者设计网络的思路依然非常值得借鉴与学习。

2.内容

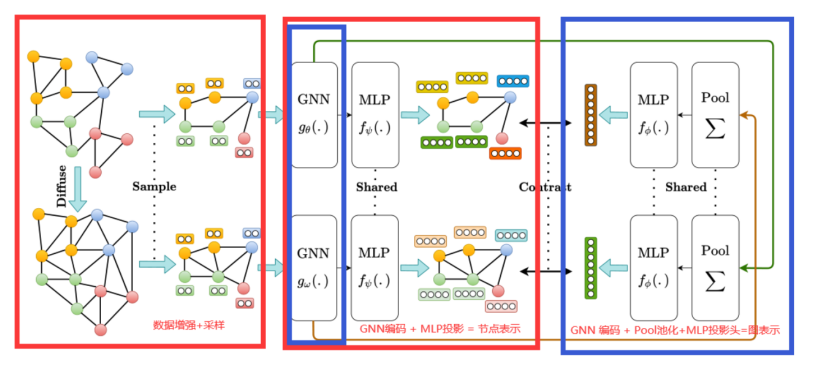

MVGRL的大致架构如下:

接下来我会从编码层、池化层、投影头以及目标函数四个方面为大家梳理这一模型。

编码

结点表示由专门编码器(GNN)以及两层隐藏层 MLP 投影头在训练集上学习得到。

图表示由专门编码器(GNN)、池化(Readout函数)以及两层隐藏层 MLP 投影头在训练集上学习得到。

两种数据增强视图视称为alpha view和beta view。

池化

池化是将图信息从所有结点信息中进行提取的层,它可以是各种单射函数,如MLP头、平均头等。本论文作者在论文中提出为拼接所有结点embedding后通过激活层输出,但是在代码实现中直接使用了平均头,即对所有结点的embedding进行简单平均,事实证明结果差异不大。

投影头

由于结点embedding与图embedding未必在同一向量空间,所以需要设计一个投影头将两者投影到同一向量空间之上。本论文中,投影头是一个两层前馈神经网络(MLP)。

目标函数

最后值得一提的是目标函数。本文的目标函数设计的非常巧妙,对比的是同一子图g,在不同增强alpha 、beta下的结点表示和图表示,使结点表示和图表示的互信息最大化。

最后放上算法流程图,实现步骤如上述:

3.思考

这篇论文的核心创新点就是跨视图对比能获得更好的效果。“跨”、“交叉”、“融合”这些词往往是非常好的创新点,不仅在学术界中非常受欢迎,在各类竞赛中也往往是榜单大杀器。如果能效仿这篇文章的创新思路,在自己的领域融合不同前沿思路,往往也能做出非常好的结果。

本次的论文分享就到这里了,更详细的消融试验结果可以下载原论文查看。希望大家从本论文的思路中可以提炼出有帮助的信息,并成功应用在自己的研究领域。

关注下方《学姐带你玩AI》🚀🚀🚀

回复“500”免费领取220+篇AI必读论文PDF

还有更多干货福利等你哦~

码字不易,欢迎大家点赞评论收藏!

203

203

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?