ModernTCN,时间序列领域一种现代纯卷积结构,获得了ICLR 2024时序领域论文最高分。相比主流方法,它在保持性能的同时实现了更高的效率。

ModernTCN是一种基于CNN的时间序列方法,这类方法在捕捉非线性和长期依赖关系上占据优势,能更有效地处理复杂时序数据,帮助我们实现高效并行计算,提升速度效率,轻松应对不同类型的时序问题。

因此,这类方法也是当前时序领域的一个热门研究方向,而且没有基于Transformer和基于MLP的那么卷,是个相对容易发表高质量论文的好方向。

本文挑选了9个基于CNN的时间序列最新成果,可借鉴的方法和创新点我做了简单介绍,原文以及相应代码都整理了,方便有论文需求的同学学习。

论文原文+开源代码需要的同学看文末

ModernTCN: A Modern Pure Convolution Structure for General Time Series Analysis

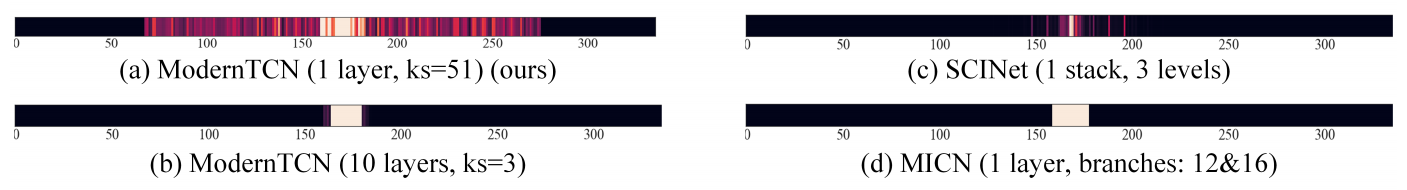

方法:论文研究了如何更好地使用卷积在时间序列分析中,并通过现代化卷积技术提出了ModernTCN模型,该模型在时间序列分析任务中取得了与Transformer和MLP模型相媲美的性能,同时保持了卷积模型的高效性能,并揭示了ModernTCN具有更大的有效感受野,能够更好地发挥卷积在时间序列分析中的潜力。

创新点:

-

作者提出现代时间卷积网络(ModernTCN),它对传统结构进行修改以捕捉时间序列依赖关系,包括一个解耦的 ConvFFN 模块和一个跨变量组件(ConvFFN2),该模型在时间序列分析任务中表现出色且效率高。

-

作者通过消融研究表明,在时间序列分析中保持变量维度很重要,丢弃变量维度会导致性能下降。

TimesNet: Temporal 2D-Variation Modeling for General Time Series Analysis

方法:论文提出了一种基于CNN的方法来进行时间序列分析,但与传统的1D CNN不同,它通过将时间序列数据转换到2D空间,并使用2D卷积核来捕捉时间序列的复杂变化模式。TimesNet结合了CNN的强大表示能力和时间序列分析中对周期性和变化模式的捕捉,是一个创新的时间序列分析框架。

创新点:

-

通过将一维时间序列转化为二维张量,将复杂的时间变化转化为多个周期内和周期间的变化,从而提出了一种新颖的时间序列分析方法。

-

TimesNet模型使用TimesBlock作为任务通用的骨干网络,可以自适应地发现多周期性并从转换后的二维张量中提取复杂的时间变化。

-

在五个主流的时间序列分析任务中,包括长期和短期预测、插补、分类和异常检测,TimesNet模型取得了一致的最先进性能。

A Data Filling Methodology for Time Series Based on CNN and (Bi)LSTM Neural Networks

方法:本文提出的两个深度学习模型基于CNN和LSTM网络,用于填充监测公寓内部温度时间序列中的数据缺失。这两个模型都能够很好地捕捉数据的波动性,并展现出良好的重构目标时间序列的能力。

创新点:

-

第一个模型由两个相同结构的深度学习网络组成,分别是CNN-LSTM-Onwards和CNN-LSTM-Backwards,它们在训练中分别使用了正序和反序的时间序列。

-

第二个模型是一个包含CNN和双向LSTM层的单一网络,称为CNN-BiLSTM。

-

本文还提出了一种新的数据填充方法,通过将前向和后向预测相结合,利用更多的信息来填充数据缺失。

CNN KERNELS CAN BE THE BEST SHAPELETS

方法:论文提出了一种结合卷积神经网络(CNN)和形状(shapelets)的时间序列建模方法。ShapeConv核心思想是将形状(shapelets)的概念整合到CNN的卷积核中,以此来提高时间序列建模的可解释性,同时保持CNN的性能优势。

创新点:

-

ShapeConv是一种可解释的卷积神经网络(CNN)层,其卷积核作为shapelets,有效地解决了时间序列建模的挑战。

-

ShapeConv通过引入形状正则化和多样性正则化,强制相似性以提高解释性,并通过不同的初始化策略将人类先验知识注入模型,提高模型性能。

-

ShapeConv在监督分类和无监督聚类任务中的实验结果表明,它在保持解释性的同时具有优越的性能,优于其他基于学习的shapelet方法和当代的深度模型。

关注下方《学姐带你玩AI》🚀🚀🚀

回复“CNN时序”获取全部论文+开源代码

码字不易,欢迎大家点赞评论收藏

1636

1636

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?