最近大🔥的法律大模型Chatlaw成功出道,在法律领域超过GPT-4。

现在看一下他们的技术报告:ChatLaw: Open-Source Legal Large Language Model with Integrated External Knowledge Bases,给大家以LLM+外部知识库构建领域模型提供参考思路。

论文地址:https://arxiv.org/pdf/2306.16092.pdf

代码:https://github.com/PKU-YuanGroup/ChatLaw

1. Motivation

在人工智能领域,大模型的开发已经渗透到各行各业,这些模型已经证明了它们在处理复杂任务和产生有价值的见解方面的效用和影响。然而,法律领域,由于其固有的重要性和对准确性的要求,是一个需要专门研究和发展专门法律模式的领域。

2. Contribution

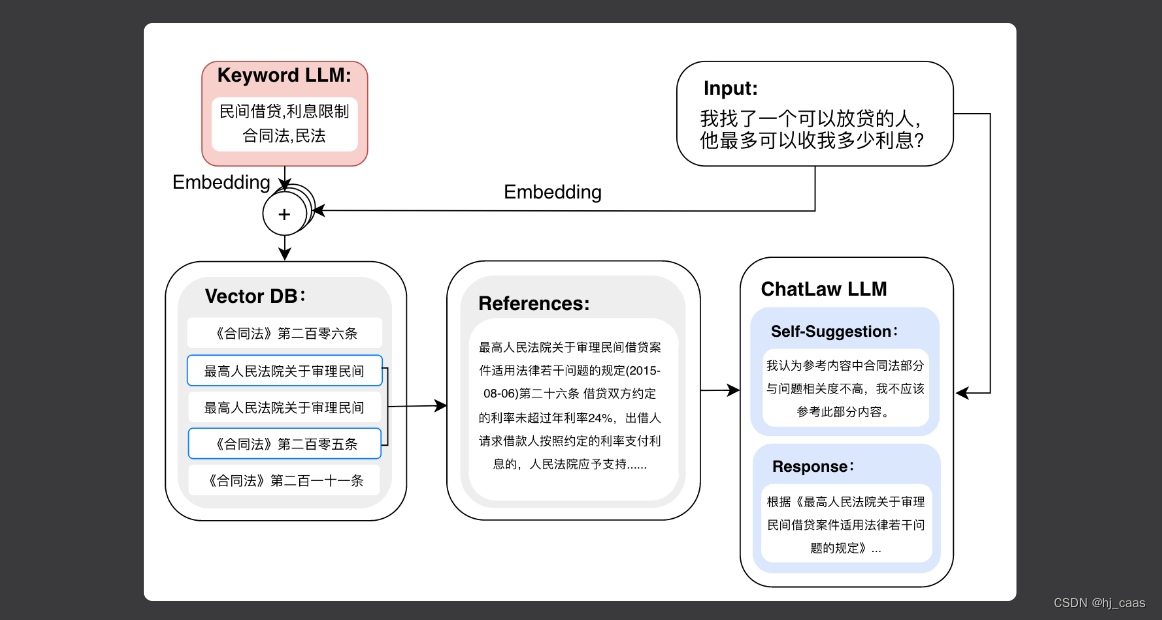

① 减小幻觉的有效办法: 提出了一种解决幻觉的方法,通过增强模型的训练过程,并在推理过程中加入四个模块: “consult,” “reference”, “self-suggestion” 和 “response” 四个模块。通过参考模块集成垂直模型和知识库,将特定领域知识注入到模型中,利用知识库中的准确信息减少幻觉的发生。

② 基于LLM的法律特征词抽取模型:训练了一个从用户日常语言中抽取法律特征词的模型。该模型识别具有法律意义的单词,从而能够有效地识别和分析用户输入中的法律上下文。

③ 基于BERT的法律文本相似度计算模型:训练了一个模型来测量用户日常语言与包含930,000个相关法律案例数据集之间的文本相似度。这能够创建一个矢量数据库,以便有效地检索相似的法律文本,促进进一步的分析和参考。

④ 构建中文法律考试测试数据集:设计了一个专门用于测试中文法律领域知识的数据集。此外,还设计了一个ELO 竞技场评分机制来比较不同模型在法律选择题中的表现。

3. Method

Keyword LLM:从用户输入中抽取法律行业关键词,用于检索知识库中的法律知识,主要为了改善语义检索的效果。关键词抽取模型思路来源于https://huggingface.co/JessyTsu1/comment_opinion_extract_ChatGLM_base、https://arxiv.org/pdf/2305.14742.pdf。

Law LLM:训练的法律领域的BERT embedding模型,将文本转化为向量结合关键词进行知识检索。Hugging face: https://huggingface.co/chestnutlzj/ChatLaw-Text2Vec。

ChatLaw LLM:对检索出来的结果进行分析,提取关键内容,过滤不相关内容,最终生成相关回复。

除此之外,本文注重数据集的构建,包括数据规模、数据质量、任务相关类型数据,还引入self-suggestion让模型进行思考,降低幻觉。

4. 细节

4.1 基座模型和微调方法

基座模型:Ziya-LLaMA-13B-v1、Anima-33B。

微调方法:Lora

4.2 检索算法

检索算法:首先使用关键词抽取模型从用户输入中抽取关键词,然后将每个关键词输入到BERT嵌入模型中,得到N个关键词向量。将用户输入的文本输入到Bert embedding中得到向量s,将每个关键词向量与s进行计算,然后通过计算cosine相似度得到TOPK个知识。

这里将关键词向量与输入文本向量s分别归一化再相加,奇怪,这表达什么意思呢????

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-pmxnS8lu-1689648044557)(/static/uploads/2023/7/10/ca553dc9435b6cdfcf247c75b2f35c7c.png)]](https://img-blog.csdnimg.cn/c766595718824f3eb442ba38ea78da52.png)

4.3 数据集的构建

- 收集大量原始法律数据。这包括收集法律新闻、社交媒体内容和来自法律行业论坛的讨论。这些来源提供了各种现实世界的法律文本,提供了对各种法律主题和讨论的见解。

- 基于法律法规和司法解释的构建数据。为了确保法律知识的全面覆盖,我们将相关法律法规和司法解释纳入数据集。这确保了数据集反映法律框架,并提供准确和最新的信息。

- 从网络上爬取真实的法律咨询数据。我们检索真实的法律咨询数据,利用现有的法律咨询数据集。这使人们能够包含用户通常遇到的现实世界的法律场景和问题,用实际的法律示例丰富数据集。

- 构建律师考试的多项选择题。创建了一套专门为律师考试设计的多项选择题。这些问题涵盖了各种法律主题,并测试了用户对法律原则的理解和应用。

总结:

1)整合不同来源的数据,数据集涵盖了广泛的法律数据,确保开发的模型能够有效地理解和解决各种法律场景。

2)经过严格的清理过程。过滤掉简短和不连贯的回复,确保只包含高质量和有意义的文本。

3)为了增强数据集,利用ChatGPT API进行辅助构建,根据现有数据集生成补充数据。

5. Conclusion

- 在2000条司法问答数据上,包括GPT4在内的各大模型,效果都还比较差。

- Elo评分机制下,本文提出的方法已经超过了GPT4,其中构建了类似于国家司法考试的多项选择题来训练本文的模型,是其在2000条数据上超过GPT4的重要原因之一。

- 局限性: 基于Ziya-LLaMA-13B-v1训练的模型,中文各项表现很好,但是逻辑复杂的法律问答效果不佳,需要用更大参数的模型来解决。基于Anima-33B训练的模型,逻辑推理能力大幅提升,但是因为Anima的中文语料过少,导致问答时常会出现英文数据。

6. 小结

- 关键词+向量检索相结合的检索方法值得学习

- 引入self-suggestion模块减少噪音值得参考

向量检索对于LLM+外部知识库非常重要,可以将参考分成title+content,其中title尽可能的简化以此来减小噪音,这样将会提高检索的准确率。

Reference

- https://www.writebug.com/article/4ec3b756-1f1c-11ee-ad3c-0242ac1b000f

2228

2228

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?