任意风格转移和领域泛化的精确特征分布匹配

文章目录

Abstract

任意风格转移(Arbitrary style transfer,AST)和领域泛化(domain generalization,DG)是重要而具有挑战性的视觉学习任务,可以被看作是一个特征分布匹配问题。在高斯特征分布的假设下,传统的特征分布匹配方法通常与特征的平均值和标准差相匹配。然而,现实世界数据的特征分布通常比高斯分布复杂得多,仅使用一阶和二阶统计量是无法准确匹配的,而使用高阶统计量进行分布匹配在计算上是很困难的。在这项工作中,我们首次提出通过精确匹配图像特征的经验累积分布函数(empirical Cumulative

Distribution Functionse,CDFs)来进行精确特征分布匹配( Exact Feature Distribution Matching,EFDM),这可以通过在图像特征空间应用精确直方图匹配(Exact Histogram Matching,EHM)来实现。特别是,我们采用了一种快速的EHM算法,名为 “排序匹配”,以即插即用的方式执行EFDM,成本很小。我们提出的EFDM方法的有效性在各种AST和DG任务上得到了验证,展示了最先进的新成果。

1. 绪论

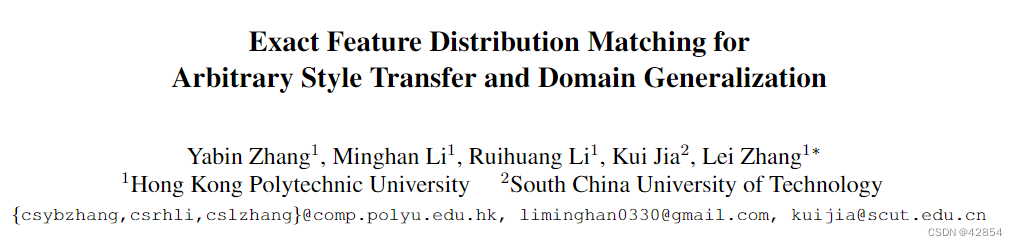

分布匹配是一个长期存在的统计学习问题[39]。随着深度模型的普及[20, 27],深度特征的分布匹配因其在解决复杂视觉任务中的有效性而受到越来越多的关注。例如,在任意风格转移(AST)[12, 21]中,图像风格可以被解释为特征分布,风格转移可以通过交叉分布特征匹配来实现[25, 34]。此外,通过使用风格转移技术来增加训练数据,我们可以解决领域泛化(DG)任务[13, 72],其目标是将在一些源领域学到的模型推广到其他未见过的领域。最流行的特征分布匹配方法是通过假设特征服从高斯分布来匹配特征的平均值和标准差[21(AdaIN), 32, 37, 41, 72]。不幸的是,现实世界数据的特征分布通常过于复杂,无法用高斯分布来建模,如图1所示。因此,只使用平均数和标准差的特征分布匹配是不准确的。因此,我们需要找到更有效的方法来实现更准确甚至是精确的特征分布匹配(EFDM)。

图1. 随机选择的通道中特征值的直方图,其中特征是由在四个领域的数据集[28]上训练的ResNet-18[20]的第一个残差块计算出来的。我们首先将每个通道的平均值和标准差分别归一化为0和1,然后在每个域的所有测试样本中收集特征值进行可视化。人们可以清楚地看到,现实世界数据的特征分布通常过于复杂,无法用高斯建模。

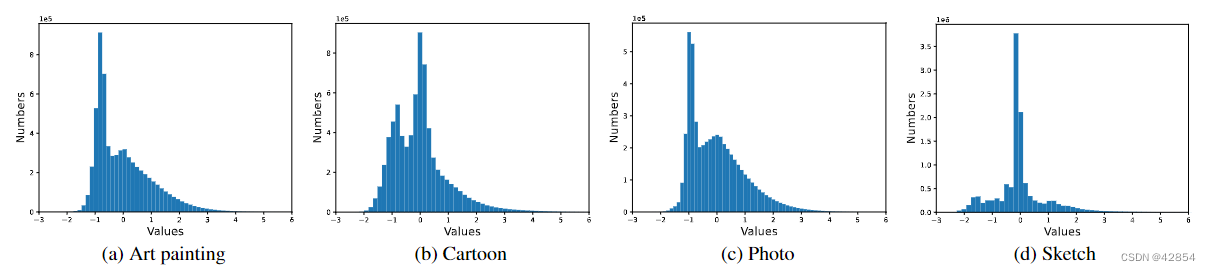

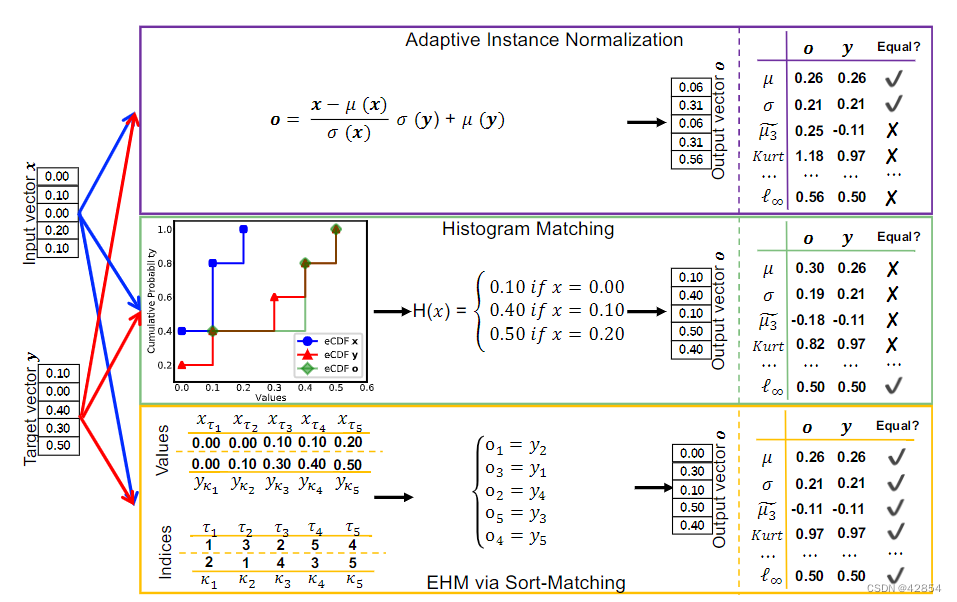

直观地说,EFDM可以通过匹配特征的高阶统计量来完成。实际上,在[25, 63]中已经明确引入了高阶中心矩(high-order central moments),以更精确地匹配分布。然而,以这种方式考虑高阶统计将引入密集的运算开销。此外,EFDM在理论上只能通过匹配无限阶的中心矩来实现[63],这在实践中是难以实现的。在Glivenko-Cantelli定理[54]的推动下,Risser等人[46]引入了经典的直方图匹配(Histogram Matching,HM)[16, 58]方法作为辅助测量,以最小化特征分布发散。遗憾的是,HM只能在输入中存在等效特征值时近似匹配eCDFs,因为HM将等效值合并为一个点并进行逐点变换。(图2是一个玩具的例子)。这种情况通常发生在整数值为零的数字图像上(例如,8位数字图像)。对于深度模型生成的特征,由于其对离散图像像素的依赖和激活函数的使用,例如ReLU[42]和ReLU6[26],等效的特征值也是不可避免的(更多细节请参考图3)。所有这些事实阻碍了通过HM进行EFDM的有效性。

图2. AdaIN、HM和通过排序匹配的EHM在一个玩具例子中进行了比较,数值精度被四舍五入到0.01的水平。AdaIN只匹配输出向量o和目标向量y之间的平均数和标准差。尽管HM将o的eCDF近似于y的eCDF,但它们并不完全匹配,导致分布不匹配,从而导致统计数据不匹配。通过排序匹配的EHM与o和y的eCDF完全匹配,导致分布完全匹配,因此统计量也完全匹配。μ,σ,~μ3,Kurt和ℓ∞分别表示平均值、标准差、第三标准化矩-偏度[24,60]、第四标准化矩-偏度[24,59]和无限准则。

图3. 在分辨率为224×224的输入图像中,ResNet18特征图的等值百分比(即所有数值的等值数*100)的说明。1st conv’代表第一个卷积层的输出。‘第1块’、‘第2块’、'第3块’和’第4块’分别表示第1、第2、第3和第4个剩余块的输出。'ReLU’和’PReLU’分别表示具有ReLU[42]和PReLU[19]激活函数的vanilla ResNet18。百分比取决于表示特征值的比特数和特征图的大小。在原始图像像素空间中,百分比接近100%,因为像素被量化为8位。在浮动数(32位)的特征空间中,由于较深的区块具有较小的特征图,所以百分比会下降。此外,与PReLU相比,使用ReLU的模型一般有更多的等值特征值,因为ReLU函数将所有的负值设置为零。

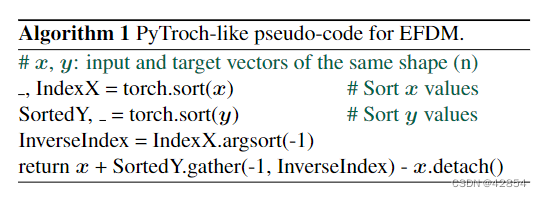

为了解决上述问题,据我们所知,我们首次提出通过精确匹配图像特征的eCDFs来执行EFDM,从而产生精确匹配的特征分布(当样本数接近无穷大时),进而产生精确匹配的平均值、标准差和高阶统计数据(见图2中的玩具例子)。eCDFs的精确匹配可以通过在特征空间中应用精确直方图匹配(EHM)算法[7, 18]来实现。具体来说,通过区分等价的特征值,并应用元素间的转换,EHM可以对eCDFs进行比HM更精细、更精确的匹配。本文采用了一种快速的EHM算法,名为Sort-Matching[47],以一种即插即用的方式,以最小的成本执行EFDM。

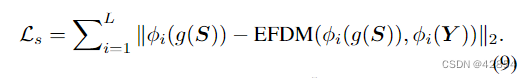

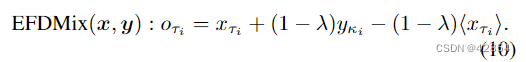

通过EFDM,我们在一个镜头中进行跨分布的特征匹配(参看公式(6)),并提出一个新的风格损失(参看公式(9))来更准确地测量分布分歧,在AST中产生更稳定的风格转换图像。继[72]之后,我们对EFDM进行了扩展,以生成具有混合风格的特征增强,从而形成了精确风格分布混合(EFDMix)(参见公式(10)),它可以为DG应用提供更多样化的特征增强。我们的方法在各种AST和DG任务上取得了新的先进技术,而且效率很高。

2. 相关工作

任意风格转换(AST) 已经在两个概念方向进行了研究:基于迭代优化的方法和前馈方法。前者[12, 25, 46]以迭代的方式优化图像像素,而后者[21, 32, 33, 37, 41]一次就能生成风格转移的输出。我们的方法属于后者,通常速度较快,适合实时应用。在这两个方向上,通过假设图像风格可以由特征分布来表示,转移风格可以被解释为特征分布匹配的问题。具体来说,[12]中的开创性工作采用了由Gram矩阵捕获的二阶矩作为风格表示。在[12]中引入的损失在[34]中被改写为图像特征间的最大平均差异,衔接了风格转移和特征分布匹配。实际上,很多AST方法都可以从特征分布匹配的角度来解释。基于高斯先验假设,AdaIN[21]中的特征分布匹配是通过匹配平均值和标准差来进行的。与AdaIN相比,WCT[33]通过一对特征变换,白化和着色,额外考虑了特征通道的协方差。通过将[12]中的内容损失纳入WCT的框架,在[32,37,41]中提出了一个闭合式的解决方案。除了广泛使用的一阶和二阶特征统计,高阶中心矩和HM分别在[25]和[46]中被引入,以通过放松高斯特征分布的假设来实现更精确的分布匹配。然而,明确计算高阶统计量会引入密集的计算开销,而且通过HM的EFDM会受到等价特征值的阻碍。为此,据我们所知,我们首次提出了一种有效的方法,通过精确匹配图像特征的eCDFs来实现EFDM,导致更忠实的AST结果(请参考图5的视觉例子)。

领域泛化(DG) 的目的是开发能够泛化到未见过的分布的模型。典型的领域泛化方法包括学习领域变量特征表示[5, 15, 31, 40, 65-67]、基于元学习的学习策略[4, 9, 29]、数据增强[13, 43, 56, 61, 71, 72]等[57, 69]。在上述所有方法中,最近的先进技术[72]基于特征分布匹配技术[21]增强了交叉分布特征,该技术在上面的AST部分已经介绍。通过提出的EFDM方法隐含地利用高阶统计,可以实现更多样化的特征增强,并观察到明显的性能改进(详情请参考表1和表2)。

精确直方图匹配(EHM) 被提出来,以精确匹配图像像素的直方图。与经典的HM相比,EHM算法可以随机地[47, 48]或根据它们的局部平均值[7, 18]来区分等价的像素值,从而使直方图的匹配更加精确。在图像像素空间中,EHM和HM的输出差异通常很小,人眼几乎无法察觉。然而,这种微小的差异在深度模型的特征空间中会被放大,导致特征分布匹配的明显分歧。因此,我们建议通过EHM精确匹配图像特征的eCDFs来执行EFDM。虽然EHM可以用不同的策略进行,但我们根据经验发现,它们在我们的应用中产生了相似的结果,因此我们提倡用快速排序匹配[47]算法进行EHM。

3. 方法

3.1. AdaIN, HM and EHM

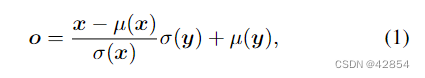

自适应实例归一化(AdaIN) [21]将从随机变量X采样的输入向量x∈Rn转化为输出向量o∈Rn,其平均值和标准偏差与从随机变量Y采样的目标向量y∈Rm相匹配:

其中μ(-)和σ(-)分别表示参考数据的平均值和标准差。通过假设X和Y遵循高斯分布,n和m接近无穷大,AdaIN可以通过匹配特征的平均值和标准偏差来实现EFDM[32, 37, 41]。然而,从图1可以看出,现实世界数据的特征分布通常与高斯分布有很大的偏差。因此,通过AdaIN来匹配特征分布是不太准确的。

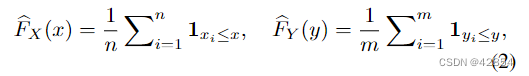

直方图匹配(HM) [16, 58]旨在将输入向量x转化为输出向量o,其eCDF与目标向量y的目标eCDF相匹配,x和y的eCDF定义为:

其中1A是事件A的指标,xi(或yi)是x(或y)的第i个元素。对于输入向量x的每个元素xi,我们找到满足足̂FX(xi)= ̂FY(yj)的yj,从而得到转换函数。H(xi)=yj。人们可以选择像在离散图像空间中那样匹配显式直方图[16]。值得一提的是,匹配eCDFs等同于匹配具有无限宽度的直方图,然而由于表示特征的比特数有限,这很难实现。

理想情况下,HM可以完全匹配连续情况下的图像特征的eCDFs。不幸的是,HM只能在输入中存在等效特征值时近似地匹配eCDFs,因为HM将等效值合并为一个点并应用逐点转换(请参考图2的玩具例子)。对于深度模型产生的图像,由于其对离散图像像素的依赖和激活函数的使用,例如ReLU[42]和ReLU6[26](更多细节请参考图3),等同的特征值是很常见的。所有这些事实阻碍了通过HM进行EFDM的有效性。

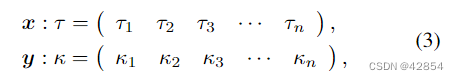

精确直方图匹配(EHM) [7,18]被提出来,以精确匹配图像像素的直方图。与HM不同的是,EHM算法区分了等价的像素值,并应用了一个元素的转换,从而可以实现更精确的直方图匹配。虽然EHM可以采用不同的策略,但我们采用排序匹配算法[47],因为它速度快。Sort-Matching是基于quicksort策略[49],它被普遍认为是最快的排序算法,其复杂度为O(nlog n)。正如其名称所述,排序匹配是通过匹配两个排序的向量来实现的,其内涵用单行符号[2]来说明:

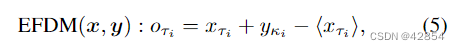

其中{xτi }ni=1和{yκi }ni=1是x和y按升序排列的排序值。换句话说,xτ1 = min(x), xτn = max(x), and xτi ≤ xτj if i < j. yκi的定义与此类似。基于公式(3)中的定义,排序匹配输出o与它的第τi个元素oτi为:

与AdaIN、HM和其他EHM算法[7, 18]相比,Sort-Matching还假定要匹配的两个向量大小相同,即m=n,这在我们的AST和DG的重点应用中得到满足。在其他应用中,如果两个向量的大小不同,可以进行插值或删除元素,使y和x的大小相同。

3.2. 用于 AST 和 DG 的 EFDM

在本节中,我们将EFDM应用于AST和DG的任务。我们通过在图像空间的排序匹配(Sort-Matching)来应用EHM算法进行精确的eCDFs匹配。为了在深度模型中实现梯度反向传播,我们通过修改公式(4)来实际执行EFDM:

其中⟨-⟩代表停止梯度操作[6]。我们按照[21, 72]对风格特征yκi停止梯度。鉴于输入数据X∈RB×C×HW和风格数据Y∈RB×C×HW,我们按照[21,72]的方法,以通道为单位应用EFDM,其中B,C,H,W分别表示批次大小、通道尺寸、高度和宽度。所提出的EFDM没有引入任何参数,可以以即插即用的方式使用,只需几行代码和最小的成本,如算法1所总结的那样。

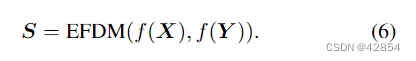

EFDM用于AST。我们采用了一个简单的编码器-解码器结构,我们将编码器f固定为预先训练好的VGG-19[51]的前几层(最多到4 1)。考虑到内容图像X和风格图像Y,我们首先将它们编码到特征空间,然后应用EFDM得到风格转移的特征,即:

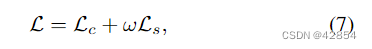

然后,我们训练一个随机初始化的解码器g,将S映射到图像空间,从而得到风格化的图像g(S)。按照[10, 21],我们用内容损失Lc和风格损失Ls的加权组合来训练解码器,从而得到以下目标:

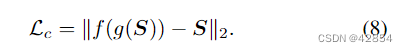

其中 ω 是平衡两个损失项的超参数。具体来说,内容损失Lc是风格化图像的特征f(g(S))和风格转移的特征S之间的欧氏距离:

风格损失测量风格化图像g(S)和风格化图像Y之间的分布分歧,在[21]中,基于高斯先验,它被实例化为它们在平均值和标准差上的分歧。为了更准确地测量分布分歧,我们引入了风格损失,即风格化图像的特征φi(g(S))与其风格转移目标EFDM(φi(g(S)),φi(Y))之间的欧氏距离之和:

按照[21],我们将{φi}Li=1实例化为VGG-19的relu1 1、relu2 1、relu3 1和relu4 1层。

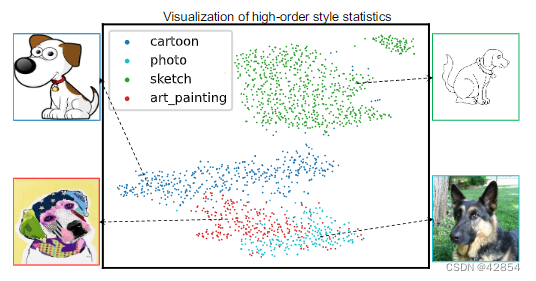

DG的EFDM。受风格信息可以由图像特征的均值和标准差来表示的研究启发[21, 33, 37],Zhou等人[72]提出为DG问题生成风格转移和内容保留的特征增强。正如我们前面所讨论的,超出高斯的分布具有除均值和标准差之外的高阶统计量,因此,通过使用高阶特征统计量可以更准确地表示风格信息。图4中的可视化显示,第三标准化矩-偏度[24, 60]可以很好地代表同一物体的四个不同领域。这促使我们在DG中利用高阶统计学进行特征增强。

图4. t-SNE[53]对第三个标准化矩–偏度[24, 60]的可视化,这清楚地表明,风格信息可以由均值和标准差之外的高阶统计来表示。除了偏度,风格信息还可以在第四个标准化矩–峰度[24, 59]和无限常数中观察到(详情请参考补充文件)。可视化的特征是从ResNet-18[20]的第1个残差块中提取的,这些残差块是在四个领域的数据集上训练出来的[28]。

由于高阶特征统计可以通过我们提出的EFDM方法进行有效的隐性匹配,因此在DG中用EFDM取代AdaIN进行跨分布特征增强是一个自然的想法。为了产生更多样化的混合风格的特征增强,按照[72],我们通过插值排序的向量来扩展公式(5)中的EFDM,结果是精确特征分布混合(EFDMix)为:

我们采用从实例出发的混合权重λ,并从Beta分布中取样λ:λ∼Beta(α,α),其中α∈(0,∞)是一个超参数。除非另有规定,否则我们将α=0.1。显然,当λ=0时,EFDMix会退化为EFDM。

鉴于输入特征X,按照[72],我们采用两种策略来混合风格特征Y。当给出域标签时,我们从与X不同的域中对Y进行采样,从而得到EFDMix w/ domain label。否则,Y是通过沿批次维度对X进行洗牌得到的,结果是EFDMix w/随机洗牌。我们只用交叉熵损失来训练模型。按照文献[72],我们将EFDMix模块插入到多个底层,采用0.5的概率来决定EFDMix在训练阶段的前向传递中是否被激活,并在测试阶段将其停用。

利用高阶特征统计的优势可以通过增强的多样性来直观地阐明。例如,给定两个具有相同平均数和标准差的不同风格特征̂y和̃y,以及一个特定的混合权重λ,只利用平均数和标准差就可以得到相同的增强特征[72]。相反,我们的EFDMix可以通过隐含地利用高阶统计来产生两种不同的增强,从而产生更多不同的特征增强。

4. 实验

我们对AST和DG任务进行了实验,以评估EFDM的有效性。

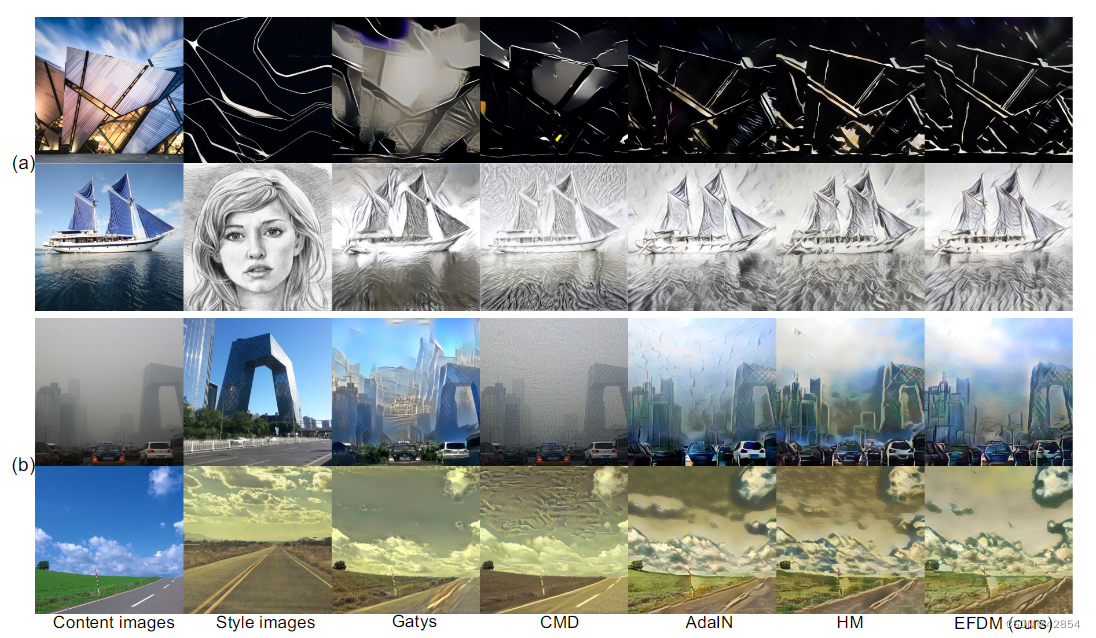

4.1. Experiments on AST

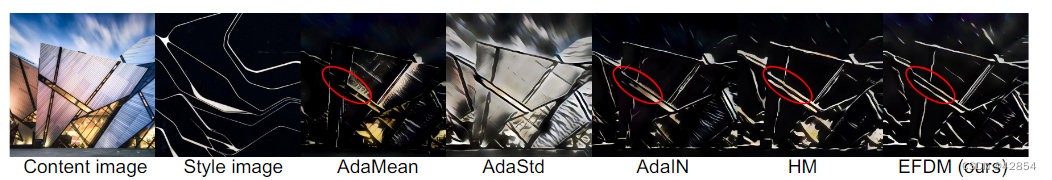

我们严格按照文献[21]对AST进行了实验1。具体来说,我们采用adam优化器,设置批次大小为8个内容-风格图像对,并设置超参数ω=10。在训练中,分别采用MS-COCO[35]和WikiArt[44]作为内容和风格图像。我们在图5中比较了EFDM和最先进的技术。可以看出,我们的EFDM在风格转换(上两行)和更具挑战性的照片写实风格转换(下两行)任务中工作稳定。通过更准确地进行特征分布匹配,它在转移风格时更忠实地保留了图像结构和细节,并产生了更多的照片逼真的结果。相反,竞争的方法可能会引入许多视觉伪影和图像失真。更多的视觉结果可以在补充文件中找到。

图5. (a) 风格转换[21](顶部两行)和(b)更具挑战性的照片写实风格转换[38](底部两行)任务的结果说明。Gatys’[12]和’CMD’[25]的结果是用官方代码获得的。对于HM,我们使用HM,而不是EHM,以大约匹配eCDFs。在补充文件中提供了更多的可视化信息。

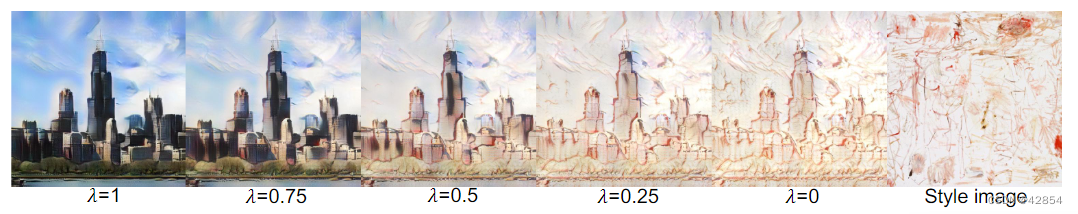

测试阶段的内容-风格权衡(Content-style trade-off in the test stage)。内容和风格之间的权衡可以通过调整公式(7)中的超参数ω来实现。此外,我们可以通过在内容特征和风格特征之间进行插值来实现内容-风格的权衡,这可以通过公式(10)中的EFDMix实现。当λ=1时,预计会出现虚无缥缈的内容图像,而当λ=0时,该模型会输出最风格化的图像。我们在图 6 中说明了一个示例。我们看到,通过将λ从1到0的变化,图像从内容风格平稳地过渡到目标风格。

图 6. 等式中各种 λ 的内容风格权衡的可视化。 (10)。

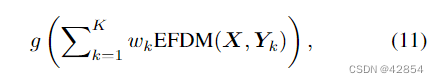

风格插值(Style interpolation)。按照[21],我们用相应的权重w1,w2,—,wK插值特征图来插值K个风格图像,如下所示:

其中∑K k=1 wk = 1。如图7所示,新的风格可以通过这种风格插值得到。

图 7. 样式插值的可视化

4.2. Experiments on DG

我们严格按照MixStyle[72]在DG2上进行实验,包括数据准备、模型训练和选取。换句话说,我们只是用EFDMix替换了MixStyle模块,其具体内容如下。

类别分类的概括(Generalization on category classification)。我们采用了流行的DG基准数据集PACS[28],其中包括9,991张由7个类别和4个领域共享的图像,即艺术、卡通、照片和素描。我们采用了两种任务设置。在留出一个域的设置中[28],我们在三个域上训练模型,在剩下的一个域上测试。在单源DG[45, 56]中,模型在一个域上训练,在其余三个域上测试。我们采用在Im-ageNet数据集上预训练的ResNet-18和ResNet-50作为骨干。

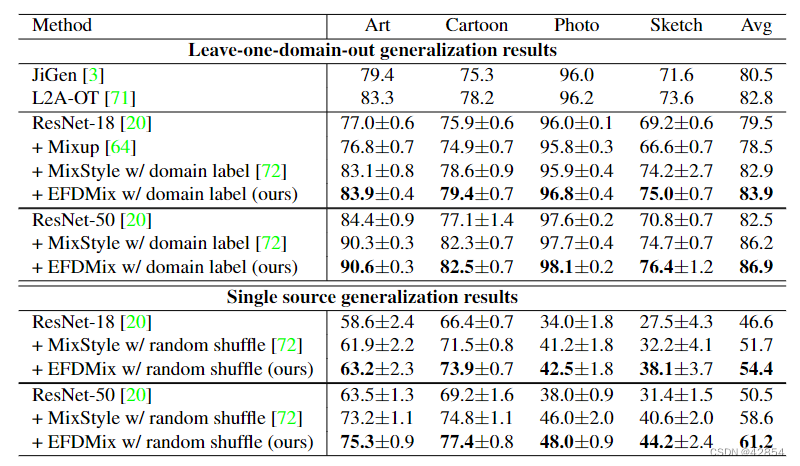

我们将我们的方法与最新的MixStyle[72]、基于正则化的方法[8, 14, 55, 62, 64]和有代表性的DG方法[1, 3, 30, 31, 40, 50, 71]进行比较。由于篇幅所限,在表1中只重新介绍了部分结果,更全面的结果见表1。1,更全面的结果在补充文件中给出。我们可以看到,我们的EFDMix在这两种情况下都一直优于MixStyle以及其他的组合方法。与其他竞争性方法相比,更多的优势在于 竞争方法的更多优势可以在单源泛化环境中观察到,其中训练数据的多样性较少。这可以解释为通过EFDMix进行的更多样化的特征增强,如第3.2节所阐明的。

表1. PACS上类别分类的领域概括结果。MixStyle的结果是用官方代码获得的。所列的域在留出一个域的情况下是测试域,而在单源泛化的情况下则是训练域。

我们注意到在DG社区有不同的实验策略。按照最近 DomainBed[17],我们的EFDMix在PACS数据集上取得了87.9%的准确率,比强大的ERM基准[17]高出1.2%。详情请参考补充文件。

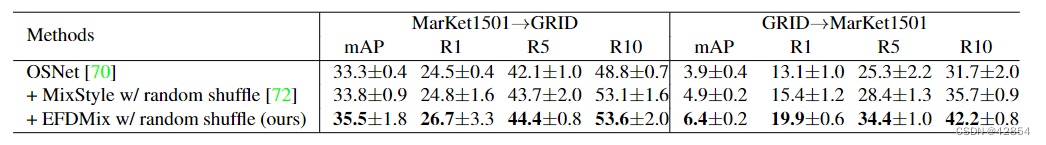

实例检索的泛化(Generalization on instance retrieval)。我们采用Markert1501[68]和GRID[36]的个人重新识别(re-ID)数据集来进行跨领域的实例检索。我们按照[72]的做法,用OSNet[70]进行了实验。与分类的结果类似,EFDMix优于MixStyle和其他竞争对手,如表2所示。2. 这再次验证了在DG中利用高阶统计数据进行特征增强的有效性。

表2. 跨领域人物重新识别任务的领域泛化结果。MixStyle的结果是用官方代码获得的。

4.3. 讨论

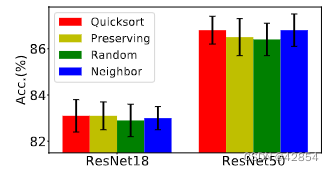

不同等级的特征统计的作用(The role of different orders of feature statistics)。为了进一步研究不同等级特征统计量的作用,我们通过只匹配特征平均值和标准差来实现AdaIN,从而得到AdaMean和AdaStd的变体。(图8和图9分别说明了AST的定性结果和DG的定量结果。从图8中,我们可以看到AdaMean与基本色调大致相符。AdaStd保留了内容图像的结构,但有错误的色调。通过匹配平均值和标准差,AdaIN预先提供了更多的细节和正确的色调。通过隐式匹配的高阶特征统计,EFDM保留了大部分内容细节。从图9中,我们看到用AdaMean或AdaStd进行特征增强可以比ResNet-50基线有所提高,而AdaMean的表现略好。AdaIN比AdaMean和AdaStd高出1%以上,证明了利用更多特征统计的有效性。通过隐式匹配高阶特征统计,EFDM取得了最佳结果。虽然HM与eCDFs近似匹配,但它甚至不能保证均值和标准差的精确匹配,导致性能下降。

图8. 关于不同等级的特征统计对AST的作用的定性分析

图9. 对PACS数据集上不同等级特征统计的作用的定量分析

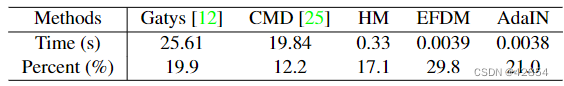

用户对风格转移的研究(User study on style transfer)。如表3所示,我们的方法因其较好的风格化性能而在竞争的AST方法中获得了最多的投票。更多细节请参考补充文件。

表3. 平均运行时间和用户对不同AST方法的偏好。运行时间是用Tesla V100 GPU在512×512图像上的平均数。

EFDM与不同的EHM算法(EFDM with different EHM algorithms)。不同的EHM算法是通过其等值的排序策略来区分的。在图10中,我们在DG的任务上用不同的EHM算法实现了EFDM。我们可以看到,它们在PACS数据集上产生了相似的精度。考虑到流速赋能的排序匹配算法具有最快的速度,我们在工作中采用了它来实现EFDM。

图10. 在PACS数据集上使用EFDM的不同实现方式的结果。除了Quicksort的排序匹配[49],我们还保留了x中等值的顺序(Preserving),对等值进行随机排序[48],以及根据本地平均值对等值进行排序18来实现EFDM,分别。我们看到,不同的实现方式导致了类似的结果。

运行时间(Running time)。我们评估了我们的EFDM方法在AST任务中的速度。不同的算法处理512×512图像的平均运行时间列于表3.3。EFDM比[12, 25]中的方法和基于HM的算法要快得多,该算法是用skimage库实现的。它的速度几乎与半成品AdaIN[21]相同,在512×512大小的图像上以256 FPS的速度运行,使其适用于实时应用。

局限性(Limitations)。与线性复杂度的AdaIN[21]相比,EFDM的复杂度较高,为nlog(n)。不过,由于特征大小有限,其运行时间与AdaIN的AST和DG任务相当。此外,按照[21, 25, 72],我们假设不同的特征通道是独立的,这并不完全正确,并且受到了[33, 37]的质疑。

关于EFDMix、EFDM与EFDMix的比较、公式(10)中α的选择、损失曲线、ReLU函数的影响、与DG上相关方法的比较[11, 23, 52, 72]以及对计算时间的详细分析的更多讨论可以在补充文件中找到。

5. 结论

据我们所知,我们首次尝试对特征分布进行精确匹配,并将所谓的精确特征分布匹配(EFDM)方法用于AST和DG的应用。我们采用了一种快速的EHM算法,即Sort-Matching,在深度特征空间中实现EFDM。所提出的EFDM方法在视觉质量和定量指标方面表现出比现有的AST和DG技术更优越的性能。我们的工作为有效执行EFDM的视觉学习任务打开了一扇大门。我们可以继续进行广泛的研究,例如,在平均数和标准差的统计之外,赋予经典的归一化[22]。

4572

4572

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?