今天给大家推荐一个好发顶会且不卷的idea:多模态持续学习!

这是个新兴的热门!它使机器学习模型,能在新数据中不断学习,同时保留并扩展已获得的多模态知识,超越了传统直接叠加单模态方法效果不佳的局限。在克服模型的灾难遗忘,提高模型性能、泛化能力、适应性方面作用显著!比如新成果变把多模态大模型与持续学习结合,实现了性能飙升113.67%的效果!

正是由于其的这些特性,使得医疗诊断、自动驾驶、金融交易、智能制造等,需要模型能够实时更新以适应最新的数据和趋势的领域,都绕不开它!在CVPR、ICML等顶会,其也是霸榜的存在。

目前的研究主要围绕:基于正则化、基于结构、基于重放、基于提示4个方面进行!为方便大家理解和运用,每种方法我都给大家准备了参考顶会论文和源码,共17篇!

论文原文+开源代码需要的同学看文末

1.基于正则化

对参数施加约束,减少灾难性遗忘

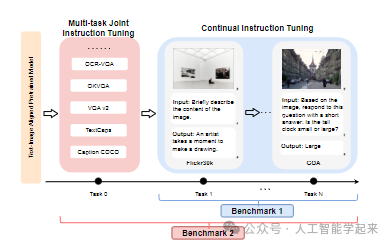

论文:Continual Instruction Tuning for Large Multimodal Models

内容

该论文探讨了在持续指令调整中大型多模态模型(LMMs)是否仍然遭受灾难性遗忘,以及现有的三类持续学习方法是否适用于LMMs的持续指令调整。研究建立了第一个持续指令调整的基准,发现在持续指令调整LMMs时仍然可以观察到灾难性遗忘。然而,多任务联合指令调整有助于提高模型的持续学习能力并减轻遗忘。

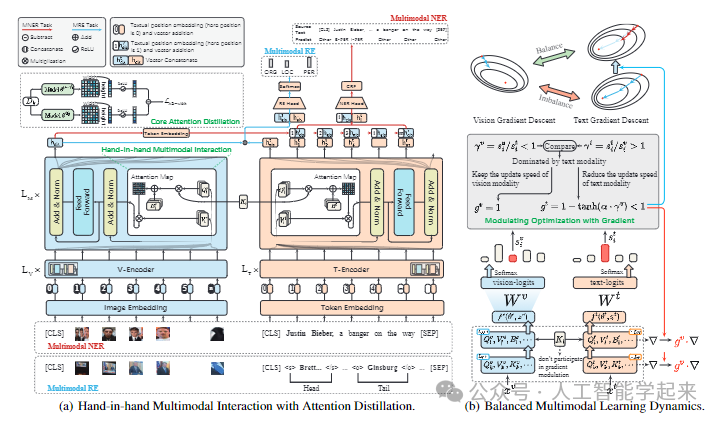

论文:Continual Multimodal Knowledge Graph Construction

内容

该论文介绍了持续多模态知识图谱构建(MKGC)领域的挑战,特别是在处理不断涌现的实体和关系时,现有模型可能会遭受灾难性遗忘,即丢失之前获取的知识,引入了新的基准测试,并提出了一个名为MSPT(Multimodal Stability-Plasticity Transformer)的框架,旨在通过策略性多模态优化来平衡已有知识的保留(稳定性)和新数据的整合(可塑性)。

2.基于架构

引入任务特定组件,减少不同任务之间的干扰

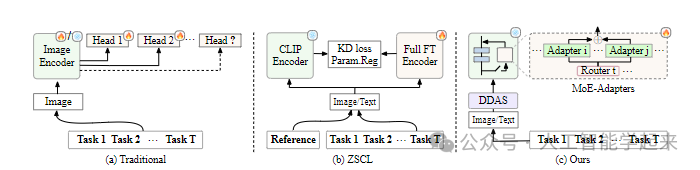

论文:Boosting Continual Learning of Vision-Language Models via Mixture-of-Experts Adapters

内容

该论文提出了一个名为MoE-Adapters的参数高效持续学习框架,用于提升视觉-语言模型在连续学习中的表现。该框架通过在预训练的CLIP模型上动态集成Mixture-of-Experts(MoE)适配器来应对新任务,并引入了一种名为Distribution Discriminative Auto-Selector(DDAS)的机制,用于自动将输入数据分配给MoE适配器或原始CLIP模型,以实现对已见数据的有效预测和对未见数据的零样本转移。

3.基于重放

使用一个记忆缓冲区来存储历史实例,无需动态调整网络架构,也不需约束参数自由度。

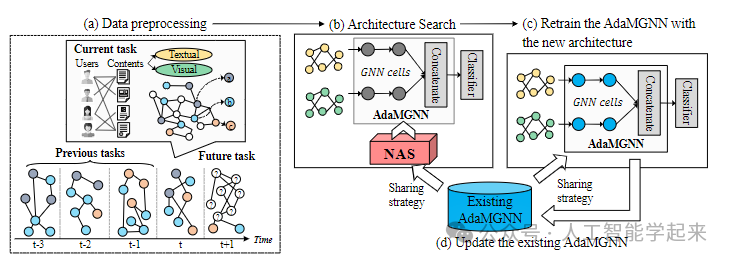

论文:Nodeformer: A scalable graph structure learning transformer for node classification

内容

该论文介绍了一种新颖的多模态持续图学习模型(MSCGL),该模型能够不断学习模型架构和相应的参数,以适应连续到来的多模态图任务,同时避免遗忘旧任务的知识。MSCGL模型通过结合神经架构搜索(NAS)和群组稀疏正则化(GSR),在保留历史信息的同时,探索更有效的架构来适应新任务。

4.基于提示的方法

引入任务特定组件来减少不同任务之间的干扰

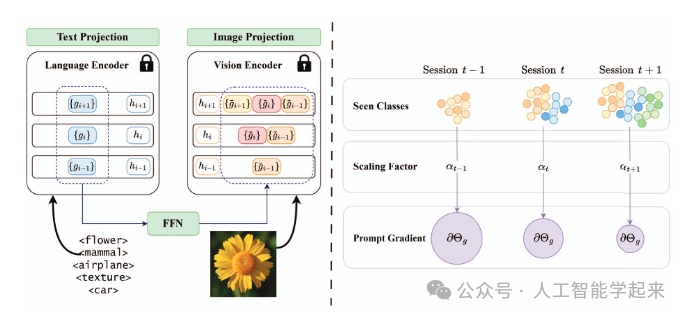

论文:Multimodal Parameter-Efficient Few-Shot Class Incremental Learning

内容

该论文提出了一种名为CPE-CLIP的多模态参数高效少样本类增量学习(FSCIL)方法,旨在解决在连续学习会话中可用的训练样本有限时的挑战。CPE-CLIP通过利用大规模预训练的CLIP模型的丰富知识及其在新概念泛化方面的有效性,采用可学习的提示(prompts)来适应语言和视觉编码器,实现跨会话的迁移学习。

关注下方《人工智能学起来》

回复“多模持续”获取全部论文+开源代码

码字不易,欢迎大家点赞评论收藏

1094

1094

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?