前言

具身的论文解读过很多之后,便会发现整个今24年的具身模型/策略大概如下所示——目前全网独一份「(_建议按照从下至上的顺序看,且所有点我都做了详尽而细致的解读,点击下表中对应的文字即可阅读,我后续也会不断完善之——毕竟还有很多并未囊括于下表中,_如转载请于文章开头标明作者July及本文链接」

有意思的是,其中的RDT、π0都通过聚合各大机器人数据集先做预训练,然后微调,且它两的参数规模也分别达到了1B、3B

大有类似大语言模型的发展路线,比如

- 17-20年,以BERT、GPT为代表的预训练-微调模式

且从GPT3起,模型的参数规模越来越大,慢慢的不再需要针对下游特定任务做微调——一个模型搞定所有任务- 途中经历过GPT3.5的RLHF微调

- 及至到GPT4之后,模型在各方面的能力逼近人类甚至超越人类

你说,是不是有趣?

第一部分 从训练数据来源、动作预测策略、模型训练方法

1.1 训练数据来源

在机器人领域,互联网数据、仿真数据、真实数据等这三类数据构成了主要的数据来源

- 如果采用端到端模仿学习的方法,给定一张图像并直接输出机器人动作,这通常依赖于真实世界数据

- 如果采用端到端的强化学习RL,因为需要一个可以反复交互的环境,则往往依赖于仿真数据

当然,也有先在RL仿真环境里训练一个base model,然后再在真实环境中通过模仿学习微调——这个搞法,我司七月具身项目组 便用到过

详见如下表格

| 2024年具身前沿模型/策略大汇总 | 说明 | 补充备注 | 典型代表 |

| 第一大块 训练数据来源 | 人类行为视频数据 | 相当于互联网上大规模的视频数据,比如YouTube上的 | 比如DexMV、MimicPlay、字节GR2 |

| 开源数据 | 需要一定的整合 | 比如Open X-Embodiment等 | |

| 仿真数据 | 毕竟仿真环境中训练base model,最后真实环境中微调,是常见训练方式 | 1 英伟达的Isaac Sim:整合了物理引擎PhysX、图像渲染引擎RTX、动画/电影描述格式USD | |

| 2 Google的MuJoCo | |||

| 人工收集 | 手持夹爪,收集方便 | umi/fastumi | |

| 动作捕捉,精度较高 | dexcap | ||

| 遥操,精度很高 | 主从机械臂遥操数据ALOHA | ||

| VR遥操Open-television |

1.2 动作预测策略

| 2024年具身前沿模型/策略大汇总 | 说明 | 补充备注 | 典型代表 |

| 第二大块 动作预测策略 | iDP3(改进的3D diffusion policy) | 可落地在人形机器人上 | 斯坦福iDP3 |

| 3D diffusion policy | 将3D视觉表示与扩散策略 | 3D Diffusion Policy: Generalizable Visuomotor Policy Learning via Simple 3D Representations | |

| Diffusion Policy(还可基于点云) | diffusion policy基于扩散模型 | UMI/dexcap | |

| Diffusion Transformer(DiT) | 基于Diffusion Transformer(DiT)改造 | 清华RDT | |

| 预测与动作扩散器PAD:通过联合去噪同时预测未来图像和动作 | Prediction with Action: Visual Policy Learning via Joint Denoising Process | ||

ACT基于Transformer | |||

| 基于下一个token预测技术预测动作token | 基于类似下个token预测策略 | ||

| 伯克利Digit |

1.3 模型训练方法

1.3.1 非Robotics VLM与VLA的训练方法

| 2024年具身前沿模型/策略大汇总 | 说明 | 补充备注 | 典型代表 |

第三大块 模型训练方法 | 直接真实环境中RL开训,摒弃仿真 | 真实环境中得到的RL数据微调VLM + 机器人动作微调:RL训练运行创建的数据集,可以用于二次训练,代替人类提供的例子(效果如何 待验证) | UC伯克利的Sergey Levine,于24年年底在DAI 2024上的演讲:RLDG——Reinforcement Learning Distilled Generalist |

| 结合视觉和人类示教与纠正的RL方法,目前暂时还是小众赛道 | UC伯克利的HIL-SERL | ||

| RL仿真 + VR遥操 | 估计人类动作 + 人类动作到人形机器人的重定向「凡是人形,必涉及到基于AMASS数据集(包括SMPL-X做参数化建模)做人形运动目标的重新定位」 + sim to real(师生学习/策略蒸馏) + VR遥操 | ||

| OmniH2O | |||

| RL仿真训本体 + RGB遥操部署 | Retargeting、Sim-to-Real、RGB Real-time遥控 | H2O:通过重定向清除不可行的动作,然后仿真训练,最后RGB实时遥操作部署(使用训练好的Sim-to-Real模仿策略进行模仿) | |

| 仿真中训小脑HST(仿真中训练好之后,RGB遥操部署) 且其真实中训大脑HIT | HumanPlus:RL仿真训本体 + 人类示教(模仿学习/行为克隆)训大脑 | ||

| 静态数据训练 + 人类示教 | 比如通过示范数据做行为克隆,更结合前身ALOHA的静态数据做协同训练 | Mobile ALOHA 某种意义上,没有显性奖励函数定义的模仿学习里,可以把对expert action(人类专家动作)的模仿看作为奖励函数 |

1.3.2 Robotics VLM与VLA的训练方法

| 2024年具身前沿模型/策略大汇总 | 说明 | 补充备注 | 典型代表 |

第三大块 模型训练方法 | 预训练的VLA | 先对VLM基于机器人数据(开源OXE + 自采,或只开源OXE)做二次预训练(模仿人类)变成VLA,再真实环境中微调VLA | 1 π0:先在高度多样化的开源 + 自采机器人数据上进行预训练——变成了相比不二次预训练情况下更强大的VLA,然后针对所需任务进行微调 |

| 2 RT2和OpenVLA:只在开源OXE上做的预训练 | |||

| 不用预训练的VLA | 其考虑到预训练成本较高 | TinyVLA | |

| 预训练的Robotics VLM | 针对VLM的二次预训练,通过开源OXE训练VLM变成Robotics VLM | Octo:在Open X-Embodiment数据集上进行预训练 | |

| 不预训练的Robotics VLM | 没有针对VLM的二次预训练,而是直接机器人数据微调VLM变成Robotics VLM | 字节RoboFlamingo:使用简单、少量的微调就可以把 VLM 变成 Robotics VLM |

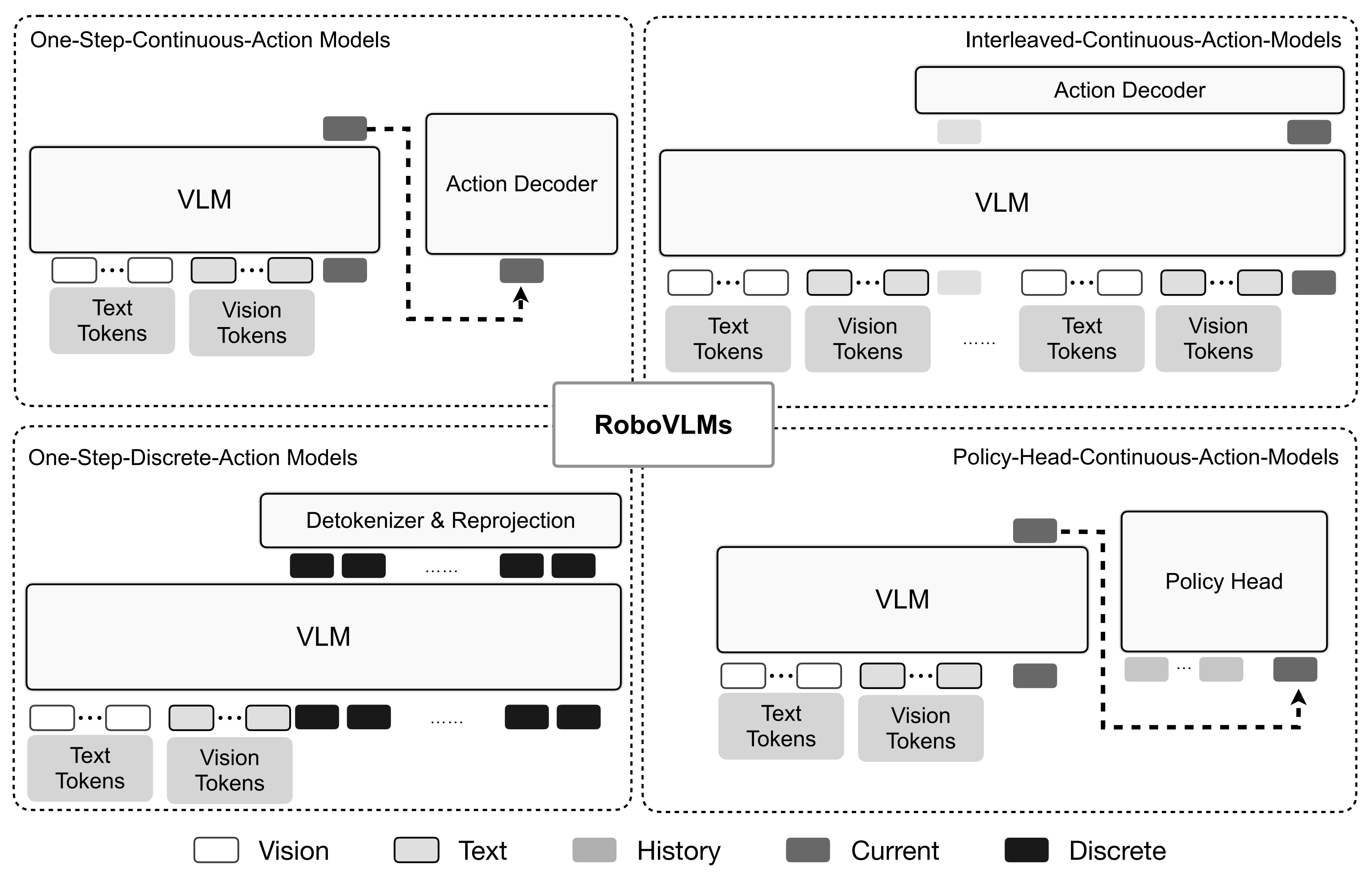

第二部分 Robotics VLM和VLA中的动作预测

2.1 Robotics VLM和VLA中的动作预测

| 2024年具身前沿模型/策略大汇总 | 说明 | 补充备注 | 典型代表 |

| 第四大块 Robotics VLM和VLA中的动作预测 | 专门的action head | 基于LSTM | Robotics VLM:字节RoboFlamingo |

| 基于diffusion model | Robotics VLM:Octo | ||

| VLA:TinyVLA(diffusion-based head) | |||

| 基于流匹配 | VLA:π0 (流匹配微调VLM) | ||

| 基于Diffusion Transformer(DiT) | VLA:CogACT(相比Octo的头 更大) | ||

| 基于下一个token预测技术预测动作token | 对于离散化token动作表示,即指将机器人的每个动作维度分别离散化为 256 个箱子中的一个 | VLA:RT-2、OpenVLA(相当于RT-2开源版) | |

| 打造机器人动作专用的高效Tokenizer:比扩散π0的训练速度快5倍但效果相当 | 自回归版π0-FAST |

第三部分 借鉴大语言模型的发展之路

3.1 借鉴大语言模型的发展之路

| 2024年具身前沿模型/策略大汇总 | 说明 | 补充备注 | 典型代表 |

| 第五大块 借鉴大语言模型的发展之路 | 预训练-微调模式中把模型搞大 | 需要架构、数据双双具备 | RDT、π0 |

| 把RLHF引入近具身 | 通过偏好对齐提升机器人策略的泛化能力 | GRAPE | |

| 把CoT引入具身 | 让具身模型学会逐步推理 | ECoT | |

| 让VLM充当机器人大脑,做顶层任务规划 | 机器人基础模型(相当于大脑):用于整体任务规划 机器人操控模型(相当于小脑):用于精确控制 | Figure 01、清华ViLA、CoPa | |

| 让大模型来打辅助:推理、规划样样行 | 基于VLM模型GPT-4o和关系关键点约束 | ReKep | |

| VLM解释人类演示视频,并为机器人生成任务计划、代码 | 纽约大学:VLM See, Robot Do | ||

| 结合「GPT4V的open-world vision能力」和重定向 | OKAMI |

AI大模型学习路线

如果你对AI大模型入门感兴趣,那么你需要的话可以点击这里大模型重磅福利:入门进阶全套104G学习资源包免费分享!

扫描下方csdn官方合作二维码获取哦!

2025最新版CSDN大礼包:《AGI大模型学习资源包》免费分享

这是一份大模型从零基础到进阶的学习路线大纲全览,小伙伴们记得点个收藏!

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

100套AI大模型商业化落地方案

大模型全套视频教程

200本大模型PDF书籍

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

LLM面试题合集

大模型产品经理资源合集

大模型项目实战合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

2025最新版CSDN大礼包:《AGI大模型学习资源包》免费分享

369

369

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?